10.09.2019

Hochleistungsrechner

1. Teil: „High Performance Computing in der Cloud“

High Performance Computing in der Cloud

Autor: Oliver Schonschek

Gorodenkoff / Shutterstock.com

Dank der Cloud steht Superrechner-Power jedem Unternehmen zur Verfügung. Erst das High Performance Computing ermöglicht Berechnungen hochkomplexer Analysen und Simulationen.

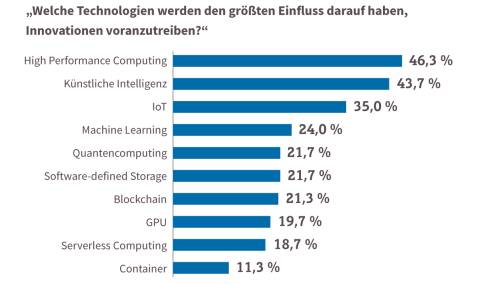

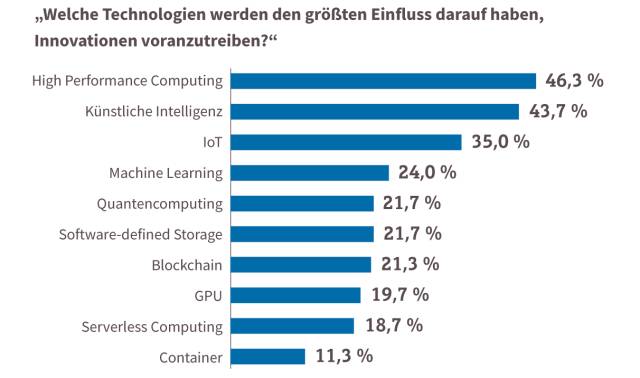

Während Big Data und Machine Learning in aller Munde sind, führt High Performance Computing (HPC) in der breiten Öffentlichkeit eher ein Schattendasein – zu Unrecht.

„High Performance Computing hat die jüngsten Entwicklungen und Erfolge in den Bereichen Maschinelles Lernen und Big Data erst ermöglicht“, so Forscher des Fraunhofer-Instituts für Algorithmen und Wissenschaftliches Rechnen SCAI in Sankt Augustin.

HPC-Lösungen unterstützen komplexe Analysen und Simulationen durch Hochleistungsrechnen, also insbesondere durch eine enorme Rechenleistung und hohe Fehlertoleranz, die mit klassischen Arbeitsplatzrechnern und Servern in einem Unternehmen kaum erreicht werden können.

Wie schnell HPC werden kann, hängt von der Konfiguration des Rechnersystems ab, von den Clustern und Prozessoren, vom Speicher, der Vernetzung, der Software und dem Betriebssystem, den Applikationen und der Komplexität der Aufgaben. Die 500 schnellsten Computer der Welt liefern inzwischen mindestens 1 PetaFLOPS, das sind eine Billiarde Rechenoperationen pro Sekunde.

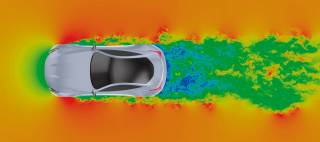

High Performance Computing ist für die Wettbewerbsfähigkeit von Wissenschaft und Wirtschaft unerlässlich, so der Digitalverband Bitkom. Ohne detaillierte Simulationen sei moderne Forschung und Entwicklung undenkbar. Das gilt auch für Schlüsselbereiche der deutschen Wirtschaft, wie Bitkom unterstreicht. Ob elektronische Geräte, Autos, Flugzeuge, moderne Medikamente oder neuartige Operationsverfahren, sie alle basieren auf Erkenntnissen aus Simulationen.

Beispiel: Stromnetze

Wie sich Hochleistungsrechnen in der Praxis einsetzen lässt, zeigt zum Beispiel der Übertragungsnetzbetreiber Tennet TSO. Gemeinsam mit Experten des Jülich Supercomputing Centre (JSC) wurde ein spezielles Computersystem entwickelt. Es soll dazu beitragen, das über Jahrzehnte gewachsene Stromnetz an die Anforderungen durch die Energiewende anzupassen. Der Netzbetreiber nutzt für den Ausbau Computersimulationen der Lastflüsse im Stromnetz, die sich mit dem neuen System um das über 30-Fache beschleunigen lassen.

Tennet TSO mit Sitz in Bayreuth ist eines von vier Unternehmen in Deutschland, die für den Betrieb des überregionalen Stromnetzes zuständig sind. Experten des JSC haben in einer dreijährigen Kooperation mit Tennet ein hybrides Rechnersystem entwickelt: Das „Smart Performance Cluster“ ist speziell auf die vom Unternehmen eingesetzten Anwendungen zugeschnitten und stellt Ressourcen für Windows- und Linux-Software unter einer Oberfläche bereit.

„Mit dem neu entwickelten System sind wir in der Lage, zahlreiche Berechnungen parallel auszuführen. Dadurch bleibt mehr Zeit, die Berechnungsergebnisse in weiteren Dimensionen zu analysieren und neue Erkenntnisse zu erhalten. Zudem sind manche Berechnungen überhaupt erst durch die Einführung des neuen Systems möglich geworden, weshalb wir die Kooperation mit dem JSC als außerordentlich erfolgreich bewerten“, erklärt Stefan Schuh, der seitens Tennet für die Kooperation verantwortlich ist.

Mit der bisherigen Technik – die Simulations-Software lief auf klassischen Servern – wäre die dazu notwendige massive Steigerung der Rechenleistung nicht zu realisieren gewesen, auch aufgrund der Komplexität des deutschen Energiesystems, die im Zuge der Energiewende enorm gestiegen ist.

Gemeinsam mit einem IT-Dienstleister und Entwicklern der Simulations-Software haben die Experten des JSC die Tennet-Anwendungen für die parallele Bearbeitung durch eine Vielzahl von Prozessoren angepasst und einen Parallelrechner mit intelligenter Ressourcenverwaltung auf die Anforderungen des Bayreuther Unternehmens abgestimmt, mit dem sich die Simulationen und weitere Anwendungen signifikant beschleunigen lassen.

2. Teil: „Beispiel: 3D-Bilder“

Beispiel: 3D-Bilder

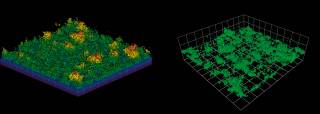

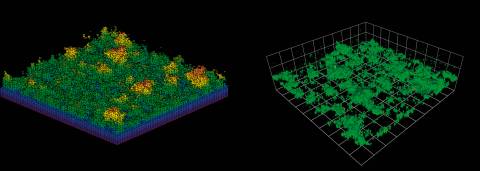

Eine weitere HPC-Anwendung sind aufwendige Videoproduktionen wie „Die Biene Maja – Die Honigspiele“ der in München ansässigen Studios 100 Media und B Animation in Koproduktion mit dem ZDF. Für die Berechnung der mehr als 230.000 3D-Bilder des Films nutzte das Animationsstudio MARK13 mit Sitz in Stuttgart den Rechner Hazel Hen, den größten Supercomputer des Höchstleistungsrechenzentrums (HLRS) in Stuttgart. „Wir haben bereits für den ersten Kinofilm mit der Biene Maja 2014 auf die Rechenkapazitäten des HLRS zurückgegriffen, weil unsere internen Kapazitäten auch aus Zeitgründen nicht ausreichten“, so Holger Weiss, CEO von MARK13. „Beim zweiten Kinoabenteuer haben wir in Sachen Rendering am HLRS stark von den Erfahrungen aus dem ersten Film profitiert. Wir konnten Prozessabläufe deutlich optimieren.“

Pro Frame (Einzelbild) lag die Berechnungszeit bei etwa 45 Minuten. Bis zu 200 Bilder berechnete Hazel Hen gleichzeitig. Das Datenvolumen für die Bildberechnung betrug insgesamt 245 Terabyte, die Rechenzeit knapp sechs Monate. „Während wir 2014 die Festplatten noch händisch zum HLRS transportiert haben, musste die Biene Maja dank neuem Glasfaseranschluss dieses Mal nicht mehr mit der S-Bahn fahren“, freut sich Weiss.

(K)eine Wissenschaft für sich

Das Implementieren einer HPC-Lösung, die zu den anstehenden Projekten im Unternehmen passt, erscheint als große Herausforderung. Es geht nicht nur um Rechenleistung, sondern auch um Speicher, Datenmanagement, Vernetzung und Kühlung, um nur einige Bereiche zu nennen. Ein Zuviel an Ressourcen würde die Kosten in die Höhe schnellen lassen. Zu stark eingeschränkte Ressourcen verringern die Zeit- und Leistungsvorteile von HPC.

Trotzdem ist HPC nicht nur etwas für Wissenschaft und Forschung, für Universitäten, die mit modernen Rechenzentren und ausgewiesenen IT-Experten ausgestattet sind: Die meisten Unternehmen können von der Analyse großer Datenmengen (Big Data) und der Einführung von Künstlicher Intelligenz (KI) profitieren und damit von HPC als einer der technischen Grundlagen. Das gilt über Großunternehmen hinaus auch für kleine und mittlere Betriebe.

Den Unternehmen kommt dabei die Cloud zu Hilfe: HPC muss nicht als On-Premise-Lösung betrieben werden, es gibt HPC-Services aus der Cloud, wodurch die Kosten für das Hochleistungsrechnen und die internen Aufwände für die Administration und den Betrieb deutlich gesenkt werden können. Ebenso können bei HPC-Cloud-Diensten die Ressourcen an den tatsächlichen aktuellen Bedarf angepasst werden. Als Unternehmen muss man sich keine dauerhafte HPC-Infrastruktur aufbauen, nur weil man beispielsweise für eine Produktentwicklung schnellere, realitätsnahe Simulationen einsetzen will.

3. Teil: „Rechnen aus der Cloud“

Rechnen aus der Cloud

HPC-Dienste aus der Cloud, auch HPC as a Service (HPCaaS) genannt, bieten alle großen Cloud-Provider, ob AWS, Microsoft Azure, Google Cloud, IBM oder Oracle. Google Cloud zum Beispiel wählte Atos im Mai 2019 als einen der wichtigsten Partner für High-Performance-Computing-Services aus und erweiterte die bestehende Partnerschaft um neue Services für Unternehmenskunden. Bei Micosoft Azure kann man über die HPC-Services Workloads auf einem Cray-Supercomputer ausführen.

Doch es gibt auch alternative Zugänge zu einer HPC-Cloud wie den Marktplatz Fortissimo. Je nach Anforderungen der Benutzer, deren Einrichtung und dem entsprechenden Projektmanagement können Angebote für HPC-Dienste auf dem Fortissimo-Marktplatz ausgewählt werden. Dank dieser Services müssen keine Investitionen in HPC-Hardware und -Software getätigt werden, was zu einer Senkung der Kosten und einer schnelleren Markteinführung führt. Das ist insbesondere für kleine Unternehmen interessant, die ansonsten keine HPC-Lösungen verwenden könnten.

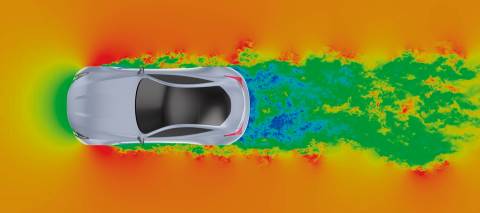

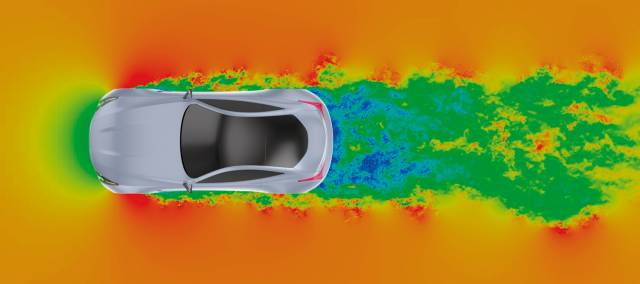

Im Zentrum des von der EU geförderten Fortissimo-Projekts standen rund 80 Beispiele, in denen die Nutzung und die Vorteile von cloudbasierten HPC-Diensten für erweiterte Simulations- und Datenanalysen dokumentiert wurden, darunter etwa die Simulation von additiven Fertigungsprozessen für die Herstellung von Metallkomponenten. Durch die Bereitstellung eines Prognosewerkzeugs – aufbauend auf verschiedenen Kühlungsgraden im Herstellungsprozess – konnte sowohl der Spannungszustand als auch die Produktverformung der endgültigen Komponenten vorhergesagt werden.

HPCaaS wird beliebter

HPC-Dienste aus der Cloud werden ein durchschnittliches jährliches Wachstum von 12,28 Prozent in den Jahren 2019 bis 2024 verzeichnen können, lautet die Prognose in der Marktstudie „Cloud High Performance Computing (HPC) Market – Growth, Trends, And Forecast (2019–2024)” von Mordor Intelligence.

Die Marktforscher begründen das mit der wachsenden Bedeutung von Big-Data-Analysen, Machine Learning und komplexen Simulationen in der Industrie. Einen weiteren Effekt sehen sie in der Zunahme an autonomen Systemen und Künstlicher Intelligenz, zum Beispiel im E-Commerce, im Gesundheitswesen sowie bei Fahrzeugen und in der Luft- und Raumfahrt.

Für wie groß das Potenzial für HPC-Dienste aus der Cloud gehalten wird, zeigen auch aktuelle Übernahmen wie die von Cray durch Hewlett Packard Enterprise (HPE) für rund 1,3 Milliarden Dollar. „Die Antworten auf einige der dringlichsten gesellschaftlichen Herausforderungen stecken in riesigen Datenmengen“, erklärt Antonio Neri, President und CEO von HPE. „Nur durch die Verarbeitung und Analyse dieser Daten können wir Antworten auf kritische Herausforderungen in den Bereichen Medizin, Klimawandel, Weltraum und mehr finden.“

Die Datenexplosion durch Künstliche Intelligenz, maschinelles Lernen und Big-Data-Analysen führt zu einer deutlichen Ausweitung von HPC, so Hewlett Packard Enterprise. Für die nächsten drei Jahre erwartet HPE ein Wachstum des HPC-Marktsegments und der damit verbundenen Speicher- und Serviceleistungen von circa 28 Milliarden Dollar im Jahr 2018 auf circa 35 Milliarden Dollar 2021.

Bereits heute bietet HPE Kunden weltweit HPC-Lösungen, darunter HPE Apollo und SGI. Dieses Portfolio wird erweitert, indem die Technologien von Cray genutzt und ergänzende Lösungen hinzugefügt werden. Die Übernahme von Cray durch HPE soll unter anderem neue HPC-as-a-Service-Lösungen und AI-/ML-Analysen durch HPE GreenLake ermöglichen und das Portfolio an HPC-Infrastrukturen erweitern, bestehend aus Computing, Hochleistungsspeicher, Systemverbindungen, Software und Services, die die vorhandenen HPE-Funktionen ergänzen.

4. Teil: „Fazit & Ausblick“

Fazit & Ausblick

HPC-Services aus der Cloud machen den Einstieg in das High Performance Computing relativ leicht. Wer bisher auf die Nutzung von Hochleistungsrechnen verzichtet hat, weil es als zu teuer und kompliziert erschien, sollte die möglichen HPC-Projekte nochmals evaluieren.

Insbesondere für umfangreichere Big-Data-Projekte und den Einsatz von Simulationen ist dies sinnvoll. Die Auswahl an möglichen HPC-Anbietern ist groß, wie die unten folgende Aufstellung zeigt. Dabei gibt es häufig auch Referenzprojekte in passenden Branchen, die die Möglichkeiten der HPC-Services beispielhaft demonstrieren, sowie Referenzarchitekturen, die man in der Cloud mit wenigen Klicks nachbilden kann.

Bad News

Game macht Fake News spielerisch erkennbar

Wissenschaftler der Universität Uppsala haben ihr Online-Spiel "Bad News" erfolgreich an 516 Schülern getestet. Es soll helfen, manipulative Techniken in Social-Media-Posts zu erkennen.

>>

3 Modelle

Business GPT - Telekom bringt KI-Angebot für Unternehmen

Mit ihren Business GPT-Angeboten will die Telekom eine sichere KI-Lösung für Geschäftskunden anbieten. Drei Modelle haben die Bonner dafür entwickelt – und die haben ihren Preis.

>>

Huawei Roadshow 2024

Technologie auf Rädern - der Show-Truck von Huawei ist unterwegs

Die Huawei Europe Enterprise Roadshow läuft dieses Jahr unter dem Thema "Digital & Green: Accelerate Industrial Intelligence". Im Show-Truck zeigt das Unternehmen neueste Produkte und Lösungen. Ziel ist es, Kunden und Partner zusammenzubringen.

>>

Nach der Unify-Übernahme

Mitels kombinierte Portfoliostrategie

Der UCC-Spezialist Mitel bereinigt nach der Unify-Übernahme sein Portfolio – und möchte sich auf die Bereiche Hybrid Cloud-Anwendungen, Integrationsmöglichkeiten in vertikalen Branchen sowie auf den DECT-Bereich konzentrieren.

>>