04.01.2021

IT-Infrastruktur im Wandel

1. Teil: „Auf dem Weg zur Distributed Cloud“

Auf dem Weg zur Distributed Cloud

Autor: Hartmut Wiehr

Virgiliu Obada / shutterstock.com

Zwischen firmeneigenem Rechenzentrum und der Cloud kommt es zu einer spannenden Koexistenz. Regulierungs- und Compliance-Fragen stellen für Unternehmen große Hürden dar.

Eigentlich ist die Sache ja schon ausgestanden. Die (Public) Cloud hat auf der ganzen Linie gesiegt. Immer mehr Unternehmen geben ihre eigene IT auf, da sie zu kompliziert ist, zu teuer und nicht zuletzt zu viel Spezialwissen und entsprechend ausgebildetes und fähiges Personal erfordert. So ist es immer wieder zu lesen. Erst kürzlich stand in einer schrillen Botschaft der PR-Agentur des eher kleineren Software-Anbieters Barracuda: „Ganze Rechenzentren verschwinden in die Cloud.“ Auf Nachfrage, ob sich das mit Zahlen belegen ließe, hieß es: „Da muss ich erst einmal passen.“

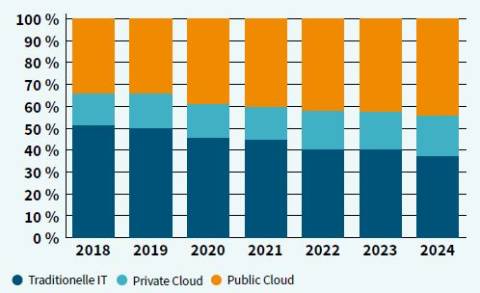

Auch angesehene Analysten wie die von Gartner argumentieren so: „Bis 2025 werden 99 Prozent aller Dateien in Cloud-Umgebungen gespeichert werden. Mitarbeiter werden Dateien erzeugen, bearbeiten und auf allen möglichen Geräten speichern, ohne zu wissen, ob die Dateien lokal oder in der Cloud abgelegt werden.“ Die Analysten von IDC schreiben: „Wo Wachstum in der Infrastruktur stattfindet, wird das meiste in der Cloud stattfinden.“ Und bei der Taneja Group heißt es: „Gegenwärtig befinden sich 67 Prozent der IT-Infrastrukturen primär in privaten Rechenzentren, aber dieser Anteil wird binnen drei Jahren auf 28 Prozent fallen, während die überwiegende Mehrheit von 72 Prozent hauptsächlich die Dienste von Public Clouds in Anspruch nehmen wird.“

Abschied von der Autarkie

Es ist noch gar nicht so lange her, da wollten größere Unternehmen möglichst autark sein, auch bei ihrer IT-Infrastruktur - mit der Herrschaft über ein eigenes Rechenzentrum und fest angestellten IT-Spezialisten für Hard- und Software und für Networking. Die von diesen Fachleuten betreuten Rechenzentren sind zunächst unabhängig von ihrer Größe dadurch charakterisiert, dass sie an einem oder mehreren Orten zentralisiert und mit Hardware- und Netzwerkgerätschaften sowie Software ausgestattet sind, um ständig wachsende Mengen von Daten anzusammeln, zu verarbeiten, zu speichern, zu verteilen und den Zugang zu ihnen nur extra berechtigten Firmenmitarbeitern zu gewähren.

Das Grundprinzip der zentralisierten Server-Architekturen mit angeschlossenen Endgeräten hat sich über die Zeit kaum geändert. Modernisierte Rechenzentrumsstrukturen mit Server-Racks, Server-Farmen, ausgefeilten Storage-Systemen und mehr sind nur Varianten von in sich geschlossenen Systemen für Computing, Networking, Storage, Backup und Recovery sowie Daten- und Applikationsmanagement. Folgt man einigen Marktbeobachtern, so setzt noch immer die überwiegende Mehrheit der KMUs darauf. Und auch bei vielen großen und international tätigen Unternehmen findet sich diese Struktur noch.

Wer sich als Unternehmen, egal welcher Größe, in dieser Welt der IT bewegt, kann eigentlich nicht viel falsch machen. Hard- und Software, Management und Internet sind ziemlich ausgereift, es gibt zahllose helfende Dienstleister oder Service-Angebote der Hersteller selbst, ferner Consultants und Analysten, die einem zur Seite stehen, wenn man sie braucht. Allerdings erfordert das fast immer kontinuierliche Investitionen und viele ausgebildete Fachleute.

Diese relativ fest in sich ruhende Welt der IT gab es quasi mehrere Jahrzehnte lang. Dann tauchte die Cloud am Horizont auf. Was als schleichender Prozess vor allem bei großen Unternehmen einsetzte, die sich von der Last und den Kosten einer selbst betriebenen IT befreien wollten, hat inzwischen auch den Mittelstand erreicht. So prognostizierte Gartner im März 2020: „Bis zum Jahr 2023 werden 60 Prozent der Workloads mittelgroßer Unternehmen (MSBs) weiter On-Premise abgewickelt werden, während es 2020 noch 63 Prozent sind.“

Public Cloud ist dem Begriff nach die Auslagerung und Übernahme der gesamten oder eines Großteils der Unternehmens-IT - die Server-Hardware befindet sich im Rechenzentrum des Dienstleisters (oft werden nur Teile eines Racks in Anspruch genommen), ebenso die Anwendungen und die Daten.

Infrastructure as a Service (IaaS) geht hier am weitesten und umfasst die ausgelagerte wesentliche IT-Infrastruktur eines Unternehmens, bestehend aus Hardware (Server und Storage-Systeme) und Software (Anwendungen und Programmentwicklung). Platform as a Service (PaaS) bezieht sich auf die Auslagerung von Software- oder Web-Entwicklungen, wobei in der jetzigen Übergangsphase eine sehr große Zahl von Spezialformen entstanden ist. Software as a Service (SaaS) wiederum beschränkt sich auf eine ausgelagerte Software, die auf einem Server oder Server-Anteil eines Racks beim Public-Cloud-Anbieter liegt. In der Praxis überschneiden sich diese drei Bereiche, sodass eine genaue Zuordnung nicht in jedem Fall gelingt.

Beherrschend in diesem Markt sind drei große Anbieter, die Hyperscaler Amazon, Microsoft und Google.

Amazon AWS: Der Markt für IaaS und PaaS wird aktuell laut Gartner von AWS mit einem Anteil von 33 Prozent dominiert, gefolgt von Microsoft Azure mit 16 Prozent, Google Cloud mit 8 Prozent und Alibaba mit 5 Prozent. Das Angebot von AWS übertrifft mit über 175 Services für Compute, Storage, Datenbanken, Analytics, Networking oder Entwicklungs- und Management-Tools quantitativ das seiner Konkurrenten. Allerdings wird die Preisstruktur des AWS-Angebots oft als unübersichtlich und schwer nachvollziehbar bezeichnet, weshalb eine gewisse Einarbeitungszeit oder das Hinzuziehen externer Experten ratsam sein kann. Wie Microsoft Azure und Google Cloud stellt AWS Basisfunktionen einer Public Cloud zur Verfügung: Selfservice, Instant Provisioning und Autoscaling sowie Security-, Compliance- und Identity-Management-Features. AWS brachte 2017 SageMaker heraus, um die Einführung von Machine Learning zu erleichtern, zudem gibt es Tools für Gesichtserkennung (AWS Rekognition) oder Modelle für Deep Learning, um Texte in Sprache zu übertragen.

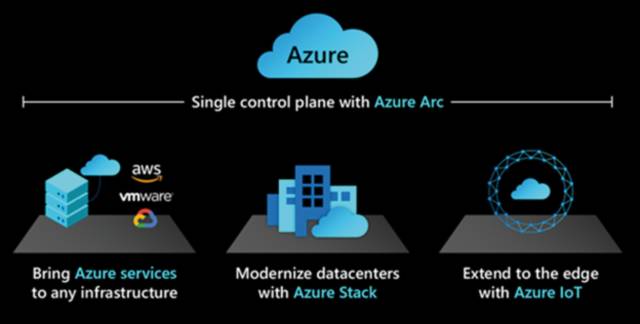

Microsoft Azure: Microsoft profitiert von seinen langjährigen Kundenbeziehungen. Viele Anwender ziehen es zudem vor, alle Produkte und Dienstleistungen von nur einem Hersteller zu beziehen. Ein Vorteil von Microsoft besteht außerdem darin, dass Microsoft 365 (Office) und Teams schon länger nicht mehr als lokal zu installierende Anwendungen, sondern nur noch als Cloud-Lösung zu beziehen sind.

Google Cloud: Google hat sich einen Ruf mit seinem Einsatz von Open-Source-Technologien, besonders von Containern, Artificial Intelligence und Machine Learning erworben, was seine wachsende Position im Bereich Public Cloud gegen die Marktführer AWS und Azure unterstützt.

2. Teil: „Blackbox“

Blackbox

Unabhängige Zahlen oder detaillierte Studien über diese Formen von Rechenzentren gibt es bisher kaum - und auch keine offiziellen Standards. Wie steht es beispielsweise um Ausfälle und Recovery, um Auszeiten und Reparaturen, um Ersatzrechenzentren oder Backup- und Security-Informationen? Wie sieht es bei staatlichen Vorgaben für diese zum Teil riesigen Rechenzentren aus, die doch einen wichtigen Teil der gesamtstaatlichen Infrastruktur bilden? Welchen Einfluss haben AWS und die anderen Cloud-Anbieter auf die Wirtschaftsstruktur in den Ländern ihrer Nicht-US Kunden?

Details wie Ausstattung, Sicherheitsvorkehrungen, Mitarbeiterzahl, Energieverbrauch oder Kühlung sickern schon aus Vorsicht vor Angriffen so gut wie nie durch - Fakt ist, dass es sich um jede Größenordnung sowie Hardware- und Networking-Varianten handelt, die man sich ausmalen kann.

Die innere Struktur der Cloud-Rechenzentren gleicht sich naturgemäß: Neben Mainframes und alten Unix-Servern gibt es unterschiedliche Cluster neuzeitlicher Server im Eigenbau oder auf der Basis von Lieferungen der bekannten Hersteller - zum Teil eine bunte Mischung hochperformanter Rechner, Speichersysteme und Netzwerke. Wie weit bestimmen die Public-Cloud-Anbieter bereits die Produktion der traditionellen Server-, Storage-, Networking- und Software-Hersteller? Was bedeuten ihre Eigenentwicklungen fur die gesamte IT-Industrie? So hat zum Beispiel Google die Entstehung der Container-Technologie wesentlich mitangetrieben.

3. Teil: „Distributed Cloud“

Distributed Cloud

Der Wettlauf zwischen den Anbietern von Public-Cloud-Infrastrukturen ist noch keineswegs entschieden. Neben AWS, Azure und Google positioniert sich auch Alibaba aus China sehr stark; eine Rolle spielen zudem IBM Cloud, Oracle Cloud und die französische OVHcloud. Angesichts der Wettbewerbssituation verwundert es auch nicht, dass es keine gesicherten Zahlen darüber gibt, wie viele Unternehmen wirklich schon ihr eigenes Rechenzentrum zugunsten eines der alternativen Angebote aufgegeben oder wie viele sich auf eine der Mischformen eingelassen haben. Neben der Urform der Public Cloud gibt es die Private Cloud, bei der einzelne technologische Elemente ihren Weg rückwärts in das klassische Rechenzentrum gefunden haben, neben einer Hybrid-Cloud, die aus einer gemeinsamen Hülle aus altem Rechenzentrum und neuen Cloud-Formationen besteht, vielleicht sogar als Multi-Cloud - für Anwender, die sich nicht für eine einzige Variante entscheiden wollen, sondern erst einmal einem bunten Mit- und Durcheinander verschiedener Public Clouds zuneigen.

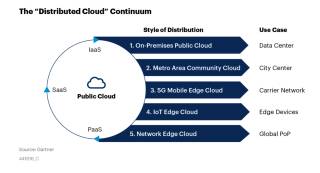

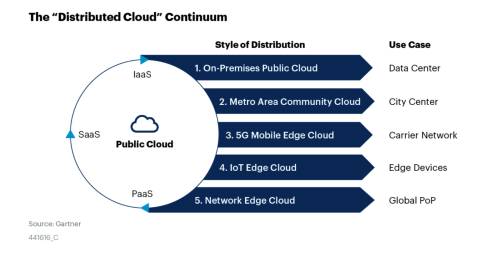

Die Analysten von Gartner empfehlen angesichts dieser Situation einen neuen Typus oder eine übergeordnete Bezeichnung: Die „Distributed Cloud“ soll die Schwächen des hybriden Ansatzes überwinden, der in der Praxis oft auseinanderdriftet. Es gehe um die Regie oder den Zusammenhalt der verschiedenen Komponenten aus interner und externer Hard- und Software, die von Unternehmen mehr oder weniger locker miteinander verbunden werden. Gartner spricht von „Substations“, die in einem gemeinsamen Konzept des Public-Cloud-Anbieters organisiert, verwaltet und weiterentwickelt werden. Alles verbleibt im Besitz und unter der zentralen Kontrolle des Eigentümers der Public Cloud.

Gartner kommt Ende April 2020 im Report „,Distributed Cloud‘ Fixes What ,Hybrid Cloud‘ Breaks“ zu dem Schluss: Viele Unternehmen, die mit der Public Cloud liebäugeln oder sie in verschiedenen Formen bereits einsetzen, müssen sich weiter mit Technologien befassen, die sie bislang schon in ihren eigenen Rechenzentren verwenden: „Diese Kunden können ihre bisher verwendeten Technologien nicht einfach aufgeben zugunsten einer kompletten und schnellen Migration in die Public Cloud. Zurück halten sie die bisherigen Ausgaben, Anforderungen bei den Regeln und Speicherorten für Daten sowie auch die notwendige Integration mit Nicht-Cloud-Systemen im Rechenzentrum. Stattdessen verwenden sie eine Kombination von Cloud-Varianten, die von der Public Cloud oder von einer Private Cloud inspiriert sind und eine gemischte, hybride Umgebung erzeugen.“

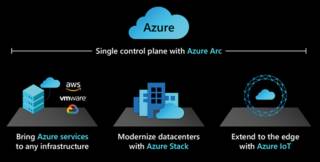

Die führenden Public-Cloud-Anbieter haben sich im Prinzip schon seit einiger Zeit stillschweigend diesem Ansatz verschrieben: Sie haben erkannt, dass viele Unternehmen nicht so einfach auf ihre Angebote umsteigen und dass ihre Resistenz reale Gründe hat. Ihre Lösung lautet recht einfach: „Kommt ihr nicht zu uns in unsere Public Cloud, dann kommen wir in der einen oder anderen Form zu euch in euer Rechenzentrum.“ Am deutlichsten zeigt sich dies in der Terminologie und den Services von Amazon AWS: „Outposts“, also Außen- oder Vorposten, heißen die strategischen Angebote, die der Konzern widerstrebenden Unternehmen macht. Bei Microsoft Azure spricht man weniger deutlich von „Stack Hub“ und bei Google Cloud von „Anthos“.

AWS Outposts: Bei Outposts handelt es sich um eine Service-Lösung aus einer Hand. Der Kunde bestellt das Outposts-Paket auf einer Basis von drei Jahren, AWS liefert es, installiert es, betreibt es und nimmt es nach Ablauf zurück, oder es schließt sich ein neuer Vertrag an. Die Hardware kommt zunächst in einer Mindestausstattung, die etwa ein Viertel eines üblichen Racks einnimmt, und unterstützt die EC2 Compute Instances, die sich gewöhnlich in einer Public Cloud von AWS befinden. Einige AWS-Services wie EC2, EBS, ECS, EKS und RDS können lokal installiert werden und laufen auf dem Outpost. Alle anderen AWS-Dienste sind nur in der Public Cloud erhältlich. Damit wird das eigene Rechenzentrum eines Unternehmens oder zumindest ein relevanter Bereich davon zu einem (begrenzten) Teil der AWS-Infrastruktur. Die Kunden können selbst keine Änderungen oder Eingriffe an den Outposts vornehmen, der Betrieb und die Verwaltung liegen komplett bei AWS, was auch für Upgrades und Security-Maßnahmen gilt.

Im Report „How to Bring the Public Cloud On-Premises With AWS Outposts, Azure Stack and Google Anthos“ vom April 2020 schreibt Gartner: „Die AWS Outposts sind nicht dazu gedacht, in einem nicht mit dem Netzwerk verbundenen Modus zu laufen. Sie sind deshalb auch nicht tauglich für von AWS isolierte Aufgaben. Sie müssen immer verbunden sein mit einer Public-Region von AWS oder mit einer von AWS autorisierten kommerziellen oder öffentlichen Organisation.“

Azure Stack Hub: Microsoft setzt, anders als AWS, auf eine offene Lösung. Die Kunden kaufen zertifizierte Hardware von einem Microsoft-Partner, auf der ausgewählte Dienste von Azure vorab installiert sind. Bezahlt wird für die Inanspruchnahme dieser Services direkt an Microsoft. Die Kunden können auch wählen, wie und wo sie Stack Hub installieren wollen - in ihrem Rechenzentrum, in Zweigstellen oder an anderen entfernten Orten. Im Unterschied zu AWS sind diese Installationen auch in einem nicht mit dem Microsoft-Netzwerk verbundenen Status arbeitsfähig. Insofern kommen sie der bestehenden Infrastruktur eines Kunden mehr entgegen, weisen aber ebenfalls einige Begrenzungen auf: Der Hardware-Verkäufer bleibt zuständig für Firmware- und Treiber-Updates, während Microsoft Azure sich um Software-Updates und Fehlerbereinigung kümmert. Der Kunde besitzt insofern zwei unterschiedliche Support-Verträge. Wie schon bei den AWS Outposts bekommt der Kunde letztlich nur ein „versiegeltes“ System und verfügt nicht über eigenständige Administrationsrechte.

Google Anthos: Google Anthos ist eine reine Software-Lösung, speziell für Container und Kubernetes ausgelegt. Sie soll mit AWS und Azure zusammenarbeiten. Anthos-Cluster sind lokal im Rechenzentrum der Kunden auf Basis von VMware vSphere installiert und mit einem breiten Spektrum an Hardware kompatibel. Die eigene VMware-Schicht kann eventuell höhere Gesamtkosten verursachen. Google will auch Varianten für KVM und Hyper-V herausbringen.

Fazit & Ausblick

Laut Technology Business Research (TBR) arbeiten Google, IBM und SAP daran, für jene 80 Prozent der Unternehmen, die noch nicht den Übergang zu Cloud-Lösungen absolviert haben, Erleichterungen für die Migration bestimmter Anwendungen auf den Weg zu bringen, die insbesondere Regulierungs- und Compliance-Fragen adressieren.

Zu den Branchen, auf die diese Pläne abzielen, gehören etwa das Bankwesen, der Gesundheitssektor oder der Einzelhandel. SAP und Google wollen sich laut TBR besonders um die Integration von Artificial-Intelligence- und Machine-Learning-Technologien in ihre Cloud-Ansätze bemühen. IBM Cloud bereitet zum Beispiel ein eigenes „Cloud Policy Framework“ für Financial Services vor, das spezielle Lösungen für diese Branche unterstützen soll.

Auf dem Weg zur Public Cloud sind viele Anwender angesichts der neuen Technologien und besonders ihrer Mischformen überfordert. Hinzu kommen neue Anforderungen und Sparzwänge aufgrund der Corona-Pandemie und der mit ihr verbundenen Lockdowns. Damit wächst der Bedarf an Beratung und Support.

Es eröffnen sich speziell neue Geschäftsfelder bei Monitoring und Kontrolle auf dem Weg zur Public Cloud und den Aktivitäten der sich rasch entwickelnden Super-Rechenzentren. So bieten etwa Logicworks und LogicMonitor Tools dafür an. Logicworks hat sich auf die Migration zu AWS und zu Azure spezialisiert, während sich LogicMonitor um „hybrides Monitoring“ kümmert - jenen Bereich aus interner IT und externen Cloud-Angeboten, die sich in vielen Fällen miteinander vermischen. Beobachtet werden traditionelle Anwendungen und gewohnte Tools und wie sie an die neuen Cloud-Bedingungen angepasst werden müssen. Für jeden Kunden werden eigene und geschützte Dateien mit den protokollierten Daten angelegt. Im Unterschied zu amerikanischen Kunden, die sich oft selbst im Internet informieren, legen europäische mehr Wert auf individuelle Beratung, heißt es bei LogicMonitor. Zu den weiteren Anbietern, die sich unter verschiedenen Aspekten um die Migrationsproblematik kümmern, gehören Data-dog, AppDynamics, Librato (jetzt bei Solarwinds), Sumo Logic und ThousandEyes (jetzt bei Cisco).

Swisscom

Neue Cyberbedrohungen auf dem Radar

Der neue Cyber Security Threat Radar von Swisscom zeigt die Angriffsmethoden und das Vorgehen von Cyberkriminellen. Er beleuchtet neu auch die Entwicklungen in den Bereichen "Disinformation & Destabilisation", "Manipulated Generative AI" und "Unsecure IoT/OT-Devices".

>>

Personen

Nfon CCO Gernot Hofstetter tritt zurück

Gernot Hofstetter war sechs Jahre beim Münchner Cloud-PBX-Anbieter Nfon, zuletzt als Chief Commercial Officer. Nun hat er das Unternehmen verlassen und ist zum Start-up Stealth Mode gewechselt.

>>

Zum Welt-Passwort-Tag

"95 % der Cyber-Sicherheitsprobleme sind auf menschliche Fehler zurückzuführen"

Am 2. Mai ist Welt-Passwort-Tag. Ein guter Anlass für den Frühlingsputz bei alten Logins und ein grundsätzliches Überdenken der eigenen Cybersecurity. Miro Mitrovic von Proofpoint gibt dazu einige konkrete Tipps.

>>

Künstliche Intelligenz

Memary - Langzeitgedächtnis für autonome Agenten

Das Hauptziel ist es, autonomen Agenten die Möglichkeit zu geben, ihr Wissen über einen längeren Zeitraum hinweg zu speichern und abzurufen.

>>