20.10.2020

Kontrolle vor Nutzung

1. Teil: „Künstliche Intelligenz mit Ethik“

Künstliche Intelligenz mit Ethik

Autor: Oliver Schonschek

Bild: Shutterstock / kentoh

Datenschutz und Compliance, aber auch die Kunden fordern eine KI mit ethischen Maßstäben.

Künstliche Intelligenz gilt in Deutschland als umstritten, weil dafür oft großen Mengen an Daten verarbeitet werden müssen und Algorithmen Entscheidungen fällen, deren Grundlage für die betroffenen Menschen nicht zu durchschauen sind. Doch Fabian Schladitz, Leiter des Center of Excellence Künstliche Intelligenz der IT-Beratung Capgemini Deutschland, sieht das anders. Er ist der Ansicht, dass die Verbraucher hierzulande prinzipiell genauso offen für den KI-Einsatz sind wie anderswo. Um davon zu profitieren, müssten Unternehmen allerdings Strukturen und einen Wertekanon schaffen, damit ethische Aspekte angemessen berücksichtigt würden. Sie müssten darauf achten, dass dies schon während der Entwicklung von KI-Systemen geschehe, und wenn die KI anschließend eingesetzt werde, sei es mindestens genauso wichtig, alle Beteiligten über die Interaktionen mit der KI umfassend zu informieren und sie zu befähigen, bewusst mit ihr umzugehen.

Denn: „Unternehmen stehen an einem Scheideweg: Es wird deutlich, dass es nicht allein um Vorschriften und Compliance geht, sondern dass ethische Grundsätze vorteilhaft für das eigene Geschäft sein können“, postuliert Schladitz.

Alle wollen ethische KI

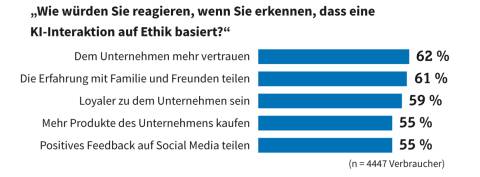

Laut der Studie „Why addressing ethical questions in AI will benefit organizations” des Capgemini Research Institute sind insbesondere Transparenz und Fairness für Konsumenten von großer Bedeutung. Ein als ethisch empfundener KI-Einsatz steigert demnach bei knapp 60 Prozent die Kaufbereitschaft und Loyalität gegenüber dem Unternehmen.

Andersherum gilt aber auch: Ethische Probleme bei der KI-Interaktion, zum Beispiel eine fehlende Zustimmung zur Datennutzung oder intransparente und verzerrte Ergebnisse, haben laut der Umfrage auch negative Auswirkungen: 41 Prozent der Konsumenten würden sich beschweren, 36 Prozent eine Erklärung verlangen. Ein Drittel würde den Kontakt zum Unternehmen sogar abbrechen.

Auch aufseiten der Unternehmen selbst wird die Bedeutung ethischer Grundsätze bei KI-Lösungen durchaus gesehen. Wie die Capgemini-Studie ergab, berichten Führungskräfte aus fast neun von zehn Unternehmen, dass bei ihnen die Nutzung von KI innerhalb der letzten zwei bis drei Jahre ethische Fragen aufgeworfen habe. Zu den Anlässen zählt etwa die Sammlung persönlicher Patientendaten ohne Zustimmung im Gesundheitswesen. 51 Prozent der Führungskräfte finden es der Studie zufolge wichtig, sicherzustellen, dass KI-Systeme ethisch und transparent sind. 41 Prozent geben an, dass sie den Einsatz von ethisch problematischen KI-Systemen wahrscheinlich beenden würden oder dies bereits getan haben.

2. Teil: „Gefahren unethischer KI“

Gefahren unethischer KI

Die Bedeutung ethischer KI für den Unternehmenserfolg wird klar, wenn man sich die möglichen Folgen anschaut, die eine KI mit mangelhafter Ethik verursachen kann:

Die Verarbeitung personenbezogener Daten durch die KI findet automatisch und ohne vorherige Einwilligung der Betroffenen statt Entscheidungsfindungen mittels Machine Learning sind intransparent und nicht zurückzuverfolgen

Geschäftliche Entscheidungen, Preisgestaltungen und Angebote an Kunden erscheinen aufgrund tendenziöser und vorurteilsbehafteter Daten oder fehlerhafter Algorithmen diskriminierend.

Möglich werden zum Beispiel unpassende Angebote durch Fehler der KI während der Zielgruppenanalyse, da die KI ungewollt die Kriterien für die Zielgruppenbestimmung verändert hat. Wenn ein Kunde ein anderes Angebot erhält als ihm bekannte Personen und die Unterschiede für ihn nicht nachvollziehbar sind, dann wird sich dieser Kunde womöglich benachteiligt sehen und das Angebot des Unternehmens ablehnen. Zudem kann der Ruf des Unternehmens nachhaltig leiden, insbesondere wenn das öffentlich bekannt wird.

Zum Problem kann unethische KI auch in der Personalabteilung werden, wenn Bewerberinnen und Bewerber auf Basis intransparenter Empfehlungen einer KI-basierten HR-Lösung abgelehnt werden. Die möglichen Folgen aus Compliance-Sicht liegen auf der Hand, wenn man an das Allgemeine Gleichbehandlungsgesetz (AGG) denkt.

Die Plattform Lernende Systeme (PLS), ein Expertenkreis der forschenden Informatik mit Wirtschaftsunternehmen im Feld der Künstlichen Intelligenz, erläutert anschaulich, wie es zu solchen unethischen KI-Lösungen kommen kann: Ein KI-System wird zum Vorsortieren von Bewerbungen mit den Daten der in der Vergangenheit erfolgreich eingestellten Beschäftigten trainiert. Sind diese überwiegend männlich, lernt der Algorithmus, Bewerbungen von Männern besser zu bewerten als die von Frauen. Auf technischem Weg setzt das KI-System dann Diskriminierungen durch.

Ethische KI-Lösungen sind also nicht nur eine gesellschaftliche Forderung, sondern sie sind mitentscheidend für den geschäftlichen Erfolg und für die Einhaltung der Compliance, sobald KI-Lösungen in den betrieblichen Prozessen zum Einsatz kommen.

3. Teil: „Richtlinien setzen Maßstäbe“

Richtlinien setzen Maßstäbe

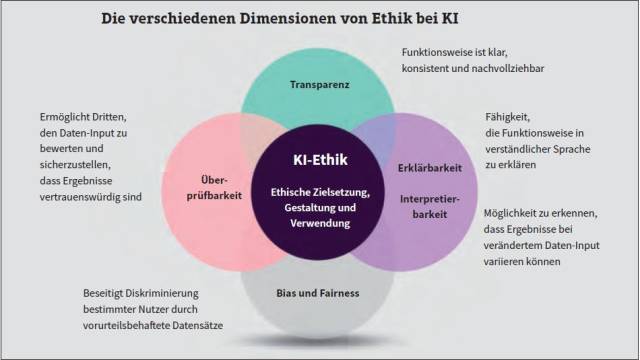

Was aber macht Ethik in einer KI-Lösung genau aus? Luciano Floridi, Director of Digital Ethics Labs am Oxford Internet Institute, nennt Transparenz, Verantwortlichkeit und Befähigung als zentrale Kriterien und erklärt: „Transparenz, damit Menschen sehen, was man tut; Verantwortlichkeit, weil man die Verantwortung übernimmt für das, was man tut; und Befähigung, indem man die Verantwortung dafür übernimmt, dass es anderen möglich ist zu sagen, ob man das Richtige getan hat oder etwas nicht gut war.“

Um dies konkret in einem Unternehmen umzusetzen, braucht es allerdings mehr als nur drei Begriffe. Es sind Richtlinien gefragt, die möglichst genau sagen, wer was tun und lassen soll. „Vorschriften, die mit dem richtigen Gleichgewicht und im besten Interesse aller Beteiligten umgesetzt werden, sind für optimale Ergebnisse unerlässlich“, meint dazu Paul Cobban, Chief Data and Transformation Officer bei DBS, einem multinationalen Bank- und Finanzdienstleistungskonzern mit Hauptsitz in Singapur. „Unternehmen müssen über das Gleichgewicht zwischen den Rechten des Einzelnen und den Rechten der Unternehmen nachdenken. Die andere Herausforderung im Zusammenhang mit der Regulierung besteht darin, dass sich in einer zunehmend vernetzten Welt die Vorschriften in einem Teil der Welt von denen in anderen Teilen unterscheiden“, so Cobban weiter.

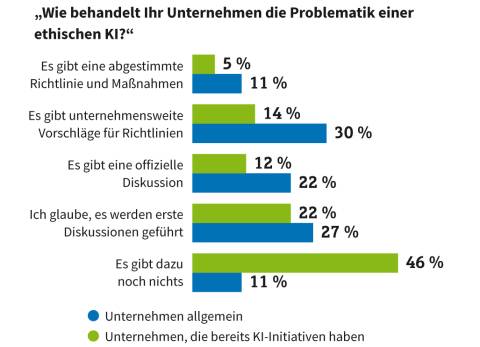

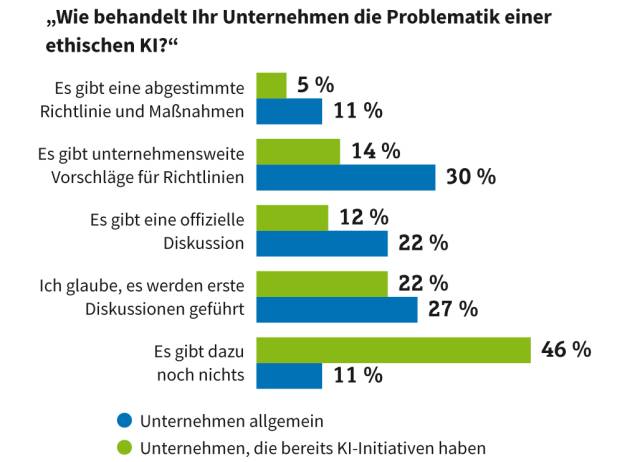

Es ist also nicht einfach, eigene KI-Richtlinien im Unternehmen zu definieren, um den ethischen Einsatz sicherzustellen. Im „Digitalisierungsmonitor 2020“ der Management- und Technologieberatung BearingPoint erklären lediglich 5 Prozent der Befragten, dass es in ihrem Unternehmen bereits abgestimmte Richtlinien und Maßnahmen für den ethischen Umgang mit KI gibt. Bei 46 Prozent existieren gar keine Richtlinien und Maßnahmen. Weitere 22 Prozent wissen es nicht sicher, vermuten aber immerhin, dass erste Diskussionen geführt werden.

„Um KI von Anfang an richtig zu machen, ist die Etablierung eines KI-Ethik-Teams zur Ausarbeitung und Festlegung grundlegender Prinzipien sowie eine entsprechende Kommunikation unabdingbar. Für Unternehmen, die schon Erfahrung mit KI gemacht haben, ist es umso wichtiger, sich auch diesem Thema konsequent zu widmen“, erklärt Theodor Schabicki, Partner bei BearingPoint. Der Experte für Künstliche Intelligenz nennt eine Reihe von Vorteilen, die das für Unternehmen bringt: „Sich hier richtig zu positionieren, führt zur Akzeptanz von KI im Unternehmen selbst und dient der Glaubwürdigkeit. Darüber hinaus - und das sollte für Unternehmen immer ein Argument sein - liefert der transparente Umgang mit Ethik einen nicht zu unterschätzenden Mehrwert für Kunden. Hier liegt eine große Chance, um Ethik und KI zum Differenzierungsmerkmal zu machen.“

Und es gibt bereits eine Reihe von Guidelines, die Orientierung bieten können, wenn man eigene KI-Richtlinien entwickeln möchte und sehen will, wie andere vorgegangen sind:

Auch die EU-Kommission hat entsprechende Leitlinien erstellen lassen. Wesentlich sind:

Menschliche Entscheidungsfreiheit und Kontrolle: KI-Systeme sollten gerechte Gesellschaften ermöglichen, indem sie die menschliche Handlungsfähigkeit und die Grundrechte unterstützen und die menschliche Autonomie nicht verringern, einschränken oder fehlleiten.

Robustheit und Sicherheit: Vertrauenswürdige KI erfordert, dass Algorithmen sicher, zuverlässig und robust genug sind, um Fehler oder Inkonsistenzen während aller Lebenszyklusphasen von KI-Systemen zu behandeln.

Datenschutz und Datenverwaltung: Die Bürger sollten die volle Kontrolle über ihre eigenen Daten haben, während die sie betreffenden Daten nicht dazu verwendet werden, sie zu schädigen oder zu diskriminieren.

Transparenz: Die Rückverfolgbarkeit von KI-Systemen ist zu gewährleisten.

Vielfalt, Nichtdiskriminierung, Fairness: KI-Systeme sollten die gesamte Bandbreite menschlicher Fähigkeiten, Fertigkeiten und Anforderungen berücksichtigen und Zugänglichkeit sicherstellen.

Gesellschaftliches und ökologisches Wohlergehen: KI-Systeme sollten eingesetzt werden, um einen positiven sozialen Wandel sowie Nachhaltigkeit und ökologische Verantwortung zu fördern.

Rechenschaftspflicht: Es sollten Mechanismen eingerichtet werden, um die Verantwortung und Rechenschaftspflicht für KI-Systeme und deren Ergebnisse sicherzustellen.

Bleibt die Frage: Selbst wenn man eigene KI-Ethik-Richtlinien definiert hat oder einen KI-Anbieter wählt, der KI-Guidelines veröffentlicht hat - woher weiß man, dass die genutzte KI-Lösung wirklich ethisch vertretbar ist und sich an die Regeln hält?

4. Teil: „KI-Ethik testen“

KI-Ethik testen

Unternehmen, die sich an einer eigenen KI-basierten Lösung versuchen wollen, können von einigen Werkzeugen profitieren, mit denen sich KI in gewissem Rahmen testen lässt. Beispiele für solche Tools sind das Ethics and Algorithms Toolkit, um Risiken zu ermitteln, die mit einem Algorithmus verbunden sein können, das What-If-Tool von Google, um das Verhalten einer KI zu simulieren, und der Bias-Report, ein Open-Source-Toolkit für Entwickler und Analysten, mit dem sich Modelle für maschinelles Lernen auf Ethik-Probleme hin überprüfen lassen.

Ein weiteres Tool ist der Pegasystems Ethical Bias Check. Er soll helfen, Voreingenommenheiten oder Diskriminierungen in KI-Anwendungen automatisch zu identifizieren und zu eliminieren. Der Ethical Bias Check ist eine Funktionserweiterung des Pega Customer Decision Hub, der den KI-Einsatz im Kundendialog steuert. Das Tool kann laut Anbieter sowohl simulativ im Vorfeld als auch operativ im laufenden Prozess KI-Anwendungen auf eventuelle Diskriminierung über Kundensegmente hinweg prüfen. Dabei lassen sich Schwellwerte selbst definieren, etwa für

Alter, Geschlecht oder Herkunft. Damit soll es Unternehmen möglich sein, unbeabsichtigte Voreingenommenheiten in Vertriebs- und Marketingstrategien zu vermeiden.

Alter, Geschlecht oder Herkunft. Damit soll es Unternehmen möglich sein, unbeabsichtigte Voreingenommenheiten in Vertriebs- und Marketingstrategien zu vermeiden.

KI-Ethik zertifizieren

Für die Außenwirkung bei den Kunden sind Gütesiegel und Zertifikate hilfreich, die die Ethik einer Künstlichen Intelligenz bescheinigen. Solche Nachweise sind nicht nur für die Anbieter von KI-Lösungen interessant, sie stellen auch eine wichtige und praktische Unterstützung dar, wenn man als Unternehmen eine KI-basierte Lösung anschaffen und einsetzen möchte. Die Arbeit an solchen Gütesiegeln läuft inzwischen auf Hochtouren.

Ein Beispiel dafür ist das Projekt „Zertifizierung zur Sicherstellung einer vertrauenswürdigen KI“, an dem das Fraunhofer-Institut für Intelligente Analyse- und Informationssysteme IAIS beteiligt ist. Das dort geplante KI-Zertifikat soll auch Fragen der KI-Ethik behandeln und die Einhaltung von KI-Ethik-Richtlinien bescheinigen.

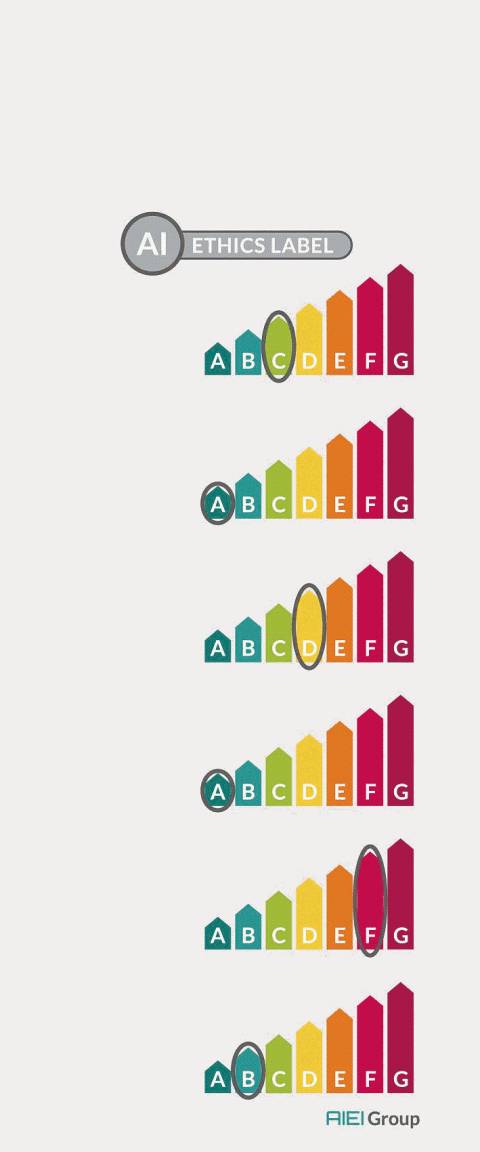

Der Verband der Elektrotechnik Elektronik Informationstechnik (VDE) hat zusammen mit weiteren Partnern ein Modell entwickelt, mit dem sich nach dem Vorbild des Energieeffizienz-Labels die Ethik einer KI transparent und differenziert abbilden lassen soll.

Zum Wie und Warum des Labels erklärt Sebastian Hallensleben, KI-Spezialist im VDE und Initiator des Modells: „Ethik wird genauso wie das Thema Nachhaltigkeit zum Wettbewerbsvorteil. Unternehmen, die transparent aufzeigen, wie sich ihre KI-Systeme ethisch verhalten, bringen ihre Produkte leichter in den Markt. Mit dem Modell fördern wir das Vertrauen der Bürger in KI-Systeme, die direkt mit Menschen zu tun haben oder mit deren Daten umgehen. Gleichzeitig räumen wir Ängste in der Industrie vor überbordenden neuen Vorschriften aus.“

Das VDE-Modell einer Ethik-Kennzeichnung lehnt sich an die bereits bei Haushaltsprodukten bewährte Energieeffizienz-Kennzeichnung an. Ähnlich der Energieeffizienz-Klassen veranschaulicht es die Eigenschaften von KI-Systemen, beispielsweise Schutz der Privatsphäre, Transparenz oder Diskriminierungsfreiheit.

„Wir machen KI-Ethik messbar und schaffen damit einen transparenten Wettbewerb, ermöglichen regionale Mindeststandards für bestimmte Anwendungen und geben Kunden Transparenz“, erläutert Hallensleben das Modell. Der Schlüssel sei dabei die Messbarkeit, damit die Kennzeichnung auch tatsächlich aussagekräftig ist.

Der Vorschlag zur Normung stieß auch in der International Electrotechnical Commission (IEC) grundsätzlich auf Zustimmung. Sebastian Hallensleben konstatiert sogar ein Interesse Chinas am VDE-Modell: „Gerade für China ist eine weltweit einheitliche Ethik-Kennzeichnung essenziell, um seine Produkte global vermarkten zu können.“ Noch sei das Gestaltungsfeld bei KI weit offen. Im internationalen Wettrennen um KI habe Deutschland gute Chancen, mit ethischer und transparenter KI „made in Germany“ vorne mitzumischen.

Fazit & Ausblick

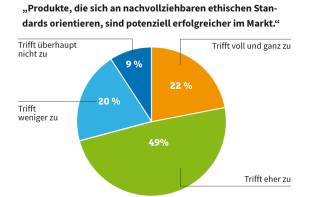

Sicher ist: Die Verbraucher in Deutschland sind für solch ein KI-Ethik-Label. So ergab eine Studie des Bundesverbands Digitale Wirtschaft (BVDW): Stolze 72 Prozent der Bundesbürger erklären, sie würden digitale Produkte und Services bevorzugen, die so geplant sind, dass sie sich bei ihrer Entscheidungsfindung an nachvollziehbaren ethischen Standards orientieren. Eine ähnliche Erkenntnis haben die Digitalunternehmen gewonnen. Von ihnen sind 71 Prozent der Ansicht, dass digitale Produkte, die an ethischen Standards ausgerichtet sind, auch potenziell erfolgreicher im Markt sind.

Mitunter kann das Einhalten ethischer Standards eine Einschränkung des Funktionsumfangs zur Folge haben - fast zwei Drittel der Verbraucher (63 Prozent) würden das in Kauf nehmen. Bemerkenswert: Bei den befragten Digitalunternehmen liegt dieser Anteil sogar bei 83 Prozent.

Der deutsche Markt scheint also auf ethische KI-Lösungen zu warten - beispielhafte Leitlinien, Werkzeuge für KI-Ethik-Tests und Modelle für KI-Ethik-Labels gibt es bereits.

Wie sich der Trend zu einer ethischen KI international entwickelt, bleibt allerdings abzuwarten, denn: „Hierzulande spielen Themen wie Ethik und Datenschutz eine deutlich größere Rolle als zum Beispiel in den USA“, betont BVDW-Präsident Matthias Wahl. Im Bereich KI gibt es jedoch viele Lösungen, die nicht aus Deutschland oder der Europäischen Union stammen.

Test-Framework

Testautomatisierung mit C# und Atata

Atata ist ein umfassendes C#-Framework für die Web-Testautomatisierung, das auf Selenium WebDriver basiert. Es verwendet das Fluent Page Object Pattern und verfügt über ein einzigartiges Protokollierungssystem sowie Trigger-Funktionalitäten.

>>

3 Modelle

Business GPT - Telekom bringt KI-Angebot für Unternehmen

Mit ihren Business GPT-Angeboten will die Telekom eine sichere KI-Lösung für Geschäftskunden anbieten. Drei Modelle haben die Bonner dafür entwickelt – und die haben ihren Preis.

>>

Programmiersprache

Primärkonstruktoren in C# erleichtern den Code-Refactoring-Prozess

Zusammenfassen, was zusammen gehört: Dabei helfen die in C# 12 neu eingeführten Primärkonstruktoren, indem sie Code kürzer und klarer machen.

>>

Huawei Roadshow 2024

Technologie auf Rädern - der Show-Truck von Huawei ist unterwegs

Die Huawei Europe Enterprise Roadshow läuft dieses Jahr unter dem Thema "Digital & Green: Accelerate Industrial Intelligence". Im Show-Truck zeigt das Unternehmen neueste Produkte und Lösungen. Ziel ist es, Kunden und Partner zusammenzubringen.

>>