16.02.2018

Informationsintegration bei KMUs

1. Teil: „Datenintegration wird unerlässlich“

Datenintegration wird unerlässlich

Autor: Charles Glimm

Kapralcev / shutterstock.com

Von einem einheitlichen Blick auf Firmendaten profitieren auch kleine Unternehmen. Daher sollten sich KMUs ebenfalls mit Data Integration beschäftigen.

Der Begriff Data Integration, im Deutschen meist als Informationsintegration, seltener Datenintegration bezeichnet, steht für die Zusammenführung unterschiedlicher Daten aus verschiedenen Quellen, typischerweise zum Zweck der Analyse, für Business Intelligence, Berichtswesen oder Migration. Im Kern geht es darum, aus bis dahin isolierten Informationen ein sinnvolles Ganzes zu gestalten, um eine einheitliche Sicht auf unternehmensweite Daten zu erhalten.

Ein Beispiel: Die Personalabteilung eines kleinen Unternehmens hat eine neue Führungsposition zu besetzen. Obwohl im Unternehmen nur rund 100 Mitarbeiter beschäftigt sind, ist die lückenlose Verfolgung des internen Talent-Pools eine Herausforderung. Das Personalverwaltungssystem enthält eine Fülle von Mitarbeiterdaten, aber daraus resultierende Erkenntnisse sind nicht in einer interpretierbaren Weise ins Talentmanagementsystem integriert. So gibt es im Unternehmen zwar geeignete Mitarbeiter, aber da sich mangels Integration Daten aus Personalmanagement und Talentbeschaffung nicht kombinieren lassen, bleibt dies unerkannt.

Einheitlicher Blick

Eine Datenintegrationsstrategie hätte für eine einheitliche Sicht auf die Datensätze gesorgt und so die interne Einstellung gesichert, was wiederum Rekrutierungskosten gespart und eine schnellere Besetzung der Stelle, noch dazu mit einem top motivierten Mitarbeiter, ermöglicht hätte.

Das Beispiel lässt sich leicht auf viele andere betriebliche Situationen übertragen. Nach einer Übernahme müssen inkompatible Datenbanken zusammengeführt werden, überalterte Software wird von einem neuen System mit anderen Datenformaten abgelöst, Webprojekte entstehen aus einer Zusammenschau von Daten aus verschiedensten Quellen und dergleichen.

Hinzu kommt, dass die Datenmengen, die sich täglich ansammeln, in jeder Organisation sprunghaft zunehmen, sodass kleine wie große Unternehmen von einer Datenintegrationsstrategie nicht nur profitieren, sondern sie eigentlich implementieren müssen, wenn sie den Anschluss an die Konkurrenz nicht verlieren wollen.

Unternehmen ohne Datenintegrationsstrategie verschwenden letztlich Zeit und Ressourcen, sobald und wann immer die Notwendigkeit entsteht, unterschiedliche Datenquellen zusammenzubringen. Nicht integrierte Geschäftsdaten hingegen gefährden nicht nur die Effizienz, sondern ziehen weitere Probleme nach sich. Das Unternehmen büßt Wettbewerbsvorteile ein, weil den Mitarbeitern vielfach nicht die Informationen zur Verfügung stehen, die sie für fundierte Entscheidungen benötigen. Abläufe versagen, wenn Informationen nicht zur richtigen Zeit an den richtigen Ort gelangen. Die Zusammenarbeit leidet, wenn Führungskräfte und Mitarbeiter das Vertrauen in die Zuverlässigkeit und Aktualität der abgerufenen Daten verlieren.

Für eine effiziente Unternehmensführung, die datengetriebene Erkenntnisse nutzt, um Wettbewerber mit datengesteuerten Taktiken zu übertreffen, ist eine Datenintegrationsstrategie unerlässlich. Sie eröffnet die Möglichkeit zur gemeinsamen Verarbeitung von Daten aus einer Vielzahl von Quellen wie Unternehmensanwendungen, Tabellenkalkulationen oder proprietären Datenbanken und erlaubt es, unstrukturierte Daten aus sozialen Medien, E-Mails und von Webseiten ebenfalls einzubeziehen. Syntaktische und semantische Prüfungen stellen sicher, dass alle Daten den Geschäftsregeln und -richtlinien entsprechen, Deduplizierung und Entfernen von falschen oder falsch formatierten Daten verbessern Prozesse und gewonnene Erkenntnisse.

Eine bessere Integration mit Kunden außerhalb des internen Netzwerks optimiert das Kundenerlebnis und damit die Verkäufe. Eine einheitliche Sicht auf alle Informationsressourcen gewährleistet, dass alle Benutzer die gleichen, konsistenten Daten verwenden, wenn sie geschäftliche Entscheidungen treffen.

2. Teil: „Extract, Transform, Load“

Extract, Transform, Load

Um diese Ziele zu erreichen, existieren verschiedene Ansätze, einer der wichtigsten und verbreitetsten wird als Extract, Transform, Load oder kurz ETL bezeichnet. ETL ist ein Prozess, bei dem große Datenmengen aus verschiedenen Datenbanken extrahiert, in ein gemeinsames Format übertragen, bereinigt und in eine spezialisierte Berichtsdatenbank geladen werden, das sogenannte Data Warehouse.

ETL-Daten können aus beliebigen Quellen stammen, einschließlich einfacher Dateien, Anwendungsdaten aus CRM und ERP oder Mainframe-Anwendungsdaten. Im Transform-Abschnitt des Prozesses werden die Daten einerseits gereinigt und von Duplikaten befreit, vor allem muss die Software aber auch Konsistenzprobleme lösen und regelgestützt konsistente Daten an das Data-Warehouse-Repository weitergeben. Sind die Daten einmal im Data Warehouse angekommen, können sie von Business-Intelligence-Front-Ends abgefragt werden, die damit konsolidierte Daten für Berichte und Dashboards erhalten.

Während Unternehmen jeder Größe von einer Datenintegrationsstrategie gleichermaßen profitieren, unterscheiden sich Prioritäten und Anforderungen von kleinen und großen Unternehmen in einigen Punkten. Zum Beispiel müssen KMUs in der Regel mit kleinerem Budget wirtschaften. Eine dünnere Personaldecke führt dazu, dass jeder Rolle bei der Umsetzung eine höhere Verantwortung zufällt. Mitarbeiterbandbreite und Arbeitszeit sind viel begrenztere Ressourcen als in Großunternehmen. Somit muss die Kostenentwicklung sorgfältiger verfolgt und verwaltet werden.

Insbesondere kleine Unternehmen sollten sich nicht zu stark auf die Einrichtung der Datenintegration selbst konzentrieren, sondern diese Aufgabe an einen Anbieter abgeben, der die nötige Software bereitstellt und die Datenintegrationsstrategie unterstützt. Es gibt genügend Datenintegrations-Software, sodass sich für jedes Budget und alle Anforderungen eine passende Lösung findet. Für KMUs gilt es, genau diese passende Lösung zu suchen, die es ihnen ermöglicht, sich auf ihr Kerngeschäft zu konzentrieren, weil das Tool ihre Integrationsbedürfnisse zuverlässig abdeckt.

3. Teil: „Die richtige Lösung“

Die richtige Lösung

Zu den Eigenschaften, die eine Datenintegrationslösung für KMUs haben sollte, zählen neben überschaubaren Bereitstellungskosten vor allem eine möglichst flache Lernkurve und hohe Anwenderfreundlichkeit, anschauliche Datenvisualisierungen zur Unterstützung von Benutzern ohne technischen Hintergrund, Echtzeit-Datenlieferung und die Fähigkeit, in beide Richtungen zu skalieren, um sich flexibel an Veränderungen anzupassen. Je nach betrieblichen Gegebenheiten kann es von Vorteil sein, wenn mehrere Bereitstellungsoptionen, von On-Premise- bis zu Cloud-Diensten, verfügbar sind. Schließlich ist eine schnelle Rendite erstrebenswert. Anwendungsfälle, Branchenerfahrungen oder eine direkte Anfrage an den Lösungsanbieter können helfen, die ROI-Vorgaben eines Produkts abzusichern.

Die Marktforscher von Gartner konstatierten Ende 2016, der Markt der Datenintegrations-Tools befinde sich in einem teilweisen Umbruch, weil verstärkt flexible, skalierbare und leichtgewichtige Lösungen nachgefragt würden und die Anbieter sich auf diesen Bedarf ausrichteten. Das entspricht jedoch genau den besonderen Anforderungen von KMUs, was es für kleine Unternehmen, die bisher ohne Datenintegrationsstrategie auskommen, angezeigt erscheinen lässt, sich gerade jetzt nach einer Lösung umzusehen.

com! professional stellt im Folgenden einige Anbieter und Lösungen vor.

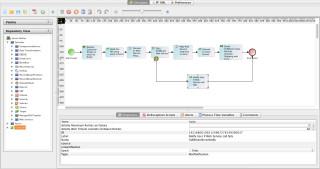

Actian

Actian, vormals Ingres, hat sich nach der Akquise weiterer Datenbankspezialisten wie Versant, Pervasive und ParAccel in den Jahren 2012 und 2013 als multinationaler Anbieter aufgestellt. Die hybride Integrationslösung Actian DataConnect bringt zur Unterstützung von Integrationsprozessen in Unternehmen eine Bibliothek mit Hunderten von Konnektoren mit und soll so eine schnelle Onboarding- und Selfservice-Integration ermöglichen. Der Nutzer kann Integrationen On-Premise, in der Cloud oder in hybriden Umgebungen entwerfen, bereitstellen und verwalten, ohne auf Datentypen oder Volumes beschränkt zu sein.

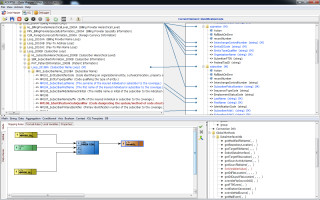

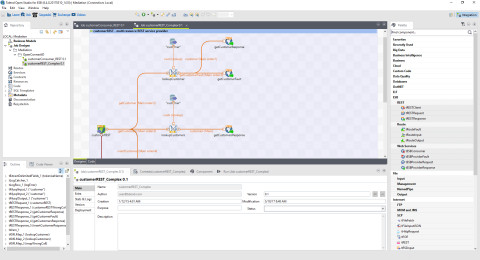

Einen Schwerpunkt legt DataConnect auf Wiederverwendung und Anpassungsfähigkeit, was einer kostengünstigen Integration unterschiedlicher Daten und Anwendungen von zahlreichen Endpunkten entgegenkommt. Für die Benutzerfreundlichkeit sollen intuitives Workflow-Design, eine vereinfachte Administration und Unterstützung für das bekannte Open-Source-Framework Eclipse sorgen. Design und Bedienung sind einheitlich für On-Premise- und Cloud-Implementierung. Integrationszuordnungen, Schemata, Artefakte, Regeln und Jobpläne lassen sich in einer visuellen Entwicklungsumgebung (IDE) erstellen oder ändern, ohne Programmier- oder Skript-Kenntnisse zu erfordern.

Die mit dem IDE-Framework erstellten Vorlagen sind wiederverwendbar für ein schnelles Skalieren oder den Ablauf ähnlicher Integrationen mit wenig Aufwand. Neben der großen Anzahl vordefinierter Konnektoren können mit Hilfe eines SDK benutzerdefinierte Konnektoren und andere Workflow-Komponenten erstellt werden. Dazu kommt ein standardisierter Ansatz für REST-konforme Web-Service-APIs.

4. Teil: „Adeptia und Attunity “

Adeptia und Attunity

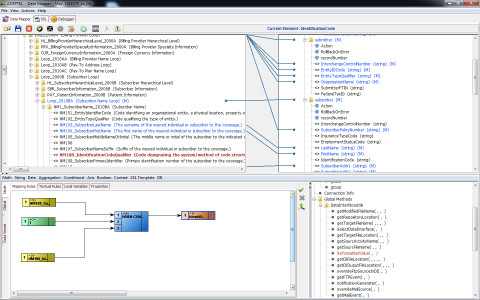

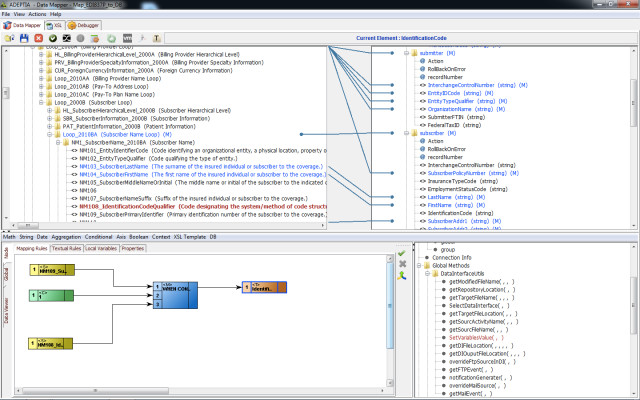

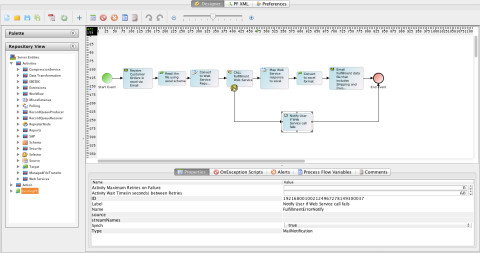

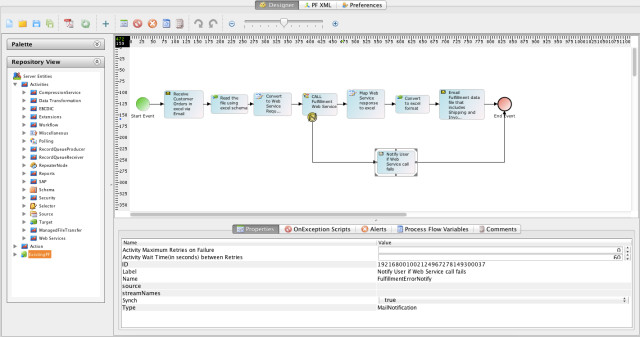

Adeptia Integration Suite (AIS) ist eine umfassende ETL-Lösung mit leistungsstarken Datenkonvertierungsfunktionen von und zu nahezu beliebigen Formaten. Eine grafische, assistentengesteuerte Oberfläche soll sicherstellen, dass die Software einfach zu bedienen ist. Dazu gehört auch, dass Adeptia Selfservice-ETL-Funktionen bietet, um es Geschäfts-Anwendern zu ermöglichen, selbst einfache Geschäftsdaten-Integrationsverbindungen zu erzeugen. Entwickler können damit umfangreiche Datenintegrationsabläufe erstellen, die Datenvalidierung, Bereinigung, Routing, Ausnahmebehandlung und Back-End-Konnektivität umfassen.

Adeptia Integration Suite wird zentral verwaltet und gewartet, um eine reibungslose Leistung und Verfügbarkeit zu gewährleisten. Detaillierte Logs und Audit-Trails sind verfügbar, um die Einhaltung regulatorischer Anforderungen sicherzustellen. Die Einhaltung von Standards, eine serviceorientierte Architektur (SOA) und ein prozessbasierter Ansatz zum Erstellen flexibler und lose gekoppelter Datenflüsse lassen AIS für alle Aggregations- oder Data-Warehousing-Lösungen geeignet erscheinen. Ebenfalls vorhanden ist eine Middleware-Anwendung zur Dokumentation, Automatisierung und Ausführung kritischer Datenprozesse, insbesondere zum Erstellen und Bestücken von Data Warehouses aus verschiedenen internen oder externen Datenquellen.

AIS umfasst ein Designstudio und kombiniert Datentransport mit Metadaten-Management. Dadurch können Daten von mehreren Quellen in unterschiedlichen Formaten empfangen und einem gemeinsamen Datenbankschema zugeordnet werden. Für Unternehmen interessant ist auch die zentrale Verwaltung von Datenschema und Zuordnungsregeln in einem zentralen Speicherort mit der direkten Archivierung dieser Regeln in PDF-Dokumenten zum einfachen Abruf.

Eine kostenlose Version der Adeptia Integration Suite als B2B- und Datenintegrationslösung steht ebenfalls zur Verfügung. Sie erlaubt den automatisierten Datenaustausch mit bis zu zwei Partnern und eignet sich laut Anbieter ideal für Unternehmen, die sich mit großen Partnern verbinden müssen.

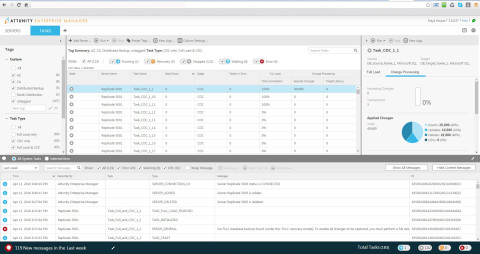

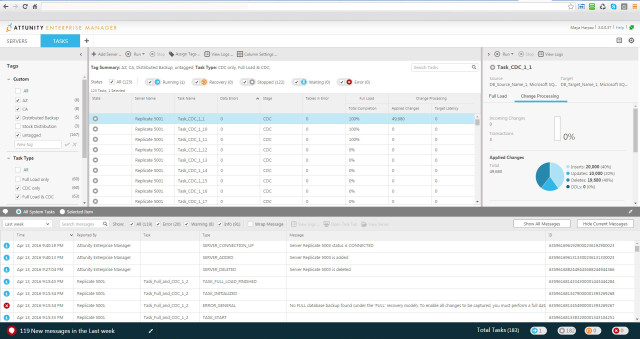

Attunity

Attunity tritt unter anderem als Advanced Technology Partner von Amazon AWS auf. Geboten werden Lösungen zur Beschleunigung von Datenreplikation, -speicherung und -streaming in einer Vielzahl von heterogenen Datenbanken, Data Warehouses und Datenplattformen. AWS selbst nutzt die Technologie von Attunity für die Datenintegration im AWS-Big-Data-Kompetenzprogramm und für die Datenmigration im AWS-Migration-Kompetenzprogramm.

Der Schwerpunkt von Attunity liegt in der Datenreplikation, wobei die Lösung durchaus erlaubt, der Replikation einfache Daten-Änderungsregeln hinzuzufügen. Attunity Replicate kann so eingerichtet werden, dass es alle zu replizierenden Quellentabellen übernimmt, oder es lassen sich einzelne Tabellen nach Namen oder Namensmustern auswählen. Wenn eine neue Tabelle an der Quelle angezeigt wird und ihr Name mit dem Replikationsmuster übereinstimmt, erstellt Attunity eine Tabelle in der Zieldatenbank und beginnt sofort, sie zu replizieren. Änderungen der Datenstruktur bewältigt Attunity dabei ohne Mühe.

Im nächsten Schritt erfasst Replicate neue Zeilen, Datenaktualisierungen und Löschungen. Diese Änderungen werden automatisch auf die Zieltabellen angewendet. Replicate bewältigt Änderungen an großen Datenmengen in beeindruckender Zeit und verarbeitet auch eine ganze Liste von Tabellen in einem Durchgang.

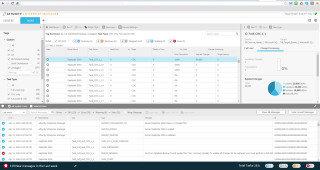

Replicate ist über eine ansprechende Browser-Schnittstelle zu bedienen. Das visuelle Interface hilft beim Einrichten der Replikationsaufgabe und vereinfacht auch die Replikationsüberwachung. Zu jeder Tabelle zeigt das Tool an, wann die letzte Datenaktualisierung stattgefunden hat und wie viele Ergänzungen, Aktualisierungen und Löschungen es seit dem letzten Taskstart gab. Eine kostenlose Testversion kann über die Website von Attunity angefordert werden

5. Teil: „Denodo“

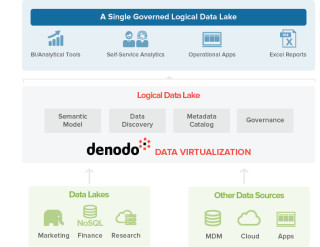

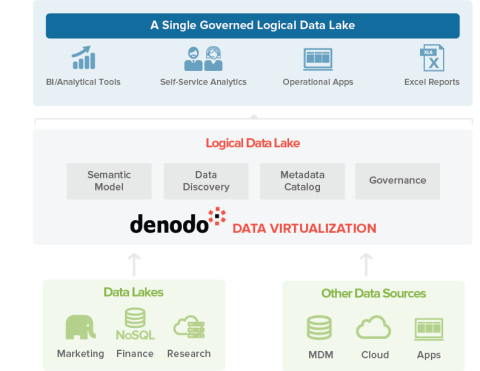

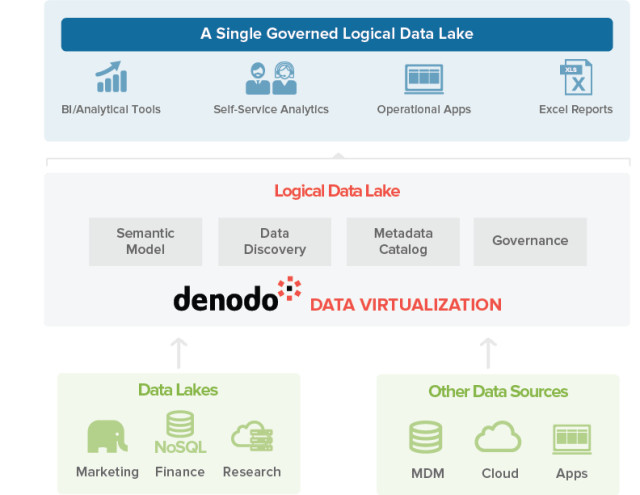

Denodo

Denodo setzt auf ein erweitertes relationales Datenmodell, ermöglicht die Optimierung von Abfragetechniken, unterstützt Sicherheitsprotokolle sowie Datenbereitstellung durch REST und bietet Selfservice-Datenservices.

Unterstützt werden On-Demand-Echtzeitzugriffe auf zahlreiche Quellen. Integrierte Datenservices nutzen intelligente Abfrageoptimierung in Echtzeit, Caching, In-Memory und hybride Strategien. Diese werden automatisch oder von Hand auf Basis von Einschränkungen seitens der Quelle, Anforderungen der Anwendung und Erkennung von Netzwerken ausgewählt. Die Datenservices sind horizontal und vertikal skalierbar.

Eine übersichtliche Bedienoberfläche soll Fachanwendern wie auch Entwicklern bequemen Zugriff gestatten. Mit der Denodo-Plattform lässt sich eine virtuelle Datenschicht erstellen, die vorhandene Datenquellen als Datendienste für alle Anwendungen im Unternehmen verfügbar macht, sowohl für betriebliche als auch für Informationszwecke.

Dieser serviceorientierte Ansatz für Daten bietet eine konsistente Sicht auf die zugrundeliegenden Datenquellen, Unterstützung für mehrere Zugriffsprotokolle sowie einen einheitlichen Kontrollpunkt für Sicherheit und Governance. Der Anwender ist so in der Lage, zu sehen, wer über den Datendienst auf die Daten zugegriffen hat, wann zugegriffen wurde und welche Abfragen ausgeführt wurden. Das ist besonders für Branchen, die mit privaten oder vertraulichen Daten arbeiten, ein wichtiges Feature. Die Denodo-Plattform stellt den Kontrollpunkt zum Erzwingen und Überwachen des Datenzugriffs über die exponierten Datendienste bereit.

Darüber hinaus verfügt die Plattform über eine Funktion für Linked Data Services, mit der Benutzer das virtuelle Datenmodell durchsuchen und abfragen können, um die benötigten Daten zu ermitteln. Die Denodo-Plattform bietet eine flexible API und stellt dynamische Datenservices bereit, um damit auf komplexe Datenquellen zuzugreifen. Jede primäre, abgeleitete, integrierte oder virtuelle Datenquelle kann damit in einem abgewandelten Format oder Protokoll zugänglich gemacht werden. Auch Änderungen an Quellen, Integration oder Output-Datenservices sind schnell vorzunehmen.

Denodo kommt als Enterprise-Lizenz zu einem Paketpreis, der jeden Konnektor und alle notwendigen Funktionen umfasst. Der Kunde bezahlt nur die CPU-Kapazität der verwendeten Hardware. Daneben sind mit Denodo Express die wichtigsten Funktionen der Plattform zur Datenvirtualisierung in einem einfach zu bedienenden Paket kostenlos verfügbar. Enthalten sind die grafische Bedienoberfläche, ein Workbench für Skripte sowie Konnektoren zu den meisten Datenquellen, ins Web sowie zu unstrukturierten Daten und semantischen Strukturen.

6. Teil: „Informatica und Talend“

Informatica und Talend

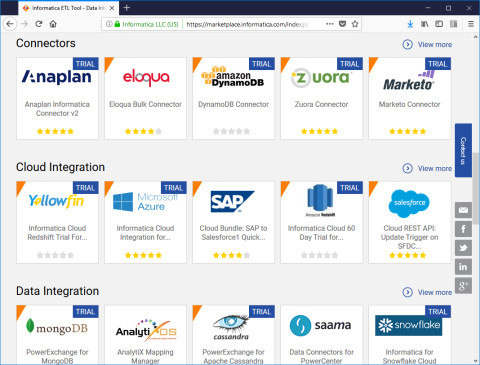

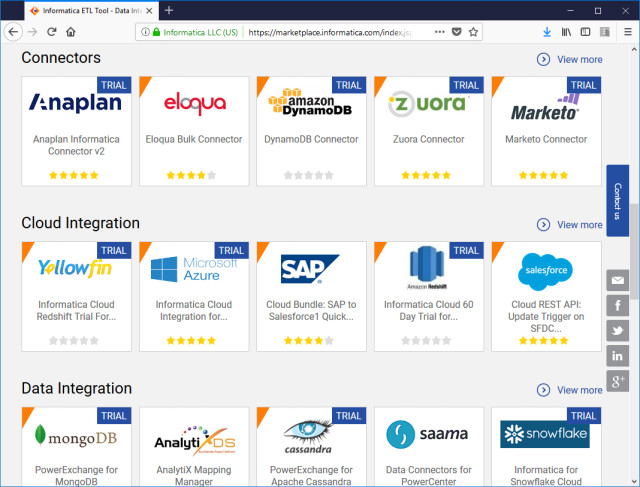

Informatica bietet Datenintegrations-Software für verschiedene Geschäftsbereiche an. Unterstützt werden unter anderem Data Warehousing, Datenmigration, Datenkonsolidierung, Datensynchronisation und Datensteuerung.

Die Data-Integration-Plattform besteht aus mehreren Einzelprodukten, die kombiniert werden können. Zentrales Element ist das sogenannte PowerCenter. Daran lassen sich weitere Produkte wie Konnektoren, ein Data Integration Hub oder Advanced Data Transformation anbinden. Mit Advanced Data Transformation als umfassender Unternehmenslösung lassen sich über eine Point-and-Click-Oberfläche beliebige Datentypen praktisch unabhängig von Format, Komplexität oder Größe umwandeln.

In Deutschland stellt T-Systems als Informatica-Partner die Software seit März 2015 als Service aus einem Cloud-Rechenzentrum in München bereit. T-Systems betreibt die Informatica-Software also in einem deutschen Rechenzentrum nach den strengen deutschen Datenschutzvorschriften. Gleichzeitig gewährleistet T-Systems nach eigenem Bekunden höchste IT-Sicherheit sowie maximale Verfügbarkeit bei der Bereitstellung und ist für Kundenberatung und -Support zuständig.

Über die Website von Informatica lässt sich eine kostenlose Testversion der Lösung anfordern.

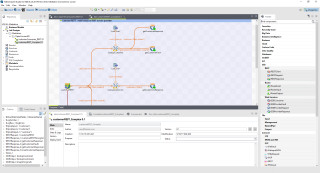

Talend

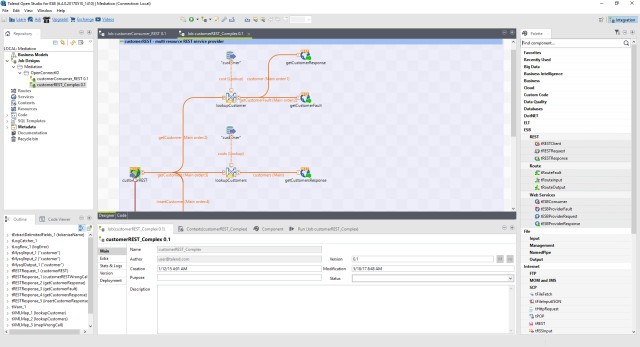

Talend bietet Big-Data-, Cloud-Storage-, Datenintegrations-, Datenmanagement-, Datenaufbereitungs- und Enterprise-Application-Integration-Software und -Dienstleistungen an. Das Unternehmen ist Sponsor der Apache Software Foundationund und Mitglied des Java Community Process. Vor diesem Hintergrund ist zu verstehen, dass Talend den Code seiner Kernmodule unter der Apache-Lizenz veröffentlicht. Nach dem sogenannten Open-Core-Geschäftsmodell ist der Code der Kernmodule als Open Source frei verfügbar, während Talend nur an Value Added Features und Services verdient, die unter einer kommerziellen Abonnementlizenz verkauft werden. Die kommerzielle Lizenz bietet Zugriff auf Mehrwertfunktionen wie Load Balancing oder Monitoring, technischen Support und Rechtsschutz.

Talend entwickelt Produkte und Services vorwiegend in Java. Eine leistungsstarke Enterprise-Datenintegrations-Software mit über 900 Konnektoren in einer offenen, skalierbaren Architektur soll es ermöglichen, schnell auf Geschäftsanforderungen zu reagieren. Dazu kommen einheitliche Tools, die Datenintegrationsaufträge schnell entwickeln und implementieren helfen. Eine vollwertige Datenmanagementplattform erlaubt teamübergreifendes Arbeiten.

Die Datenintegrations- und Datenqualitätsplattform unterstützt relationale Datenbanken, Flatfiles, Cloud-Apps und Plattformen. Für Datenaufbereitung und Data-Stewardship stehen einfache Selfservice-Tools zur Verfügung. Weitere Features sind eine Drag-and-Drop-Oberfläche, native Code-Generierung und eine umfassende Bibliothek von Konnektoren. Dazu bietet Talend eine breite Palette an robusten Open-Source-Integrations-Tools zum Download. Kostenlos sind diverse Open-Source-Lösungen wie Open Studio for Data Integration, Open Studio for Big Data und Open Studio for ESB. Vom kommerziellen Produkt ist eine kostenlose Testversion verfügbar.

Test-Framework

Testautomatisierung mit C# und Atata

Atata ist ein umfassendes C#-Framework für die Web-Testautomatisierung, das auf Selenium WebDriver basiert. Es verwendet das Fluent Page Object Pattern und verfügt über ein einzigartiges Protokollierungssystem sowie Trigger-Funktionalitäten.

>>

Programmiersprache

Primärkonstruktoren in C# erleichtern den Code-Refactoring-Prozess

Zusammenfassen, was zusammen gehört: Dabei helfen die in C# 12 neu eingeführten Primärkonstruktoren, indem sie Code kürzer und klarer machen.

>>

Huawei Roadshow 2024

Technologie auf Rädern - der Show-Truck von Huawei ist unterwegs

Die Huawei Europe Enterprise Roadshow läuft dieses Jahr unter dem Thema "Digital & Green: Accelerate Industrial Intelligence". Im Show-Truck zeigt das Unternehmen neueste Produkte und Lösungen. Ziel ist es, Kunden und Partner zusammenzubringen.

>>

Nach der Unify-Übernahme

Mitels kombinierte Portfoliostrategie

Der UCC-Spezialist Mitel bereinigt nach der Unify-Übernahme sein Portfolio – und möchte sich auf die Bereiche Hybrid Cloud-Anwendungen, Integrationsmöglichkeiten in vertikalen Branchen sowie auf den DECT-Bereich konzentrieren.

>>