08.03.2022

AI as a Service

1. Teil: „Künstliche Intelligenz aus der Cloud“

Künstliche Intelligenz aus der Cloud

Autor: Bernd Reder

Shutterstock / whiteMocca

Mit Artificial Intelligence as a Service lassen sich KI-Projekte schneller umsetzen.

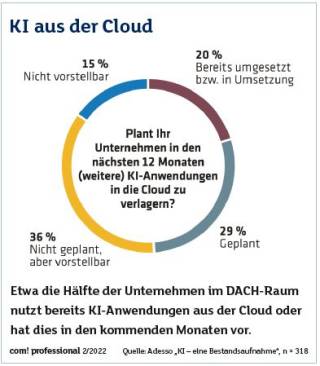

Für die meisten Unternehmen ist klar, dass an Künstlicher Intelligenz (KI) und maschinellem Lernen (ML) kein Weg vorbeiführt. „Noch vor drei bis vier Jahren befanden wir uns in der Phase des ‚Kennenlernens‘. Heute sagen über 80 Prozent der Verantwortlichen, dass der Einsatz von KI mittelfristig zu Wettbewerbsvorteilen führt“, erklärt Benedikt Bonnmann, Leiter Line of Business Data & Analytics bei Adesso. Diese Daten stammen aus der Studie „KI – eine Bestandsaufnahme“ des IT-Dienstleisters. Für Bonnmann ist KI kein „Hype-Thema“, das in ein paar Jahren wieder verschwindet: „Künstliche Intelligenz ist eines der Felder, auf dem sich die Zukunftsfähigkeit von Unternehmen und des gesamten Standorts Deutschland entscheidet“, ergänzt er.

Google, das über seine Google Cloud Platform eine große Palette von KI-Services vermarktet, sieht das ähnlich: „Wir verstehen Künstliche Intelligenz vor allem als transformatorische Kraft im Unternehmen, die alles und jeden verändern kann. Damit ist KI nicht länger ein Teil der IT-Strategie, sondern der Unternehmensstrategie“, betont Stefan Ebener, Head of Customer Engineering für Google Cloud.

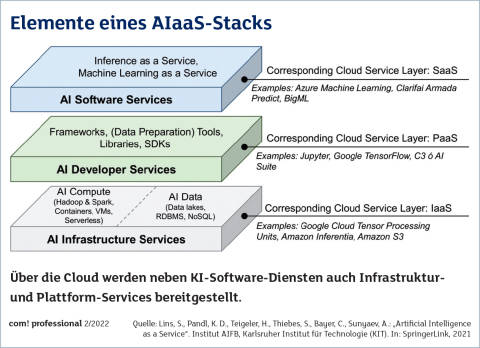

Doch wie können Unternehmen und öffentliche Einrichtungen mit akzeptablem Aufwand Use-Cases und Anwendungen im Bereich KI entwickeln? Laut Cloud-Service-Providern, Beratungshäusern und IT-Dienstleistern sind KI-Services aus der Cloud (Artificial Intelligence as a Service, AIaaS) eine tragfähige Option, um dieses Ziel zu erreichen. Das Bereitstellungsmodell ist dasselbe wie bei Office-Paketen, IT-Sicherheitslösungen und Geschäfts-Software: Die KI- und Machine-Learning-Lösungen inklusive der erforderlichen Server, Storage-Komponenten und Netzwerksysteme stehen über eine Public Cloud zur Verfügung.

Nutzer können solche Services bei einem großen Cloud-Provider (Hyperscaler) buchen, also bei Amazon Web Services (AWS), Google (Google Cloud Platform) und Microsoft (Azure). Doch auch IT-Dienstleister und Provider wie IBM, Capgemini, Adesso, OVHcloud und Lufthansa Industry Solutions stellen AIaaS zur Verfügung. Teils greifen sie dabei auf die Plattformen der Hyperscaler zurück.

2. Teil: „Die Vorteile von AI as a Service“

Die Vorteile von AI as a Service

Solche KI-Angebote aus der Cloud stoßen in Deutschland auf reges Interesse, erläutert Julian Staub, Technology Consultant bei Lufthansa Industry Solutions (LHIND): „Die Bereitschaft zum AIaaS-Einsatz ist hoch. Das gilt vor allem für kleinere Unternehmen und Behörden, die meist wenig Expertise im Bereich KI haben.“ Solche Nutzer erhalten Staub zufolge ein Lösungspaket, das sie bei KI und maschinellem Lernen (ML) technisch gesehen in „die gleiche Liga“ aufsteigen lässt wie größere Unternehmen.

Im Detail schätzen deutsche Unternehmen den geringeren Zeitaufwand, den das Umsetzen von KI-Projekten mithilfe der Cloud erfordert, so Rüdiger Eberlein, Chief Technology Officer Insights & Data beim IT- und Beratungshaus Capgemini. Dazu tragen vorgefertigte Funktionsbausteine für KI-Lösungen bei, die sich in einer Cloud sofort nutzen lassen. „Vorteilhaft ist außerdem die einfache Skalierbarkeit bei ressourcenintensiven Aufgaben wie dem Training von Machine-Learning-Modellen“, weiß Eberlein.

Wichtig sei bei AIaaS zudem das Unterstützen agiler Arbeitsweisen. So lassen sich mit AIaaS Ideen ohne große Investitionen und lange Einkaufsprozesse validieren. „Im Fall eines positiven Ergebnisses lässt sich die KI-Lösung rasch erweitern, Stichwort Skalierbarkeit. Bleiben dagegen die Erfolge aus, kann ein Unternehmen den Versuch abbrechen, ohne dass weitere Kosten anfallen“, so Eberlein.

3. Teil: „Für Fachabteilungen und Entwickler“

Für Fachabteilungen und Entwickler

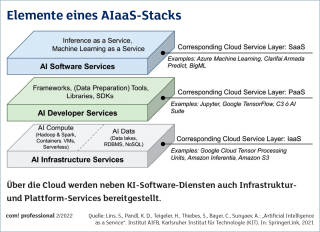

Bei KI als Cloud-Service sind mehrere Ansätze zu unterscheiden, von Programmierschnittstellen (APIs) für Cognitive Computing über schlüsselfertige KI- und Machine-Learning-Anwendungen bis hin zu Entwicklungs-Tools, Frameworks und Managed Services (siehe Kasten „Vier Typen von AIaaS“). „Bei User-zentrierten AI-Lösungen nutzt der Anwender fertige Tools und Assets, um ein Geschäftsproblem zu lösen“, sagt Marlene Heinrichs, Manager MVP Team (Minimum Viable Product, d. Red.) von IBM Deutschland, Österreich und Schweiz. Ein Vorteil ist, dass auch technisch weniger versierte Business-User solche Werkzeuge bedienen und an ihre Anforderungen anpassen können. Dazu tragen Ansätze wie Low-Code und No-Code bei.

Solche vortrainierten und sofort einsatzbereiten AIaaS-Produkte „aus der Steckdose“ stellen beispielsweise Anbieter wie AWS, Google und Microsoft, aber auch IBM und andere Service-Provider über ihre Cloud-Plattformen bereit. „Es handelt sich in unserem Fall um ein Portfolio von Microservices, die als Baukasten zur Verfügung stehen“, so Heinrichs. Solche Services kann ein Nutzer beispielsweise mit eigenen Apps kombinieren und diese um KI-Funktionen erweitern. Entwickler, Data Scientists und Analysten können zusätzlich auf spezielle AIaaS-Angebote zugreifen, die für technisch anspruchsvollere Projekte ausgelegt sind. Sie erlauben es, KI-Modelle zu erstellen, zu testen und zu verwalten. Zu dieser Kategorie zählt etwa das Tool-Set Watson Studio von IBM.

4. Teil: „Hyperscaler oder IT-Dienstleister?“

Hyperscaler oder IT-Dienstleister?

Cloud-Hyperscaler und IT-Dienstleister stellen Nutzern neben einem umfassenden Portfolio von KI-Anwendungen auch die erforderlichen Server-, Storage- und Netzwerkressourcen via Cloud zur Verfügung. „Wir bieten einfach ein starkes Gesamtpaket“, unterstreicht beispielsweise Stefan Ebener von Google. „Anwendungen wie Google Maps, Assistant, Voice und Chrome OS sind Cloud-Applikationen. Daher können wir sagen, dass wir bereits seit mehr als 20 Jahren sicher und verlässlich mit der Cloud arbeiten.“ Dies komme auch den Nutzern von KI, Machine Learning und Deep Learning zugute.

Doch naturgemäß sehen IT-Dienstleister, die ihren Kunden mit AIaaS einen Mehrwert bieten möchten, die Angebote von großen Cloud-Service-Providern kritisch: „Hyperscaler setzen bei KI vor allem auf eine technische Lösung, also die Tools, mit denen Anwender mit der Nutzung von Künstlicher Intelligenz starten können. Einen echten Service bieten sie jedoch nicht“, erklärt Julian Staub von LHIND. Den stelle dagegen ein IT-Dienstleister wie Lufthansa Industry Solutions in Form von KI-Service-Paketen bereit. „Ein Bestandteil eines solchen Pakets ist, dass Kunden die Möglichkeit haben, KI-Services zu individualisieren und an konkrete Aufgabenstellungen anzupassen.“

Auch der europäische Service-Provider OVHcloud mit Hauptsitz in Frankreich setzt auf ergänzende Angebote: „Wir bieten eine Alternative auf Basis von Open-Source-Technologien und eines KI-Ökosystems“, erläutert Falk Weinreich, General Manager Central Europe des Providers. Zielgruppe sind Unternehmen und öffentliche Auftraggeber, die über die Cloud effizientere Wege suchen, um KI-Modelle zu entwickeln und zu trainieren, und gleichzeitig auf die Daten-Governance und Compliance Wert legen. Ihnen gibt OVHcloud über die eigene Cloud KI-Lösungen an die Hand. Hinzu kommen Platform-as-a-Service-Tools (PaaS), die ein Anwender für den Aufbau und das Hosting von KI-Projekten benötigt. „ML Serving ist beispielsweise darauf ausgerichtet, KI-Modelle in Betrieb zu nehmen. AI Training stellt wiederum Computing-Ressourcen mit CPU- und Grafikprozessoren für Test- und Pre-Production-Phasen bereit“, berichtet Weinreich.

Hochleistungs-Hardware für AIaaS

Nutzer können somit aus der Cloud nicht nur KI- und ML-Frameworks und vorgefertigte Modelle beziehen, sondern auch die Infrastruktur. Auch dabei ist es wichtig, dass ein Anwender mehrere Optionen hat, so Intel: „Aus etlichen Beispielen haben wir gelernt, dass es keine universelle Lösung für eine KI-Infrastruktur gibt. Vielmehr kommen die Nutzung vorhandener Hardware, der Aufbau einer Plattform, die KI unterstützt, sowie das Outsourcing in die Cloud in Betracht“, sagt Stephan Gillich, Direktor Künstliche Intelligenz GTM für den Raum EMEA bei der Datacenter Group von Intel. „Eventuell ist auch eine Hybrid-Lösung aus lokaler Hardware unter Einbeziehung der Cloud für bestimmte Workloads der richtige Weg.“ Deshalb hat Intel mit Habana Gaudi ein System für das Training von Deep-Learning-Algorithmen entwickelt. Es steht sowohl als Service über die AWS-Cloud als auch in Form einer On-Premise-Lösung zur Verfügung. Auch KI-/ML-Lösungen von Nvidia sind über Cloud-Portale zugänglich. Dazu gehören Grafikprozessoren (GPUs) wie A100, V100 und T4, darauf basierende Hochleistungsrechner (DGX-Systeme) sowie Software-Kataloge und KI-/ML-Frameworks wie Modulus für das Training von KI- und Deep-Learning-Modellen. Einen ähnlichen Ansatz dürfte AMD wählen, das im November 2021 mit Instinct MI eine GPU-Linie für High-Performance-Computing, KI und Machine Learning präsentierte.

5. Teil: „Wir empfehlen beim Einsatz von KI grundsätzlich hybride Modelle“

Wir empfehlen beim Einsatz von KI grundsätzlich hybride Modelle

Über seine Plattform Azure stellt Microsoft eine große Zahl von KI- und Machine-Learning-Services zur Verfügung. Dennoch plädiert Alexander Britz, Head of Digital Business Transformation & Artificial Intelligence bei Microsoft Deutschland, beim Einsatz von KI und ML für ein Hybrid-Cloud-Modell – und das nicht nur als Gründen des Datenschutzes.

com! professional: Herr Britz, wie hoch ist derzeit die Bereitschaft von Unternehmen in Deutschland, Künstliche Intelligenz und Machine Learning einzusetzen?

Alexander Britz: Zwischen der Erkenntnis, dass KI eine Schlüsseltechnologie ist, und der konkreten Umsetzung von KI-Projekten gibt es in Deutschland noch eine deutliche Diskrepanz. Je kleiner ein Unternehmen, desto größer ist oft diese Lücke. Hier gibt es also noch viel Potenzial. Ein Hemmnis für die Einführung von KI in mittelständischen Unternehmen ist der Mangel an Fachkräften und damit einhergehend das fehlende Know-how. Hier können Unternehmen aktiv gegensteuern, etwa durch Qualifizierungsangebote für die Mitarbeiter.

com! professional: In welchen Bereichen können Unternehmen und öffentliche Einrichtungen in erster Linie von KI profitieren?

Britz: KI ist nicht eine einzige Technologie, sondern ein Sammelbegriff für verschiedene Ansätze. Künstliche Intelligenz spielt mittlerweile in nahezu allen Bereichen unseres Lebens eine wichtige Rolle. Im Wesentlichen reden wir über drei Anwendungsfelder: erstens die Analyse und Interpretation von Daten in Form von Zahlen, Text, Sprache, Bildern und Videos, zweitens maschinelles Lernen aus Daten. Hinzu kommt als dritter Bereich die menschliche Interaktion, etwa über Sprachassistenten, Chat-Bots und Natural Language Processing.

com! professional: Wie bewertet Microsoft die Bereitschaft seitens Unternehmen und Behörden, KI aus der Cloud (AI as a Service) einzusetzen?

Britz: Entscheidend ist, welche Daten in der Cloud auf welche Weise verarbeitet werden. Wir haben zum Beispiel mit dem Land Nordrhein-Westfalen und der Zentral- und Ansprechstelle Cybercrime NRW bei den Ermittlungen wegen sexualisierter Gewalt gegen Kinder und Jugendliche eine Möglichkeit geschaffen, Daten lokal in den Rechenzentren der Strafverfolgungsbehörden zu abstrahieren und zu anonymisieren. Dieses Material kann sowohl lokal (On-Premise) als auch in den deutschen Rechenzentren der Microsoft Cloud mit einer KI-gestützten Analyse ausgewertet werden. Wir betrachten also nicht allein die Plattform, sondern gehen auch vom Use-Case aus.

com! professional: Bedeutet dies, dass für viele Anwender ein hybrides Modell die beste Lösung ist, bei dem KI-Anwendungen sowohl über eine Public Cloud als auch das eigene Rechenzentrum bereitgestellt werden?

Britz: Wir empfehlen grundsätzlich hybride Modelle. Bei ihnen erfolgt beispielsweise das Training der Algorithmen in der Cloud. Die Datenerhebung und -auswertung kann wiederum im eigenen Rechenzen-

trum oder am Rand der IT-Infrastruktur erfolgen, also dem Edge. Dort kommt es weniger auf die Konnektivität als auf geringe Latenzzeiten an. Daher sind dort lokale KI-Instanzen erforderlich. Die am Edge erhobenen Daten lassen sich anschließend wieder in die Cloud hochladen, um die KI-Modelle zu trainieren und die Intelligenz am Edge weiter zu optimieren.

trum oder am Rand der IT-Infrastruktur erfolgen, also dem Edge. Dort kommt es weniger auf die Konnektivität als auf geringe Latenzzeiten an. Daher sind dort lokale KI-Instanzen erforderlich. Die am Edge erhobenen Daten lassen sich anschließend wieder in die Cloud hochladen, um die KI-Modelle zu trainieren und die Intelligenz am Edge weiter zu optimieren.

com! professional: Und wie lässt sich ein hybrides Modell in der Praxis umsetzen?

Britz: Das ist beispielsweise mit einer Lösung wie Azure Stack möglich. Sie ermöglicht KI-Echtzeitanalysen in jeder lokalen Infrastruktur und stellt dadurch eine „Edge Intelligence“ bereit. In Verbindung mit einer hybriden Cloud-Plattform wie Azure Stack Hub funktioniert das sogar ohne Internetverbindung.

com! professional: Was müssen Anwender tun, damit cloudbasierte oder hybride KI-Services den gewünschten Nutzen bringen?

Britz: Wichtig sind konsistente, gut gepflegte und vollständige Daten. Denn ein Algorithmus kann nur so gut analysieren, wie es die Daten erlauben. Auch eine Datenkultur ist wichtig: Daten- und Wissenssilos im Unternehmen sind kontraproduktiv. Für produktive KI braucht ein Unternehmen zudem die Bereitschaft der Mitarbeiter, Daten und Wissen zu teilen. Und es ist die „richtige“ Lösung erforderlich: AIaaS bietet für jeden Anwendungsfall Services, die sich in bestehende Infrastrukturen integrieren lassen. Das Anpassen an Strukturen und Bedürfnisse sowie das Entwickeln und Testen von Minimum Viable Prototypes (MVP) ist daher eine der wichtigsten Aufgaben bei KI-Projekten. Hier sollten Unternehmen nicht sparen.

6. Teil: „Daten und Einsatz in der Praxis“

Daten und Einsatz in der Praxis

Doch unabhängig davon, ob ein Anwender KI und ML aus einer Cloud bezieht oder in Eigenregie entsprechende Ressourcen aufbauen will, muss er zuvor „Hausaufgaben“ erledigen. Dazu gehört nach Einschätzung von Marlene Heinrichs von IBM die wachsende Komplexität der Datenbestände. „Heute sind Unternehmen gezwungen, Daten an einem einzigen Ort zu konsolidieren. Dies kann kostspielig sein, zu Qualitätsproblemen führen und Bedenken bezüglich des Datenschutzes und der Daten-Governance aufwerfen.“ Die Lösung ist aus Sicht von IBM eine Data Fabric. Mit einer Data Fabric können Anwender Daten unabhängig davon nutzen, wo diese gespeichert sind.

Rüdiger Eberlein von Capgemini sieht im Operationalisieren von erstellten Machine-Learning-Modellen eine der größten Herausforderungen. „Diese Modelle müssen in die IT-Anwendungslandschaft integriert werden, damit sie im Geschäftsbetrieb eingesetzt werden können.“ Dabei helfen Konzepte wie DataOps (Data Operations) und MLOps (Machine Learning Operations). „Solche Ansätze werden jedoch von KI-Diensten in der Cloud besser unterstützt als von solchen, die On-Premise bereitgestellt werden“, gibt Eberlein zu bedenken.

7. Teil: „Datenschutz und Vendor-Lock-in“

Datenschutz und Vendor-Lock-in

Nach wie vor wichtig, aber nicht mehr so dominant wie noch vor zwei bis drei Jahren ist die Frage, ob Cloud-Angebote wie AIaaS den Datenschutz- und Compliance-Vorgaben entsprechen, die in der EU gelten. „Anbieter haben auf Bedenken in Bezug auf die Datensicherheit und den Datenschutz mit tragfähigen Lösungen reagiert“, führt Benedikt Bonnmann von Adesso an. „Außerdem tragen Zertifizierungen durch unabhängige Einrichtungen und Behörden dazu bei, dass das Vertrauen in die Cloud wächst.“

Anwender, die auf Nummer sicher gehen möchten, haben zudem die Möglichkeit, KI und Machine-Learning im Rahmen einer Hybrid-Cloud zu betreiben. Und um bei AIaaS einen Vendor-Lock-in zu vermeiden, bietet sich der Multi-Cloud-Ansatz an: „Das Problem lässt sich lösen, indem man Cloud-Dienste von Drittanbietern nutzt, die auf den Cloud-Infrastrukturen der drei ‚Großen‘ gleichermaßen laufen, also AWS, Microsoft und Google“, betont Rüdiger Eberlein von Capgemini. „Die Angst vor einer Abhängigkeit von einem Cloud-Anbieter wird daher überbewertet.“

8. Teil: „Fazit & Ausblick“

Fazit & Ausblick

Zweifellos beseitigen Ansätze wie KI aus der Cloud einen Teil der (Einstiegs-)Hürden, die mit dem Einsatz von KI- und Machine-Learning-Lösungen verbunden sind, etwa in Bezug auf die Investitionskosten und die Bereitstellung. Doch eine Garantie, dass solche Projekte erfolgreich verlaufen, ist das nicht. Vielmehr müssen Anwender an mehreren Stellen ansetzen, etwa der Qualität und Verfügbarkeit von Daten, den Entwicklungsressourcen und dem Fachwissen ihrer Mitarbeiter. Hinzu kommt, dass tragfähige Use-Cases erforderlich sind.

Kurzum, es ist viel zu tun, damit KI und Machine Learning zu einer Erfolgsgeschichte werden. Daher empfiehlt es sich für Unternehmen und öffentliche Auftraggeber, Unterstützung von außen zu holen und parallel dazu den eigenen Mitarbeitern die Chance zu geben, Fachwissen zu erwerben. Wer an diesen Stellen spart, riskiert viel: dass KI-Projekte scheitern und mittelfristig die Wettbewerbsfähigkeit leidet.

Forschung

KI macht Gebärdensprache zugänglicher

Ein KI-Tool der Universität Leiden für "Wörterbücher" erkennt Positionen und Bewegungen der Hände bei der Darstellung unterschiedlicher Gebärdensprachen.

>>

Umweltschutz

Netcloud erhält ISO 14001 Zertifizierung für Umweltmanagement

Das Schweizer ICT-Unternehmen Netcloud hat sich erstmalig im Rahmen eines Audits nach ISO 14001 zertifizieren lassen. Die ISO-Zertifizierung erkennt an wenn Unternehmen sich nachhaltigen Geschäftspraktiken verpflichten.

>>

Cyberbedrohungen überall

IT-Sicherheit unter der Lupe

Cybersecurity ist essentiell in der IT-Planung, doch Prioritätenkonflikte und die Vielfalt der Aufgaben limitieren oft die Umsetzung. Das größte Sicherheitsrisiko bleibt der Mensch.

>>

Galaxy AI

Samsung bringt KI auf weitere Smartphones und Tablets

Einige weitere, ältere Smartphone- und Tablet-Modelle von Samsung können mit einem Systemupdate jetzt die KI-Funktionen von Galaxy AI nutzen.

>>