04.10.2019

Kontrolle statt Vertrauen

1. Teil: „Wie Zero Trust für mehr Sicherheit sorgt“

Wie Zero Trust für mehr Sicherheit sorgt

Autor: Thomas Hafen

deepadesign / shutterstock.com

Mit dem Fortschreiten der Digitalisierung wird auch die Angriffsfläche für Kriminelle stetig größer. Neue Berechtigungskonzepte bieten mehr Schutz als Perimeter und VPN und helfen bei der Abwehr.

Die klassische Verteidigungslinie der IT-Sicherheit ist der Perimeter, die Grenze des Sichtfelds. „Traditionelle Sicherheitsmodelle kann man sich vorstellen wie eine mittelalterliche Burg“, sagt Sam Srinivas, Product Management Director Google Cloud bei Google. „Alles, was sich außerhalb der Mauer befindet, gilt als gefährlich, alles, was sich innerhalb der Festung befindet, ist vertrauenswürdig.“

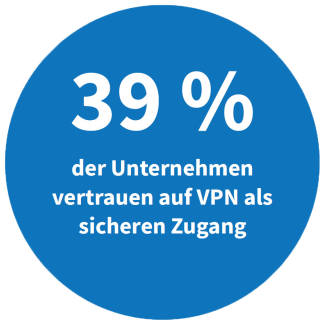

Wie bei einer Burg mit Zugbrücke und Torwächter ist der Zugang streng bewacht. Firewalls, Intrusion-Detection-and-Prevention-Systeme (IDS/IPS), Virenscanner und andere Schutzmaßnahmen untersuchen den IP-Verkehr ins Firmennetz, während starke Authentifizierung und VPN-Tunnel die Zugänge der Mitarbeiter absichern.

Für den netzinternen Verkehr sind die Sicherheitsvorkehrungen jedoch wesentlich schwächer, wenn überhaupt vorhanden. „Wird einem User durch ein Remote-Access-VPN-System Zugriff auf das Unternehmensnetz gewährt, kann er dort oftmals auf alle Daten und Anwendungen zugreifen“, erklärt Mathias Widler, Regional Vice President & General Manager, Central EMEA beim Sicherheitsspezialisten Zscaler. „Ein solch grenzenloses Vertrauen kann das Sicherheitssystem unterlaufen.“

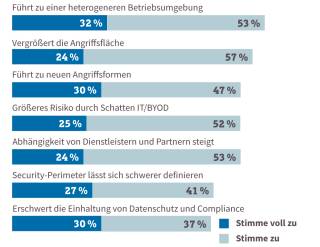

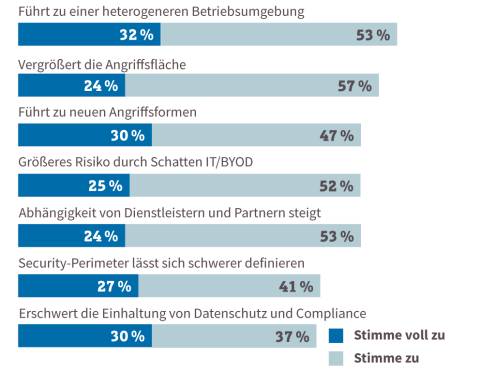

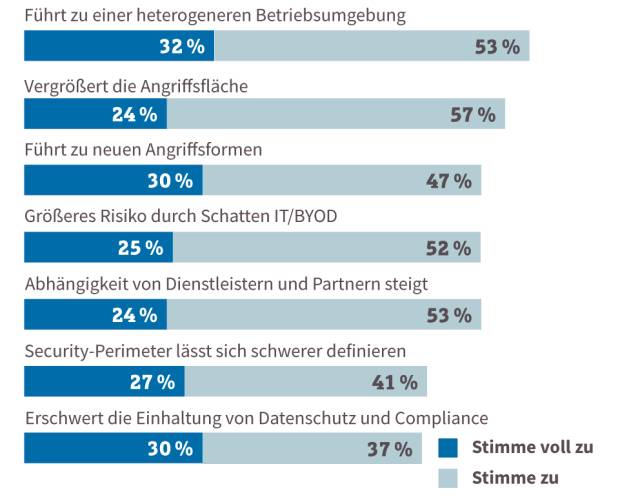

Die schwache Absicherung der netzinternen Kommunikation stellt Unternehmen jedoch zunehmend vor Probleme, denn die Schutzwälle des traditionellen Perimeters werden durch Virtualisierung, Cloud-Computing und mobiles Arbeiten immer löchriger, die Angriffsfläche größer.

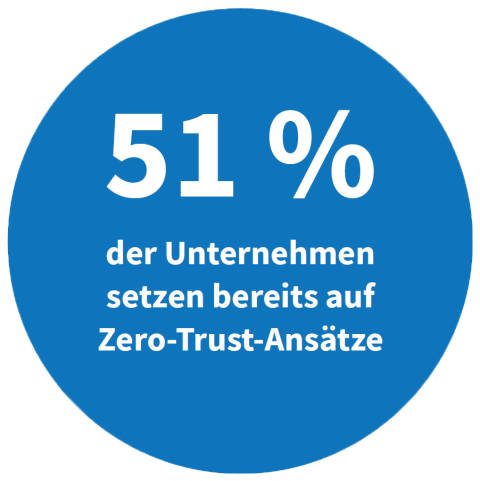

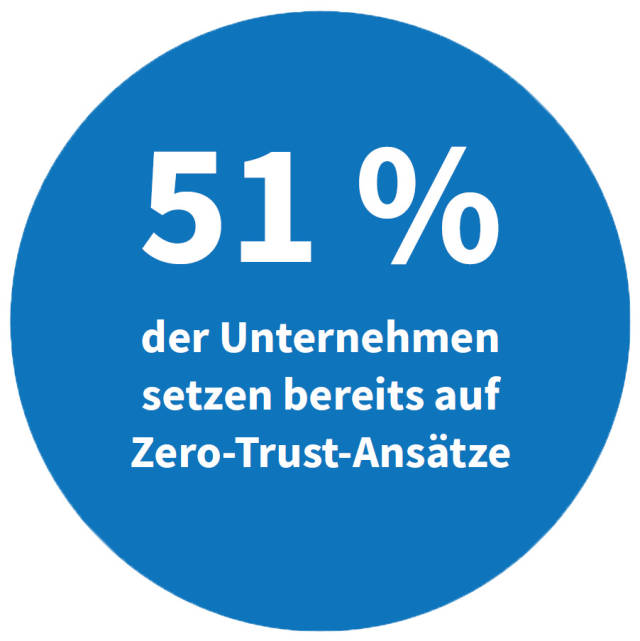

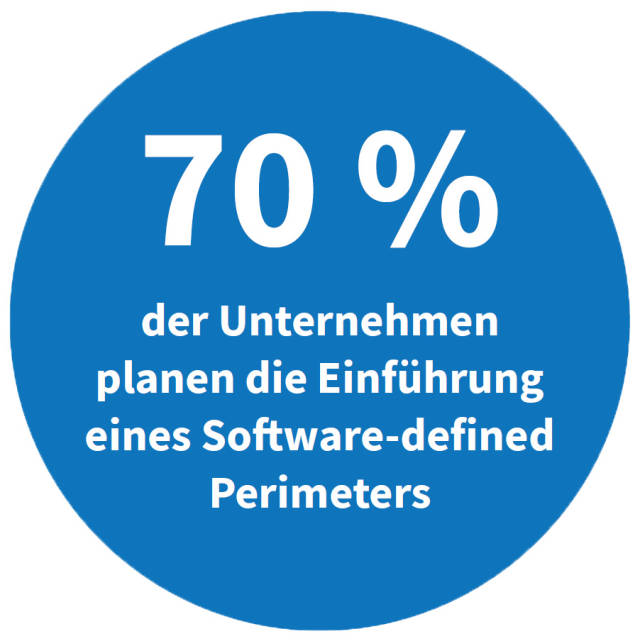

„Anwendungen, Nutzer und Geräte befinden sich heutzutage außerhalb des herkömmlichen Kontrollbereichs von Unternehmen“, erklärt Gerhard Giese, Manager des Enterprise-Security-Teams bei Akamai, „Folglich müssen Unternehmen die Sicherheit ihrer Netzwerke anpassen, um Schutz zu gewährleisten.“ Das spricht sich auch langsam bei den Betroffenen herum: 58 Prozent der von Forrester Consulting im Auftrag des Sicherheitsspezialisten Unisys befragten IT-Verantwortlichen halten den Perimeter in seiner traditionellen Form für nicht mehr zu verteidigen.

Vertraue niemandem

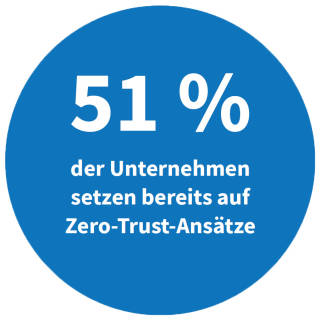

Um dieses Problem adressieren zu können, hat das Beratungsunternehmen Forrester den „Zero Trust“-Ansatz entwickelt. „Die Grundidee von Zero Trust besteht darin, dass ein User keinen Zugriff auf seine gewünschte Anwendung erhält, bevor er nicht in einem ersten Schritt für den Zugang autorisiert ist“, erklärt Mathias Widler von Zscaler. „Damit wird das traditionelle Zugriffskonzept auf den Kopf gestellt, bei dem erst die Verbindung ins Netzwerk erfolgt und im Anschluss die Autorisierung.“

Zero Trust unterscheidet nicht mehr zwischen sicheren und unsicheren Geräten, vertrauenswürdigen und verdächtigen Nutzern, externen und internen Netzen. Stattdessen wird jeder Zugriff analysiert, bevor er zugelassen wird. „Das Modell sieht eine verstärkte Überprüfung von Benutzern, Geräten und Sicherheitsstatus unmittelbar an den abgerufenen Ressourcen vor, kombiniert mit einem zentralen granularen Policy-Management“, ergänzt Scott Gordon CISSP (Certified Information Systems Security Professional) und Chief Marketing Officer bei Pulse Secure.

Eine Weiterentwicklung des Zero-Trust-Ansatzes ist das CARTA-Modell (Continuous Adaptive Risk and Trust Assessment) von Gartner. Risiken und Vertrauensstatus sollten, so die Idee dahinter, nicht nur beim initialen Zugriff, sondern kontinuierlich während der gesamten Interaktion analysiert und die Bewertung gegebenenfalls angepasst werden. „Entscheidend ist, dass Vertrauen in den Anwender oder sein Gerät nicht von vornherein vorausgesetzt wird, sondern erst durch den Kontext hergestellt und dann im Sinn eines Risiko-Assessments fortlaufend kontrolliert wird“, verdeutlicht Zscaler-Manager Widler das Prinzip.

Einige Experten sehen den Zero-Trust-Ansatz allerdings auch kritisch: Die Implementierung führe oft zu Produktivitätsverlusten oder zu einer geringeren Effektivität im Kundenmanagement, schreibt etwa NTT Security im „Global Threat Report 2019“. „Es ist nicht ungewöhnlich, dass verschärfte Zugangsvoraussetzungen und zusätzliche Auflagen zu Verzögerungen bei der Anmeldung oder gar zur Zugriffsverweigerung führen“, gibt auch Scott Gordon von Pulse Secure zu bedenken.

2. Teil: „Drei Wege zu Zero Trust“

Drei Wege zu Zero Trust

Für die Implementierung eines Zero-Trust-Modells gibt es im Wesentlichen drei Ansätze, die sich nicht ausschließen, sondern durchaus gegenseitig ergänzen können.

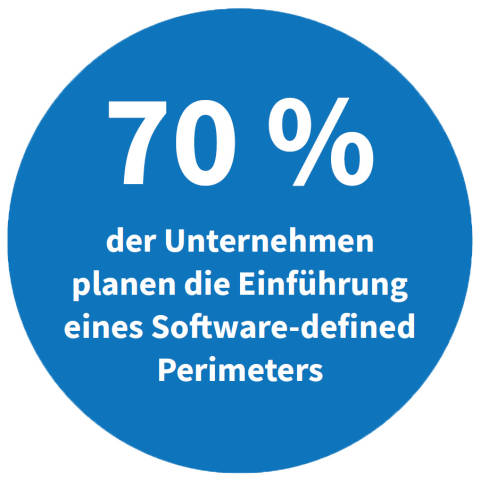

Software-defined Perimeter (SDP): Analog zu anderen Konzepten wie Software-defined Networking oder Software-defined Datacenter, zeichnet sich der „Software-defined Perimeter“ (SDP) durch eine Trennung von Daten- und Kontrollebene aus. Zentraler Bestandteil einer SDP-Architektur ist das Steuerungssystem, etwa ein SDP-Gateway, das den Datenaustausch zwischen Clients und Servern verwaltet. Neben der Authentifizierung kann der SDP-Controller auch orts-, zeit- und gerätespezifische Parameter für die Zugangsentscheidung heranziehen. So kann etwa ein Zugriff verweigert werden, wenn auf dem Client der Virenscanner nicht aktualisiert wurde, die Anfrage aus einem Land kommt, in dem sich der Anwender unmöglich aufhalten kann, oder definierte Bürozeiten nicht eingehalten werden.

Eine SDP-Implementierung erfordert neben den Gateways und Controller-Appliances in der Regel die Installation von Client-Software auf jedem Gerät. Jeder Standort, an dem sich Anwendungen befinden, muss über ein Gateway angeschlossen werden, was Bereitstellung, Verwaltung und Wartung in großen verteilten Umgebungen schwierig macht.

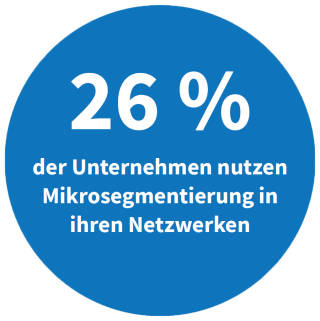

Mikrosegmentierung: Eine andere Möglichkeit, die Angriffsfläche und die Schäden durch bereits eingedrungene Malware zu begrenzen, ist die Mikrosegmentierung des Netzwerks. Hierbei wird das interne Netz in kleine logische Bereiche aufgeteilt, auf die nur ganz bestimmte Nutzer und Endgeräte Zugriff erhalten. So lassen sich Finanzbuchhaltung, Produktion oder das Personalmanagement abkapseln und

gegen nicht autorisierte Zugriffe schützen. Damit die Mikrosegmentierung effektiv funktioniert, ist es wichtig, die Sicherheitszonen so klein wie möglich zu halten und nur gerade so viele Berechtigungen zu vergeben, dass die Funktionalität nicht darunter leidet. Eine effiziente und sinnvolle Einteilung des Netzwerks stellt daher eine nicht zu unterschätzende Herausforderung dar. Sie muss zudem ständig angepasst und überprüft werden. Die Gefahr ist groß, dass unter Zeitdruck Zugriffsrechte über Segmentgrenzen hinweg vergeben werden, was das Sicherheitsniveau senkt.

Cloudbasierte Zugriffsmodelle (Proxies): Eine weitere Implementierungsform von Zero Trust sind cloudbasierte Proxies, die auf der Basis von Identität („Identity-aware“) und Kontext („Context-aware“) zentral die Autorisierung steuern. Ähnlich wie bei Software-defined Perimeter gewähren sie nur die absolut notwendigen Rechte. Der Zugriff erfolgt aber über Standardprotokolle wie HTTPS auf der Anwendungsschicht (Layer 7 im OSI-Modell). VPN-Tunnel werden so ebenso überflüssig wie separate Clients oder Agenten. Proxies können nicht nur die Anfragen von Anwendern bewerten, sondern auch Applikationszugriffe untersuchen. Anders als bei einer Firewall basieren die Entscheidungen nicht auf Ports und IP-Adressen, sondern auf dem Verhalten der Nutzer oder der Anwendungen. Applikation und Daten im eigenen Netz lassen sich so tarnen, dass sie für nicht autorisierte Anwender oder Fremdprogramme unsichtbar sind.

Das Proxy-System steht und fällt mit einer zuverlässigen Quelle für die Identitätsprüfung. Mit den Daten aus diesem System, das vom Unternehmen selbst oder von Identitäts-Providern bereitgestellt werden kann, wird die Identität von Benutzern und Geräten überprüft (Authentifizierung) und auf dieser Basis werden Zugriffsrechte gewährt (Autorisierung). Der Proxy kann seine Entscheidung auch an Mindestkriterien wie gültige Zertifikate, ein aktuelles Betriebssystem, die Passwortqualität oder das Vorhandensein eines Antivirenscanners knüpfen. Fehlen diese Voraussetzungen, wird ein Zugriff mit entsprechendem Hinweis abgelehnt.

3. Teil: „Gartners ZTNA-Definitionen“

Gartners ZTNA-Definitionen

Neben dieser Einteilung werden häufig auch die ZTNA-Definitionen (Zero Trust Network Access) von Gartner verwendet. Das Analystenhaus unterscheidet zwischen Client-initiiertem („Client-initiated“) und Service-initiiertem („Service-initiated) ZTNA.

Bei der ersten Variante, die im Wesentlichen dem SDP-Ansatz entspricht, schickt ein auf dem Gerät des Nutzers installierter Client Informationen über Sicherheitszustand und Kontext an einen Controller. Dieser sendet dem Anwender eine Authentifizierungsaufforderung und entscheidet, auf welche Applikationen und Daten zugegriffen werden kann. „Wird der Anwender für den Zugriff autorisiert, erfolgt die Verbindung zur Applikation über das existierende Netzwerk und einen Internet-Link“, erläutert Mathias Widler von Zscaler.

Der Service-initiierte Ansatz entspricht im Wesentlichen dem Proxy-Model. Die Verbindung zur Anwendung erfolgt über einen zwischengeschalteten Service als Broker. „Bei diesem Ansatz wird die Verbindung nicht über das öffentliche Internet hergestellt, sondern über eine private Infrastruktur“, erklärt Widler. Die Verbindung zur Anwendung erfolge somit in größerer Isolation, da der Datenverkehr nicht über das Internet läuft. „Was nicht sichtbar ist im Internet, kann auch nicht angegriffen werden.“

Kein Alles-oder-nichts-Ansatz

Auch wenn Zero Trust ein radikales Umdenken erfordert, müssen vorhandene Netzwerk- und Security-Umgebungen nicht notwendigerweise komplett ersetzt werden. „Unternehmen sollten wenn möglich die bestehenden Infrastrukturen weiter nutzen“, rät Scott Gordon von Pulse Secure, „Zero Trust ist kein Alles-oder-nichts-Projekt, sondern kann nach und nach eingeführt werden.“

Ohnehin sei Zero Trust kein Allheilmittel, ergänzt Gordon: „Der Ansatz hat Vorteile bei der Zugangskontrolle, ersetzt aber nicht alle anderen Verteidigungsmechanismen.“ In vielen Fällen sei eine Kombination aus Perimeter-basierten und Zero-Trust-Technologien aber die beste Wahl. „Anwender sollten beim Ausbau einer Zero-Trust-Infrastruktur die geschäftliche Notwendigkeit, die spezifischen Anwendungsbereiche und die Auswirkungen auf das operative Geschäft berücksichtigen.“

Gerhard Giese von Akamai empfiehlt, mit dem Zugriffsmodell der geringstmöglichen

Berechtigungen zu starten: „Warum sollte jeder angemeldete Nutzer IP-basierten Zugriff auf das gesamte Netzwerk haben?“, fragt der Experte.

Berechtigungen zu starten: „Warum sollte jeder angemeldete Nutzer IP-basierten Zugriff auf das gesamte Netzwerk haben?“, fragt der Experte.

Chester Wisniewski, Principal Research Scientist bei Sophos, hält ebenfalls ein differenziertes Vorgehen für den richtigen Weg: „Es gibt keinen einheitlichen Ansatz mehr, wie ihn viele Unternehmen in LANs verwendet haben“, erklärt Wisniewski. „Die Anzahl der Einschränkungen und die Tiefe der Authentifizierung müssen je nach angeforderter Ressource oder Zugriffsebene variieren.“

4. Teil: „Wie Google Zero Trust umsetzte“

Wie Google Zero Trust umsetzte

Eines der bekanntesten Unternehmen, die den Zero-Trust-Ansatz anwenden, ist der Internetkonzern Google. Bereits 2011 begann das Unternehmen, ein Sicherheitskonzept namens BeyondCorp zu entwickeln, das auf dem Zero-Trust-Model basiert. Verschiedene Gründe hatten den Perimeter-basierten Security-Ansatz zunehmend problematisch werden lassen. Immer mehr Mitarbeiter waren unterwegs und griffen von unterschiedlichsten Orten mit verschiedenen Geräten auf das Unternehmensnetz zu. Eine Absicherung der Verbindungen per VPN wurde durch den vermehrten Einsatz von Smartphones und Tablets immer schwieriger und unübersichtlicher.

Hinzu kam eine steigende Zahl von Lieferanten und Partnern, denen nur auf bestimmte Inhalte Zugriff gewährt werden sollte, auch wenn sie sich innerhalb des Unternehmensnetzwerks befanden. Durch die Verbreitung von Public-Cloud-Diensten wie Software as a Service vergrößerte sich die Angriffsfläche weiter und machte eine sinnvolle Perimeterdefinition nahezu unmöglich.

Das Unternehmen wollte außerdem Attacken schneller erkennen und möglichst automatisiert darauf reagieren können. „Während die meisten Unternehmen davon ausgehen, dass das interne Netzwerk eine sichere Umgebung für Firmenanwendungen ist, hat unsere Erfahrung bei Google gezeigt, dass dieses Vertrauen fehl am Platz sein kann“, betont Google-Cloud-Director Srinivas. „Vielmehr sollte man davon ausgehen, dass ein internes Netzwerk genauso anfällig für Gefahren sein kann, wie das öffentliche Internet – und auf Basis dieser Annahme Unternehmensanwendungen erstellen.“

Heute richtet sich der Zugriff auf Unternehmensressourcen danach, wer mit welchem Gerät von wo auf welche Inhalte zugreifen möchte. „Bei Google gibt es kein privilegiertes Unternehmensnetzwerk mehr“, erklärt Srinivas. „Stattdessen hängt der Zugriff ausschließlich von den Benutzerdaten und dem Kontext ab, egal in welchem Netzwerk sich ein Nutzer befindet. Jede Zugriffsanfrage auf die internen Ressourcen von Google ist vollständig authentifiziert, autorisiert und umfassend verschlüsselt.“

Für den Nutzer ergeben sich daraus laut Srinivas keine Nachteile: „Die Benutzererfahrung zwischen lokalem und Fernzugriff auf die internen Ressourcen von Google ist, bis auf mögliche Unterschiede in der Latenzzeit, praktisch identisch.“

Fazit & Ausblick

Unternehmen fällt es immer schwerer, zu definieren, wo ihr Firmennetz anfängt, wo es aufhört, und vor allem, wie es abzusichern ist. Der Zero-Trust-Ansatz ist ein Ausweg aus diesem Dilemma, denn er macht keinen Unterschied zwischen „drinnen“ und „draußen“, sondern behandelt jede Anfrage gleich. Das erleichtert nicht nur die Integration von Cloud-Ressourcen und mobilen Mitarbeitern erheblich, es reduziert auch die Gefahr, dass sich eingedrungene Schädlinge ungehindert im Netz ausbreiten können. Das Modell hat aber auch Tücken.

Da die zentrale Rechteverwaltung jeden Zugriff autorisieren muss, steht und fällt die Benutzerfreundlichkeit und Leistungsfähigkeit mit deren Verfügbarkeit und Performanz. Es ist deshalb ausgesprochen wichtig, dieses System redundant, skalierbar und hochverfügbar zu halten, um bei einem Ausfall nicht die gesamte Infrastruktur lahmzulegen.

Ein weiterer Knackpunkt beim Umstieg auf Zero Trust ist die Definition der Zugangsberechtigungen. Alle Nutzer, Geräte, Datentypen und Rollen müssen definiert und dynamisch angepasst werden können. Das erfordert eine sorgfältige Vorarbeit und eine ständige Überprüfung. Kein Wunder also, dass Zero-Trust-Projekte mehrere Jahre dauern können und einen erheblichen Aufwand an Personal und Investitionen bedeuten.

Pilot-Features

Google Maps-Funktionen für nachhaltigeres Reisen

Google schafft zusätzliche Möglichkeiten, um umweltfreundlichere Fortbewegungsmittel zu fördern. Künftig werden auf Google Maps verstärkt ÖV- und Fußwege vorgeschlagen, wenn diese zeitlich vergleichbar mit einer Autofahrt sind.

>>

Codeerzeugung per KI

Code ist sich viel ähnlicher als erwartet

Eine Studie zeigt, dass einzelne Codezeilen zu 98,3 Prozent redundant sind, was darauf hindeutet, dass Programmiersprachen eine einfache Grammatik haben. Die Machbarkeit von KI-erzeugtem Code war also zu erwarten.

>>

Bitkom-Länderindex

Hamburg und Berlin bei der Digitalisierung ganz vorne

Im Länder-Ranking des Branchenverbandes Bitkom liegen die Stadtstaaten an der Spitze der Digitalisierung in Deutschland. Bayern ist der beste Flächenstaat.

>>

JavaScript Framework

Hono werkelt im Hintergrund

Das JavaScript-Framework Hono ist klein und schnell. Ein weiterer Vorteil ist, dass Hono auf vielen Laufzeitumgebungen zum Einsatz kommen kann.

>>