13.02.2018

Edge- und Fog-Computing

1. Teil: „So werten Sie latenzkritische Daten aus“

So werten Sie latenzkritische Daten aus

Panchenko Vladimir / Shutterstock.com

Sensorikgestützte Anwendungen fordern garantierte Latenzzeiten für kritische Daten. Edge- und Fog-Computing sorgen im Internet der Dinge für einen flotten Datenaustausch.

Mit dem Aufkommen hoch entwickelter Sensorik, des maschinellen Lernens und kognitiver Systeme nimmt die Netzwerkkante an Relevanz zu. Immer mehr Unternehmen wollen aus dem IoT- und IIoT-Datenreichtum neue Werte schöpfen. Doch gerade im Bereich der sprichwörtlichen „letzten Meile“ besteht dringender Handlungsbedarf. „Das Internet der Dinge sowie rechenintensive Analytics-Anwendungen benötigen häufig extrem kurze Latenzzeiten“, erläutert Martin Kipping, Director International IT-Projects beim IT-Infrastrukturanbieter Rittal.

Cyber-physische Systeme (CPS), kleine Netzwerke aus Sensoren und Computern, erfassen kontinuierlich eine Vielzahl von Sensor-Messwerten in winzigen Datenpaketen. Bohrtürme zum Beispiel erzeugen so bereits heute 500 GByte Daten pro Woche, ein Flugzeug rund 20 TByte pro Minute.

Ähnliche Entwicklungen nehmen auch in anderen Wirtschaftssparten an Fahrt auf. Selbst im Straßenverkehr entstehen mittlerweile massive Datenmengen. Ein vernetztes Fahrzeug funkt jede Stunde rund 25 GByte an Daten in die Cloud, etwa Informationen über die gefahrene Strecke oder aktuelle Verkehrsbedingungen.

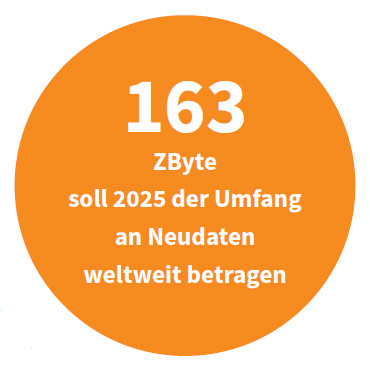

Der Datenverkehr durch den Frankfurter DE-CIX-Knoten, den größten Internetknoten Deutschlands, wächst um durchschnittlich 73 Prozent pro Jahr. Die Schere zwischen der Trendlinie für Leistungsspitzen und der für die Durchschnittsbelastung klafft dabei immer stärker auseinander. Die Explosion an Daten bringt die Internet-Infrastruktur durch unvorhersehbare Bedarfsschwankungen zunehmend ins Stottern. Der Datendruck sei „der wichtigste Treiber für IT und Telekommunikation“, betont der operative Leiter der IT-Division von T-System Stefan Bucher in einem Interview mit „DataCenter Insider“. Die weltweite Datenmenge soll bis 2025 gegenüber 2016 um 1000 Prozent steigen, prognostizieren IDC und Seagate. Der Gesamtumfang an Neudaten soll dann die 163-Zettabyte-Marke übertreffen.

Die Grenzen der Cloud

Zur Auswertung und Langzeitspeicherung müssen die gesammelten Daten bisher in die Cloud oder in ein unternehmenseigenes Rechenzentrum übertragen werden, wo die Rechenleistung und die vorhandenen Speicherkapazitäten den Einsatz von Big-Data-Analysewerkzeugen und KI-Anwendungen ermöglichen. Dafür müssen die Datenströme aber erst einmal im Rechenzentrum ankommen. Die großen Entfernungen, die die Signale der Sensorik in den Endgeräten auf dem direkten Weg in die Cloud überbrücken müssen, resultieren in einer unvermeidlichen Netzwerklatenz und gehen mit unerwarteten Verbindungsstörungen einher. Folge: Die Daten stauen sich, Betriebsabläufe stocken, die Kosten steigen.

CPS-Systeme können auf Anweisungen aus der Cloud nicht warten – erst recht nicht, wenn Menschenleben im Spiel sind. Ein klassisches Beispiel dafür sind autonome Fahrzeuge. Sie setzen Fähigkeiten zur Echtzeitkommunikation der Sensorik voraus und diese steht und fällt mit der Netzwerklatenz. Konventionelle IT-Architekturen wie die Cloud ziehen da den Kürzeren. Der Weg zum Kern-Rechenzentrum oder gar zur Public Cloud ist viel zu weit.

Alle Daten in der Cloud aufzubereiten würde zu viel Zeit und Geld kosten. Die Compute-Leistung muss daher näher an die Netzwerkkante heranrücken. So könnten Funktionen dort ablaufen, wo sie benötigt würden, erklärt Michael Stiller, wissenschaftlicher Mitarbeiter im Bereich Industriekommunikation beim Fraunhofer-Institut für Eingebettete Systeme und Kommunikationstechnik (ESK). Für Unternehmen gilt es also, die Datenflut direkt am „Rand“ des Netzwerks zu bändigen. Die Frage lautet nur: Wie?

2. Teil: „Edge und Fog: die Unterschiede“

Edge und Fog: die Unterschiede

Vorreiter der Kommunikationstechnologie setzen auf Edge- und Fog-Computing, um die Schwächen der Cloud zu kompensieren. Bei Edge und Fog handelt es sich um zwei Lösungsansätze für eine intelligente, dezentrale und echtzeitfähige IT-Infrastruktur an der Netzwerkkante.

Edge: Beim Edge-Computing-Modell erfolgt die Verarbeitung der Daten in eingeschränktem Umfang direkt auf den Endgeräten der Netzwerkkante. Daher die Bezeichnung Edge für Kante. Im Industriesektor finden sogenannte PACs (Programmable Automation Controllers) Verwendung – Geräte in der Größe eines Mikro-Computers wie des Raspberry Pis. Sie übernehmen die Compute-Last der zahllosen smarten IoT-Endpunkte, um cyber-physische Systeme mit Echtzeitfähigkeiten auszustatten. Edge-Computing minimiert die Netzwerkbelastung und die Latenz. Das Problem bei diesem Ansatz: Die verfügbare Leistung lässt sich nicht skalieren.

Fog: Im Fog-Computing-Modell kommen an der Netzwerkkante kleine Rechenzentren als Gateways zum Einsatz. Hier findet eine Teilauswertung und Aggregation der Daten aus der Sensorik der Endgeräte statt – zur anschließenden Übertragung ins Hauptrechenzentrum oder in die Cloud. „Der zentrale Cloud-Server erhält beim Fog-Computing nur die wichtigsten IoT-Daten. Den Rest präparieren kleinere Netzwerkkomponenten“, so Marko Vogel, Director Security Consulting bei KPMG Deutschland.

Fog-Architekturen stellen zusätzliche Compute-, Speicher-, Cache- und andere Ressourcen zwischen dem Hauptrechenzentrum oder der Cloud und den einzelnen IoT-Endgeräten mit ihrer Sensorik bereit, um die Geschwindigkeit der Datenverarbeitung an strategischen Punkten zu optimieren. So lassen sich zeitkritische Entscheidungen auch bei komplexeren Problemstellungen nahezu in Echtzeit treffen.

Fog ist im Endeffekt eine spezielle Variante von Edge-Computing auf Systemebene. Das Fog-Architekturmuster hat gegenüber dem reinen Edge-Modell den Vorteil der Gateways. Diese auch als Fog-Knotenpunkte (fog nodes) bezeichneten Gateways sind physische und logische Netzwerkelemente, die analog zu einem Server im Cloud-Computing bestimmte Dienste implementieren. Bei den Fog-Knoten kann es sich sowohl um ressourcenarme Geräte als auch um üppig bestückte Hardware wie Cloudlets oder kleine Edge-Rechenzentren an der Netzwerkkante handeln. Die Fog-Knoten können auch direkt im betreffenden Endgerät verbaut sein.

Edge- und Fog-Computing weisen gewisse Parallelen zu einem Content Delivery Network (CDN) auf. Während sich jedoch klassische CDNs auf die unidirektionale Bereitstellung statischer Medien und das Medien-Streaming beschränken, schließt das Edge- beziehungsweise das Fog-Computing bidirektionale Übertragung transaktionaler Daten mit ein. Dies hat weitreichende Implikationen unter anderem für die Industrie 4.0. „Nur mit einem dezentralen Ausbau der IT-Landschaft lässt sich eine IT-technische Unterstützung von verteilten Entwicklungs- und Produktionsstandorten erreichen“, erläutert Martin Kipping von Rittal.

Laut den Analysten von IDC sollen bis zum Jahr 2019 etwa 43 Prozent der durch das IoT erzeugten Daten mit Edge-Computing-Systemen verarbeitet werden. Hierzu müssten an den Rändern des Unternehmensnetzwerkes zusätzliche IT-Kapazitäten geschaffen werden. Der Markt sei auf Wachstum eingestellt, bestätigt Kipping. Das Gartner-Institut beziffert das weltweite Marktpotenzial von Hardware für Edge- und Fog-Computing im Jahr 2020 auf annähernd 3 Billionen Dollar. Bis 2020 sollen laut Gartner weltweit 20,4 Milliarden IoT-Endgeräte auf Edge- und Fog-Computing-Infrastruktur zugreifen.

3. Teil: „Smarte Fabriken und Städte“

Smarte Fabriken und Städte

Eine neue Generation von echtzeitfähigen, hochsicheren und intelligenten IIoT-Anwendungen auf der Basis von Fog-, Edge- und Cloud-Infrastrukturen entwickelt in Deutschland unter anderem das IIoT-Center des Fraunhofer-Instituts für Offene Kommunikationssysteme FOKUS. Zu den wichtigsten Anwendungsfeldern zählen neben Smart Manufacturing und Industrie 4.0 auch Smart Cities.

Das Konzept der smarten Fabrik wie auch der smarten Metropole steht und fällt mit der Verfügbarkeit von Sensordaten für prädiktive Wartung, Zustandsüberwachung, Energiewirtschaft, öffentliche Sicherheit und dergleichen mehr. Die Technologie der vorausschauenden Instandhaltung (Predictive Maintenance) ist bereits weit fortgeschritten. Sie erlaubt es, mit Hilfe von analytischen Modellen und konkreten Messwerten absehbaren Betriebsstörungen durch den proaktiven Austausch abgenutzter Teile zuvorzukommen. Unternehmen können dadurch nicht nur ihre Betriebskosten senken, sondern nebenbei auch Qualitätsschwankungen in der Fertigung reduzieren oder Dienstausfälle verhindern.

T-Systems konnte den wirtschaftlichen Nutzen prädiktiver Wartung unter anderem im Bahnbetrieb erfolgreich nachweisen. Jede ausgefallene Lok kostet laut Stefan Bucher rund 90.000 Euro im Jahr. T-Systems habe einen selbstlernenden Algorithmus entwickelt, der in den Rohdaten aus rund

60 Sensoren bestimmte Muster erkenne und Anomalien finde. So ließen sich Ausfälle verhindern.

60 Sensoren bestimmte Muster erkenne und Anomalien finde. So ließen sich Ausfälle verhindern.

Auch im Bereich der physischen Sicherheit scheinen sich Edge- und Fog-Architekturmuster zu bewähren. So bietet beispielsweise T-Systems gemeinsam mit dem kalifornischen Start-up Roambee eine IoT-gestützte Echtzeitlösung für das Asset-Tracking und Risikomanagement an. Die Technologie ermöglicht die Nachverfolgung von Warensendungen und die Überwachung des Zustands von Gütern und Industrieanlagen auf der ganzen Welt. Unternehmen erhalten Berichte über relevante Ereignisse, Echtzeitalarme sowie Auswertungen und verwertbare Datenanalysen in Einklang mit höchsten Datensicherheitsstandards.

Übrigens: Maschinelles Lernen ist erst dank der neuesten Entwicklungen im Bereich des Edge-Computings praxistauglich geworden. Beim maschinellen Lernen handelt es sich um einen Sonderfall von Künsticher Intelligenz, nämlich um die Fähigkeit physischer Geräte, ohne menschliche Interventionen eigene analytische Modelle zu entwickeln und auf Basis der so gewonnenen Erkenntnisse autark zu handeln. Maschinell lernende cyber-physische Systeme können generell auch ohne eine aktive Cloud-Anbindung auskommen. Letzteres stellt eine Voraussetzung für die Robustheit und Verlässlichkeit kritischer Infrastrukturen dar.

4. Teil: „Wettlauf um die Netzwerkkante“

Wettlauf um die Netzwerkkante

Die enorme Tragweite des Edge-Computing-Modells für die Wirtschaft 4.0 haben auch die Großen unter den Cloud-Anbietern wie Amazon & Co. mittlerweile auf dem Radar – und deshalb eigene Lösungen für das Edge- und Fog-Computing entwickelt. Sie lassen sich sowohl auf SOC-Hardware (System on a chip) im Edge-Modell als auch auf Fog-Gateways nutzen.

Der Aufbruch in die 5G-Mobilfunk-Ära und die damit einhergehende Verdichtung der Mobilfunkmasten versprechen zusätzliche neue Möglichkeiten zur Umsetzung verteilter Edge-Topologien durch die Virtualisierung von RAN-Komponenten (Radio Access Network). Ein RAN ist ein Funkzugangsnetz, das zwischen einem drahtlos angeschlossenen Gerät und seinem Kern-Netz vermittelt. Für die Telekommunikationsanbieter sind mit der Virtualisierung eines RANs zum vRAN erhebliche Kostensenkungen verbunden.

Die Nutzung von Netzwerkvirtualisierung zur Bereitstellung von Edge-Diensten hat die Branche auf den Namen Edge as a Service getauft, kurz: EaaS. Das Konzept verspricht eine Lösung für ein drückendes Problem des Mobilfunksektors: die starre Kostenstruktur, die derzeit eine Differenzierung von Diensten im Hinblick auf die verschiedenen Edge-Anwendungen in der Praxis verhindert.

Die aktuelle Netzwerklandschaft zwingt Netzbetreiber in das traditionelle Geschäftsmodell der Telekommunikationsbranche auf der Basis eines dedizierten Zugangsnetzes. Dies hat schwankende Kosten und eine gewisse Stagnation mit sich gebracht.

Die zunehmende Nachfrage nach Breitbandnetzen mit immer höheren Kapazitäten drängt auf den schnellen Einsatz mehrerer Arten von Zugangsnetzen weltweit, die oft aus ganz neuen Lösungen bestehen, darunter zum Beispiel die Techniken Narrowband-IoT oder Low Range Wide Area Network (LoRa).

Huawei Roadshow 2024

Technologie auf Rädern - der Show-Truck von Huawei ist unterwegs

Die Huawei Europe Enterprise Roadshow läuft dieses Jahr unter dem Thema "Digital & Green: Accelerate Industrial Intelligence". Im Show-Truck zeigt das Unternehmen neueste Produkte und Lösungen. Ziel ist es, Kunden und Partner zusammenzubringen.

>>

Nach der Unify-Übernahme

Mitels kombinierte Portfoliostrategie

Der UCC-Spezialist Mitel bereinigt nach der Unify-Übernahme sein Portfolio – und möchte sich auf die Bereiche Hybrid Cloud-Anwendungen, Integrationsmöglichkeiten in vertikalen Branchen sowie auf den DECT-Bereich konzentrieren.

>>

Teldat-Tochter

Bintec Elmeg stellt den Betrieb ein

Auf LinkedIn teilt der Hersteller mit, dass Bintec Elmeg seine Aktivitäten in der DACH-Region einstellt. Die Sanierung sein gescheitert, so heißt es offiziell.

>>

Forschung

KI macht Gebärdensprache zugänglicher

Ein KI-Tool der Universität Leiden für "Wörterbücher" erkennt Positionen und Bewegungen der Hände bei der Darstellung unterschiedlicher Gebärdensprachen.

>>