21.10.2019

Green IT

1. Teil: „Das Rechenzentrum nachhaltig gestalten“

Das Rechenzentrum nachhaltig gestalten

Autor: Konstantin Pfliegl

graphicsdunia4you / shutterstock.com

Im Meer versenken oder im Windrad verbauen - Data-Center werden umweltfreundlicher. Unter anderem kann zum Beispiel die Abwärme zum Heizen verwendet werden.

Die digitale Welt ist eigentlich eine überaus praktische Sache: zentrale Datenspeicher und Anwendungen in der Cloud, moderne Produktion dank Industrie 4.0 oder mit dem Smartphone von überall aus auf relevante Informationen zugreifen.

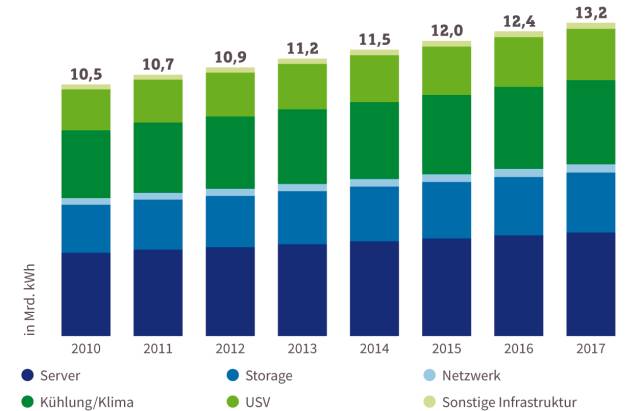

Einen großen Nachteil hat die Digitalisierung allerdings. Die vielen Dienste verschlingen weltweit Milliarden Kilowattstunden Strom. So verbrauchten etwa Server und Rechenzentren in Deutschland im vorletzten Jahr mehr als 13 Milliarden Kilowattstunden, wie das Borderstep Institut für Innovation und Nachhaltigkeit errechnete. Zum Vergleich: Das entspricht in etwa dem Jahresenergiebedarf der Bundeshauptstadt Berlin.

Und ein Ende des wachsenden Stromhungers ist erst einmal nicht in Sicht. So erhöhte sich der Energiebedarf in deutschen Rechenzentren zwischen 2010 und 2017 um 25 Prozent. Auch die Server werden immer mehr: 2017 wurden hierzulande rund 2,4 Millionen Server betrieben - 18 Prozent mehr als sieben Jahre zuvor.

Dieses enorme Wachstum wird in erster Linie vom Cloud-Markt getrieben. Laut „Global Cloud Index (GCI)“ des Netzwerkausrüsters Cisco kommen 2021 bereits 95 Prozent des Datenverkehrs in Rechenzentren aus der Cloud. Die Cloud-Anbieter bauen ihre Ressourcen in Deutschland immer weiter aus. Das liegt nicht zuletzt auch an den Anforderungen der Datenschutz-Grundverordnung (DSGVO). Sie veranlasst viele Unternehmen dazu, Daten nur noch in Deutschland beziehungsweise innerhalb der Europäischen Union abzulegen. Dementsprechend stocken vor allem die großen Cloud-Anbieter wie Amazon, Google oder Microsoft ihre Ressourcen hierzulande deutlich auf.

Interessant dabei: Vor allem im Großraum Frankfurt wächst der Stromhunger von Servern. In und um die hessische Metropole haben zahlreiche Rechenzentrumsbetreiber eine Dependance - hauptsächlich wegen des bedeutenden Internetknotens DE-CIX. Und das hat Folgen: Bereits vor mehr als einem Jahr haben die dort ansässigen Data-Center den Frankfurter Flughafen von seiner Position als Strom-Hauptkonsument verdrängt. Anderthalbmal so viel Strom wie an den Airport liefert der städtische Energieversorger an die diversen Rechenzentren.

Eines ist aber trotz steigendem Energiebedarf klar: „Die Digitalisierung ist nicht aufzuhalten: Immer mehr Daten werden erzeugt, die in immer mehr und größeren Rechenzentren verarbeitet werden. Dabei steigen nicht nur die Leistungsdichten exponentiell, sondern auch die Energiebedarfe weltweit“, betont Konstantin Kleinichen, Manager beim Dresdener Rechenzentrums-Spezialisten Cloud&Heat Technologies. Alle Unternehmen, Rechenzentrumsbetreiber und auch Kunden trügen dabei die Verantwortung, einen Beitrag zum Klimaschutz und zur Zukunft unseres Planeten zu leisten.

Vor allem hinsichtlich des Klimawandels sollte daher das Ziel sein: Einsatz energieeffizienter Hardware, Nutzung regenerativer Energien und eine möglichst effiziente Verwendung der Rechenzentrums-Abwärme.

Die gute Nachricht: Es gibt bereits eine Menge Möglichkeiten, wie sich Rechenzentren energieeffizienter betreiben lassen, Stichwort Green IT. Unter dem Begriff Green IT werden sämtliche umwelt- und ressourcensparenden Maßnahmen im Bereich IT und Kommunikation zusammengefasst. Im Wesentlichen zielt Green IT darauf ab, den Energieverbrauch zu senken, CO2-Emissionen zu reduzieren und die Energieeffizienz zu steigern.

2. Teil: „Potenzial der Abwärmenutzung“

Potenzial der Abwärmenutzung

Der größte Einsparfaktor in Rechenzentren liegt im Bereich der Klima- und Lüftungstechnik. Diese verursacht je nach Alter der Rechenzentren und der eingesetzten Technik bis zu 60 Prozent der Energiekosten. Denn die in den Rechenzentren installierten Server verbrauchen nicht nur eine Menge Strom für den Betrieb, sie erzeugen trotz moderner Hardware mit entsprechender Energieeffizienz nach wie vor viel Wärme, die größtenteils komplett ungenutzt bleibt. Ein nicht unbeträchtlicher Teil der eingesetzten Energie verpufft quasi als heiße Luft in die Umgebung.

Und damit nicht genug: Um die viele Abwärme abzutransportieren und die Server und Komponenten vor dem Hitzetod zu schützen, entsteht ein nicht unerheblicher zusätzlicher Energieaufwand für die erforderlichen Kühlanlagen. „Der überwiegende Teil des Energiebedarfs beim Betrieb der Rechenzentrumsinfrastruktur wird bei der Klimatisierung der IT-Installationen verbraucht, weitere Verbraucher sind die unterbrechungsfreie Spannungsversorgung (USV) und Betriebsperipherie“, erläutert Jan Schriewer, Geschäftsführer des Systemhauses GREEN IT.

Die Abgabe der Wärme in die Umwelt ist also verschenkte Energie. Ein wichtiger Hebel, um die Energieeffizienz eines Rechenzentrums und dessen Nachhaltigkeit zu erhöhen, ist daher eine Nutzung dieser Abwärme. Eine naheliegende Verwendungsmöglichkeit für die Abwärme der Server ist die Einspeisung in vorhandene Nah- oder Fernwärmenetze.

Wie so etwas aussehen kann, zeigen zum Beispiel die VW Financial Services, die im letzten Jahr in Braunschweig ein Rechenzentrum in Betrieb genommen haben, dessen Abwärme ein angrenzendes Wohn- und Gewerbegebiet versorgt. Und in der Schweizer Gemeinde Uitikon beheizt die Abwärme eines Data-Centers das Wasser des örtlichen Schwimmbads.

Data-Center als Heizung

Der Rechenzentrumsspezialist Cloud&Heat Technologies produziert solche Rechenzentren, die die Abwärme der Server nicht ungenutzt in die Luft zu blasen. Seine Data-Center nutzen eine sogenannte Heißwasser-Direktkühlung, um Gebäude zu heizen oder die Wärme in ein vorhandenes Fern- und Nahwärmenetz abzugeben. Auch im Sommer, wenn keine Heizung gebraucht wird, lässt sich die Abwärme sinnvoll nutzen, etwa zur Erwärmung des Trinkwassers. Die eingesetzte Direktkühlung hält dabei - ohne den Einsatz von Wärmepumpen - das Temperaturniveau gleichbleibend auf 60 Grad.

Eine derartige Lösung kommt zum Beispiel in einem Rechenzentrum im 111 Meter hohen Hochhaus Eurotheum in der Frankfurter Innenstadt zum Einsatz und versorgt das Gebäude mit Heizenergie und Warmwasser. Die Büros und das in dem Gebäude befindliche Hotel sollen laut Cloud&Heat auf diese Weise jährlich bis zu 65.000 Euro einsparen. Zusätzlich soll die wasserbasierte Kühltechnik im Vergleich zu konventionellen Luftkühlungslösungen bis zu 95.000 Euro an Einsparungen bringen. Das entspreche einer CO2-Reduktion von bis zu 557 Tonnen im Jahr.

3. Teil: „Rechenzentrum im Meer“

Rechenzentrum im Meer

Microsoft arbeitet beim Projekt Natick bereits seit mehreren Jahren an einem kompakten Rechenzentrum, das kostengünstig und ohne lange Datenverbindungen in der Nähe von Ballungszentren autonom betrieben werden kann. Zudem soll das Data-Center besonders umweltfreundlich sein.

Die Lösung fanden die Microsoft-Forscher im Meer. Denn mehr als die Hälfte der Menschheit lebt nur rund 200 Kilometer vom nächsten Meer entfernt. Durch den Betrieb von Rechenzentren im küstennahen Meer lassen sich nicht nur die Latenzzeiten beim Zugriff auf die Cloud gering halten. Das Wasser lässt sich auch gleich für die Kühlung der Server verwenden - stromhungrige Kälteanlagen fallen so weg. Microsoft setzt bei seinem Unterwasser-Rechenzentrum auf ein Wärmetauschverfahren des Unternehmens Naval Group, das auch zur Kühlung von U-Booten genutzt wird. Das System leitet zunächst das Meerwasser durch die Kühler auf der Rückseite der Server-Racks und anschließend zurück ins Meer. Die Energiebilanz eines solchen Unterwasser-Rechenzentrums lässt sich dabei noch nachhaltiger gestalten, indem man beispielsweise auf Strom aus Offshore-Windparks oder Gezeitenkraftwerke setzt. Letztere nutzen den natürlichen Tidenhub der Meere, um Strom zu erzeugen.

Im Sommer vergangenen Jahres hat Microsoft eines erstes autonomes Unterwasser-Rechenzentrum in der Nähe der schottischen Orkney-Inseln ins Meer gelassen. Die rund 14 Meter lange und 12 Meter breite Metall-röhre beherbergt 12 Server-Racks mit knapp 900 Servern. Sie ist mit über den Meeresboden verlegten Glasfaser- und Stromleitungen mit dem Festland verbunden.

Ein erstes Fazit: Die U-Boot-Kühllösung funktioniert in der Praxis auch bei Servern. Das aufgeheizte Wasser aus dem Rechenzentrum vermischt sich schnell mit der umgebenden Strömung.

Server in Windrädern

Einen ähnlichen Weg wie Microsoft geht das Unternehmen WestfalenWIND. Anstatt die Server aber im Meer zu versenken, bewegt sich der Windparkbetreiber mit dem Projekt WindCORES in die Höhe und verbaut kleine Rechenzentren direkt in Windkraftanlagen. Pro Windenergieanlage lassen sich bis zu 50 Server-Racks unterbringen. Die Idee dahinter: Durch die direkte Versorgung der Server mit umweltfreundlichem Windstrom soll der Betrieb dieser Mini-Rechenzentren weitgehend CO2-neutral erfolgen. Laut Betreiber könnte man mit dieser Windrad-Lösung bis zu 10.000 Standorte bundesweit ausstatten.

Dabei sollen auch in den Windrädern die von anderen Rechenzentren bekannten hohen Sicherheitsstandards gelten. Es wird nicht nur die mit den Kunden vereinbarte Rechenzentrumsleistung in eine der Windenergieanlagen integriert, es wird auch gewährleistet, dass die Daten der Kunden sicher und zum Beispiel vor Feuer, EMV-Störungen oder auch vor Zugriffen durch Dritte geschützt sind. Die Windkraftanlagen unterliegen dazu einer Kamera- und Echtzeitüberwachung sowie einer bedarfsgerechten Klimatisierung.

4. Teil: „Abwärme züchtet Algen“

Abwärme züchtet Algen

Das schleswig-holsteinische Unternehmen WindCloud setzt für den Betrieb von Rechenzentren ebenfalls auf Ökostrom von Windkraftanlagen. WindCloud baut seine Rechenzentren jedoch nicht in die Anlagen, sondern in deren Nähe. Als lokaler Großabnehmer kauft WindCloud den Strom weitestgehend direkt bei den Erzeugern und nutzt den Ökostrom möglichst in unmittelbarer Nähe der Windräder, etwa auf ehemaligen Nato- und Bundeswehranlagen in Nordfriesland.

Ende vergangenen Jahres hat WindCloud auf dem GreenTEC-Campus im nordfriesischen Enge-Sande auf einem ehemaligen Munitionsdepot das erste Rechenzentrum in Betrieb genommen. Der Betreiber gibt für das Rechenzentrum einen PUE-Wert von 1,2 an.

Die Idee von WindCloud ist aber nicht nur die Nutzung von regionalem Ökostrom - die Rechenzentren sollen künftig aktiv CO2 vermindern. Dazu sollen neben den Rechenzentren Gewächshäuser entstehen, die mit der Abwärme der Server beheizt werden. In den Gewächshäusern sollen zum Beispiel Algen gezüchtet werden, die CO2 binden und so die Kohlendioxid-Bilanz des Rechenzentrums quasi neutralisieren. Auch für die Algen selbst gibt es sinnvolle Nutzungsmöglichkeiten. Sie eignen sich als Nahrungsergänzungsmittel oder für die Kosmetikindustrie.

Klimaneutrales Rechenzentrum

Das Unternehmen WindCloud ist nicht der einzige Rechenzentrumsbetreiber, der an einem Data-Center mit einer positiven Klimabilanz arbeitet. In der schwedischen Stadt Falun in der Provinz Dalarna baute der dortige städtische Energieversorger Falu Energi & Vatten zusammen mit dem Rechenzentrums-Unternehmen EcoDataCenter das nach eigenen Aussagen weltweit erste Data-Center, das einen klimaneutralen Betrieb ermöglicht.

Zum einen setzen die Betreiber ausschließlich auf Strom aus erneuerbarer Energie wie Wasser- und Windkraft. Zum anderen nutzen zum Beispiel die Kühlungssysteme des Data- Centers modernste Technik für eine größtmögliche Energieeffizienz. So reduzieren die Wasserpumpen des Kühlkreislaufs bei niedriger Last automatisch ihre Drehzahlen und senken damit den Strombedarf. Das soll für einen extrem niedrigen PUE-Wert von 1,15 sorgen. Darüber hinaus wird die Überschusswärme in das Faluner Fernwärmenetz geleitet.

Wärme für den Bergkäse

Unweit des Bodensees, in St. Gallen, steht das „energieeffizienteste Rechenzentrum der Schweiz“, so der Betreiber Rechenzentrum Ostschweiz, und gibt für dieses einen PUE-Wert von ebenfalls 1,15 an.

Das Data-Center mitten im Appenzellerland ist im Frühjahr vergangenen Jahres in Betrieb gegangen und verfügt über eine flächendeckende Photovoltaikanlage an den Fassaden und auf der Dachfläche. Diese Solaranlage erzeugt je nach Witterung bis zu einem Drittel der Energie, die das Rechenzentrum mit seinen 900 Quadratmetern Fläche und seinen 300 Server-Racks benötigt. Der übrige Strom kommt aus erneuerbaren Quellen.

Besonders ist aber die Kühlung der Server. Hier kommt eine sogenannte adiabate Kühlung zum Einsatz - eine Verdunstungskühlung. Durch Verdunsten wird der Abluft Wärme entzogen. Das kennt man aus dem Alltag: Wenn man über die angefeuchtete Haut pustet, dann spürt man durch die Verdunstung einen kühlenden Effekt. Im Ostschweizer Rechenzentrum wird hierfür die notwendige Kühlluft über Fassadenöffnungen eingesogen und sogenannten Kreuzstromwärmetauschern zugeführt. Das ist notwendig, da man die Außenluft nicht direkt zur Kühlung der Hardware verwenden kann. Diese ist nicht rein genug.

Die Abwärme der Server wird zudem zu Heizzwecken genutzt. Ein Nahwärmenetz versorgt eine benachbarte Käserei mit Server-Wärme. Diese benutzt die Wärme zum Pasteurisieren der Milch für ihre Käseproduktion.

5. Teil: „Daten in der Mine“

Daten in der Mine

In der Lefdal Mine, einer stillgelegten Mine an der Westküste Norwegens, wo Bergleute früher das Mineral Olivin für die Stahlherstellung abbauten, befindet sich heute ein riesiges Rechenzentrum. Das Lefdal Mine Datacenter besteht aus einem mehrstöckigen, 29 Kilometer langen Stollensystem mit

75 Kammern, das rund 120.000 Quadratmeter Platz für Server und die übrige Infrastruktur eines Rechenzentrums bietet.

75 Kammern, das rund 120.000 Quadratmeter Platz für Server und die übrige Infrastruktur eines Rechenzentrums bietet.

Wo liegen die Vorteile eines Rechenzentrums in einer ehemaligen Mine? Es muss nicht erst ein Gebäude gebaut werden - die Mine ist schon da. Zudem schützt das massive Gestein auf natürliche Weise zuverlässig vor elektromagnetischer Strahlung und Datenverlust. Hinzu kommt: In Norwegen gibt es Unmengen an Strom, den Wasserkraftwerke das ganze Jahr über umweltfreundlich aus dem Schmelzwasser von Gletschern erzeugen.

Auch bei der Kühlung der Server macht sich die Lage in Norwegen bezahlt: So ist es in der Mine nicht nur ganzjährig angenehm kühl, womit sie sich bestens für den Betrieb von Servern eignet, die Kühlanlagen nutzen zudem das kühle Nass des nahegelegenen Fjords. Sie saugen die warme Abluft der Server an, die sich über einen Wärmetauscher mit Hilfe des 7 Grad kalten Wassers aus 16 Metern Tiefe des Meeresarms dann wieder abkühlt. Dem Rechenzentrumsausrüster Rittal zufolge soll das Lefdal Mine Datacenter so auf einen PUE-Wert von unter 1,1 kommen.

Warmes Wasser zum Kühlen

Das Leibniz-Rechenzentrum der Bayerischen Akademie der Wissenschaften in Garching bei München hat keinen Fjord mit kühlem Wasser um die Ecke. Der Betreiber des Super-Computers SuperMUC setzt bei der Kühlung des Rechners auf warmes Wasser. Was zunächst widersinnig klingt, funktioniert in der Praxis bestens. Anstatt Luftkühlung mit Wärmetauschern nutzt das Leibniz-Rechenzentrum eine sogenannte Warmwasserkühlung. Wie der Name andeutet, wird dabei das durch die Server erwärmte Kühlwasser nicht jedes Mal wieder auf Frischwasser-Temperatur heruntergekühlt, sondern lauwarm zurück zu den Servern geleitet.

Und so funktioniert’s: Das Kühlwasser der Anlage wird direkt über Kupferrohre auf die Bauteile geleitet und erhitzt sich je nach Auslastung des Superrechners dabei auf 60 bis 65 Grad. Über mehrere Kühlkreisläufe leitet die Anlage das warme Kühlwasser auf das Dach des Rechenzentrums, wo es durch die kühle Außenluft wieder auf seine Ausgangstemperatur von rund 35 Grad heruntergekühlt wird. Das klappt auch bei sommerlichen Außentemperaturen.

In Kombination mit einer ebenfalls auf Energieeffizienz ausgelegten Software sollen dank dieser Art der Warmwasserkühlung Energieeinsparungen von bis zu 40 Prozent möglich sein.

6. Teil: „Kleine Änderung, große Wirkung“

Kleine Änderung, große Wirkung

Wenn man den Klimaschutz ernst nimmt, dann sollte man sich als Unternehmen Gedanken darüber machen, wie man den IT-Betrieb nachhaltig gestaltet. Das umfasst selbstverständlich nicht nur den Rechenzentrumsbetrieb. Doch ist dies der Bereich, der am meisten Energie verschlingt und viele Möglichkeiten bietet, effizienter und nachhaltiger zu werden. So kann man etwa Ökostrom beziehen, die Abwärme sinnvoll nutzen oder auf moderne Kühltechnologien und -methoden zurückgreifen. Die beschriebenen Beispiele zeigen, dass ein umweltfreundlicher Rechenzentrumsbetrieb durchaus möglich ist und etwas bringt, wenngleich der Aufwand nicht zu unterschätzen ist. Nicht zuletzt sinken damit mittelfristig auch die Betriebskosten.

Es muss aber nicht immer gleich der komplette Neu- oder Umbau eines Rechenzentrums samt umfangreicher Abwärmenutzung sein. Häufig ziehen bereits kleinere Veränderungen in der Infrastruktur erstaunliche Einsparungen bei den Energiekosten nach sich. Ein Beispiel ist IT Baden-Württemberg, der IT-Dienstleister für die Landesverwaltung des Bundeslandes. Die IT-Verwaltung plant langfristig die sogenannte Einhausung der Kaltgänge all ihrer Rechenzentren. Allein durch die Einhausung der ersten fünf Kaltgänge in zwei Server-Räumen im vergangenen Jahr wurden rund 10 Prozent Energie zum Kühlen eingespart. Bei einem Jahresenergieverbrauch von rund 1.000 Megawattstunden (MWh) sind das immerhin 100 MWh pro Jahr.

Doch was können Unternehmen - abgesehen von den Rechenzentren - noch alles tun, um klimafreundlicher, nachhaltiger und energieeffizienter zu werden? Man kann zum Beispiel weniger drucken, was Papier, Druckertinte oder Toner spart und darüber hinaus dafür sorgt, dass Laserdrucker weniger Feinstaub in die Büros und in die Umwelt pusten.

In vielen Unternehmen dürften die Drucker rund um die Uhr durchlaufen und die meiste Zeit unnötig Strom verbrauchen. Hier eine Lösung zu finden, ist nicht ganz einfach, weil zum Beispiel abteilungsweite Netzwerkdrucker meist durchgängig verfügbar sein müssen.

Was IT-Verantwortliche aber auf jeden Fall tun können: beim Einkauf von IT-Komponenten die Energieeffizienz berücksichtigen und auf entsprechende Öko-Siegel wie Energy Star oder Blauer Engel achten.

Wenn man aber den Nachhaltigkeitsgedanken weiter fasst und nicht nur den Stromverbrauch im Blick hat, sondern nachhaltige und fair produzierte Hardware anschaffen möchte, dann wird das Angebot auf dem Markt ziemlich schnell ziemlich dünn. Bei den Smartphones gibt es immerhin noch das „Fairphone“, ein Android-Smartphone, das unter „verantwortungsvoller Materialbeschaffung“ hergestellt wurde. Aber ob sich Unternehmen für ihre Mitarbeiter ein 450-Euro-Smartphone mit einer Ausstattung der unteren Mittelklasse leisten wollen, ist fraglich. Hier könnte das Verständnis für Nachhaltigkeit und faire Produktionsbedingungen schnell aufhören.

Nachhaltigkeit im Kleinen bietet Nager IT bereits seit einigen Jahren mit seiner „fairen Maus“. Statt Plastik wird Bio-Kunststoff auf Zuckerrohr-Basis verwendet. Das Scrollrad ist aus Buchenholz und Birke gefertigt, als Lötmaterial wird recyceltes Zinn verwendet. Die Produktion der Mäuse, also Lötarbeiten und Montage, erfolgt in einer Integrationswerkstatt in Regensburg. Und mit rund 30 Euro ist die Öko-Maus auch durchaus bezahlbar.

Fazit

Auf welche Art und Weise auch immer Unternehmen ihre IT nachhaltiger gestalten - wichtig ist, dass die Verantwortlichen sich des Themas bewusst sind und bei künftigen Investitionen den Nachhaltigkeitsaspekt mitberücksichtigen.

Jan Schriewer bringt es auf den Punkt: „Nachhaltigkeit ist keine Frage der Zeit, sondern der Prioritäten.“ Auch in Zeiten der Digitalisierung sollten Unternehmen nachhaltig denken - „unternehmerische Entscheidungen beeinflussen nicht nur die Welt, in der wir arbeiten, sondern auch die Welt, in der wir leben.“ Daher sei es unerlässlich, sich über die Zukunft Gedanken zu machen. Jeder trage Verantwortung und wisse, dass wir alle verantwortungsvoll und fair mit den Ressourcen und den Menschen umgehen müssen.

7. Teil: „Im Gespräch mit Jens Gröger vom Öko-Institut“

Im Gespräch mit Jens Gröger vom Öko-Institut

Energieeffizienz wird für die Betreiber von Rechenzentren zu einem immer wichtigeren Thema. Jens Gröger ist Senior Researcher beim Öko-Institut. Sein Forschungsschwerpunkt ist die Nachhaltigkeit von Produkten und Dienstleistungen der Informations- und Kommunikationstechnologie. Im Interview

erklärt er, wie sich Rechenzentren umweltfreundlicher betreiben lassen.

erklärt er, wie sich Rechenzentren umweltfreundlicher betreiben lassen.

com! professional: Herr Gröger, die Digitalisierung bringt einen immer höheren Energiebedarf mit sich, vor allem für den Betrieb von immer mehr und immer größeren Rechenzentren. Worin genau liegen die Probleme?

Jens Gröger: Die Entwicklung des Energieverbrauchs durch Rechenzentren ist deshalb beunruhigend, weil die Zunahme sehr schnell stattfindet und nicht durch Einsparungen an anderer Stelle aufgefangen wird. Prognosen gehen davon aus, dass sich der Energieverbrauch durch IT in den nächsten zehn Jahren mindestens verdoppelt, im ungünstigsten Fall sogar auf die Hälfte des weltweiten Energieverbrauchs ansteigt. Dieser Entwicklung kann nur durch hocheffiziente und nachhaltige Rechenzentren entgegengesteuert werden.

com! professional: Was macht ein nachhaltiges Rechenzentrum eigentlich aus? Ein möglichst geringer Strombedarf genügt nicht, oder?

Gröger: Nachhaltigkeit umfasst immer die drei Dimensionen Umwelt, Soziales und Wirtschaft. Ein nachhaltiges Rechenzentrum muss daher sowohl bei den unterschiedlichen Umweltwirkungen, wie Energie- und Ressourcenverbrauch, Treibhausgasemissionen oder Flächeninanspruchnahme Vorreiter sein als auch bei den sozialen Aspekten, wie faire Bezahlung, Qualifikation, Familienfreundlichkeit und Gleichberechtigung. Daneben muss ein nachhaltiges Rechenzentrum aber auch wirtschaftlich und damit langfristig betreibbar sein.

com! professional: Was kann man als Betreiber vor allem im Bereich der Energieeffizienz tun?

Gröger: Die Gebäudetechnik muss hocheffizient arbeiten, es dürfen keine klimaschädlichen Kältemittel eingesetzt werden und der Strom muss aus erneuerbaren Energiequellen stammen.

Die eigentliche IT-Technik, also Server, Datenspeicher und Netzwerktechnik, muss mit sehr verlustarmen Netzteilen ausgestattet sein und ihre Energieverbräuche müssen permanent überwacht werden.

Die eigentliche IT-Technik, also Server, Datenspeicher und Netzwerktechnik, muss mit sehr verlustarmen Netzteilen ausgestattet sein und ihre Energieverbräuche müssen permanent überwacht werden.

Um zur Ressourcenschonung beizutragen, wird außerdem eine hohe Auslastung der IT-Technik angestrebt. Rund die Hälfte der Ressourcen wird für die Herstellung der IT-Komponenten verwendet, die andere für deren Betrieb. Daher ist eine bessere Auslastung weniger Server aus Gründen der Nachhaltigkeit immer besser als das Vorhalten etlicher Server, die nur zu einem Bruchteil ausgelastet sind. Konsolidierung und Virtualisierung sind hier die Stichwörter.

com! professional: Wo lässt sich noch Energie einsparen?

Gröger: Bei der Klimatisierung, beispielsweise durch Nutzung freier Kühlung und Erhöhung der zulässigen Raumtemperaturen, liegen in Bestandsrechenzentren sicher noch große Einsparpotenziale. Gleiches gilt für die Stromversorgung und die Nutzung effizienter Netzteile. Die Nutzung der Abwärme ist zusätzlich eine attraktive Option, wenn die Wärme sinnvoll, etwa an Gewerbebetriebe, weitergegeben werden kann.

Die tatsächlichen Einsparmöglichkeiten sind aber sehr individuell. Grundsätzlich ist ein Rechenzentrumsbetreiber daher gut beraten, ein umfassendes Energiemonitoring einzuführen und geeignete Kennzahlen zu bilden, die die Effizienz der verschiedenen Teilbereiche beschreiben. Durch ein Energiemanagement können die Schwachstellen schnell identifiziert und die Betriebsführung optimiert werden.

com! professional: Solche Optimierungen betreffen aber häufig nur die Gebäudetechnik …

Gröger: Blinde Flecken bleiben tatsächlich die IT-Geräte selbst. Ob auf den Geräten nützliche Arbeit verrichtet wird oder ob es sich um Server oder Datenspeicher handelt, die einfach vergessen wurden, kann der Rechenzentrumsbetreiber in der Regel selbst nicht beantworten. Durch ein zusätzliches Monitoring der Rechenleistung, der Netzwerk- und Festplattenaktivität können jedoch auch hier Kennzahlen generiert werden, mit deren Hilfe die Performance optimiert werden kann.

com! professional: Gibt es eigentlich Zertifizierungen, die garantieren, dass genutzte Rechenzentrumsdienste aus einem energieeffizienten Rechenzentrum stammen?

Gröger: Bezogen auf einzelne Komponenten wie USV, Netzteile oder Datenspeicher gibt es Zertifikate wie den Energy Star, EPEAT oder herstellereigene Datenblätter zu Wirkungsgraden, die die Energieeffizienz bestätigen. Für ganze Rechenzentren und deren Dienstleistungen gibt es nur den Blauen Engel, der die Effizienz zuverlässig nachweist. Das Umweltzeichen ist in der Branche aber noch nicht flächendeckend angekommen. Bis es so weit ist, empfehle ich Unternehmen deshalb, den Beschaffungsleitfaden des Umweltbundesamtes anzuwenden. Der Leitfaden enthält alle Anforderungen an ein energieeffizientes Rechenzentrum.

Glasfasernetz

GlobalConnect stellt B2C-Geschäft in Deutschland ein

Der Glasfaseranbieter GlobalConnect will sich in Deutschland künftig auf das B2B- und das Carrier-Geschäft konzentrieren und stoppt die Gewinnung von Privatkunden mit Internet- und Telefonanschlüssen.

>>

Pilot-Features

Google Maps-Funktionen für nachhaltigeres Reisen

Google schafft zusätzliche Möglichkeiten, um umweltfreundlichere Fortbewegungsmittel zu fördern. Künftig werden auf Google Maps verstärkt ÖV- und Fußwege vorgeschlagen, wenn diese zeitlich vergleichbar mit einer Autofahrt sind.

>>

The Boring Phone

Bierbrauer Heineken verschenkt ein Anti-Smartphone

Da viele Menschen durch Smartphones von echten sozialen Aktivitäten abgelenkt werden, legen Heineken und Bodega 5.000 Exemplare eines einfachen Klapp-Handys als "The Boring Phone" auf.

>>

Vier Smartphones

Huawei stellt die neue Pura-Serie vor

"Pura" statt "P": Huawei hat zunächst für den chinesischen Markt seine neue Flaggschiff-Serie mit den Modellen Pura 70, Pura 70 Pro, Pura 70 Pro+ und Pura 70 Ultra vorgestellt.

>>