07.11.2018

Quantencomputer

1. Teil: „Rechen-Power der Zukunft schon heute simulieren“

Rechen-Power der Zukunft schon heute simulieren

Autor: com! professional

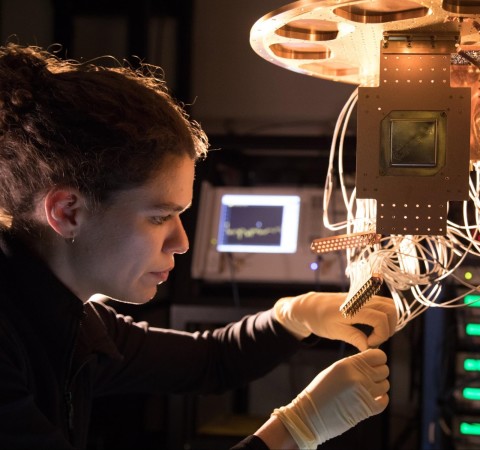

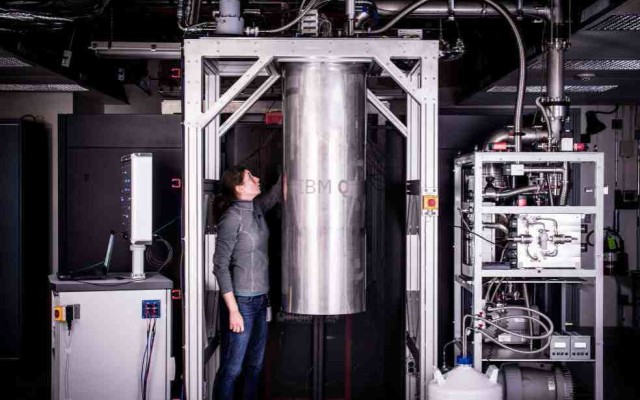

IBM (Quantenrechner Q in Kühlvorrichtung)

Quantencomputer sind dabei, den klassischen Supercomputern den Rang abzulaufen. Wie schnell und mit welcher Technologie sie jedoch die Praxis erobern, ist noch völlig offen.

Dieser Beitrag wurde erstellt von Philippe Duluc, CTO Big Data und Security beim französischen IT-Dienstleister Atos.

Es wird noch einige Zeit vergehen, bis die superschnellen Quantenrechner in Massenstückzahl bereitstehen. Supraleiter, Spin-Qubits, Ionenfallen oder die NISQ-Technologie - welche Systeme sich als Basis wohl durchsetzen werden? Fest steht: Simulationsplattformen werden den Weg zur Marktreife verkürzen, da sich mit ihnen kostengünstig ein wesentliches Manko angehen lässt. Zudem eignen sie sich, um an der quantensicheren Verschlüsselung zu arbeiten - ein weiteres Zukunftsthema.

Es wird noch einige Zeit vergehen, bis die superschnellen Quantenrechner in Massenstückzahl bereitstehen. Supraleiter, Spin-Qubits, Ionenfallen oder die NISQ-Technologie - welche Systeme sich als Basis wohl durchsetzen werden? Fest steht: Simulationsplattformen werden den Weg zur Marktreife verkürzen, da sich mit ihnen kostengünstig ein wesentliches Manko angehen lässt. Zudem eignen sie sich, um an der quantensicheren Verschlüsselung zu arbeiten - ein weiteres Zukunftsthema.

Mit Quantenrechnern, die 50 bis 100 Quantenbits, kurz Qubits, bereitstellen, können Forscher komplexe Analysen durchführen, die mit einem konventionellen Computer deutlich länger dauern würden. An diesem Punkt ist die sogenannte Quantum Supremacy erreicht, also die Überlegenheit der Quantensysteme. Herkömmliche Supercomputer arbeiten auch künftig die vielen Lösungswege einer variantenreichen Berechnung nacheinander ab.

Ein Quantensystem erledigt das parallel – und in Sekunden oder Millisekunden. Möglich macht den Rechenzauber ein Quantengatter, das die Qubits verschränkt und ihre Zustände von null, eins oder beliebig vielen dazwischen manipuliert. Auf die Weise lassen sich Qubits messen und in die gängigen Werte von null und eins übersetzen, die wiederum das Ergebnis darstellen. Wie das Gatter anzuwenden ist, legen spezielle Quantenalgorithmen fest.

Experten streiten, wann Quantencomputer den Markt in Massen erobern. Die Fachwelt geht mehrheitlich davon aus, dass es in fünf bis zehn Jahren so weit sein wird. Prototypen und erste kommerzielle Systeme erfüllen jedoch bereits heute das Kriterium Quantum Supremacy oder kommen dem sehr nahe. Anfang März stellte Google den Quantenprozessor Bristlecone vor, der mit 72 Qubit den bisherigen Spitzenwert markiert.

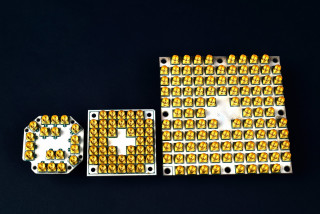

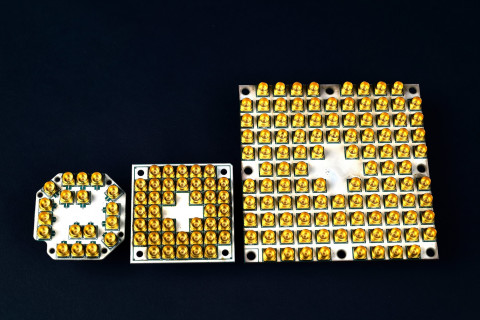

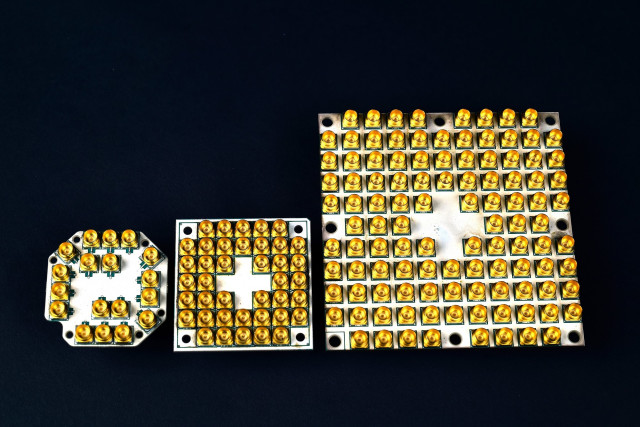

Zuvor hatte IBM im Januar auf der Consumer Electronics Show (CES) in Las Vegas einen Quantenrechner mit einer Leistung von 50 Qubit angekündigt. Ebenfalls auf der CES 2018 präsentierte Intel den Quantenprozessor Tangle Lake. Der Chip mit 49 Qubit basiert auf dem Supraleitungsprinzip. Er benötigt daher Umgebungen mit einer Temperatur nahe des absoluten Nullpunkts (– 273,15 °C oder 0 Grad Kelvin).

2. Teil: „Spin-Qubits und mehr“

Spin-Qubits und mehr

Bei einem Ansatz wie ihn Intel und Google verfolgen, sind in dem supraleitenden Mikrochip elektronische Schaltkreise integriert, die das Speichern der Qubits übernehmen. Das nötige Temperaturregime für den Supraleitungseffekt verlangt einen besonders aufwendigen und entsprechend kostspieligen Systemaufbau. Zusatzausstattung für den Erschütterungsschutz treibt den Anschaffungspreis weiter in die Höhe. Nach heutigem Stand muss ein Unternehmen eine zweistellige Millionensumme für ein solches Quantensystem investieren.

Fachleute von Intel, dem Commissariat à l’Énergie Atomique et aux Énergies Alternatives (CEA) und dem niederländischen Forschungszentrum QuTech arbeiten an einem alternativen Ansatz, den sogenannten Spin-Qubits. Sie werden mit Hilfe von Mikrowellenimpulsen erzeugt, die die Drehung eines Elektrons auf einem Siliziumsubstrat steuern. Diese Technologie funktioniert bereits bei 1 Grad Kelvin.

Das ist auf den ersten Blick kein sonderlich großer Fortschritt. Dennoch vereinfachen Spin-Qubits den Systemaufbau eines Quantenrechners. Hinzu kommen weitere Vorteile wie stärkere Kohärenz und geringere Größe. Dadurch ist es möglich, mehrere dieser Bits miteinander zu kombinieren, und das über einen längeren Zeitraum hinweg. Einen anderen Weg schlägt das Institut für Quantenoptik und Quanteninformation (IQOQI) der Universität Innsbruck ein. Es beschäftigt sich mit optischen Qubits und Ionenfallen. Diese Technologien können ebenfalls alternativ zu Supraleitern als Grundlage für Quantenrechner dienen.

Kostengünstiger Zugang

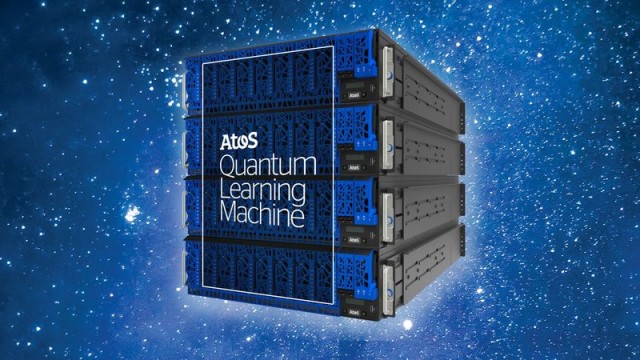

Die Investition in die Hardware ersparen Cloud-Plattformen. Diesen Zugang bietet etwa IBM für seinen Quantenrechner. Interessenten können über die Cloud-Plattform IBM Quantum Experience auf einen Quantencomputer der Reihe IBM Q zugreifen, der in einem IBM-Forschungslabor steht. Die zweite günstige Alternative sind Quantensimulatoren, zu denen auch die Atos QLM (Quantum Learning Machine) zählt, die

es in Appliances mit 30 bis 40 Qubits gibt. Anwender können 1 bis 24 Terabyte Arbeitsspeicher für das Simulieren eines Quantenrechners nutzen.

es in Appliances mit 30 bis 40 Qubits gibt. Anwender können 1 bis 24 Terabyte Arbeitsspeicher für das Simulieren eines Quantenrechners nutzen.

Das Fehlerproblem

Quantensysteme, egal ob sie nun den Supraleitereffekt oder das Ionenfallen-Prinzip nutzen, haben ein entscheidendes Manko: Bei ihnen greifen die klassischen Fehlerkorrekturverfahren nicht. Das liegt daran, dass sich Qubits nicht kopieren lassen. Das Kopieren von Zwischenergebnissen hat zwangsläufig die Zerstörung der Originaldaten zur Folge.

Supraleitende Quantenbits neigen dazu, plötzlich und unkontrolliert ihre Zustände zu ändern, wodurch Fehler entstehen. Google will Bristlecone zunächst dazu nutzen, um Fehlerkorrekturverfahren bei Quantenprozessoren zu analysieren und zu optimieren. Eine höhere Rechenleistung bei gleichzeitig mindestens ebenso niedrigen Fehlerraten wie bei herkömmlichen Supercomputern gilt als zentrales Ziel in der Entwicklung von Quantensystemen.

3. Teil: „Einfacherer Aufbau mit NISQ“

Einfacherer Aufbau mit NISQ

Bei der Entwicklung zeichnet sich noch ein weiterer Pfad ab. So könnte bis 2020 eine neue Generation von Quantenrechnern die Bühne betreten, die auf einer Technologie namens Noisy Intermediate-Scale Quantum (NISQ) basiert. Der Ansatz wurde von John Preskill eingeführt, einem Forscher am Institute for Quantum Information and Matter des California Institute of Technology (CalTech) in Pasadena (USA).

Er verzichtet auf komplexe Fehlerkorrekturverfahren, die bei anderen Quanten-Computing-Technologien zum Zuge kommen. Das wirkt sich positiv auf den Systemaufbau eines Quantencomputers aus: Dieser ist weniger komplex als bei einem Rechner mit ausgefeilten Error-Correction-Mechanismen.

Der Nachteil ist, dass ein NISQ-Quantencomputer wegen des höheren Rauschens (Noise) weniger präzise arbeitet. Dies lässt sich jedoch zumindest teilweise durch spezielle Quantenalgorithmen kompensieren, die weniger anfällig für dieses Rauschen sind.

Von der Theorie in die Praxis

Vorstellbar sind heute viele Einsatzfelder, in denen Quantenrechner und Simulatoren mit 40 Qubit oder mehr Verwendung finden. Dazu zählen die Quantenchemie und die Erforschung von kondensierter Materie. Auch die Analyse von komplexen chemischen Vorgängen, etwa den Reaktionen zwischen Molekülen, ist eine Domäne von Quantensystemen.

Zu den weiteren prädestinierten Anwendungsgebieten zählen die Künstliche Intelligenz sowie komplizierte Finanztransaktionen. Auch in der Industrie lassen sich Quantencomputer einsetzen, etwa bei der Analyse und Optimierung von Produktionsprozessen und vernetzten Fertigungsumgebungen.

Bei den Vorzeigeprojekten ragt Volkswagen heraus. Der Konzern setzt bereits Quantencomputer für eine Stauprognose in Peking ein. In die Verkehrssimulation fließen die Bewegungsdaten von 10.000 Taxis ein, deren Routen optimiert werden sollen. Das Beispiel führt vor Augen, welchen Nutzen Quantenrechner in der Praxis durch das schnelle Lösen von komplexen Aufgaben erzielen können. Allerdings muss man an dieser Stelle auch einschränken: Für einige der skizzierten Anwendungen reichen 50 oder 100 Qubit nicht aus. Diesen Anforderungen werden erst künftige Quantenrechner mit etwa 1000 Qubit und mehr gewachsen sein.

4. Teil: „Forscher im Simulationsmodus“

Forscher im Simulationsmodus

Momentan setzen daher vor allem zwei Anwendergruppen Quantencomputer ein: Forschungseinrichtungen, die Quantenalgorithmen entwickeln und testen, sowie Universitäten, die Studenten in Programmiersprachen für die neue Rechnergeneration ausbilden.

Zur ersten Kategorie zählt das Oak Ridge National Laboratory (ORNL) in Oak Ridge (US-Bundesstaat Tennessee). Bei der Entwicklung von Quantenalgorithmen und bei komplexen Simulationen greift das ORNL auf die Atos QLM zurück. Zudem kommt die Simulationsplattform beim Debuggen und Testen der Algorithmen zum Zuge. Dadurch sparen die Forscher Zeit und Geld. Erst nach Abschluss der Entwicklungsarbeiten und Tests führen die Fachleute des ORNL die Quantenalgorithmen auf einem Quantencomputer von IBM aus.

Ein weiteres Thema, mit dem sich das ORNL beschäftigt, sind Verschlüsselungstechniken, die Angriffen mit Quantenrechnern standhalten. Eine wichtige Rolle spielen dabei Verfahren zur Verteilung der Schlüssel (Quantum Key Distribution, QKD). Solche Technologien sind notwendig, um künftig den sicheren Informationsaustausch zu gewährleisten. Denn mit Quantenrechnern lassen sich in absehbarer Zeit gängige asymmetrische Verschlüsselungsverfahren wie RSA (Random Sequential Adsorption) und ECC (Elliptic Curve Cryptography) brechen.

Zwar werden Quantenrechner, die heute gebräuchliche Verschlüsselungsverfahren aushebeln können, frühestens in zehn Jahren verfügbar sein, dennoch ist es notwendig, schnellstmöglich eine standardisierte Post-Quantum-Verschlüsselung zu entwickeln. Der Grund ist, dass solche Verfahren auch in Systemen implementiert werden müssen, die eine lange Einsatzdauer von zehn oder zwanzig Jahren haben. Dazu gehören Kraftwerke, Industrieanlagen, Maschinen und IoT-Komponenten (Internet of Things). Je früher solche Systeme mit einer zukunftssicheren Datenverschlüsselung ausgestattet werden, desto geringer fällt später der Aufwand für das Nachrüsten aus.

Entwickeln und simulieren

Wie schnell Quantencomputer die Praxis erobern und mit welcher Technologie sie das tun, ist so offen wie spannend. NISQ-Systeme könnten nach Einschätzung von Forschern dazu beitragen, Quantenrechner einem breiteren Kreis von Nutzern zugänglich zu machen. Ebenso wie Simulationsplattformen beschleunigen solche Quantenrechner außerdem die Entwicklung von Quantenalgorithmen und entsprechenden Applikationen.

Gerade Appliances für das Simulieren helfen, schneller als bisher Algorithmen, Programmiertechniken und Entwicklungs-Tools für Quantenrechner hervorzubringen. Ohne sie ist auch die beste Hardware nichts wert. Mit Simulationsplattformen lässt sich die logische Grundlage dafür schaffen, dass Anwendungen für Big Data, Künstliche Intelligenz und IT-Sicherheit auf Quantencomputern laufen. Dennoch sollten parallel dazu die Arbeiten an Quantensystemen mit Quantengittern forciert werden, die niedrige Fehlerraten aufweisen.

Letzte Hürde genommen

USB-C kommt als einheitlicher Ladestandard

Nach dem Bundestag hat auch der Bundesrat einer EU-Richtlinie zugestimmt, die USB-C als einheitlichen Anschluss zum Laden von Elektrogeräten festlegt.

>>

Autohersteller

Erstes Smartphone von Polestar

Autohersteller Polestar hat in China sein erstes Smartphone vorgestellt, das vor allem gut mit den Fahrzeugen des Herstellers zusammenarbeiten soll.

>>

10 Stationen

1.500 Händler bei der AVM-Roadshow

Der Fokus der Solution Tour 2024 von AVM lag auf den Themen Glasfaser, Wi-Fi 7 und Smart Home, und mehr als 1.500 Handelspartner folgten der Einladung des Herstellers an die insgesamt 10 Standorte in Deutschland.

>>

Ohne Nokia

HMD zeigt erste Smartphones mit der eigenen Marke

Mit den drei neuen Pulse-Modellen bringt HMD seine ersten Smartphones auf den Markt, die nicht mehr unter der Lizenz von Nokia vermarktet werden.

>>