12.06.2019

Effizienz und Sicherheit

1. Teil: „Management per KI erobert das Rechenzentrum“

Management per KI erobert das Rechenzentrum

Gorodenkoff / shutterstock.com

KI macht Rechenzentren zuverlässiger und wirtschaftlicher. Durch wachsende Komplexität entziehen sich die Zentren ohnehin oft dem menschlichen Fassungsvermögen.

Mechanische Teile geben mitunter ungewöhnliche Geräusche von sich, lange bevor sie ihren Geist aufgeben. Ein Brummen oder Klicken ist bei vielen IT-Komponenten ein frühes Anzeichen drohender Betriebsausfälle. Vor allem in Rechenzentren haben solche Ausfälle meist teure Konsequenzen. Kommen zum Beispiel einige Lüfter der Hauptkühlanlage zum Stillstand, dann kann als Folge durchaus der eine oder andere Server-Raum ausfallen. Bei einem Stromausfall und einem zusätzlichen Versagen des Stromgenerators liegt möglicherweise die ganze Anlage lahm. Die gute Nachricht: Mit Hilfe von Künstlicher Intelligenz (KI) muss es gar nicht erst so weit kommen.

Anomalien am Klang erkennen

Der Co-Location-Betreiber Root Data Center aus Montreal zum Beispiel hat in Zusammenarbeit mit dem Start-up Litbit aus dem kalifornischen San José eine KI-basierte Lösung namens Dac zur Überwachung der Notstromgeneratoren entwickelt: einen KI-Agenten für die klangbasierte Anomalie-Erkennung.

Dac erkennt seinen Erfindern zufolge Anomalien der Betriebsbedingungen bei beliebigen Belastungsstufen der betreffenden Geräte anhand ihrer Klang- und Vibrationsmuster. Die Ultraschall-Hörfähigkeiten von Dac sollen eine 10-fach höhere Frequenz abdecken als die des menschlichen Gehörs und dank dieser Fähigkeit Funktionsprobleme mit Geräten im gesamten Rechenzentrum aufzeigen können. Dac soll beispielsweise das Geräusch fehlerhafter Netzteile und problematische Schwingungsmuster in Racks erkennen. Und mit seiner Infrarotkamera soll das System auch losen elektrischen Anschlüssen oder austretendem Wasser auf die Spur kommen.

Die Dac-Anwendung ist laut Root Data Center darüber hinaus in der Lage, die Parameter der Kühlsysteme bedarfsgerecht und in Echtzeit gemäß den Wetterbedingungen einzustellen und das

Kapazitätsmanagement von Systemen im gesamten Rechenzentrum zu koordinieren. Das KI-System analysiert hierzu Hunderttausende von Datenpunkten pro Sekunde.

„Wir haben ein Mikrofon in das Generatorgehäuse eingebaut, das die Geräusche möglicher mechanischer Probleme mitschneidet“, erklärt AJ Byers, der Geschäftsführer von Root. Die KI-Technologie von Litbit analysiert anschließend den Ton und das Infrarot-Video, um mögliche Diskrepanzen vom Sollzustand zu erkennen. „Das System kann ein Quietschen oder Klopfen hören oder ein Kugellager aufspüren, das nicht mehr funktioniert.“ Bei Abweichungen sendet es eine Benachrichtigung an das Network Operations Center des Hosters.

Um eine Vorstellung vom Sinn und Zweck von Dac zu vermitteln, vergleicht AJ Byers die darin zum Einsatz kommende klangbasierte Anomalie-Erkennung mit der VESDA-Technologie (Very Early Smoke Detection Apparatus), die von Xtralis, einer Tochter des Honeywell-Konzerns, vermarktet wird. VESDA misst die Luftqualität mit Lasern und kann Rauch eines Brandes erkennen, bevor er für das menschliche Auge sichtbar ist.

2. Teil: „Von DCIM zu DMaaS“

Von DCIM zu DMaaS

Wenn es darum geht, ein Rechenzentrum am Laufen zu halten, dann setzen sehr viele Unternehmen mittlerweile auf ein sogenanntes DCIM-System. Dieses Data Center Infrastructure Management überwacht

sämtliche Gebäudekomponenten eines Rechenzentrums samt der IT - von Stromverteilern und Kühlgeräten, Gebäudeautomations- und Steuerungssystemen über Server, Storage, Vernetzung bis hin zu Lifecycle-Services und Schutz des Geländes. Ungefähr jedes zweite Rechenzentrum hat heute ein solches DCIM-System im Einsatz, fand das Uptime Institute in seiner globalen Rechenzentrumsumfrage 2018 heraus. Jedes zehnte Unternehmen hat der Studie zufolge sein DCIM-System sogar in Eigenregie entwickelt.

Insgesamt werten zwar drei von vier Nutzern einer DCIM-Lösung die Implementierung in ihrem Unternehmen als Erfolg, umgekehrt bedeutet das aber auch, dass in jedem vierten Rechenzentren das eingesetzte DCIM-System nicht zur vollen Zufriedenheit gearbeitet hat. Kein Wunder, dass nahezu jeder zweite Rechenzentrumsbetreiber seine DCIM-Lösung kontinuierlich um neue Tools ergänzt - so wie das Unternehmen Root Data Center zusätzlich die KI-Lösung von Litbit verwendet.

Doch ganz so einfach ist es mit den Erweiterungen einer DCIM-Lösung nicht: Die befragten Rechenzentren haben ihre größten Effizienzsteigerungen im Hinblick auf das Management der Infrastruktur bereits vor fünf Jahren realisiert, wie das Uptime Institute in seiner Studie feststellt. Weitere Verbesserungen würden demnach „erhebliche Investitionen und Anstrengungen mit zunehmend sinkenden Renditen“ erforderlich machen. Und dennoch sind Rechenzentrumsbetreiber laut Uptime Institute auch künftig bestrebt, die betriebliche Effizienz ihrer Rechenzentren zu steigern, sei es, um die Betriebskosten zu senken, sei es, um die Energiedichte zu steigern.

René Pronovost, Betriebsdirektor bei Maya Heat Transfer Technologies, einem Siemens-Partner, bringt deshalb Künstliche Intelligenz für die Verbesserung der DCIM-Leistung ins Spiel, betont aber zugleich: Dafür müssen die Daten etwas taugen.

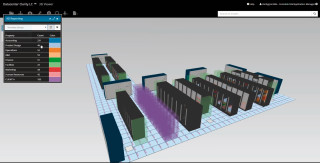

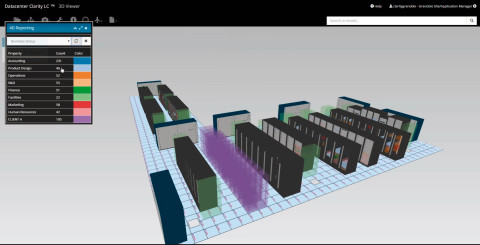

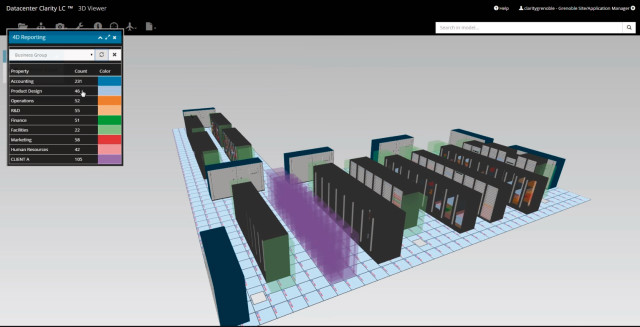

Siemens selbst bietet das DCIM-System Datacenter Clarity LC von Maya Heat Transfer Technologies als Teil seiner Integrated Data Center Management Suite (IDCMS) an. Die Lösung kombiniert Metriken der Sensorik einzelner Subsysteme einschließlich des Energie- und Gebäudemanagements - zum Beispiel Brandschutzanlagen und Kühlsysteme - mit Messwerten aus den IT-Räumen, von Server-Schränken über Datenspeichersysteme bis hin zur Netzwerk-Hardware. Dank dieser Echtzeit-Messwerte kann das DCIM-System die Künstliche Intelligenz nutzen, um granulare Optimierungen des Energiehaushalts vorzunehmen.

Steven Carlini, dem Vize-Präsidenten für Innovation und Data-Center bei Schneider Electric, sind die Herausforderungen der Anknüpfung eines Rechenzentrums an ein KI-Backend nur zu gut bekannt. In Rechenzentren gebe es „tonnenweise“ Anbindungspunkte der Stromversorgungs- und Kühlsysteme, bei denen zeitnahe Mitteilungen über kritische Ereignisse bisher immer noch nicht der Regelfall sind. Viel zu oft müssten sich Rechenzentrumsbetreiber auf althergebrachte Gebäudeverwaltungssysteme verlassen, die keine Daten bereitstellen oder keine Fernwartung unterstützen.

Ein Mix aus Altlasten-Kommunikationsprotokollen gilt als Hauptursache dafür, dass Künstliche Intelligenz aufseiten der Gebäudetechnik den IT-Systemen um Längen hinterherhinkt.

3. Teil: „Lernen aus den Daten anderer“

Lernen aus den Daten anderer

Dennoch gilt: Althergebrachte DCIM-Lösungen haben im Hinblick auf Effizienzoptimierungen längst das Ende der Fahnenstange erreicht, glauben die Analysten vom Uptime Institute. Deshalb müssten Rechenzentrumsbetreiber auch immer tiefer in die Trickkiste greifen, um hier noch etwas herauszuholen.

Nicht zuletzt Konzepte wie KI-gestütztes DMaaS (Data Center Management as a Service) versprechen Abhilfe. Bei einem DMaaS handelt es sich um einen Cloud-Dienst zur Fernüberwachung aggregierter Sensordaten aus mehreren Data-Centern mit Hilfe von Techniken der Künstlichen Intelligenz. Doch der erfolgreiche Einsatz von KI setzt auch in diesem Fall hinreichend abwechslungsreiche und zuverlässige Trainingsdaten voraus.

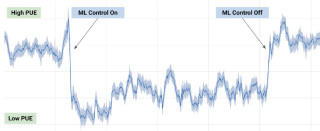

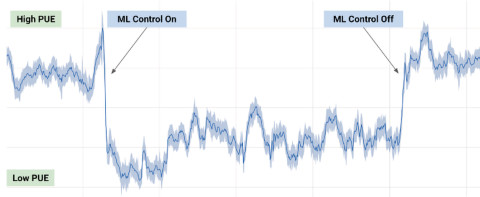

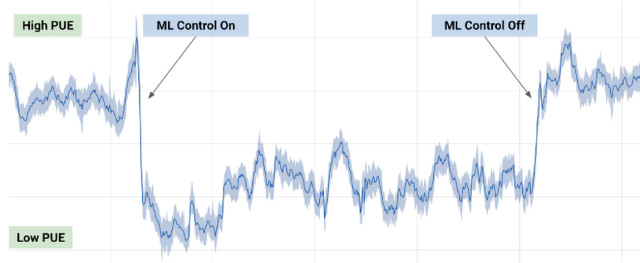

Hyperscalern wie Google oder Facebook fehlt es nicht an solchen Sensordaten. So hat beispielsweise Google ein künstliches neuronales Netzwerk entwickelt, mit dem der Cloud-Riese die erforderliche Kühlleistung um bis zu 40 Prozent und den Gesamtenergieverbrauch um 15 Prozent reduzieren konnte. Eine verbesserte, vollständig automatisierte Variante des KI-Systems soll den Energiebedarf eines Rechenzentrums sogar um bis zu 30 Prozent senken. Auch bei seinen Windparks spart Google dank KI kräftig: „Maschinelles Lernen hat die Effizienz unserer Windenergie bis heute gegenüber dem Basisszenario um rund 20 Prozent erhöht“, freut sich Google-Geschäftsführer Sundar Pichai.

Kleinere Rechenzentren können von solchen autarken KI-Systemen bisher jedoch nur träumen. Sogar dort, wo Echtzeitdaten vorhanden sind, liegen in der Regel nicht genügend viele Konfigurationsvarianten vor, um ein Deep Learning und damit weitreichende Optimierungen zu ermöglichen.

Das Problem: Im traditionellen DCIM-Modell läuft die Management-Software lokal am jeweiligen Rechenzentrumsstandort und sieht in der Regel keinerlei Möglichkeiten einer standortübergreifenden Synchronisierung vor. Die Erkenntnisse lassen sich aus diesem Grund weder direkt auf andere Rechenzentren übertragen noch lassen sich die Benchmarks verschiedener Betriebsumgebungen sinnvoll miteinander vergleichen.

Hier schafft das erwähnte DMaaS vielerorts Abhilfe. Es ermöglicht maschinelles Lernen durch die Verarbeitung großer Datenmengen. Nur so sind die erzielbaren Resultate selbstlernender Algorithmen statistisch aussagekräftig. Je mehr Daten aus verschiedenen Arten von Rechenzentren in die Analyse einfließen, desto intelligenter wird das DMaaS-System.

EcoStruxure IT beispielsweise, der DMaaS-Dienst von Schneider Electric, verarbeitet Messwerte aus den Rechenzentren von mehr als 500 Kunden mit 2,2 Millionen Sensoren. Eine große Vielfalt an unterschiedlichen Betriebsumgebungen erlaubt es dem Dienst, sinnvolle Handlungsempfehlungen zu geben.

Die Hauptaufgabe eines DMaaS-Dienstes bestehe darin, „Infrastrukturausfälle und andere unliebsame Ereignisse vorherzusagen und zu verhindern sowie Ineffizienzen oder Kapazitätsengpässe zu erkennen“, erläutert Rhonda Ascierto, Vizepräsidentin für Forschung beim Uptime Institute und Forschungsdirektorin für Rechenzentren und kritische Infrastrukturen bei 451 Research.

„Basierend auf anderen Maschinen, die in ähnlichen Umgebungen mit ähnlicher Auslastung, ähnlichem Alter und ähnlichen Komponenten arbeiten, kann die KI voraussagen, dass dies oder jenes schiefgehen wird“, erklärt Rhonda Ascierto. DCIM als Cloud-Service könne das Risiko von Rechenzentrumsausfällen verringern und gleichzeitig neue Effizienzsteigerungen, bessere Kapazitätsprognosen und eine verbesserte geschäftliche Flexibilität zutage fördern, so die Analystin.

Das Uptime Institute empfiehlt Unternehmen, sich auf den Gesamtenergieverbrauch ihrer hybriden IT im Kontext der anfallenden IT-Last zu konzentrieren statt „nur“ auf die Minimierung lokal auftretender mechanischer und elektrischer Verluste. DMaaS scheint der hierfür geeignete Weg zu sein. Denn im Gegensatz zu DCIM können geeignete DMaaS-Lösungen den Entscheidungsträgern einen Blick auf die gesamte IT-Infrastruktur des Unternehmens gewähren.

DMaaS-Systeme bieten zudem häufig erweiterte Serviceverträge zur Wartung und Reparatur und andere Mehrwertdienste an. Managed-Service-Partner (MSPs) bekämen so eine Möglichkeit, innovative Dienste rund um die verschiedenen Funktionsbereiche eines Rechenzentrums - vom Energiemanagement bis hin zur proaktiven Wartung - zu entwickeln und in das Ökosystem des DMaaS-Anbieters miteinzubinden.

So besteht für den Betreiber eines Rechenzentrums zum Beispiel die Möglichkeit, das eigene Team um spezialisiertes Know-how externer Experten bedarfsgerecht zu erweitern.Das löst zumindest zu einem Teil auch das Problem des Fachkräftemangels. Laut der Umfrage des Uptime Institutes stoßen rund 40 Prozent der Betreiber von Rechenzentren auf Schwierigkeiten bei der Suche nach qualifizierten Kandidaten für offene Stellen.

4. Teil: „KI wird zur Pflicht“

KI wird zur Pflicht

Die Analysten von Gartner prognostizieren, dass bis 2020 jedes dritte Rechenzentrum, das keine Künstliche Intelligenz erfolgreich nutzt, seine „operative und wirtschaftliche Wettbewerbsfähigkeit verlieren“ werde. Analyst Dave Cappuccio schätzt, dass im Jahr 2025 acht von zehn Unternehmen ihre traditionellen Rechenzentren ohne KI außer Betrieb gesetzt haben werden.

Es stellt sich allerdings die Frage, ob dieser Trend auch langfristig anhält. Beim Einsatz weitgehend einheitlicher KI-Systeme dürften sich die operativen Parameter von Rechenzentren branchenweit einpendeln. Rechenzentrumsbetreibern dürfte es dann immer schwerer fallen, mit nennenswerten Effizienzvorteilen gegenüber ihren Mitbewerbern zu trumpfen. Und genau wie beim klassischen DCIM dürfte der betriebswirtschaftliche Erfolg eines Data-Centers auch im KI-Zeitalter vor allem eine Frage der optimalen Managementprozesse darstellen.

KI gegen KI

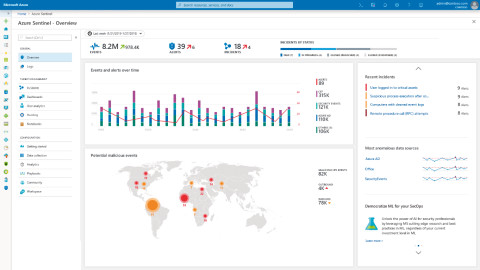

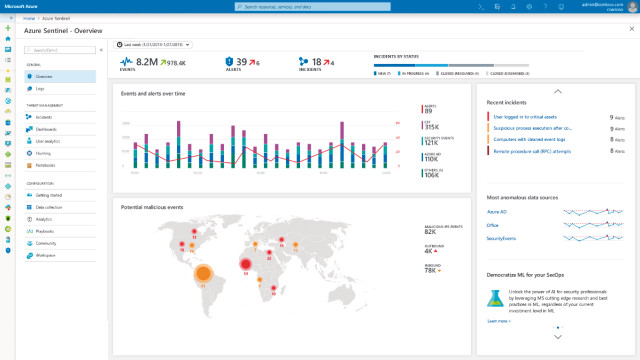

Der Einsatz von Künstlicher Intelligenz im Rechenzentrum soll jedoch nicht allein die Gebäude und die Server-Hardware am Laufen halten, sie soll nicht zuletzt auch vor Cyberangriffen schützen, die wiederum selbst bald per Künstlicher Intelligenz daherkommen werden.

IBM-Forscher warnen: Malware wird in naher Zukunft KI-gestützt ihr Unwesen treiben - gesteuert durch lernfähige Algorithmen. Einfache Formen von bösartiger KI tauchten bereits vereinzelt auf. Die sogenannten Transformers, eine neuartige Malware-Variante, sind etwa in der Lage, ihren Code automatisch auf das Betriebssystem zu portieren - Schad-Software könnte so im Rechenzentrum von Server zur Server springen.

Konventionelle Tools für Cybersicherheit können bösartiger KI bei Weitem nicht das Wasser reichen. Viele Sicherheitsforscher fordern daher die Entwicklung einer sogenannten Security Fabric, eines KI-gestützten, lernenden Systems der kontinuierlichen Ereignisüberwachung der gesamten IT-Infrastruktur eines Unternehmens.

Einer der Vorreiter beim Einsatz von maschinellem Lernen zur Cyberabwehr ist Siemens. In seinem Hochsicherheits-Rechenzentrum Eagle, dem „Fort Knox“ Münchens, nutzt der Konzern schon seit rund fünf Jahren die Big-Data-Plattform Splunk des gleichnamigen Anbieters. Das Team von Eagle habe das „Rechenzentrum mit Splunk vollumfänglich abdecken“ wollen, erklärt Siemens-Sicherheitsexperte Oliver Kollenberg. „Wir haben in der Zwischenzeit eine ganz respektable Größe erreicht, wo wir diesem Ziel recht nahegekommen sind“, so Kollenberg weiter.

Zu den Hauptaufgaben der Splunk-Installation von Eagle zählt neben dem Betriebs-Monitoring vor allem die Erkennung von Advanced Persistent Threats (APTs, fortgeschrittene, andauernde Bedrohungen). Splunk wertet hierfür rund 210 Datentypen aus 3.200 Datenquellen aus.

Fazit

Die wachsende Komplexität des Data-Center-Managements entzieht sich langsam dem menschlichen Fassungsvermögen. Für das einst unvermeidliche „Bauchgefühl“ bleibt auch auf diesem IT-Feld kaum noch Raum. Wo deterministische Regeln versagen, tritt zunehmend Künstliche Intelligenz auf den Plan. Das Potenzial scheint enorm zu sein, doch die Lernkurve der Pioniere ist steil.

Beim Management von Rechenzentren mit Künstlicher Intelligenz geht es in absehbarer Zukunft um den Weg der kleinen Schritte. Das Rennen um die besten KI-gestützten Lösungen für das Management der IT-Infrastruktur hat gerade erst begonnen.

Galaxy AI

Samsung bringt KI auf weitere Smartphones und Tablets

Einige weitere, ältere Smartphone- und Tablet-Modelle von Samsung können mit einem Systemupdate jetzt die KI-Funktionen von Galaxy AI nutzen.

>>

Pilot-Features

Google Maps-Funktionen für nachhaltigeres Reisen

Google schafft zusätzliche Möglichkeiten, um umweltfreundlichere Fortbewegungsmittel zu fördern. Künftig werden auf Google Maps verstärkt ÖV- und Fußwege vorgeschlagen, wenn diese zeitlich vergleichbar mit einer Autofahrt sind.

>>

The Boring Phone

Bierbrauer Heineken verschenkt ein Anti-Smartphone

Da viele Menschen durch Smartphones von echten sozialen Aktivitäten abgelenkt werden, legen Heineken und Bodega 5.000 Exemplare eines einfachen Klapp-Handys als "The Boring Phone" auf.

>>

Vier Smartphones

Huawei stellt die neue Pura-Serie vor

"Pura" statt "P": Huawei hat zunächst für den chinesischen Markt seine neue Flaggschiff-Serie mit den Modellen Pura 70, Pura 70 Pro, Pura 70 Pro+ und Pura 70 Ultra vorgestellt.

>>