25.04.2019

Essen per Abo

1. Teil: „Machine Learning hat ein großes Potenzial“

Machine Learning hat ein großes Potenzial

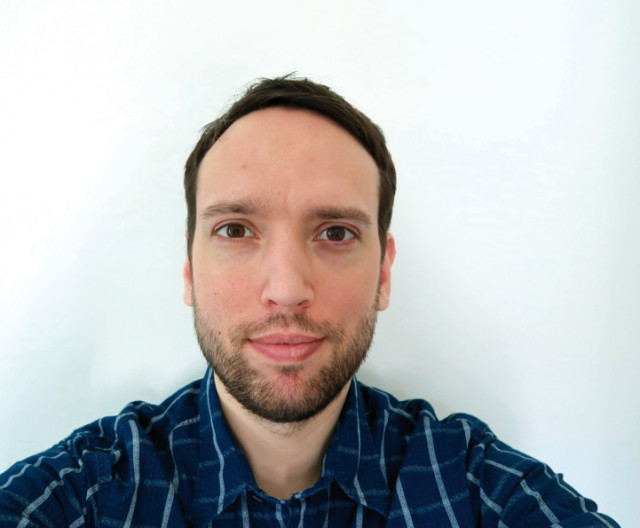

Autor: Konstantin Pfliegl

whiteMocca / shutterstock.com

Kai von Grambusch vom Kochbox-Versender HelloFresh erklärt die Bedeutung von Big Data. Aber auch Machine Learning kommt zum Einsatz, um optimal planen zu können.

Das Berliner Unternehmen HelloFresh wurde 2011 gegründet und bietet Kochboxen im Abonnement an. Verbraucher erhalten damit einmal pro Woche ein Paket mit mehreren Rezepten und den dazugehörigen fertig abgewogenen Zutaten.

Kai von Grambusch, Director Data & Analytics beim Kochbox-Versender HelloFresh, erläutert im Interview, weshalb Daten für das Unternehmen eine bedeutende Rolle spielen und wie die vielen anfallenden Daten bei HelloFresh verarbeitet werden.

com! professional: Herr von Grambusch, das Konzept von HelloFresh ist eigentlich recht einfach: Kunden bestellen sich eine Kochbox, wählen die Gerichte aus, die sie gerne hätten - und Sie liefern. Wie helfen Ihnen Daten, die Kundenbindung zu verbessern?

Kai von Grambusch: Daten helfen uns zum einen, besser zu verstehen, was unsere Kunden mögen. Welche Rezepte kommen gut bei Kunden an? Wie müssen Rezepte kombiniert werden, damit Kunden jede Woche eine Box bestellen?

Daten helfen uns außerdem dabei, zu verstehen, wie sich Kunden auf unserer Webseite zurechtfinden und wie sehr sie bestimmte Funktionen nutzen. Dazu gehört zum Beispiel, wie schnell Neukunden verstehen, wie sie Rezepte jede Woche selbst auswählen können oder wie sie die Anzahl der Mahlzeiten bestimmen können.

com! professional: Es geht beim Thema Daten also hauptsächlich um die Kundeninteraktion …

Von Grambusch: Die Daten helfen uns auch, die Prozesse in unserer Logistik zu optimieren. Anhand von diversen Prognosen und Hochrechnungen können wir vorab bestimmen, wie viele Zutaten für die Rezepte wir für die kommende Woche bestellen müssen, um den Bedarf zu decken. Gleichzeitig geht es auch darum, das Risiko zu minimieren, zu viele Zutaten zu kaufen.

com! professional: Sie setzen für Ihre Daten seit Kurzem auf ein Data Warehouse beim kalifornischen Anbieter Cloudera, auf Basis von Apache Hadoop. Was war der Anlass, sich nach einem neuen Data Warehouse umzusehen, und wo lagen Ihre Daten bisher?

Von Grambusch: Vor Cloudera haben wir mit einer anderen Hadoop-Distribution gearbeitet. Wir waren mit der Hadoop-Technologie an sich zufrieden, sahen bei Cloudera aber einige Vorteile.

Zum einen können wir durch Cloudera immer auf dem neuesten Stand der Hadoop-Technologien bleiben. Gerade Impala, ein Apache-Projekt für schnelle SQL-Abfragen, wird stetig weiterentwickelt und bei uns viel genutzt.

Hinzu kommt: Cloudera bietet die für uns beste Verwaltung des Clusters sowie umfassende Support-Möglichkeiten.

2. Teil: „Anbieterauswahl erst nach ausführlicher Sondierung“

Anbieterauswahl erst nach ausführlicher Sondierung

com! professional: Sie haben sich sicher eine Menge Anbieter angesehen. Wie verlief der Auswahlprozess und warum haben Sie sich letztendlich für Cloudera entschieden?

Von Grambusch: Wir haben verschiedene Punkte definiert, die uns wichtig sind. Dazu gehört unter anderem das leichte Management des Hadoop-Clusters durch eine Weboberfläche wie den Cloudera

Manager. Außerdem haben wir darauf geachtet, dass die von uns genutzten Services in den neuesten Versionen bereitstehen und Upgrades des Clusters leicht durchgeführt werden können. Auch automatische Backups und Support waren uns wichtig.

com! professional: Schauen wir mal ein wenig in die Praxis: Wie funktioniert die Datenanalyse bei HelloFresh in der täglichen Arbeit?

Von Grambusch: Wir haben ein Team von zwölf Data Engineers und zwei Product Ownern, die sich um die Infrastruktur des Data Warehouse sowie unsere ETL-Prozesse (Extract, Transform, Load) und Endnutzer-Tools kümmern. Sie sorgen dafür, dass alle relevanten Daten im Unternehmen in unser Hadoop-Cluster fließen und dort so strukturiert und transformiert werden, dass sie von unseren Kollegen optimal genutzt werden können.

com! professional: Und wie viele Mitarbeiter greifen bei Ihnen auf die Daten zu?

Von Grambusch: Derzeit gibt es etwa 150 Personen bei HelloFresh, die als Analysten oder Data Scientists täglich intensiv mit unseren Daten im Data Warehouse arbeiten. Dabei werden unsere Daten größtenteils via SQL analysiert, mit der Visualisierungs-Software Tableau zu Dashboards und Reports verarbeitet oder in Data-Science-Modelle geladen.

com! professional: Von welchen Datenmengen sprechen wir eigentlich?

Von Grambusch: Wir transferieren im Monat etwa 50 TByte an Daten für HelloFresh. Allerdings ist für den Großteil unserer Nutzer nur ein kleiner Teil dieser Daten relevant. Derzeit lagern wir etwa 20 TByte an Daten direkt auf unserem Hadoop-Cluster.

3. Teil: „Die Rolle von KI und Machine Learning“

Die Rolle von KI und Machine Learning

com! professional: Welche Rolle spielen bei Ihnen Technologien wie Machine Learning und Künstliche Intelligenz? Setzen Sie diese bereits ein, und falls ja, in welchen Bereichen?

Von Grambusch: Gerade Machine Learning ist ein Bereich, den wir in den vergangenen Jahren skaliert haben und in dem wir noch großes Potenzial sehen. Wir nutzen Machine-Learning-Modelle beispielsweise, um vorherzusagen, wie viele Zutaten wir bestellen müssen, um die Bestellungen unserer Kunden zu decken.

Das ist natürlich besonders wichtig für HelloFresh, da Lebensmittel Waren sind, die wir nicht lange lagern können. Je genauer wir deshalb den Bedarf an Zutaten vorhersagen können, desto weniger müssen wir Zutaten kurzfristig nachkaufen.

com! professional: Kommen wir noch einmal auf Ihren Data-Warehouse-Wechsel zurück. Wie verlief die Implementierung Ihrer vorhandenen Daten in das neue Data Warehouse von Cloudera? Wie lange dauerte der Umstellungsprozess - in der Planung und in der Praxis?

Von Grambusch: Nachdem wir uns für einen Wechsel zu Cloudera entschieden hatten, verlief der Migrationsprozess reibungslos. Da wir ein großes Live-System migrieren mussten, war es aber natürlich wichtig, dass wir vorsichtig vorgehen und alles genau testen.

Zunächst haben wir über zwei Wochen hinweg die neue Infrastruktur geplant. Dann haben wir über einen Zeitraum von drei Wochen die Infrastruktur komplett mit dem Automatisierungswerkzeug Ansible automatisiert und konfiguriert. Ebenso haben wir alle sonstigen Dienste, die wir nutzen, aufgesetzt, zum Beispiel das Workflow-Management-Tool Airflow.

com! professional: Und dann liefen das alte und das neue System eine Zeit lang parallel?

Von Grambusch: Genau. Sobald alles einsatzbereit war, haben wir angefangen, alle unsere Datenprozesse parallel zu unserem alten Cluster auch auf unserem neuen Cloudera-Cluster laufen zu lassen.

Das hat uns ermöglicht, zu gewährleisten, dass alles auf dem neuen Cluster funktioniert. Außerdem half uns das, etwaige Probleme zu finden, bevor wir Nutzer auf unser neues Cluster umleiten. Nachdem wir sichergestellt hatten, dass auf dem neuen Cluster alles reibungslos läuft, haben wir angefangen, erste Nutzer auf unser neues Cluster umzuleiten, um zu sehen, ob alles unter hoher Auslastung weiterhin funktioniert.

Über einen Zeitraum von zwei Wochen haben wir schließlich 100 Prozent der Nutzer von unserem alten Cluster auf das neue migriert und das alte Cluster nach ein paar weiteren Wochen abgeschaltet.

4. Teil: „Problemloser Anbieterwechsel“

Problemloser Anbieterwechsel

com! professional: Unternehmen reden zwar nicht gerne darüber - aber wo hakte es bei der Umstellung?

Von Grambusch: Es lief alles ziemlich gut. Dadurch dass wir schon viel Erfahrung mit Hadoop hatten und parallel an dem neuen Cluster arbeiten konnten, gab es keine größeren Probleme.

Geholfen hat uns dabei die Automatisierung, wodurch wir, wenn mal etwas schiefging, das Cluster schnell wieder neu generieren konnten. Ein nützliches Tool war hier der Kafka Mirror Maker, der es uns erlaubte, Events zu replizieren.

com! professional: Wie sind Ihre bisherigen Erfahrungen? Hat sich die Umstellung gelohnt? Wo liegen die Vor- und Nachteile gegenüber Ihrer früheren Lösung?

Von Grambusch: Wir sind glücklich darüber, dass die Releases von Cloudera uns immer aktuelle Versionen der integrierten Dienste wie Impala bereitstellen. Auch das grundsätzliche Management des Hadoop-Clusters dank Tools wie dem Cloudera Manager gefällt uns gut.

com! professional: Für die eigentliche Datenanalyse - BI und Analytics - setzen Sie auf Tools von Tableau. Können Sie uns skizzieren, wie Ihre Datenanalyse-Plattform heute aufgebaut ist? Welche Tools und Standards nutzen Sie?

Von Grambusch: Für die Data Ingestion, also das Verfügbarmachen der Daten, benutzen wir hauptsächlich Apache Kafka oder unsere eigenen Konnektoren. Anschließend werden die Daten entweder durch mit Airflow gesteuerte Spark-Batch-Jobs transformiert und als Parquet-Files (ein Hadoop-Speicherformat) in unserem Hadoop Distributed File System (HDFS) gespeichert oder via Spark-Streaming-Jobs in den Datenspeicher Apache Kudu geladen.

Die Daten werden dann von unseren internen Nutzern größtenteils via SQL über Impala konsumiert. Für die Endnutzer stellen wir Alation als Dokumentations- und Query-Plattform zur Verfügung und Tableau zur Datenvisualisierung und fürs Reporting.

com! professional: Vor allem im Rahmen der Cloud-Nutzung spielt der Datenschutz eine große Rolle. Ihre Daten liegen auf den Amazon Web Services. Darunter sind ja bestimmt auch die ein oder anderen Kundendaten? Wie stellen Sie sicher, dass Kundendaten der europäischen Datenschutz-Grundverordnung gemäß verarbeitet werden?

Von Grambusch: Die Sicherheit der Daten steht für uns selbstverständlich an oberster Stelle. Wir behandeln die uns zur Verfügung stehenden Daten DSGVO-konform.

Um zu gewährleisten, dass die Daten auch dementsprechend verarbeitet werden können, haben wir Prozesse eingeführt, die zum Beispiel sicherstellen, dass personenbezogene Daten im Data Warehouse leicht gelöscht werden können.

com! professional: Blicken wir zum Schluss noch in die nähere Zukunft: Welche weiteren Veränderungen sind bei HelloFresh in Bezug auf die IT für die nächste Zeit geplant?

Von Grambusch: Ein großes Thema für uns ist, dass wir die Verarbeitung von Daten in unserer gesamten IT-Abteilung, also nicht nur im Data Warehouse, moderner und zuverlässiger gestalten wollen.

Dazu arbeiten wir zum Beispiel daran, Apache Kafka als Standard für alle unsere Events zu nutzen und firmenweite Standards und Best Practices festzulegen.

Auch arbeiten wir an Möglichkeiten, es für Endnutzer einfacher zu machen, die Ressourcen unseres Clusters zu nutzen, indem sie beispielsweise größere ETL-Prozesse eigenständig und ohne Programmierkenntnisse einrichten können.

Huawei Roadshow 2024

Technologie auf Rädern - der Show-Truck von Huawei ist unterwegs

Die Huawei Europe Enterprise Roadshow läuft dieses Jahr unter dem Thema "Digital & Green: Accelerate Industrial Intelligence". Im Show-Truck zeigt das Unternehmen neueste Produkte und Lösungen. Ziel ist es, Kunden und Partner zusammenzubringen.

>>

Nach der Unify-Übernahme

Mitels kombinierte Portfoliostrategie

Der UCC-Spezialist Mitel bereinigt nach der Unify-Übernahme sein Portfolio – und möchte sich auf die Bereiche Hybrid Cloud-Anwendungen, Integrationsmöglichkeiten in vertikalen Branchen sowie auf den DECT-Bereich konzentrieren.

>>

Tools

GitLab Duo Chat mit KI-Chat-Unterstützung

Der DevSecOps-Plattform-Anbieter GitLab führt den GitLab Duo Chat ein. Dieses Tool integriert Künstliche Intelligenz in die DevSecOps-Workflows.

>>

Forschung

KI macht Gebärdensprache zugänglicher

Ein KI-Tool der Universität Leiden für "Wörterbücher" erkennt Positionen und Bewegungen der Hände bei der Darstellung unterschiedlicher Gebärdensprachen.

>>