25.05.2018

Flexible Ressourcen

1. Teil: „Der lange Weg zum agilen Rechenzentrum “

Der lange Weg zum agilen Rechenzentrum

Autor: Filipe Pereira Martins

Pixabey / PIRO4D

Composable Infrastructure tritt in die Fußstapfen integrierter Systeme und verändert das Paradigma der IT-Administration dank Code-gesteuerter Provisionierung.

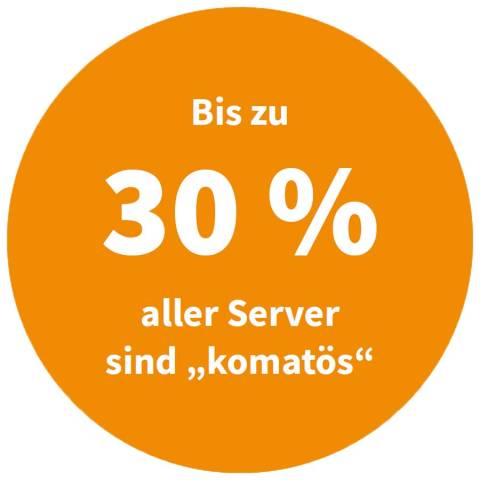

Die dürftige Auslastung ihrer Rechenzentren setzt den Unternehmen arg zu. 20 bis 30 Prozent aller Server in einem typischen Rechenzentrum seien „komatös“: Sie würden Strom saugen und rein gar nichts damit machen, fanden das Uptime Institute und Forscher der Stanford-Universität heraus. Und McKinsey schätzt, dass die Auslastung der übrigen, der „produktiven“ Server, aufs Jahr gerechnet zwischen 5 und 15 Prozent ihrer Kapazität schwankt.

Überprovisionierung

Diese Überversorgung mit Servern ist oft eine Reaktion darauf, dass sich die IT-Infrastruktur dem fluktuierenden Bedarf der Fachabteilungen nicht flexibel anpassen lässt. Konfigurationsänderungen erfordern nicht selten die koordinierte Arbeit mehrerer Spezialisten, womöglich noch das Hinzuschalten eines externen Integrators. Fachabteilungen neigen deshalb dazu, Systeme auf Verdacht zu provisionieren und dann in steter Betriebsbereitschaft vor sich hin laufen zu lassen.

Vor diesem Hintergrund entstanden in den vergangenen Jahren eine Reihe von Hardware-Architekturen – alle mit dem Ziel, die Komplexität der Administration zu reduzieren und die Kosten in den Griff zu bekommen.

Infrastruktur in einem Rechenzentrum der alten Schule besteht aus drei Ressourcen: Compute (Server), Storage (Speicher) und Networking (Vernetzung). Die Hardware stammt von verschiedenen Anbietern, wird vor Ort aufeinander abgestimmt und separat verwaltet. Wegen dieser Ressourcen-Silos erfordert die Bereitstellung neuer Workloads im IT-Team zugleich breite Kompetenzen und tiefe Spezialisierungen.

Die hohe Komplexität der Provisionierung neuer Workloads über die Ressourcenklassen hinweg mit Administrationswerkzeugen unterschiedlicher Anbieter geht auf Kosten der Agilität. So lässt sich die Auslastung der Infrastruktur kaum optimieren. An dieser Komplexität konnten weder Referenzarchitekturen, Best-Practices noch Gewehr-bei-Fuß-Systemintegratoren wirklich etwas ändern.

2. Teil: „Appliances & Konvergenz“

Appliances & Konvergenz

Als Antwort darauf traten zunächst Appliances auf den Plan, das heißt, IT-Vorrichtungen, die einen komplexen Software-Stack für einen präzise definierten Workload vorkonfiguriert bereitstellen. Appliances sind Ein-Zweck-Systeme und haben sich zum Beispiel als Mail-Server, Firewalls oder Datenbanken bewährt. Einen weiteren Schub bekam die Idee schlüsselfertiger Infrastruktur durch die aufkommende Virtualisierung und die Einführung integrierter modularer Hardware. Das Konstrukt taufte die Industrie auf den Namen konvergente Infrastruktur (Converged Infrastructure).

Ein konvergentes System integriert Compute, Storage und Networking in einer kompakten Bauform mit vorkonfigurierter Virtualisierung. Ähnlich wie eine Appliance ist es für eine bestimmte Art von Arbeitslast optimiert, um Inbetriebnahme und Administration zu erleichtern. Vorkonfigurierte, aufeinander abgestimmte Administrationswerkzeuge senken die Komplexität der Bereitstellung von Workloads und verringern den Bedarf an IT-Spezialisten. In einem solchen System „konvergieren“ die Hardware-Ressourcen Compute, Storage und Networking, sind jedoch noch als separate Elemente mit ihren jeweiligen Admin-Tools nutzbar. Für die Leistung zeichnet ebenso wie bei einer Appliance ein einziger Anbieter verantwortlich.

Konvergente Systeme eliminieren Inkompatibilitäten von Hardware, minimieren den Platzbedarf, vereinfachen die Verkabelung und erleichtern die Administration. Aus den vorgefertigten Bausteinen – den einzelnen konvergenten Systemen mit ihren verschiedenen Arbeitslasten – entsteht nach dem Lego-Prinzip die konvergente Infrastruktur.

Mit der wachsenden Akzeptanz konvergenter Systeme rückte im Lauf der Zeit eine andere Anforderung in den Vordergrund: die horizontale Skalierbarkeit von Arbeitslasten. Konvergente Infrastruktur kann nämlich nicht nahtlos wachsen. Wer mehr Storage- oder Compute-Leistung benötigt, muss neue Knoten anschaffen und dabei die nicht benötigten Ressourcenklassen samt zugehörigen Software-Lizenzen zähneknirschend mit in Kauf nehmen, ohne Vorteile wie Hochverfügbarkeit zu gewinnen.

Kaum hatte sich der Staub um die konvergente Infrastruktur gelegt, war plötzlich die hyperkonvergente Infrastruktur (HCI) in aller Munde. Diese Weiterentwicklung konvergenter Architekturen erfasst Compute, Storage und Networking in einer Software-definierten Umgebung auf Basis eines Hypervisors, auch Virtual Machine Monitor (VMM) genannt.

Die Ressourcen aller Knoten lassen sich als vereinheitlichter, logischer Pool über eine einzige Software-Ebene kontrollieren. Hyperkonvergenz ermöglicht Lösungen, die nach dem Baukastenprinzip durch weitere Knoten ausbaufähig sind. Zusätzliche Dienste wie Weitverkehrsbeschleunigung, Verschlüsselung, Deduplizierung, Hochverfügbarkeit und Caching heben die Leistung dabei auf ein neues Niveau.

3. Teil: „Beispiel Scholz Recycling“

Beispiel Scholz Recycling

Was der Umstieg auf Hyperkonvergenz bringt, zeigt ein Blick auf Scholz Recycling, einen großen Verwertungsbetrieb für Stahl- und Metallschrott in Europa. Als Leasingverträge ausliefen, entschied sich die GmbH, ihre beiden Rechenzentren auf Basis hyperkonvergenter Systeme zu erneuern. Ergebnis: Energieeffizienz und Skalierbarkeit wurden besser, das Deployment von Workloads einfacher. Zudem konnte Scholz Recycling den Bedarf an Rackspace von 22 auf gerade einmal 4 Höheneinheiten je Site senken. Und der Stromverbrauch fiel von 9,6 auf 2,8 kW pro Site.

Basis der neuen Architektur war die Dell EMC VxRail-Appliance. Sie ist für VMwares hyperkonvergente Storage-Lösung vSAN vorkonfiguriert und punktet mit integrierten Services wie Replikation, Backup und Cloud-Tiering. Die Ressourcen Compute, Storage und Networking lassen sich Workloads via Management-Konsole nach Bedarf zuweisen.

Zudem wurde auf Basis der Programme EMC Avamar und Networker eine Backup-Lösung implementiert, die von den beiden hochverfügbaren Rechenzentren sowie allen mobilen Geräten im Außendienst und in den über 50 deutschen Standorten täglich Kopien anfertigt.

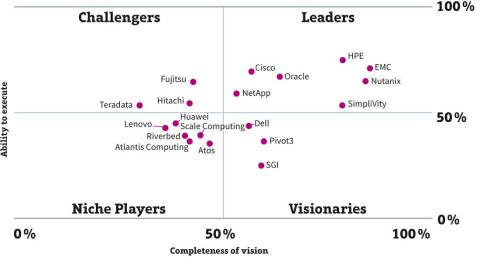

Der Markt für HCI wächst seit drei Jahren rasant. Bis Anfang 2019 soll er sich laut Gartner gegenüber 2016 mehr als verdoppeln und fünf Milliarden Dollar erreichen. 2020 sollen 20 Prozent aller unternehmenskritischen Anwendungen auf HCIs migriert sein.

Dennoch geht vielen Firmen Hyperkonvergenz noch nicht weit genug. HCI-Systeme stellen ihre lokalen Compute-Ressourcen und direkt angeschlossenen Speicher (Direct Attached Storage, DAS) über eine Virtualisierungsebene bereit, weswegen leistungshungrige Anwendungen in HCIs nicht gut aufgehoben wären. Zudem haben konvergente und hyperkonvergente Systeme den gleichen Nachteil in puncto Skalierbarkeit: Compute- und Storage-Ressourcen lassen sich nicht unabhängig voneinander ausbauen.

4. Teil: „Infrastructure as a Code“

Infrastructure as a Code

Eine gerade stark diskutierte Antwort auf die Unzulänglichkeiten integrierter Architekturen heißt Composable Infrastructure (CI), auch Infrastructure as a Code genannt. Composable Infrastructure abstrahiert alle Ressourcen in Software, macht sie via Code steuerbar und ermöglicht smarte Kontrollfunktionen. Ein CI-System kann vorhandene Ressourcen selbst auffinden, automatisch erkennen und im Zuge einer raffinierten Selbstdiagnose auf Betriebsbereitschaft prüfen. Ist ein Modul nicht korrekt verbaut, hat das System passende Anweisungen parat, um die Störung zu beheben.

Composable Infrastructure unterstützt sowohl Baremetal-Deployments als auch virtualisierte und containerisierte Umgebungen in einer einzigen Plattform. Sie abstrahiert operative Details und ersetzt sie durch automatisierte Abläufe. Dank Software-definierter Vorlagen lassen sich Workloads in einem einzigen Schritt provisionieren, ohne die Verfügbarkeit laufender Dienste zu unterbrechen.

Auch Vorgänge wie das Aktualisieren von Firmware erfolgen automatisch über Vorlagen. Die Infrastruktur orchestriert sich selbst und sichert sich selbst ab. Das minimiert manuelle Interaktionen und menschliche Fehler.

„Durch Hinzufügen von Composable Infrastructure zur aktuellen Mischung aus Virtualisierungsabstraktionen und Automatisierungswerkzeugen (…) wird ein vollständig Software-definiertes Rechenzentrum vorstellbarer“, urteilt Richard Fichera, VP und Principal Analyst für DevOps bei Forrester Research.

Eine Software-definierte Composable Infrastructure entsteht auf der Basis eines Frameworks oder Stacks von Werkzeugen, indem sie die Ressourcen Compute, Storage und Networking als gepoolte Dienste statt als physische Einheiten erfasst und verwaltet. Im Zusammenspiel mit intelligenter Orchestrierungs-Software kann die IT ihre Aufmerksamkeit verstärkt der logischen Dimension der Infrastruktur widmen. Die Software-definierte Schicht der Infrastruktur verwaltet die Hardware darunter vollkommen autark.

5. Teil: „CI am Beispiel Dreamworks“

CI am Beispiel Dreamworks

„Wir haben Workflows mit sehr unterschiedlichen Anforderungen an unsere Infrastruktur; wir müssen diese Workflows starten und anhalten können“, beschreibt Jeff Wike, CTO bei Dreamworks Animation, die Herausforderung für die IT des Filmstudios. Bevor ein Kinofilm fertig gerendert ist, arbeiten digitale Künstler in Workflows mit unterschiedlichsten, stets schwankenden Ressourcenanforderungen. So entstehen über eine Milliarde Dateien pro Projekt.

Viele Ingenieur-geprägte Unternehmen, etwa in der Automobilindustrie und im Maschinenbau, kennen das Problem: Innovative Produktentwicklung braucht flexibel dosierbare Rechenkraft. „Die Analytics der Ressourcenanforderungen – die Fähigkeit, auf Änderungen im Workflow zu reagieren, also mehr Bandbreite, mehr Speicher, mehr Compute-Leistung provisionieren zu können – war für uns eine enorme Herausforderung“, führt Wike aus. Gelöst hat sie Dreamworks mit Synergy vom CI-Pionier HPE.

„Synergy ist ganz einfach eine Kombination aus schlüsselfertig optimierter Hardware und Software, die uns erlaubt, auf unsere Infrastruktur als eine Sammlung zusammensetzbarer Ressourcen in Code zuzugreifen“, erläutert Justin G. Decker, Vice President of Platforms and Infrastructure bei Dreamworks.

„Wir können [Ressourcen-Vorlagen] aufsetzen, unterschiedliche Konfigurationen auf verschiedene Workflows loslassen, und wenn einer davon nicht mehr gebraucht wird, bauen wir ihn auseinander und übertragen die Ressourcen woandershin“, erklärt Decker. Und er bestätigt zufrieden, dass diese Zusammensetzbarkeit der Infrastruktur in Synergy tatsächlich reibungslos funktioniert: „Die Fähigkeit, 30.000 Rendering-Kerne nach Lust und Laune zu manipulieren und sie jederzeit beliebigen Workflows in Synergy zuweisen zu können verleiht uns ein enormes Maß an Flexibilität.“

Die Synergy-Produktlinie entstand aus den Blade-Systemen von HPE durch das Hinzufügen von Features der HPE-Appliances Synergy Composer und Image Streamer. Diese beiden Komponenten ermöglichen das schnelle Zusammenstellen einer komplexen Topologie von Systemen auf der Basis von Vorlagen. Jeder Synergy-Frame vereint Rechenknoten sowie Speicher und Netzwerk in einem einzigen 10-Rack-Gehäuse. Die Verbindung zu weiteren HPE-Synergy-12000-Frames stellt ein 10-GByte-Frame-Link-Modul bereit.

Die Synergy-Plattform ermöglicht, die Infrastruktur einzeln um die Ressourcentypen Compute, Storage und Networking/Fabric sowie die Management-Software in separaten Knoten zu erweitern. Die Trennung von Daten- und Managementverkehr soll zudem Denial-of-Service-Angriffe verhindern helfen und Sicherheits-Checks verbessern.

6. Teil: „Zwei Ansätze für CI-Lösungen“

Zwei Ansätze für CI-Lösungen

Das Analystenhaus IDC unterscheidet im aufkeimenden CI-Markt zwei Ansätze – integrierte und disaggregierte Systeme. Zu Ersterem zählt IDC HPEs Synergy aufgrund seiner Software-defined Composability, die Synergy zu einer Weiterentwicklung der Hyperkonvergenz macht.

Umgekehrt strebt der Disaggregation genannte Ansatz die Entkoppelung der Ressourcenklassen Compute, Storage und Networking in den einzelnen Knoten an, um sie im Rahmen des gesamten Racks auf Hardware-Ebene zusammenzusetzen, Stichwort: Rack Scale Design (RDS). In konventionellen Systemarchitekturen sind die Ressourcenklassen Compute (darunter CPUs, GPUs, FPGAs) und Speicher (wie RAM oder Storage-Class-Memory) nur im Rahmen eines Knotens (Node) aufeinander abgestimmt und dann mit der Außenwelt (also mit anderen Knoten) über Switches vernetzt. Ein Knoten kann so nicht direkt auf den Speicher eines anderen Knotens zugreifen, ohne diese Ressourcen von der zugehörigen CPU erst anzufordern; zudem ist die Netzwerkanbindung für einen direkten Speicherzugriff viel zu langsam. Wenn nun die verschiedenen Ressourcenklassen beim Rack Scale Design nicht mehr nur für den einen Knoten optimiert sind, sondern disaggregiert wurden, lassen sie sich im Rahmen des Racks wieder zusammensetzen. So entsteht ein modulares System, das zudem hochperformant ist.

Disaggregierte Infrastruktur steckt allerdings noch in den Kinderschuhen. Denn Infrastrukturbauteile der Speicherdomäne aktueller Systemarchitekturen, darunter Hardware-Beschleuniger, I/O und RAM, entziehen sich der Disaggregation und somit auch der Zusammensetzbarkeit auf Hardware-Ebene.

Langsame Ressourcen wie Datenspeicher und Netzwerk nutzen von Haus aus derart üppige Protokoll-Stacks wie TCP/IP, iSCSI und NFS, dass sich noch eine weitere Software-Ebene auf die Gesamt-Performance der Systeme kaum negativ auswirkt. Deshalb hat auch HPE mit seinem Ansatz Erfolg.

Anders liegt der Fall bei schnellen Hardware-Ressourcen mit Zugriffszeiten im Nanosekunden-Bereich, die nicht diese langsamen Protokoll-Stacks nutzen, sondern CPU-native Befehlssätze sprechen. In diese Kategorie fallen Komponenten der Speicherdomäne wie DRAM, SCM (Storage Class Memory) und GPUs/FPGAs. Aktuelle Systemarchitekturen können die theoretisch erzielbare Leistung dieser Komponenten nicht voll ausreizen.

Bei den CI-Systemstrukturen kommt gerade diesen schnellen Ressourcen eine entscheidende Bedeutung zu. Erst eine von Grund auf neu entwickelte, speicherzentrische Architektur mit geeigneter Speichersemantik würde die Disaggregation dieser Komponenten ermöglichen und das Konzept der Composable Infrastructure auf Hardware-Ebene vervollständigen. Alle aktuellen Lösungen stellen bisher nur Krücken dar.

Bei Speichersemantik (memory semantics) handelt es sich um die Prozesslogik, mit deren Hilfe ein System den Zugriff auf gemeinsam genutzte Adressen des physischen Speichers oder gemeinsam genutzte Variablen durch mehrere Prozessoren oder mehrere Threads steuert.

Bei allen bestehenden Systemarchitekturen würde sich jeder Versuch, die verfügbaren Ressourcen bis in die Ebene der Speichersemantik zu disaggregieren, sofort auf Bandbreite und Latenz der Komponenten auswirken und die Vorteile zusammensetzbarer Infrastruktur schnell zunichtemachen.

Es braucht also eine völlig neue speicherzentrische Architektur. Eine solche längst überfällige Lösung entsteht gerade im Rahmen des Gen-Z-Consortiums. Zu dessen Mitgliedern zählen unter anderem AMD, ARM, Broadcom, Cray, Dell EMC, HPE, Huawei, IBM, Lenovo, Samsung und VMware. Die Gen-Z-Technologie ist Open Source und frei von Lizenzgebühren – und damit eine Kriegserklärung der IT-Branche an Intel und seine proprietären Interconnects.

7. Teil: „Speicherzentrisch“

Speicherzentrisch

Bei Gen-Z handelt es sich um einen offenen Standard für ein Interconnect auf Systemebene, das heißt, um einen neuen Bus für ein direkte, in Hardware implementierte Hochgeschwindigkeitsanbindung zwischen CPU-Kernen, SoCs, FPGAs, GPUs, Speicher-Pools und vernetztem Datenspeicher.

Gen-Z will die Bandbreite zwischen Compute-Ressourcen auf über 100 GBit/s steigern, beispielsweise zwischen den CPU-Kernen auf der einen Seite und Block-basiertem Speicher auf der anderen Seite. Diese Verbindung stellt derzeit den größten Flaschenhals im Hinblick auf die Latenz dar. Für die Latenz strebt Gen-Z einen Wert von unter 100 Nanosekunden an.

Unternehmen versprechen sich von der speicherzentrischen Architektur darüber hinaus neue Möglichkeiten der Leistungsoptimierung bestehender Infrastrukturen, eine verbesserte Energieeffizienz und eine höhere Agilität dank neuer Fähigkeiten zur Echtzeit-Datenanalyse. Gen-Z-Hardware-Komponenten lassen sich in die bestehende Unternehmens-IT vollständig transparent einfügen. Es sind dazu weder Änderungen am Betriebssystem noch an der Middleware erforderlich.

Der Standard nutzt allerdings neuartige modulare Stecker, zum Teil sollen diese aber mit bestehenden Anschlüssen und bestehenden Verkabelungen nutzbar sein. Das Interconnect soll vorerst zwischen verschiedenen Server-Knoten vermitteln und auf ein Rack skalieren können.

Fazit

Composable Infrastructure tritt in die Fußstapfen integrierter Systeme und verändert das Paradigma der IT-Administration dank Code-gesteuerter Provisionierung. Konventionelle Hardware kann mit den wachsenden Anforderungen an den Arbeitsspeicher allerdings längst nicht mehr Schritt halten. Direkt in Hardware zusammensetzbare Infrastruktur auf der Basis disaggregierter Ressourcen verspricht in Zukunft Abhilfe.

Ohne Nokia

HMD zeigt erste Smartphones mit der eigenen Marke

Mit den drei neuen Pulse-Modellen bringt HMD seine ersten Smartphones auf den Markt, die nicht mehr unter der Lizenz von Nokia vermarktet werden.

>>

Test-Framework

Testautomatisierung mit C# und Atata

Atata ist ein umfassendes C#-Framework für die Web-Testautomatisierung, das auf Selenium WebDriver basiert. Es verwendet das Fluent Page Object Pattern und verfügt über ein einzigartiges Protokollierungssystem sowie Trigger-Funktionalitäten.

>>

Salzbatterie

Neuer Super-Akku lädt in wenigen Sekunden

Eine neue Batterie des Korea Advanced Institute of Science and Technology (KAIST) lädt binnen Sekunden. Als Basismaterial kommt das auf der Erde in großen Mengen vorkommende Natrium zum Einsatz.

>>

Programmiersprache

Primärkonstruktoren in C# erleichtern den Code-Refactoring-Prozess

Zusammenfassen, was zusammen gehört: Dabei helfen die in C# 12 neu eingeführten Primärkonstruktoren, indem sie Code kürzer und klarer machen.

>>