20.01.2020

Zertifizierungen für KI

1. Teil: „Künstliche Intelligenz muss Vertrauen schaffen“

Künstliche Intelligenz muss Vertrauen schaffen

Autor: Oliver Schonschek

Profit_Image / shutterstock.com

Gütesiegel und Zertifikate für KI-Lösungen sind noch Mangelware. Auch Ethik-Grundsätze sind extrem wichtig. Diese müssten aber zunächst definiert werden.

Im Kontext zunehmender Automatisierung und auf Künstlicher Intelligenz (KI) basierender Anwendungen wird das Thema Ethik zu einem immer wichtigeren Faktor für die digitale Wirtschaft, so die Studie „Künstliche Intelligenz, Smart Home, vernetzte Gesundheit - Ethik in der Digitalen Wirtschaft” des Bundesverbands Digitale Wirtschaft (BVDW).

Drei Viertel der befragten Verbraucher in Deutschland (74 Prozent) gaben in einer repräsentativen Umfrage von Kantar TNS im Auftrag des BVDW an, dass ethische Grundsätze bereits bei der Entwicklung neuer Produkte einen hohen oder sehr hohen Stellenwert haben sollten. Die parallel durchgeführte Umfrage unter BVDW-Mitgliedsunternehmen belegt, dass mehr als die Hälfte der Unternehmen (55 Prozent) das als genauso wichtig einstuft.

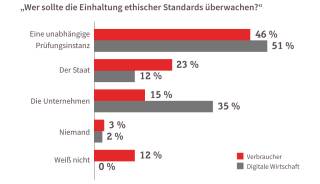

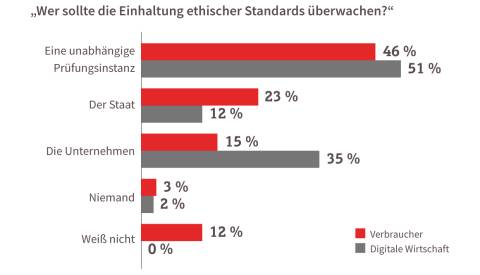

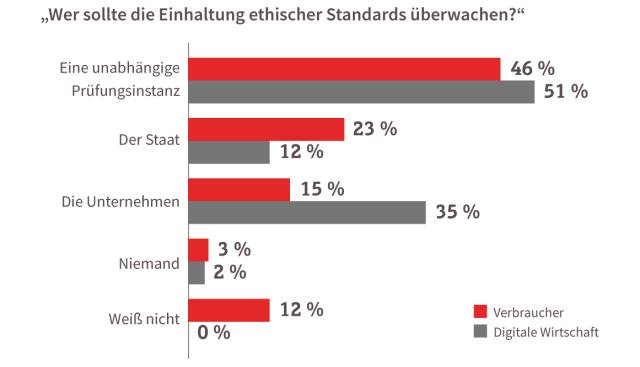

Einigkeit herrscht auch bei der Frage, wer die Einhaltung ethischer Standards überwachen soll: 46 Prozent der Verbraucher und 51 Prozent der Digitalunternehmen gaben an, dass diese Aufgabe eine unabhängige Prüfinstanz übernehmen sollte.

Vor einer Ethikprüfung bei Künstlicher Intelligenz müssen allerdings zuerst noch die Kriterien festgelegt sein, die eine KI erfüllen soll.

KI fehlt „Brief und Siegel“

„Künstliche Intelligenz ist eine Schlüsseltechnologie, die enormes Potenzial für die deutsche Wirtschaft birgt. Wir brauchen aber verlässliche Normen und Standards, um ,KI made in Germany weiter voranzubringen“, erklärte der Staatssekretär im Bundesministerium für Wirtschaft und Energie (BMWi), Ulrich Nussbaum, auf der Auftaktveranstaltung der Normungsroadmap Künstliche Intelligenz, die vergangenen Oktober im BMWi stattfand. Dort diskutierten rund 300 Experten und Interessierte aus Wirtschaft, Gesellschaft, Politik und Wissenschaft über die notwendige Normierung bei KI. „Die Roadmap wird eine Übersicht über bestehende Normen und Standards zu KI-Aspekten umfassen und insbesondere Normungsbedarfe nach ihrer Dringlichkeit geordnet aufzeigen - vor allem hinsichtlich Qualität, Nachvollziehbarkeit, Erklärbarkeit und Verlässlichkeit von KI“, so Wolfgang Wahlster, Mitglied des Lenkungskreises der Plattform Lernende Systeme und Wissenschaftler im Bereich KI.

Christoph Winterhalter, Vorstandsvorsitzender des Deutschen Instituts für Normung (DIN), ergänzte: „Unser Ziel ist es, einen sicheren und verlässlichen Handlungsrahmen zu schaffen, der deutschen Innovationen und Unternehmen, insbesondere aus dem Mittelstand, den Zugang zum globalen Markt öffnet und gleichzeitig die Umsetzung von europäischen Wertmaßstäben in der KI fördert.“ Vorgestellt werden soll die Normungsroadmap Künstliche Intelligenz kommenden Herbst anlässlich des Digital-Gipfels der Bundesregierung.

Doch woran können sich Unternehmen heute orientieren, wenn sie mit KI arbeiten wollen? Laut der aktuellen CIO-Umfrage von Gartner hat sich der Anteil der Unternehmen, die bereits KI einsetzen, im Vergleich zum Vorjahr fast vervierfacht - von 4 Prozent 2018 auf 14 Prozent im Jahr 2019, mit weiter steigender Tendenz.

Die Wahl einer KI-Lösung kann Folgen haben für die Compliance, sollte also nicht vorschnell und ungeprüft erfolgen. Für den Datenschutz zum Beispiel haben die Aufsichtsbehörden ihre rechtlichen Anforderungen an KI in der sogenannten Hambacher Erklärung dargelegt. Dazu gehören Kriterien wie technische und organisatorische Maßnahmen, etwa Pseudonymisierung, Schutz vor Manipulationen und Datenminimierung. Insbesondere muss eine KI transparent, nachvollziehbar und erklärbar sein, so die Datenschützer.

Anwenderunternehmen dürften von der Überprüfung einer KI überfordert sein, sie brauchen Unterstützung durch unabhängige Experten. Die Zertifizierung von KI-Lösungen würde hier helfen. „Es gibt eine Reihe von Richtlinien und ethischen Standards, aber noch keine Zertifizierungen, die eine viel detailliertere Betrachtung erfordern“, beschreibt Jörg Bienert, Vorsitzender des Bundesverbands Künstliche Intelligenz

(KI Bundesverband e.V.), die Situation. Allerdings bietet der KI Bundesverband etwas anderes: „Wir haben mit dem KI-Gütesiegel ein Rahmenwerk erstellt, zu dem sich die Mitglieder, die dies möchten, in einer Selbstverpflichtung bekennen“, so Jörg Bienert. Doch es gibt Einschränkungen: „Eine Überprüfung findet derzeit nicht statt, kann durch uns alleine auch nicht geleistet werden. Wir arbeiten aktiv mit anderen Gremien, zum Beispiel DIN, zusammen an Aktivitäten, die eine Zertifizierung als Ziel haben.“

(KI Bundesverband e.V.), die Situation. Allerdings bietet der KI Bundesverband etwas anderes: „Wir haben mit dem KI-Gütesiegel ein Rahmenwerk erstellt, zu dem sich die Mitglieder, die dies möchten, in einer Selbstverpflichtung bekennen“, so Jörg Bienert. Doch es gibt Einschränkungen: „Eine Überprüfung findet derzeit nicht statt, kann durch uns alleine auch nicht geleistet werden. Wir arbeiten aktiv mit anderen Gremien, zum Beispiel DIN, zusammen an Aktivitäten, die eine Zertifizierung als Ziel haben.“

Sind KI-Zertifizierungen verfügbar, dann hat dies klare Vorteile. „Wenn es KI-Zertifikate gibt, gibt es ein zugrundeliegendes Prüfschema“, erläutert Dirk Kretzschmar, Geschäftsführer von TÜViT. „Diese geben Informationen darüber, was eigentlich genau und wie geprüft wurde. Wir sind der Überzeugung, dass KI-Prüfungen in einem dafür zertifizierten Labor erforderlich sind. Allein der Dokumentation der KI-Entwickler zu vertrauen oder gar Herstellereigenerklärungen zuzulassen, halten wir für keine vertrauenswürdige Zertifizierung. Für diese Laborprüfungen ist großes Expertenwissen etwa zu Machine Learning, neuronalen Netzen, IT-Security, Adversial Attacks und entsprechende Ausstattung erforderlich.“

2. Teil: „Zertifizierung in Vorbereitung“

Zertifizierung in Vorbereitung

Das Fraunhofer-Institut für Intelligente Analyse- und Informationssysteme IAIS und das Bundesamt für Sicherheit in der Informationstechnik (BSI) wollen im Rahmen der Kompetenzplattform KI.NRW einen Prüfkatalog für den verantwortungsvollen Einsatz von Anwendungen der Künstlichen Intelligenz entwickeln. Ziel ist die Ausarbeitung konkreter Qualitäts- und Sicherheitsstandards, auf deren Grundlage technische Prüforganisationen künftig KI-Anwendungen sachkundig beurteilen können.

„Die Zertifizierung soll den zuverlässigen und verantwortungsvollen Einsatz von KI-Anwendungen für die Bürgerinnen und Bürger in Nordrhein-Westfalen und Deutschland sichern und auch als europäisches Vorbild dienen“, sagte Andreas Pinkwart, Minister für Wirtschaft, Innovation, Digitalisierung und Energie des Landes Nordrhein-Westfalen. „Die Zertifizierung sichert die Qualitätsmarke ,KI made in Germany‘, indem sie zuverlässige, sichere Technologien erkennbar macht und nachhaltig schützt“, betonte Minister Pinkwart. „Die Zertifizierung fördert den freien Wettbewerb unterschiedlicher Anbieter und leistet einen Beitrag zur Akzeptanz von KI in der Gesellschaft.“

Ein Ziel der Kompetenzplattform KI.NRW ist es, eine Zertifizierung für KI zu entwickeln, die neben der Absicherung der technischen Zuverlässigkeit auch einen verantwortungsvollen Umgang mit der Technologie prüft. Hierzu leitet das Fraunhofer IAIS ein interdisziplinäres Forschungsteam mit Vertreterinnen und Vertretern aus Philosophie, Recht, Wirtschaft und Politik, um die Grundlagen für diese Zertifizierung zu erarbeiten. Die Kriterien bei der KI-Zertifizierung sollen die Bereiche Ethik und Recht, Autonomie und Kontrolle, Fairness, Transparenz, Verlässlichkeit, Datenschutz und Sicherheit umfassen.

Typische Fragen innerhalb der Zertifizierung sollen sein: Respektiert die KI-Anwendung gesellschaftliche Werte und Gesetze? Ist eine selbstbestimmte, effektive Nutzung möglich? Behandelt die KI alle Betroffenen fair? Sind ihre Funktionsweise und Entscheidungen nachvollziehbar? Funktioniert die KI zuverlässig und ist sie robust? Ist sie sicher vor Angriffen, Unfällen und Fehlern? Schützt die KI die Privatsphäre und sonstige sensiblen Informationen?

Informationen zum richtigen Umgang mit der KI-Anwendung müssten verfügbar sein, betonen die Experten. Für die Nutzer müssten die Interpretierbarkeit, Nachverfolgbarkeit und Reproduzierbarkeit von Ergebnissen der Künstlichen Intelligenz möglich sein. Widerstreitende Interessen - wie Transparenz und Schutz von Geschäftsgeheimnissen - müssten gegeneinander abgewogen werden.

3. Teil: „Permanente Aufgabe“

Permanente Aufgabe

„Bald werden sich Systeme selbst neu programmieren, um sich automatisch an veränderte Gegebenheiten anzupassen“, erklärt Giuseppe De Giacomo, KI-Experte an der Universität La Sapienza in Rom. „Die Ausstattung von Systemen mit Selbstprogrammierung birgt jedoch erhebliche Risiken, deshalb müssen wir in der Lage sein, Leistung und Sicherheit in Einklang zu bringen. Aus diesem Grund ist es wichtig, solche Systeme durch menschliche Vorgaben und Aufsicht zu schützen, das heißt Systeme zu schaffen, deren selbst programmiertes Verhalten für den Menschen nachvollziehbar und analysierbar ist.“

Künstliche Intelligenz zu zertifizieren, wird sich deshalb von den klassischen Zertifizierungen unterscheiden, wie sie viele Unternehmen zum Beispiel aus dem Qualitätsmanagement kennen. KI verändert „selbstlernend“ ursprünglich von Menschen gestaltete Algorithmen und gewinnt auf dieser Grundlage automatisierte Schlussfolgerungen, die als Basis von relevanten praktischen Entscheidungen genommen werden können.

KI unterliegt Veränderungen, ohne die das Lernen der Maschinen nicht möglich wäre - mit Folgen für die Zertifizierung. „Zertifizierungen kennen wir bisher als periodisch wiederkehrende zu einem bestimmten Zeitpunkt. Rezertifizierungen sind auch bei KI Lösungen erforderlich, insbesondere, wenn Änderungen am Algorithmus vorgenommen werden“, erklärt TÜViT-Geschäftsführer Dirk Kretzschmar. „Insgesamt sehen wir durchaus die Notwendigkeit einer permanenten Überprüfung, insbesondere bei Algorithmen, die ausschließlich in der Cloud betrieben werden.“

Bislang gibt es also noch keine Zertifizierung von Künstlicher Intelligenz, in Zukunft aber wird sie fortwährend stattfinden.

4. Teil: „Im Gespräch mit Dr. Maximilian Poretschkin vom Fraunhofer-Institut IAIS“

Im Gespräch mit Dr. Maximilian Poretschkin vom Fraunhofer-Institut IAIS

Dr. Maximilian Poretschkin verantwortet am Fraunhofer-Institut für Intelligente Analyse- und Informationssysteme (IAIS) die Aktivitäten im Bereich Absicherung und Standardisierung von Künstlicher Intelligenz. In dieser Funktion leitet er unter anderem ein interdisziplinäres Forschungsprojekt zur Entwicklung einer Zertifizierung von Künstlicher Intelligenz, das von der KI-Kompetenzplattform KI.NRW gefördert wird und an dem auch das Bundesamt für Sicherheit in der Informationstechnik (BSI) beteiligt ist.

com! professional: Hindert nach Ihrer Erfahrung gegenwärtig fehlendes Vertrauen in Künstliche Intelligenz die weitere Nutzung in Unternehmen?

Maximilian Poretschkin: Das Vertrauen der Wirtschaft in Künstliche Intelligenz ist durchaus vorhanden. Die Unternehmen erkennen, dass ein verantwortungsvoller Einsatz der Technologie tatsächlich mehr Chancen als Risiken bietet: KI-Anwendungen offerieren ein breites Spektrum an Möglichkeiten, sei es bei der Prozessoptimierung oder um neue Geschäftsmodelle zu generieren.

Und an vielen Stellen im Alltag oder in der Arbeitswelt funktioniert KI bereits heute besonders zuverlässig, beispielsweise in der Medizin: KI-Systeme können Diagnosen anhand von Röntgenbildern präziser stellen als die Radiologen. Allerdings ist es letztlich immer der Mensch, der die Diagnose verifiziert und eine Behandlung einleitet. So können wir KI wirklich als Chance begreifen, und dann ist es auch nicht das fehlende technologische Vertrauen seitens der Unternehmen, das sie an der Nutzung von KI hindert, sondern vielmehr Fragestellungen der tatsächlichen Einsatzmöglichkeiten von KI-Anwendungen.

com! professional: Was müsste geschehen, damit das Vertrauen in KI weiter steigt?

Poretschkin: Um das Vertrauen in KI noch weiter zu stärken, müssen KI-Anwendungen, die an besonders sensiblen Stellen zum Einsatz kommen - etwa beim autonomen Fahren oder weiteren Anwendungen in der Medizin -, überprüfbar konstruiert werden und ethische sowie rechtliche Rahmenbedingungen erfüllen. Idealerweise werden ethische Aspekte bereits beim Design bis hin zum Operativeinsatz mitgedacht. Zudem müssen die Anwendungen technisch abgesichert sein, sprich zuverlässig funktionieren.

Oft beruhen KI-Anwendungen auf großen Datenmengen vor dem Hintergrund hochkomplexer Modelle. In der Praxis kann es sich aus Sicht des Anwenders durchaus schwierig gestalten, zugesicherte Eigenschaften der Anwendung zu überprüfen. Solche Anwendungen werden auch „Black Boxes“ genannt. Es liegt hier an den Wissenschaftlerinnen und Wissenschaftlern der Informatik, neue, nachvollziehbare und erklärbare Verfahren zu entwickeln.

Zusätzlich ist es wichtig, einen Dialog mit der Gesellschaft zu führen, um Vertrauen in diese Zukunftstechnologie zu schaffen. Hierzu haben wir ein Whitepaper mit Handlungsfeldern für einen vertrauenswürdigen Einsatz von KI veröffentlicht, das die Basis unseres Prüfkatalogs für eine KI-Zertifizierung bildet. Darüber hinaus engagieren wir uns regelmäßig in Diskussionsrunden und mit Vorträgen auf öffentlichen Veranstaltungen, um für das Thema zu sensibilisieren.

com! professional: Welche Nachweise oder Zertifizierungen für KI gibt es bisher?

Poretschkin: Bislang gibt sehr viele allgemein gehaltene Empfehlungen zur Entwicklung und zum Umgang mit vertrauenswürdiger KI, etwa von der High Level Expert Group on Artificial Intelligence der Europäischen Kommission. Es gibt allerdings noch keine Zertifizierung von vertrauenswürdigen KI-Anwendungen, die die Konformität mit diesen Empfehlungen nach außen hin erkennbar macht.

Fraunhofer IAIS ist hier im Rahmen der Kompetenzplattform KI.NRW ein Vorreiter für die Entwicklung einer solchen Zertifizierung. Diese Entwicklung ist durchaus herausfordernd und erfordert sowohl eine tiefe technische KI-Expertise als auch ein Verständnis ihrer praktischen Anwendungen, ist also eine typische Fraunhofer-Aufgabe. Zusätzlich verlangt die Breite der Thematik, nicht zuletzt auch die gesellschaftliche Verantwortung, ebenso eine enge und interdisziplinäre Zusammenarbeit mit weiteren Partnern. Hierzu kooperieren wir mit namhaften Expertinnen und Experten aus dem Bereich Rechtswissenschaften und Philosophie sowie dem Bundesamt für Sicherheit in der Informationstechnik. Mit unserem Ansatz für die Zertifizierung beraten wir zudem regelmäßig sowohl große Unternehmen als auch politische Organe.

com! professional: Woran arbeiten Sie konkret im Bereich Zertifizierung für KI?

Poretschkin: Primäres Ziel ist, konkrete Qualitäts- und Sicherheitsstandards in Form eines Prüfkatalogs auszuarbeiten, auf deren Grundlage technische Prüfer künftig KI-Anwendungen sachkundig beurteilen können. Aktuell sind wir in Verhandlungen mit entsprechenden Prüforganisationen, um ein marktfähiges Verfahren zu entwickeln.

Aufbauend auf unserem interdisziplinären Austausch formuliert der Katalog KI-spezifische Anforderungen für den vertrauenswürdigen Einsatz von Künstlicher Intelligenz. Faires Verhalten der KI-Anwendung gegenüber allen Beteiligten, die Anpassung an die Bedürfnisse der Nutzerinnen und Nutzer, eine verständliche, verlässliche und sichere Funktionsweise sowie der Schutz sensibler Daten sind zentrale Kriterien, die ein Prüfkatalog und eine Zertifizierung abdecken müssen.

Die erste Version unseres Prüfkatalogs wird Anfang dieses Jahres erscheinen. Prüfverfahren für selbstfahrende Autos, sicherheitskritische Anwendungen oder bestimmte Arten des Weiterlernens der Anwendung - etwa Anwendungen, die die Architektur der neuronalen Netze im laufenden Betrieb ändern -, erfordern weitere Spezialkataloge und sind teilweise Gegenstand aktueller Forschung, auch hier bei Fraunhofer.

com! professional: Worauf sollten Unternehmen bei KI-Zertifikaten achten?

Poretschkin: Zurzeit gibt es noch keinen solchen Markt, bei der Aktualität des Themas wird sich dieser aber rasch entwickeln. Unternehmen sollten in ihrem eigenen Interesse darauf achten, sich keine Persilscheine ausstellen zu lassen. Ein gutes Gütesiegel sollte von entsprechenden KI-Experten unter Berücksichtigung von ethischen und gesellschaftlichen Fragestellungen entwickelt worden und nicht zuletzt auch von den zuständigen Behörden anerkannt sein.

com! professional: KI bedeutet ja auch stetige Veränderung durch Lernen. In welcher Weise kann eine Zertifizierung dies berücksichtigen?

Poretschkin: KI-Anwendungen folgen immer bestimmten Prinzipien und Mustern, die von ihren Entwicklerinnen und Entwicklern entsprechend programmiert wurden. KI kann sich dann im Betrieb dynamisch weiterentwickeln und bedient sich aus aktuellen oder historischen Daten. Ein bekanntes Negativbeispiel ist der Chatbot eines großen Technologieunternehmens. Die Software eignete sich rassistisches Verhalten an, was bei der Entwicklung natürlich nicht beabsichtigt worden war.

Derartige Ergebnisse gilt es klarerweise zu verhindern. Wirksame Gegenmittel hierzu sind, wie eingangs erwähnt, ein Human-in-the-Loop, das heißt, eine Kontrolle der Entscheidungen der KI durch den Menschen. Eine andere Möglichkeit sind strukturierte Updates, bei denen der Lernfortschritt der KI getestet wird, bevor er im laufenden Betrieb angewandt wird.

Galaxy AI

Samsung bringt KI auf weitere Smartphones und Tablets

Einige weitere, ältere Smartphone- und Tablet-Modelle von Samsung können mit einem Systemupdate jetzt die KI-Funktionen von Galaxy AI nutzen.

>>

Pilot-Features

Google Maps-Funktionen für nachhaltigeres Reisen

Google schafft zusätzliche Möglichkeiten, um umweltfreundlichere Fortbewegungsmittel zu fördern. Künftig werden auf Google Maps verstärkt ÖV- und Fußwege vorgeschlagen, wenn diese zeitlich vergleichbar mit einer Autofahrt sind.

>>

The Boring Phone

Bierbrauer Heineken verschenkt ein Anti-Smartphone

Da viele Menschen durch Smartphones von echten sozialen Aktivitäten abgelenkt werden, legen Heineken und Bodega 5.000 Exemplare eines einfachen Klapp-Handys als "The Boring Phone" auf.

>>

Vier Smartphones

Huawei stellt die neue Pura-Serie vor

"Pura" statt "P": Huawei hat zunächst für den chinesischen Markt seine neue Flaggschiff-Serie mit den Modellen Pura 70, Pura 70 Pro, Pura 70 Pro+ und Pura 70 Ultra vorgestellt.

>>