02.10.2018

Grundlagen, Tipps, Best Practices

1. Teil: „IT neu gestalten mit Software-defined Storage“

IT neu gestalten mit Software-defined Storage

Autor: Klaus Manhart

Andrey VP / shutterstock.com

Wachsende Datenmassen erfordern neue Speicher-Infrastrukturen. Eigene Hardware ist aber nicht nur kostspielig, sondern häufig auch unflexibel. Eine Lösung verspricht SDS.

Storage wird für Unternehmen zunehmend zum Problem. Die Entwicklungen der vergangenen Jahre – die Verbreitung mobiler Geräte, der Siegeszug sozialer Netzwerke und das Cloud-Computing – haben zu einer Datenexplosion geführt. Die historisch gewachsenen IT-Infrastrukturen können die Datenmassen kaum mehr bewältigen.

Viele Unternehmen erweitern deshalb sukzessive ihre bestehende Storage-Landschaft. Das zieht eine ganze Reihe von Problemen nach sich: So müssen Storage-Nachrüstungen immer wieder erfolgen. Sie sind arbeits- und zeitaufwendig und belasten das IT-Budget. Noch viel dramatischer aber ist: Heute mischen sich die verschiedensten Speichersysteme von HDD über NAS und SAN bis hin zu Flash- und hyperkonvergenten Systemen. Der Zukauf von Storage unterschiedlicher Technologie und Hersteller führt zu Systemen, die sich untereinander – und vor allem mit älteren Systemen – nicht vertragen. Selbst sich auf das Portfolio eines einzigen Herstellers zu beschränken, bewahrt nicht vor Inkompatibilitäten. „Die Speicherverwaltung und Datenmigration zwischen Storage-Hardware unterschiedlicher Hersteller, Modelle und Produktgenerationen stellt eines der größten IT-Probleme für Unternehmen dar“, erklärt George Teixeira, Präsident des Storage-Spezialisten DataCore Software.

Starrer Storage

Die Herausforderungen sind damit noch nicht erschöpft: Da Hardware von Haus aus unflexibel ist, wird oft mehr gekauft, als man eigentlich braucht. Vor allem, um die Leistungs- und Hochverfügbarkeitsanforderungen abzubilden, stellen die IT-Abteilungen sehr oft eine gewisse Überversorgung mit zu viel Speicher und zusätzlichem Redundanz-Level bereit. Die Folge ist eine ineffiziente Auslastung der Kapazitäten. Gleichzeitig sind solche Systeme infolge der komplexen Struktur und Anbindung oft nicht besonders schnell, da eine Fülle von „Flaschenhälsen“ im System lauern, die die Geschwindigkeit drosseln können. Dabei werden im Zuge von Big Data und Analytics die Performance und das Tempo, mit dem Daten bereitgestellt werden, immer wichtiger. Unternehmenskritische Business- und Analytics-Applikationen wie SAP HANA verlangen eine hohe Performance mit entsprechend schnellen Speicherbausteinen wie Flash.

Doch der schnelle Flash-Speicher in Kombination mit herkömmlichem Speicher verkompliziert die Storage-Landschaft weiter. Die jüngeren Innovationen haben zu konvergierten Systemen geführt, zu Flash-Karten, Flash-Arrays und Cloud-Speicher – und letztlich zu Speichersilos und völlig inkompatiblen Systemen.

Modernen Business-Anforderungen nach Tempo, Flexibilität und Zuverlässigkeit ist mit den traditionellen Speicherbausteinen kaum beizukommen. „Mit starren IT-Ressourcen lässt sich die digitale Transformation der Unternehmen und Geschäftsfelder nur unbefriedigend umsetzen“, heißt es in der IDC-Studie „Software-Defined Infrastructure 2016“. Matthias Zacher, Manager Research und Consulting bei IDC und Leiter der Studie, schlägt Alarm: „IT-Verantwortliche müssen jetzt dringend damit beginnen, ihre starren IT-Ressourcen zu flexibilisieren. Tun sie dies nicht, können sie schon bald die Business-Anforderungen nach einem sicheren und reibungslosen IT-Betrieb in zunehmend offenen und heterogenen geschäftlichen Ökosystemen nicht mehr gewährleisten.“

2. Teil: „Was ist Software-defined Storage?“

Was ist Software-defined Storage?

Eine Lösung für die diskutierten Herausforderungen verspricht Software-defined Storage (SDS). SDS-Plattformen verfolgen das Ziel, Speicher-Ressourcen einfach und bedarfsabhängig hinzuzufügen und bereitzustellen. Der physische Speicher wird dabei als unabhängige Ressource zu einem Pool zusammengefasst, der sich über mehrere Systeme erstrecken und unterschiedliche Medien wie SSDs, SAN, NAS oder RAID-Systeme umfassen kann. Der Software-basierte Betrieb von Storage reiht sich damit kohärent in Trends wie Virtualisierung und Hardware-Abstraktion und die Entwicklung hin zum Software-defined Data Center ein.

Der zentrale Punkt dieses Konzepts ist die Trennung von Software und Hardware: Anders als herkömmlicher Speicher sind SDS-Plattformen nicht Hardware-abhängig – vielmehr „abstrahieren“ sie von der Hardware. Das bedeutet: Die Speicherung und die Verwaltung der Daten sind von der darunterliegenden Hardware getrennt, Software und Hardware werden als unterschiedliche, vollständig getrennte Instanzen behandelt.

Die Storage-Software-Plattform stellt Services wie Orchestrierung und Provisionierung sowie Datenschnittstellen bereit und bietet automatisch arbeitende Funktionen für die Verwaltung. Sie lässt sich idealerweise in nahezu jede beliebige Speicher-Infrastruktur integrieren und ermöglicht eine horizontale Skalierung der Ressourcen.

Die Vorteile von SDS

Von einer Software-definierten Speicherinfrastruktur profitieren Unternehmen mehrfach. Die Hardware-Abhängigkeit wird beseitigt, Speicherüber- und -unterprovisionierung entfallen, der Management- und Wartungsaufwand minimiert sich und Automatisierung und Hardware-Unabhängigkeit haben eine deutliche Kostenreduktion zur Folge.

SDS-Spezialist DataCore führt insbesondere folgende Pluspunkte an:

Hardware-Unabhängigkeit: Mit einer SDS-Lösung können sich Unternehmen von proprietären Umgebungen unabhängig machen. Durch die Trennung von Storage-Software und -Hardware müssen Hardware und Software-Teile der Speicherlösung nicht mehr zwingend von demselben Hersteller bezogen werden. Eine SDS-Plattform nimmt Hardware jedes beliebigen Speicher-Anbieters auf – bereits vorhandene Festplattensysteme können ebenso genutzt werden wie neu gekaufter Storage. Speicher unterschiedlicher Hersteller kann miteinander kombiniert werden. Hardware-Unabhänigkeit hat auch den angenehmen Nebeneffekt, dass preisgünstige Standardsysteme mit dem besten Preis-Leistungs-Verhältnis eingesetzt werden können.

Flexible Anpassbarkeit: Storage-Verantwortliche können Software-defined Storage flexibel an sich ändernde Leistungs- und Volumenanforderungen anpassen. Drohende Speicherengpässe entfallen damit ebenso wie Überprovisionierung. Sollten Kapazitäten für neue Aufgaben nicht ausreichen, kann Hardware schnell hinzugefügt werden, denn die Leistungsmerkmale werden von der Software bereitgestellt. Analog kann zu viel Storage leicht wieder entfernt werden.

Speicheroptimierung: Um möglichst anpassungsfähig und effizient zu sein, werden in das SDS-System unterschiedliche Datenträger mit verschiedenen Leistungsmerkmalen eingebaut – zum Beispiel Flash-Speicher, SSD, HDD oder Netzwerkspeichersystem. Bei diesem „Storage Tiering“ speichert das System oft verwendete Dateien auf teuren, aber schnellen Speichergeräten, weniger häufig genutzte Dateien werden auf preisgünstigeren, aber langsameren Datenträgern abgelegt. Nicht mehr genutzte Daten können optional auf Band archiviert werden.

Die Software-Basierung macht es Administratoren auch leicht, schnellen Flash-Speicher einfach in die bestehende Infrastruktur zu integrieren. Über die Software lässt sich festlegen, wie Flash eingesetzt wird. Beispielsweise kann es als lokaler Speicher oder als gemeinsam genutzter Arbeitsspeicher verwendet werden. SDS macht das Rechenzentrum damit auch fit für Hochleistungs- und Cloud-Umgebungen, in denen riesige Datenmengen schnell einer Vielzahl von Anwendern zur Verfügung gestellt werden müssen.

Einfaches Management: Mit SDS müssen isolierte Storage-Systeme nicht mehr zeitaufwendig verwaltet werden. Die Administration der kompletten Speicherumgebung wird zentralisiert durchgeführt, der Storage wird über eine Plattform gemanagt. Über diese Plattform lassen sich viele Prozesse wie Hochverfügbarkeit oder Deduplizierung automatisieren. Der Storage-Verantwortliche kann Speicher dem Bedarf einzelner Abteilungen entsprechend zuweisen. Leistungsmerkmale wie Deduplikation, Thin Provisioning oder Storage Tiering unterstützen dabei, die Ressourcen effizient zuzuweisen. Erforderliche Kapazitäten können dem Ressourcen-Pool hinzugefügt werden – ebenso wie Cache, Schnittstellen oder Prozessoren.

Automatisierung: Viele Standardaufgaben lassen sich mit SDS automatisieren oder können vom Endnutzer übernommen werden. Der Mitarbeiter legt zum Beispiel fest, welche Kapazität er braucht und ob das Datenmaterial gespiegelt oder mit Snapshots geschützt werden soll. Im Idealfall klickt sich der Anwender die benötigten Eigenschaften für seinen Speicher über ein Selfservice-Portal zusammen, die Software erledigt den Rest automatisch. Anschließend erhält er einen auf seinen Bedarf zugeschnittenen Speicher vom System zugewiesen.

Kosten: Wegen der Flexibilät lassen sich Hardware-Bestände längere Zeit nutzen. In der Regel kommt SDS zudem mit weniger Storage aus. Das wiederum spart Server-Raum und Kühlungsbedarf, Wartungsaufwand und Elektrizität – und dadurch Kosten. Auch die Automatisierung trägt zur Kostenreduktion bei. „Für IT-Organisationen in der digitalen Transformation bietet SDS eine gute Möglichkeit, die benötigten Anforderungen abzudecken – flexible IT-Agilität, einfachere und intuitivere Administration und niedrigere Kosten“, erklärt Eric Burgener, Research Director bei IDC.

3. Teil: „Wann bietet sich ein Umstieg an?“

Wann bietet sich ein Umstieg an?

Angesichts des Nutzens ist es nicht erstaunlich, dass Software-defined Storage laut IDC eine der am stärksten wachsenden Technologien im IT-Bereich ist und zum neuen Standard bei der Gestaltung von Speicherarchitekturen werden könnte. Für 2017 bis 2021 sagen die IDC-Analysten eine mittlere Wachstumsrate von 13,5 Prozent voraus.

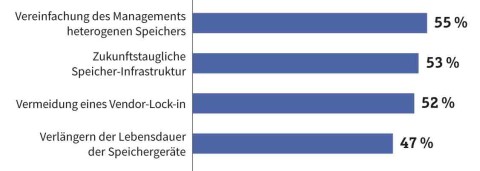

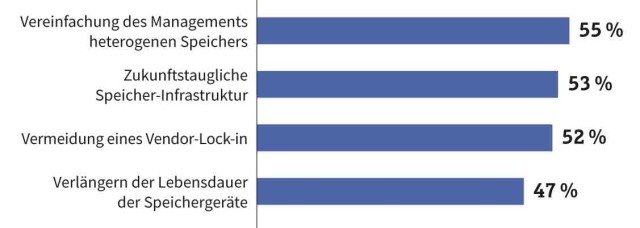

Ähnlich lautet der Befund in der Studie „State of Software-Defined Storage“, für die der SDS-Vorreiter DataCore seine Anwender befragt hat. Danach gaben 16 Prozent der Befragten an, 2017 zwischen 11 und 25 Prozent ihres Storage-Etats für SDS eingeplant zu haben, weitere 13 Prozent hatten mehr als 25 Prozent dafür reserviert.

Dass sich ein Umstieg auf Software-defined Storage lohnt, hat sich bei vielen Unternehmen also bereits herumgesprochen. Was allerdings jedes Unternehmen individuell beantworten muss, ist die Frage, wann denn der optimale Zeitpunkt dafür ist. Prinzipiell ist die Einführung einer SDS-Lösung jederzeit möglich – es gibt jedoch Gelegenheiten, zu denen sich das besonders anbietet.

Anschaffung von Hardware: An eine Migration auf Software-defined Storage sollte etwa denken, wer sowieso gerade Storage-Hardware zukaufen oder neu anschaffen will. Dann spricht einiges dafür, den alten Speicher zu behalten und das Budget stattdessen in Software-definierten Storage zu stecken. Die alten Speicherkomponenten lassen sich unter SDS weiter nutzen, die Investitionen bleiben so erhalten – und falls nötig lässt sich die bestehende Hardware unter SDS immer noch ergänzen.

Integration von Flash- und SSD-Speicher: Wer Flash-basierte Speicherprodukte einsetzt, ist auf dem besten Weg zum Software-defined Storage – selbst wenn es dabei „nur“ um die Beschleunigung einer Applikation geht, sagt IDC. In diesem Fall ist es ohnehin erforderlich, sich mit Storage Tiering und der dynamischen und automatischen Verteilung der Daten auf geeignete Datenträger zu befassen. Wer gleich auf SDS umsteigt, schlägt zwei Fliegen mit einer Klappe: SDS beherrscht Storage Tiering und sorgt für die Einbindung aller anderen Speichersysteme.

Erweiterung der Server- oder Desktop-Virtualisierung: Bei der Einführung oder Erweiterung von Server- oder Desktop-Virtualisierung ist eine Umstellung auf SDS ebenfalls sinnvoll. SDS fügt der Virtualisierung eine dritte Dimension hinzu, komplettiert die laufenden Virtualisierungsansätze und optimiert vorhandene und neue Speicher-Ressourcen. Der Vorstoß von VMware in Sachen Speichervirtualisierung dürfte so manches Unternehmen einen Schritt in Richtung SDS machen lassen.

Umstrukturierung von Ausfallsicherheit und Wiederherstellung: Wer Pläne für Ausfallsicherheit und Notfallwiederherstellung entwickelt oder anpasst, sollte ebenfalls auf SDS umsteigen. SDS-Umgebungen liefern mit synchroner Spiegelung, hoch performantem Caching und virtuellem Disk-Pooling eine optimale Auslastung vorhandener Strukturen. Gleichzeitig garantieren sie durchgängige Verfügbarkeit.

4. Teil: „Auswahlkriterien für SDS“

Auswahlkriterien für SDS

Bei der Anschaffung einer SDS-Lösung gilt es, einige Faktoren zu beachten, die im Folgenden aufgelistet sind.

Hardware-Bindungen: Hardware-Bindungen von SDS-Lösungen sollten vermieden werden, weil sie Abhängigkeiten schaffen. Je größer sie sind, desto geringer ist die Möglichkeit, technische Innovationen zu nutzen. Eine wichtige Frage lautet deshalb: Bin ich mit der SDS-Lösung wirklich Hardware-unabhängig?

Hardware-Nutzung: Wichtig ist, darauf zu achten, dass die Hardware optimal genutzt werden kann. Nicht alle SDS-Lösungen verwenden beispielsweise Caches und Puffer effektiv und ermöglichen den Zugriff auf Drittprodukte. Manche SDS-Anbieter schränken die Möglichkeiten des Anwenders ein, die preisgünstigsten oder die performantesten Storage-Komponenten zu nutzen.

„Zertifizierte“ Komponenten: Obwohl das nicht der SDS-Philosophie entspricht, verlangen manche SDS-Lösungen, dass „veralteter“ Speicher durch zertifizierte Komponenten ersetzt wird. Das treibt die Kosten für Aufbau und Betrieb einer SDS-Umgebung nach oben.

Verfügbarkeit: Wichtig ist, dass die Funktionen für das Clustern beziehungsweise Spiegeln von Daten stabil arbeiten. Sie sollten daher getestet werden. Dabei sollte die favorisierte Lösung möglichst einfach gestrickt sein und kurzfristige Überprüfungen von Spiegelungsprozessen ermöglichen. Am besten wird das Failover automatisch durchgeführt. Hier sollte gecheckt werden, ob nach dem Auftreten eines Failovers ein Failback möglich ist.

Performance: Die Beschleunigung von Speicherbausteinen sollte unterstützt werden. Die Verwendung speicherbasierter Caches und Puffer ermöglicht, die Geschwindigkeit von Anwendungen zu steigern.

Kompatibilität: Die SDS-Lösung muss zu unterschiedlichen Hypervisoren und nicht virtualisierten Anwendungen und deren Speicheranforderungen kompatibel sein. Je nach Auslastung, Arbeitslast und Umgebungsbedingungen können bestimmte SDS-Modelle besser für eine Situation geeignet sein als andere.

Verwaltbarkeit: Für die Handhabung der Storage-Systeme sollte eine SDS-Lösung Verwaltungsfunktionen bereitstellen. Sie fassen die ursprünglich von Storage-Herstellern angebotenen Mehrwertdienste in einer Zentrale zusammen, die die Steuerung von Datenspiegelung und -replikation, Thin Provisioning, Deduplikation und Kompression sowie vielen weiteren Funktionen erlaubt.

Tauglichkeit: Damit ist gemeint, wie gut eine SDS-Lösung in die Umgebung passt, in die sie eingebunden werden soll. Das beginnt bei der Stellfläche der Plattform und endet bei Anforderungen für Lärmschutz, Stromversorgung, Heizung und Klima. All diese Faktoren können von großer Wichtigkeit sein.

5. Teil: „Tipps für den Einsatz“

Tipps für den Einsatz

Laut IDC implementieren viele SDS-Anbieter nur einen Teil der möglichen SDS-Funktionalitäten. Mit solchen Lösungen gehen IT-Leiter das Risiko ein, isolierte SDS-„Inseln“ zu schaffen – ein SDS-Produkt für virtuelle SANs, eines für einen spezifischen Hypervisor, eines für Flash-Geräte, eines zum Verwalten von heterogenen Speicher-Arrays und so fort. Dann werden die IT-Verantwortlichen bald feststellen, dass sie ihre Inseln konsolidieren müssen, um höhere Levels bei Einsparungen und operativer Effizienz zu erreichen.

Zu bedenken ist auch, dass die Vorteile von SDS sich nur nutzen lassen, wenn die Lösung die gesamte Speicher-Infrastruktur inklusive DRAM-Caches, Flash, Festplatten-Subsystemen und Cloud unter einem Verwaltungs-Regime zusammenfasst. Es empfiehlt sich, eine umfassende SDS-Lösung anzuschaffen und sich nicht auf Punktlösungen des „Haus- und Hoflieferanten“ von Speicher-Hardware oder des Hypervisor-Anbieters einzulassen.

Als Königsweg für den SDS-Einstieg empfehlen Analysten außerdem: klein anfangen und für umfassende Skalierbarkeit sorgen.

Viele Unternehmen verwalten ihre Speichersysteme getrennt nach Herstellern und Produkten. Der größte Vorteil der Umstellung auf eine Software-defined-Storage-Architektur ist die Fähigkeit, unterschiedliche Speicher-Ressourcen zu vereinigen. Somit können Daten auf jeder physischen oder logischen Ressource gespeichert und zwischen Ressourcen automatisch und unterbrechungsfrei bewegt werden.

Auf diese Weise lassen sich Speicher-Ressourcen für Applikations- und Projektverantwortliche über ein Selfservice-Portal zur Verfügung stellen, was Einsparungen beim Betrieb der Storage-Infrastruktur ermöglicht. „SDS ist ein völlig anderer Ansatz für das Management von Storage. Man muss seine Denkweise ändern – und von der Hardware, die ein zentraler Aspekt im Unternehmen ist, auf eine bloß unterstützende Rolle der Hardware abstrahieren“, erläutert Shawn Smucker, Produktmanager beim Datensicherungsanbieter Commvault.

Mark Schulte, Senior Consultant bei IDC, sieht in Software-defined Storage eine Schlüsselkomponente einer servicebasierten Infrastruktur: „Wie in der Server-Welt sollte es beim Storage möglich sein, eine Abstraktionsschicht und eine einheitliche Präsentationsschicht über mehrere Ressourcen unterschiedlicher Hersteller zu legen. Das erlaubt es wiederum, Komponenten in Abhängigkeit vom Bedarf zu beschaffen, hinzuzufügen, bereitzustellen und deren Nutzung zu messen“, führt er in einem Beitrag für „IT-Business“ aus.

6. Teil: „„Reines“ und „unreines“ SDS“

„Reines“ und „unreines“ SDS

„Software-defined“ ist kein geschützter Begriff. Die meisten heute erhältlichen Speicherlösungen seien nicht Software-defined Storage, sondern schlicht „Software on Storage“, kritisierte Tony Parkinson, Vice President Enterprise Solutions von Dell, vor einiger Zeit auf einer Podiumsdiskussion in Amsterdam. Damit lag er nicht ganz falsch. Denn nicht wenige Storage-Hardware-Anbieter springen auf den SDS-Zug auf und verwenden den Begriff Software-defined auf ihre Hardware-bezogenen Produkte. Sie nutzen die Grundlagen von SDS – die Abstraktion der Software von der Hardware –, kombinieren die Software aber mit ihrer spezifischen Hardware. Im Sinne der „reinen Lehre“ ist das kein SDS. Diesem herstellerspezifischen SDS stehen die „echten“ Software-Produkte gegenüber, also das, was originär mit SDS gemeint ist. Hersteller dieser Kategorie stellen Software ohne zugehörige Hardware zur Verfügung. Hardware-Abhängigkeit gibt es dort nicht. Diese Produkte erlauben eine individuelle Storage-Zusammenstellung – sei es aus bestehenden Speicher-Ressourcen oder aus neuen, eigens konzipierten Arrays. Anbieter, die diesen Ansatz verfolgen, sind reine Software-Hersteller, etwa DataCore, einer der Pioniere im SDS-Umfeld. Seine Software SANsymphony lässt sich in heterogenen Umgebungen hoch skalieren und bringt umfassende Funktionen mit. Kleinere Anbieter sind FalconStor mit dem Network Storage Server (NSS), Nexenta Systems und StarWind Software.

Als Anbieter von SDS mit Hardware-Bindung treten vor allem klassische Storage-Hersteller auf, die damit ihre Produkte flexibilisieren. Dazu zählen zum Beispiel Dell EMC, IBM, HPE und zahlreiche kleinere Hersteller wie NetApp.

Dieser Ansatz gilt zwar nicht als „echtes“ SDS, manche Anwender schätzen ihn aber trotzdem: Es ermöglicht dem Hersteller – und damit auch dem Kunden – schneller zu neuen Hardware-Technologien zu wechseln. Auch wenn viele SDS-Puristen ein Problem mit diesen gebündelten SDS-Offerten haben, gehören sie zum Bild von Software-defined Storage dazu. Diese Produkte ermöglichen Kosteneinsparungen und bieten eine hohe Flexibilität bei Hardware-Migrationen. Wie groß die jeweiligen Vorteile sind, hängt vom Anbieter ab.

Ob reines oder unreines SDS – über eines müssen sich die IT-Manager eines Unternehmens im Klaren sein, wenn sie eine solche Lösung einführen, gibt Andrew Hatfield, Leiter Cloud-Storage bei Red Hat, zu bedenken: „Mit ziemlicher Sicherheit werden Sie von Ihrem bestehenden Storage-Team gebremst. Aber das beruht meistens eher auf unangebrachtem Eifer und Vorurteilen als auf echtem Verständnis. Man kann das den alteingesessenen Storage-Experten auch nicht verübeln. Sie haben ihre gesamte Karriere um einen oder zwei Storage-Anbieter herum aufgebaut – und jetzt verändert sich die Welt.“

Personalien

Komsa stellt sich im Solution-Segment neu auf

Der Distributor richtet sein UC- und Cloud-Business neu aus und stellt mit Christof Legat einen neuen Vice President UC-Solutions vor, Friedrich Wahnschaffe ist als Vice President für das MS-Cloud-Geschäft von Komsa in Deutschland verantwortlich.

>>

Untersuchung

Amerikaner sehen KI als Risiko für Wahlen

Die Unterscheidung zwischen echten Infos und KI-Inhalten fällt vielen politisch interessierten US-Amerikanern schwer, wie eine Studie des Polarization Research Lab zeigt.

>>

Roadmap

Estos bringt neue Services und Produkte

Der Software-Hersteller feilt an seinem Partnerprogramm, hat Schlüsselpositionen neu besetzt und kündigt eine ganze Reihe neuer Produkte und Services an. Das ist die Estos-Roadmap bis Ende des Jahres.

>>

Data Warehouse

Datenbanken besser aufsetzen mit Data Vault

Christoph Papenfuss vom finnischen Datenspezialisten Agile Data Engine gibt eine Einführung in Data Vault: Eine skalierbare und flexible Lösung für komplexe Datenumgebungen.

>>