06.12.2019

Marschroute Digitalisierung

1. Teil: „Die IT-Landschaft im Jahr 2020“

Die IT-Landschaft im Jahr 2020

Autor: Konstantin Pfliegl

Shutterstock / artskill2k17

Die digitale Transformation bewegt deutsche Unternehmen auch 2020: Diese Trends und Themen rund um die Digitalisierung werden nächstes Jahr für CIOs und CDOs besonders wichtig sein.

Neues Jahr, neue IT-Trends. Wie zu jedem Jahreswechsel machen die Prognosen zahlreicher Analysten und IT-Experten auch diesmal wieder die Runde – mit wichtigen Entwicklungen, die Unternehmen 2020 keinesfalls verpassen sollten. Neben Dauerbrennern wie Cloud oder Big Data stehen verschiedenste neue Technologien im Fokus. Doch was ist wirklich wichtig, was „heiße Luft“, und was wird erst in einigen Jahren relevant?

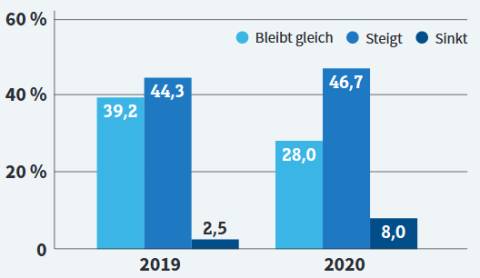

Vor allem für den Mittelstand, zu dem mehr als 99 Prozent der Firmen in Deutschland zählen, ist das nicht leicht zu entscheiden. Die meisten Unternehmen stecken noch mitten in der digitalen Transformation und sind damit vollauf ausgelastet. So hat im Bereich der IT der Ausbau der Digitalisierung für mehr als 70 Prozent der Unternehmen in Deutschland, Österreich und der Schweiz laut einer aktuellen IT-Trends-Studie des Beratungsunternehmens Capgemini oberste Priorität.

Und das lassen sich die Firmen auch einiges kosten: Sie investieren in die digitale Transformation durchschnittlich knapp ein Viertel ihres gesamten IT-Budgets. Bei Großunternehmen ab einer Milliarde Euro Jahresumsatz sind es sogar 30 Prozent, die für die Digitalisierung ausgegeben werden.

Ein großes Problem der Digitalisierung ist – trotz ihrer vielen Vorzüge – die damit einhergehende Ausdifferenzierung der IT-Landschaft. So klagt rund ein Viertel der Unternehmen über eine starke Zunahme der Komplexität. Da ist es durchaus verständlich, dass Unternehmen zögern, bevor sie auf eine weitere neue Technologie setzen.

Wenn es um die Einführung neuer Technologien geht, lässt man sich im deutschen Mittelstand daher gerne Zeit und überlegt ganz genau, welchen Nutzen sie für die eigene Unternehmensstrategie haben.

2. Teil: „Alte neue Trends“

Alte neue Trends

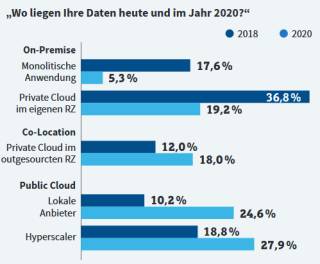

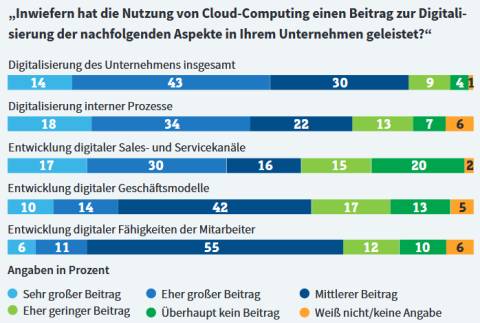

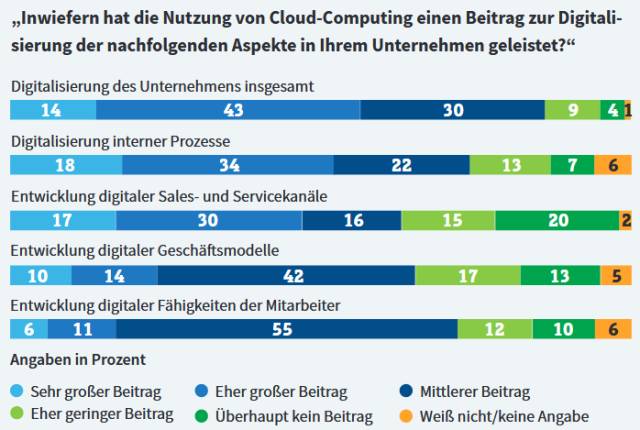

Dass viele Technologien wie Cloud, Künstliche Intelligenz (KI) oder das Internet of Things (IoT) quasi schon zur Grundausstattung einer modernen IT-Landschaft gehören, ist eine Binsenweisheit. „Technologien wie Cloud und Künstliche Intelligenz haben ihren reinen Trendstatus hinter sich gelassen und sind mittlerweile fest verankert“, bestätigt Peter Hanke, Senior Director DACH beim Speicherspezialisten NetApp. Das belegen auch die Zahlen: So setzten laut „Cloud-Monitor 2019“ von KPMG und Digitalverband Bitkom im vergangenen Jahr bereits 73 Prozent der deutschen Unternehmen auf die Cloud – lediglich für 8 Prozent der befragten Firmen war die Cloud kein Thema.

Bernhard Kube, Vice President Technology Consulting und CTO beim IT-Dienstleister Lufthansa Industry Solutions, sieht diese Technologien zwar ebenfalls in den Unternehmen angekommen, „jedoch werden sie noch lange nicht überall systematisch, sondern oft nur punktuell eingesetzt.“ Für 2020 erwartet Kube statt neuer Technologien daher eher eine Konsolidierung und eine zunehmende Vernetzung verschiedener Themen sowie eine Fokussierung auf Prozesse.

Ganz ähnlicher Auffassung ist Werner Schwarz, Vice President Corporate Strategy & Innovation beim IT-Dienstleister Cancom. Auch ihm zufolge sind Themen wie Cloud oder KI in den Unternehmen präsent. Seine Erfahrung zeige allerdings, dass deren Potenzial noch bei Weitem nicht ausgeschöpft werde. Er sieht noch viel Arbeit hinsichtlich der Vernetzung dieser Technologien: „Die Innovation liegt weniger in einer neuen Technologie an sich, sondern vielmehr in der Kombination und Integration bestehender Technologien.“

Die relevanten Technologien seien grundsätzlich vorhanden, bei der Umsetzung entlang konkreter Use Cases gebe es jedoch noch eine Vielzahl ungenutzter Möglichkeiten – „im nächsten Jahr wird daher die Integration dieser Bereiche für Unternehmen ein Kernthema“, ist Schwarz überzeugt.

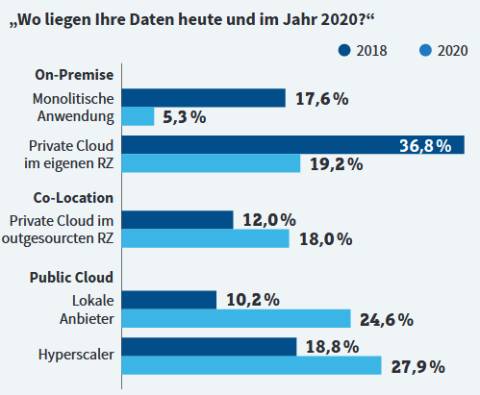

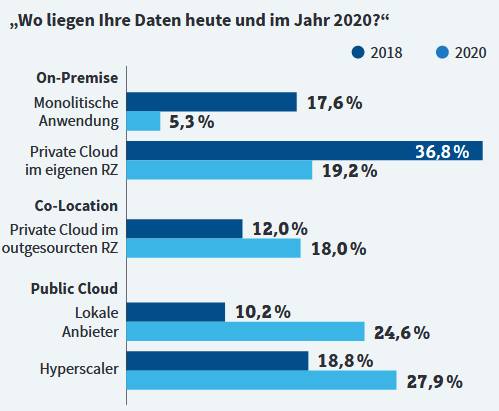

Doch was hat es mit der noch nicht vollständig erfolgten Vernetzung und Integration von Technologien auf sich? Ein Beispiel ist auch hier wieder die Cloud-Technologie, die zwar bereits häufig eingesetzt, aber in vielen Fällen nur als Insellösung für einzelne Bereiche genutzt wird. Die Analysten von IDC prognostizieren, dass bis 2022 rund 70 Prozent der Unternehmen weltweit ihre Public und Private Clouds über einheitliche Hybrid- beziehungsweise Multi-Cloud-Management-Technologien, -Tools und -Prozesse zusammenführen. Nur so könnten Unternehmen in einer „Digital-first-Wirtschaft“ bestehen. Digitale Anwendungen müssten überall und jederzeit laufen können, was eine entsprechend stärkere Integration von Anwendungen, Daten und Management über alle Cloud-Anbieter und -Standorte hinweg erfordere. Die Einschätzung von Eric Berg, Global Subject Lead Cloud Platform bei SoftwareONE, Anbieter einer Plattform zur Organisation von Software-Lizenzen, lautet: „Inzwischen hat wohl jedes Unternehmen von KI oder IoT gehört. Allerdings wird es noch eine Weile dauern, bis Unternehmen diese Themen bei sich integrieren und somit Prozesse und Produkte

optimieren.“

optimieren.“

Werner Schwarz von Cancom ergänzt, dass es für Unternehmen wichtiger denn je sei, agil und reaktionsschnell zu sein, um auf Trends und dynamische Märkte optimal und effizient reagieren zu können. Insbesondere die bekannten Themen Cloud, KI und IoT böten hier vielfältige Mehrwerte. „Nicht zuletzt deshalb wird deren Bedeutung auch in den nächsten Jahren weiter zunehmen“, so sein Resümee. Und: Diese Bedeutung beziehe sich in erster Linie auf die Nutzbarkeit und die konkreten Use Cases. „Jede Technologie ist ein einzelner Baustein, der für sich alleine bereits wichtige Impulse entlang der Wertschöpfung eines Unternehmens erbringen kann. Kombiniert man diese Technologien jedoch miteinander, erhält man ganzheitliche, integrierte digitale Lösungsansätze, mit denen Unternehmen zukunftssicher und agil aufgestellt sind.“ Hier gilt seiner Ansicht nach der klassische Ansatz: „Das Ganze ist mehr als die Summe seiner Teile.“

3. Teil: „Blockchain-Frust“

Blockchain-Frust

Eine Hype-Technologie, von der man zurzeit eher weniger hört, ist die Blockchain. Eine Blockchain ist, knapp gesagt, ein dezentrales Protokoll für Transaktionen, das jede Veränderung transparent erfasst.

Die Blockchain steckt nun schon seit rund zehn Jahren in der Entwicklung und hat sich auch 2019 noch nicht wirklich etabliert. Laut Gartners Hype Cycle ist die Blockchain-Technologie derzeit gar im „Tal der Enttäuschungen“ angekommen – bei vielen Unternehmen macht sich Ernüchterung breit, die hohen Erwartungen konnte die Blockchain bislang nicht erfüllen. Zunehmend sind kritische Stimmen zu hören, die fragen, wann die Technologie denn nun endlich an Fahrt aufnimmt.

Bernhard Kube von Lufthansa Industry Solutions geht indes von einer Renaissance der Blockchain aus. Auch wenn der erwartete große disruptive Charakter von Blockchain noch auf sich warten lasse, etabliere sich die Blockchain-Technologie mittlerweile als architektureller Baustein für spezifische Aufgabenstellungen auch im Business-Kontext. Beispiele in der Praxis seien vermehrt Applikationskontexte, in denen eine vertrauenswürdige Kommunikation mittels Blockchain in der IoT-Kommunikation oder allgemein in der Datenkommunikation zwischen Unternehmen und im Zusammenspiel mit Behörden implementiert werde.

Auch Gartner schreibt die Blockchain keineswegs ab. Sobald die Technologie praxistauglich werde, sei sie durchaus in der Lage, diverse Branchen komplett umzugestalten.

Dauerbrenner Sicherheit

„Same procedure as every year“ – auf kaum etwas ist so sehr Verlass wie auf das Thema Sicherheit. Die Bedrohungslage durch Cyberangriffe wird sich auch im kommenden Jahr nicht entspannen – ganz im Gegenteil. So bleibt Sicherheit auch 2020 eine der wichtigsten Baustellen für IT-Verantwortliche.

Laut dem aktuellen IT-Sicherheitsbericht des Bundesamts für Sicherheit in der Informationstechnik (BSI) zählen Infektionen durch Schadprogramme derzeit zu den größten IT-Bedrohungen für Unternehmen. Ein Beispiel hierfür sind Ramsomware-Angriffe, bei denen Kriminelle Unternehmensdaten verschlüsseln und Lösegeld für die Herausgabe des Entschlüsselungscodes fordern. Hinzu kommt die Bedrohung durch Bot-Netze, mit denen sich enorme Ressourcen für Distributed-Denial-of-Service-Angriffe (DDoS) aktivieren lassen. Dem BSI zufolge erreichen DDoS-Angriffe Bandbreiten von bis zu 300 GBit/s – damit lässt sich so mancher Server innerhalb kürzester Zeit in die Knie zwingen.

„So schnell wie sich die Cloud entwickelt, so schnell entwickeln sich auch die Bedrohungen“, fasst Eric Berg von SoftwareONE die Situation zusammen. Für viele Unternehmen werde es zunehmend schwierig mitzuhalten, um auf dem neuesten Stand zu bleiben. Der Grund liege, so Berg, unter anderem darin, dass viele Unternehmen die IT oft nur als Mittel zum Zweck sähen, um ihr eigentliches Business voranzutreiben. Dabei komme Security häufig zu kurz. Die immer schneller auftretenden Bedrohungen erforderten umso bessere Schutz- und Verteidigungsmechanismen. Besonders bei Cloud-Services ist seiner Erfahrung nach jedoch nach wie vor der Irrglaube einer „Security out of the Box“ verbreitet. Bei heutigen Cloud-Diensten sei es aber immer noch üblich, dass es in der Verantwortung des Kunden liege, seine dort abgelegten Unternehmensdaten zu schützen.

Gefahrenquelle IoT: Vor allem auch die wachsende Verbreitung des Internet of Things bringt neue Angriffsziele mit sich. „Diese immer stärkere Vernetzung geht zulasten der Sicherheit: Denn mit zunehmender Vernetzung wird es nahezu unmöglich, den Schutz jedes einzelnen Geräts zu gewährleisten“, warnt Minas Botzoglou, Regional Director Sales DACH bei Delphix, einem Spezialisten für die Organisation von Unternehmensdaten. Hackern falle es so immer leichter, sich an Security-Schwachpunkten zu bedienen. „Nicht unbegründet, wird dementsprechend das grundlegende Misstrauen gegenüber allen Geräten, die mit dem IoT verbunden sind, im kommenden Jahr weiter zunehmen.“ Sicherheit spiele daher eine entscheidende Rolle: KI und neue Methoden der Netzwerksegmentierung müssten genutzt und weiterentwickelt werden, um verdächtige Aktivitäten und Hacks im wachsenden Meer von Geräten automatisch zu entdecken und abzuwehren.

Security Operations Center: Wie aber gehen Unternehmen den Schutz ihrer Daten und Geräte praktisch an? Eine Lösung sind sogenannte Security Operations Center. Dabei handelt es sich um eine Art Leitstelle, die sich um den Schutz der IT-Infrastruktur kümmert. Dazu überwachen und analysieren Mitarbeiter und Systeme unter anderem die Unternehmensnetzwerke, Server oder Clients. Die Arbeitsbereiche eines SOCs gliedern sich meist in Monitoring und Analyse sowie in ein Security Information and Event Management (SIEM). Letzteres untersucht unter anderem die zahlreichen Protokolldateien nach Auffälligkeiten.

Ein solches Security Operations Center kann man als Unternehmen selbst inhouse aufbauen oder sich an einen externen Dienstleister wenden, der von außen mit seinem Security Operations Center die IT-Sicherheit des Unternehmens überwacht. In der Praxis scheitern viele Unternehmen daran, ein eigenes SOC zu betreiben, da dies mit hohem Aufwand und Kosten verbunden ist. Zudem müssen effiziente Automatisierungs-Tools für die Analyse und Auswertungen der zahlreichen Daten vorhanden sein, ebenso ein durchgehender 24/7-Betrieb, der natürlich auch die entsprechenden Fachkräfte erfordert. Für ein Unternehmen ist dies kaum rentabel zu erbringen, zumal die Fachkräfte derzeit auch noch schwer verfügbar sind.

Auch Bernhard Kube von LH Industry Solutions hebt hervor, dass „Unternehmen, die diese Aufgaben allein meistern wollen, vor erheblichen und häufig kaum leistbaren Herausforderungen stehen“. Er hält daher die Nutzung professioneller SOCs für eine sinnvolle Lösung. Unternehmen sollten jedoch bei Beauftragung eines externes Dienstleisters „sehr darauf achten, welche Daten sie wem zur Verfügung stellen und ob der avisierte Partner auch versteht, was im konkreten Business-Kontext ein normales und unnormales Applikations- beziehungsweise Systemverhalten ist“. Ungenaue Diagnosen, schlechtes Lastverhalten oder Fehlalarme würden ansonsten nur unnötige Kosten produzieren und verstellten schlimmstenfalls den Blick auf wichtige Hinweise, die einen Angreifer enttarnen.

Cyber Resilience: Um sich gegen aktuelle und zukünftige Bedrohungen bestmöglich zu wappnen, sollten Unternehmen im Idealfall einen Zustand der sogenannten Sustainable Cyber Resilience anstreben, also der nachhaltigen Widerstandsfähigkeit. „Dabei geht es darum, die Angriffsfläche zu verringern und Maßnahmen zu ergreifen, um auch im Fall einer erfolgreichen Attacke betriebsfähig zu bleiben“, erklärt Dirk Schrader, Cyber Resilience Strategist & CMO bei Greenbone Networks, einem Dienstleister für Netzwerksicherheit.

Cyber Resilience ist ein übergreifendes Konzept, das mit der Identifikation und Bewertung von Risiken zu tun hat und über IT-Security hinausgeht. Dabei gilt es, drei Dimensionen zu berücksichtigen: Menschen und Kultur, Prozesse und Organisation sowie Technologie und Infrastruktur. Die Dimensionen sind voneinander abhängig und interagieren miteinander. „Der erste Schritt auf dem Weg zu Resilienz ist, zu akzeptieren, dass es keine 100-prozentige Sicherheit vor Cyberangriffen geben kann“, erklärt Dirk Schrader. Menschen machten nun einmal Fehler und auch Systeme seien nie völlig ohne Schwachstellen. Unternehmen sollten daher potenzielle Angriffspunkte analysieren und Prozesse definieren, die den Risiken angemessen und wirtschaftlich vertretbar sind.

Das sind jedoch keine IT-, sondern vielmehr Management-Aufgaben, das heißt, Resilienz muss auf oberster Ebene angesiedelt werden. Nur wenn Unternehmen das Thema zur Chefsache erklären und alle drei Dimensionen berücksichtigten, machen sie sich im kommenden Jahr widerstandsfähig gegen Cyberangriffe.

4. Teil: „AI PaaS“

AI PaaS

Ohne KI geht nichts mehr – so die Vorhersage der IDC-Marktforscher für die kommenden Jahre. Bis 2025 werden 90 Prozent der neuen Unternehmensanwendungen in irgendeiner Form Künstliche Intelligenz verwenden, lautet die Prognose. Die meisten Anwendungen nutzen laut IDC dabei KI für schrittweise Verbesserungen, um Anwendungen intelligenter und dynamischer zu machen. Disruptive, hauptsächlich auf Künstlicher Intelligenz basierende Anwendungen werden den Analysten zufolge deutlich länger brauchen, bis sie entwickelt sind und auf dem Markt ankommen. Hier gehen die Marktforscher davon aus, dass sie bis 2025 gerade einmal 10 Prozent der gesamten Unternehmens-Anwendungen ausmachen werden.

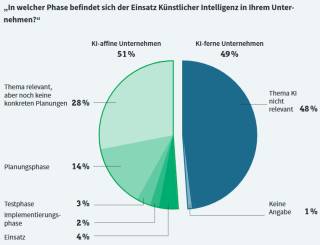

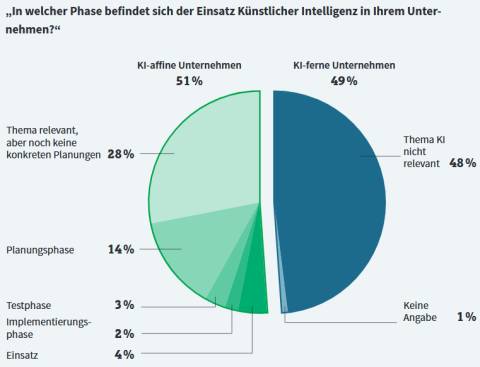

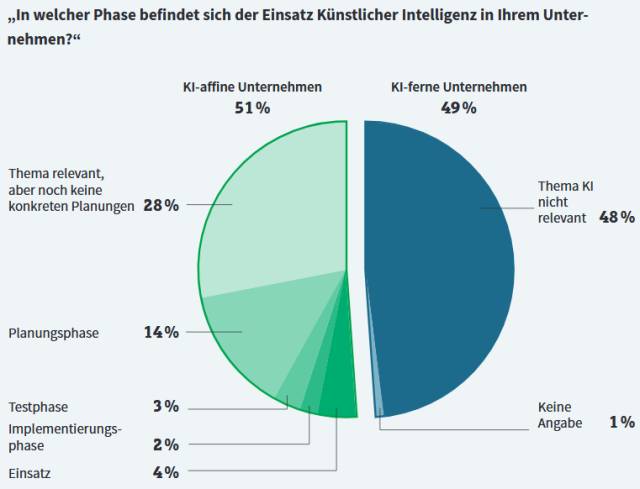

Blickt man in die Praxis, sind die Zahlen in Sachen Künstlicher Intelligenz insgesamt eher ernüchternd: Lediglich 4 Prozent der Unternehmen in Deutschland setzen KI ein, 2 Prozent implementieren derzeit KI-Systeme, 17 Prozent planen KI-Einsätze oder testen sie und 28 Prozent halten KI für relevant, planen jedoch keinen Einsatz. Überraschend sind vor allem diejenigen 48 Prozent der befragten Unternehmen, die KI für das eigene Unternehmen als „nicht relevant“ einstufen. Das sind Ergebnisse der Studie „Künstliche Intelligenz in Unternehmen“ des Beratungshauses PricewaterhouseCoopers.

Keine Frage, der Einsatz von Künstlicher Intelligenz stellt eine große Herausforderung dar. So benötigen Unternehmen dafür eine betriebsweite Strategie, um die Unternehmens-IT entsprechend vorzubereiten. Die Implementierung Künstlicher Intelligenz erfordert nicht selten auch eine neue IT-Infrastruktur, etwa weil riesige Datenmengen miteinander in Verbindung gebracht werden müssen. Hinzu kommt, dass auch die organisatorischen Voraussetzungen geschaffen werden müssen und sich die Fach- und Führungskräfte eine Wissensbasis im Bereich KI aneignen müssen. Doch der Aufwand lohnt: Künstliche Intelligenz bietet in Bereichen wie Kundenservice, Marketing und Vertrieb sowie in der Produktion und der Entwicklung enorme Möglichkeiten für Effizienzsteigerungen und neue Geschäftsmodelle.

Artificial Intelligence Platform as a Service (AI PaaS): Die Einstiegshürden für die Nutzung intelligenter Anwendungen werden erfreulicherweise immer niedriger – dank AI PaaS. Die Marktforscher von Gartner sehen darin einen der Megatrends der kommenden Jahre und so etwas wie den „Enabler“ für die Massenverbreitung von KI. Artificial Intelligence Platform as a Service sind Plattformen für maschinelles Lernen und Künstliche Intelligenz aus der Cloud. Der Markt bietet hierfür bereits heute eine Vielzahl ausgereifter Lösungen, unter anderem von den großen Hyperscalern Amazon, Google, IBM und Microsoft.

Entwickler und Datenwissenschaftler können mit Hilfe dieser Cloud-Dienste KI-Anwendungen ohne hohe Kosten oder Investitionen in neue Hard- und Software direkt ausprobieren und so abklären, ob der Einsatz Künstlicher Intelligenz im eigenen Unternehmen sinnvoll ist. Bernhard Kube von Lufthansa Industry Solutions sieht in AI PaaS eine Menge Potenzial: „AI PaaS werden voraussichtlich schnell adaptiert, weil hier der Wertbeitrag oft gut sichtbar ist.“

5. Teil: „Data Streaming“

Data Streaming

Ohne Daten geht selbstverständlich auch im Jahr 2020 nichts. Unternehmen, die Erfolg haben möchten, kommen nicht darum herum, anfallende Daten auszuwerten und sie möglichst gewinnbringend einzusetzen. „2020 wird sich daher alles um das Thema Datenmanagement drehen. Denn die Digitalisierung und der Einsatz etablierter und ganz neuer Trendtechnologien führen zu neuen datenbasierten Geschäftsmodellen und Anwendungen“, so NetApp-Director Peter Hanke. Unabhängig von ihrem Format und der Herkunft müssten Daten daher jederzeit, sicher und überall zur Verfügung stehen – am besten in Echtzeit. Dazu brauche es zum einen Interoperabilität zwischen verschiedenen Cloud-Anbietern und lokalen Systemen, um Applikationen über mehrere Plattformen verteilen zu können. Zum anderen sei ein freier Datenfluss unumgänglich: Ablage, Verwaltung, Zusammenführung und die Übertragung von Daten müssten einheitlich geregelt sein. Denn: „Stimmt die Basis nicht, dann lassen sich keine Mehrwerte generieren und die Nutzer nicht zufriedenstellen“, fasst Peter Hanke zusammen.

Doch das Problem ist: Die Datenmengen explodieren – während 2015 noch rund 30 Prozent der weltweiten Datenmenge von Unternehmen generiert wurden, sollen es 2025 bereits 60 Prozent sein. Wegen der schieren Menge wird es immer schwieriger, sämtliche Daten zu speichern und zu bearbeiten. Eine Lösung ist das sogenannte Data Stream Processing. Dabei werden Daten bereits dann in Echtzeit verarbeitet und analysiert, wenn sie anfallen. Zum Vergleich: Bislang setzt man in der Big-Data-Welt in der Regel auf das Prinzip „Data at rest“. Dabei nutzen Datenanalysen eine Batch-orientierte Dateninfrastruktur. Die Daten werden zunächst in einem Data Warehouse abgelegt und erst bei Bedarf verarbeitet. Beim Data Stream Processing erzeugt hingegen ein Sender, etwa ein IoT-Sensor, einen permanenten Datenstrom in einem wiederkehrenden Format. Ein Empfänger, etwa ein Cloud-Server, verarbeitet diese Daten kontinuierlich und stellt sie grafisch dar oder führt je nach Datenlage Aktionen aus.

Diese Datenstromverarbeitung hat aber auch ihre Nachteile. So ist nur ein fortlaufender Zugriff auf den Datenstrom möglich – im Gegensatz zur herkömmlichen Analyse von Daten etwa in einem Data Warehouse, bei der ein sogenannter wahlfreier Zugriff auf alle Daten durchführbar ist. Mittels spezieller Algorithmen lassen sich jedoch auch beim Data Streaming einzelne Datensätze aufgrund ihres Inhalts auswählen und etwa zu einem neuen Datenstrom zusammenfassen, der dann für weitere Analysen zur Verfügung steht.

Die Echtzeitverarbeitung von Daten erfordert in vielen Fällen auch Veränderungen in der IT-Architektur. Wenn man die Analyse nicht an einen externen Dienstleister wie einen Cloud-Dienst auslagert, dann müssen die eigenen Datenspeicher in der Lage sein, eine sehr große Menge an gleichzeitig anfallenden Daten in sehr kurzer Zeit zu speichern. Hier setzt man verstärkt auf Speichersysteme mit schnellem Flash-Speicher, um diesen erhöhten Anforderungen gerecht zu werden.

6. Teil: „Augmented Analytics“

Augmented Analytics

Ob Datenanalyse im Data Warehouse oder in Echtzeit mit Data Stream Processing – die Auswertung der vielen Daten ist oft langwierig, und die erwünschten Erkenntnisse bleiben nicht selten aus. Schnell wird es kompliziert und die Ergebnisse von Analysen werden falsch interpretiert – von „mal eben schnell“ etwas nachschauen ist man meilenweit entfernt. Eine herkömmliche Datenanalyse besteht aus vier zeitaufwendigen Schritten:

- Fragestellung

- Erhebung der Daten

- Analyse der Daten

- Erkenntnisse gewinnen und entsprechende Maßnahmen umsetzen

Hier sollen Augmented Analytics beziehungsweise Augmented Intelligence Abhilfe schaffen. Entsprechende Tools nutzen moderne Technologien wie Machine Learning und automatisieren die Datenanalyse. Die Tools greifen auf sämtliche Unternehmensdaten zu, bereinigen sie von überflüssigem Ballast, analysieren die übrig gebliebenen wertvollen Daten und bereiten die Ergebnisse anschließend so auf, dass sich daraus so einfach wie möglich konkrete Handlungsempfehlungen ableiten lassen – Datenanalyse auf Knopfdruck sozusagen.

Damit entlasten die Tools nicht nur den Data Scientist, der ohnehin viel Zeit auf das Sortieren von Zahlen verwenden muss. Sie ermöglichen es auch den Mitarbeitern in den einzelnen Fachabteilungen, ohne großes Expertenwissen an die gewünschten Informationen zu gelangen.

Augmented-Analytics-Tools haben quasi einen Datenexperten im Form cleverer Software an Bord. Er übernimmt viele komplizierte Operationen per Mausklick und erlaubt es auch Nicht-Statistikern, mehr oder weniger komplexe Datenabfragen zu tätigen. Viele Anbieter von Analytics-Tools wie Tableau oder Qlik setzen bereits auf die neuen, deutlich einfacheren Verfahren.

7. Teil: „Empowered Edge“

Empowered Edge

Edge-Computing bezeichnet im Gegensatz zum Cloud-Computing die dezentrale Verarbeitung von Daten am Netzwerkrand, möglichst an der Quelle, an der sie entstehen. Neu ist das Konzept des Edge-Computings nicht. Neu ist aber, dass Edge- und Cloud-Computing immer mehr zu einer intelligenten Infrastruktur zusammenwachsen. Dabei verlagert sich die Intelligenz mehr und mehr an den Netzwerkrand, sodass die Endpunkte nicht mehr nur Daten sammeln, sondern auch direkt vor Ort KI-Algorithmen ausführen, Stichwort Edge Analytics. „Edge Analytics wird zunehmend an Bedeutung gewinnen“, ist sich Bernhard Kube von Lufthansa Industry Solutions sicher.

Die Datenmenge, die in die Cloud übertragen werden muss, lässt sich auf diese Weise minimieren. Zudem werden IoT-Geräte autonomer, da sich mit der Verarbeitung vor Ort etwa Produktionsprozesse auch bei einer schlechten Cloud-Anbindung oder gar offline steuern lassen.

Ein Beispiel für Edge Analytics: GE Transportation nutzt die Technik, um die Sensordaten seiner Lokomotiven direkt an Bord in Echtzeit auszuwerten und so unter anderem den Energieverbrauch der Maschinen zu optimieren.

Distributed Cloud

Nicht nur die Analyse der Daten wandert von der großen, zentralen Cloud an den Netzwerkrand. Auch die große Cloud selbst wird zunehmend kleinteiliger. Immer mehr Cloud-Provider stellen ihre Ressourcen nicht mehr zentral an einem Ort zu Verfügung, sondern bieten dezentrale Dienste an.

Die Vorteile dieser Distributed Cloud: Zum einen ist die Performance von Cloud-Diensten höher, wenn sich die Server nicht am anderen Ende des Erdballs befinden und die Daten entsprechend umständlich hin und her gesendet werden. Zum anderen sind Cloud-Server, die in bestimmten Ländern stehen, etwa innerhalb der EU, für Unternehmen die einzige Möglichkeit, gesetzlichen Anforderungen wie der Datenschutz-Grundverordnung zu genügen.

Daher bieten zum Beispiel Hyperscaler wie Amazon, Google oder Microsoft ihre Dienste mittlerweile an vielen verschiedenen Standorten an – Kunden können wählen, in welchen Regionen beziehungsweise Ländern die genutzten Cloud-Server stehen. Die Analysten von Gartner sprechen angesichts dieser Entwicklung von der zentralisierten Public Cloud hin zur verteilten Public Cloud sogar von einer „neuen Ära des Cloud-Computings“.

8. Teil: „Fazit & Ausblick“

Fazit & Ausblick

Auch wenn deutsche Unternehmen der Implementierung neuer Technologien eher skeptisch gegenüberstehen – sie sollten in jedem Fall die Augen offen halten und sich regelmäßig über neue Trends informieren. „So gibt es doch immer wieder technologische Entwicklungen, die Unternehmen dabei unterstützen können, ihre Digitalisierung voranzutreiben“, resümiert Martin Otten, Regional Vice President Central Europe beim Unternehmens-Software-Anbieter OutSystems. Zu bedenken gibt er dabei: „Wer diese Trends völlig ignoriert, wird mit Sicherheit binnen kurzer Zeit das Nachsehen haben und hinter die Konkurrenz zurückfallen.“ Insofern sei es extrem wichtig, auch bei der Entwicklung oder Modernisierung von Anwendungen auf Technologien zu setzen, die für diese Trends offen sind.

„Es ist immer leichter, zu verstehen, was man mit einer Technologie grundsätzlich machen kann, als sie tatsächlich in der Praxis anzuwenden“, bringt es Martin Anduschus auf den Punkt, Vice President des Dienstleisters Arvato Systems. Als Beispiel nennt er Künstliche Intelligenz. „Laut Gartner sind wir beim Thema KI aktuell auf dem Höhepunkt des Hype Cycles. Das bedeutet: Jetzt folgt die thematische Ernüchterung, bevor die Technologie das Plateau der Produktivität erreicht.“

Bei den Themen Cloud und IoT sei man dagegen schon weiter. Daher sollten sich Unternehmen erst einmal auf diese fokussieren und sie in der Praxis anwenden. Das kluge Urteil von Martin Anduschus lautet jedenfalls: „Brauchen wir einen neuen Hype, der durchs Dorf getrieben wird? Ich glaube nicht.“

Forschung

KI macht Gebärdensprache zugänglicher

Ein KI-Tool der Universität Leiden für "Wörterbücher" erkennt Positionen und Bewegungen der Hände bei der Darstellung unterschiedlicher Gebärdensprachen.

>>

Umweltschutz

Netcloud erhält ISO 14001 Zertifizierung für Umweltmanagement

Das Schweizer ICT-Unternehmen Netcloud hat sich erstmalig im Rahmen eines Audits nach ISO 14001 zertifizieren lassen. Die ISO-Zertifizierung erkennt an wenn Unternehmen sich nachhaltigen Geschäftspraktiken verpflichten.

>>

Cyberbedrohungen überall

IT-Sicherheit unter der Lupe

Cybersecurity ist essentiell in der IT-Planung, doch Prioritätenkonflikte und die Vielfalt der Aufgaben limitieren oft die Umsetzung. Das größte Sicherheitsrisiko bleibt der Mensch.

>>

Galaxy AI

Samsung bringt KI auf weitere Smartphones und Tablets

Einige weitere, ältere Smartphone- und Tablet-Modelle von Samsung können mit einem Systemupdate jetzt die KI-Funktionen von Galaxy AI nutzen.

>>