14.10.2020

Intelligente Cyberguards

1. Teil: „Gefahrenabwehr mit KI-Unterstützung“

Gefahrenabwehr mit KI-Unterstützung

Autor: Bernd Reder

J. Simunek / shutterstock.com

Mit Künstlicher Intelligenz sollen Sicherheitslösungen Angriffe unterbinden. Doch auch Hacker setzen auf KI.

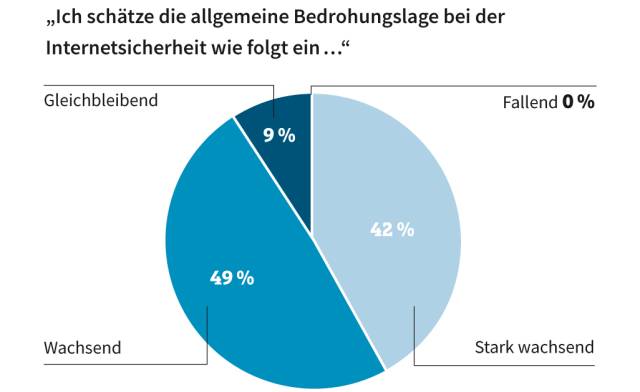

Wer hat die Nase vorn - der Hacker oder der IT-Sicherheitsfachmann? Eine klare Antwort auf diese Frage gibt es nicht. Denn der Wettlauf zwischen IT-Sicherheitsunternehmen und Cyberkriminellen hat sich zu einem Kopf-an-Kopf-Rennen entwickelt. Das zeigt sich auch beim Einsatz von Künstlicher Intelligenz (KI) und maschinellem Lernen (ML). Beide Technologien werden verstärkt in Security-Lösungen verwendet. Laut einer Studie des Beratungshauses Capgemini von 2019 gaben in Deutschland mehr als 60 Prozent der Unternehmen an, dass sie nur mit Unterstützung von KI-basierten Sicherheits-Tools Cyberattacken abwehren können.

Der Grund für diese Vorgehensweise: „Cyberangriffe sind im Vergleich zu vor wenigen Jahren raffinierter und gefährlicher geworden. Bedrohungen entwickeln sich in immer schnellerem Tempo weiter“, sagt Christine Schönig, Regional Director Security Engineering CER, Office of the CTO beim Software-Anbieter Check Point Software Technologies. „Unternehmen stehen daher vor der Notwendigkeit, ihre Cybersicherheit kontinuierlich zu erhöhen und zu verbessern.“

KI und Machine Learning

Künstliche Intelligenz und maschinelles Lernen sollen Schwachpunkte klassischer Security-Lösungen beseitigen. Zu diesen zählt, dass sie nicht bislang unbekannte Angriffsformen abwehren können. Ein Beispiel ist der Bereich Endpoint Protection, also der Schutz mobiler Endgeräte. „Der Einsatz von traditionellen Antiviren-Programmen reicht hier nicht aus“, erklärt Achim Freyer, Director Central Europe beim Datenmanagement-Spezialisten Rubrik. „Denn diese erkennen nur, was bereits bekannt ist.“ Dagegen seien mit KI-gestützter Software präventive Maßnahmen möglich. „Künstliche Intelligenz ist für das Lernen, Interpretieren und Umsetzen notwendig, weil IT-Sicherheitsmaßnahmen sonst immer einen Schritt langsamer als die ‚Bösen‘ sind.“

Diese Gefahr droht bei Security-Lösungen, die auf vorgegebenen Regeln und Signaturen beruhen. Treten Angriffe auf den Plan, die nicht in diesen Regeln definiert wurden, sind diese Systeme dafür „blind“. Dagegen können Lösungen auf Grundlage von Künstlicher Intelligenz und ML auch unbekannte Bedrohungen erkennen. Die Grundlage dafür sind maschinelles Lernen und Deep Learning. „Von maschinellem Lernen spricht man, wenn ein Programm neue Daten aufnimmt, daraus lernt und Änderungen vornimmt, ohne explizit dafür programmiert zu sein. Die Maschine wir somit in die Lage versetzt, Regeln zu erstellen oder zu ändern, um sich selbst weiter zu verbessern“, erläutert Thierry Karsenti, Vice President Engineering EMEA beim Sicherheitsspezialisten Palo Alto Networks. Dieses adaptive Verfahren ist notwendig, weil sich Angriffstechniken kontinuierlich und automatisch ändern, um signaturbasierte Erkennungsmethoden zu umgehen. „KI- und ML-gestützte Technologien werden immer wichtiger, weil sie sich durch die Bewältigung unbekannter Angriffe und hochgradig evasiver Bedrohungen auszeichnen“, so Karsenti weiter.

2. Teil: „Funktionsweise von KI-Security“

Funktionsweise von KI-Security

Zu den ersten Einsatzgebieten von KI-gestützten Sicherheitslösungen zählte der Kampf gegen Kreditkartenbetrug: Dazu wurde eine große Zahl von Informationen über betrügerische und legitime Aktivitäten in ein überwachtes maschinelles Lernsystem eingespeist. „Dieses geschulte System wurde im Erkennen betrügerischer Nutzungsmuster mit der Zeit besser als ein Mensch“, sagt Andreas Müller, Director Deutschland, Österreich, Schweiz bei Vectra, einem Spezialisten für KI-basierte Sicherheitslösungen.

Stehen nicht genügend Muster bösartiger Aktivitäten zur Verfügung, kann ein nicht überwachtes maschinelles Lernverfahren eingesetzt werden. Ein Algorithmus lernt in diesem Fall anhand der Daten, wie sich eine IT-Umgebung im Normalfall darstellt, also ohne Angriffe. „Das System kann dann Anomalien oder Ereignisreihen finden, die statistisch höchst unwahrscheinlich sind“, so Müller. Die Herausforderung beim nicht überwachten Lernen besteht jedoch darin, dass es relativ „geräuschvoll“ ist. „Dies bedeutet, dass es viele Anomalien gibt. Die meisten davon sind aber keine Cyberangriffe, und Menschen müssen oft erst die Kontextinformationen liefern, damit das System nutzbar wird“, ergänzt der Experte.

Um für eine möglichst große Zahl von Angriffsformen gerüstet zu sein, setzt ein Großteil der Anbieter von KI-basierten Lösungen mehrere Algorithmen ein. Zudem berücksichtigen die Algorithmen eine Vielzahl von Parametern. So analysiert etwa CloudGuard SaaS von Check Point E-Mails anhand von 300 Parametern darauf hin, ob es sich um saubere Nachrichten oder Phishing-Mails handelt. Diese Aufgabe übernimmt eine Anti-Phishing-KI-Engine.

Auch die Bösen rüsten auf

Die Arbeit von Algorithmen und menschlichen IT-Sicherheitsexperten wird jedoch durch die Tatsache erschwert, dass auch Kriminelle verstärkt KI-Tools einsetzen: „Es ist richtig, dass auch Hacker KI zunehmend für ihre Zwecke verwenden, etwa um Sicherheitslücken zu identifizieren. Daraus entwickelt sich mehr und mehr ein regelrechter Wettstreit zwischen automatisiertem Hacking und KI-basierten Schutzmaßnahmen“, bestätigt Dennis Monner, CEO von Secucloud, Anbieter einer IT-Security-Plattform.

Ein besonders dreistes Beispiel dafür, wie Angreifer KI-Tools nutzen, schildert die IT-Security-Firma Trend Micro in ihren Sicherheitsvorhersagen für 2020. Demnach imitierten Kriminelle mit Hilfe dieser Technik die Stimme des Geschäftsführers eines deutschen Energieversorgungsunternehmens. Der vermeintliche Chef wies in einem Telefonat den Leiter der Tochtergesellschaft in Großbritannien an, rund eine Viertelmillion Dollar an ein Unternehmen in Ungarn zu überweisen - mit Erfolg. Das Geld verschwand auf Nimmerwiedersehen.

3. Teil: „Authentifizierung von Nutzern“

Authentifizierung von Nutzern

Um zu verhindern, dass Angreifer die Rolle eines rechtmäßigen Nutzers übernehmen, setzen Unternehmen bereits seit einigen Jahren Künstliche Intelligenz und maschinelles Lernen beim Authentifizieren und Authentisieren von Nutzern ein. „Diese Technologien, in Verbindung mit Lösungen für die Authentisierung von Nutzern, ermöglichen es, benutzerfreundliche Sicherheitskonzepte aufzubauen. Ein Beispiel ist die Absicherung von Transaktionen beim Online-Banking“, erläutert beispielsweise Stephan Schweizer, CEO des IT-Sicherheitsunternehmens Nevis Security aus Zürich.

Bei solchen und vergleichbaren Lösungen, etwa für das Identity- und Access-Management (IAM), wird maschinelles Lernen verwendet, um ein verhaltensbiometrisches „Scoring“ von Nutzern umzusetzen. Eine Authentisierungslösung erstellt dazu im Rahmen von Online-Sessions ein Profil eines Nutzers. Ein Finanzdienstleister kann dieses Profil bei der Prüfung von Zahlungen verwenden. Weichen die Schreibgeschwindigkeit des Nutzers oder der Druck auf dem Touchscreen eines Smartphones erheblich vom Profil des Kunden ab, erfolgt eine manuelle Überprüfung der Transaktion durch einen Mitarbeiter.

Datenverkehr überwachen

Zu den Einsatzfeldern, die sich in besonderem Maß für KI- und ML-gestützte Sicherheitssysteme eignen, zählt die Überwachung des Netzwerkverkehrs. Nach Einschätzung des Beratungshauses Gartner erfassen solche NDR-Systeme (Network Detection and Response) den Datenverkehr in einem Unternehmensnetzwerk in Echtzeit. Durch ein sogenanntes Baselining der Verkehrsmuster wird der Normzustand des Netzwerks ermittelt. Mit Hilfe von Machine Learning sind die Systeme dann in der Lage, Anomalien zu entdecken und die IT-Abteilung zu informieren.

Wichtig bei NDR-Lösungen sind Funktionen, die auf eine Attacke automatisch reagieren oder zumindest manuelle Gegenmaßnahmen durch Administratoren erlauben. Doch daran, inwieweit ein KI- beziehungsweise ML-Algorithmus eigenständig auf einen Angriff reagieren darf, scheiden sich die Geister. Christine Schönig von Check Point Software sieht keinen Interessenkonflikt zwischen Mensch und Maschine: „Die Entscheidungskontrolle durch den Fachmann wird nicht aus der Hand gegeben, sondern durch qualifizierte Informationen erhöht.“

Dagegen sieht Achim Freyer von Rubrik nach wie vor bei IT-Fachleuten den Wunsch, selbst zu entscheiden, was bei verdächtigen Aktivitäten im Netzwerk zu tun ist: „IT-Experten befürworten den Einsatz von KI- und ML-basierten IT-Sicherheitslösungen, wollen aber meistens die Möglichkeit eines manuellen Eingriffs nicht missen. Hinweise und Vorschläge seitens einer derartigen Lösung sind erwünscht, jedoch präferieren die meisten Benutzer, den letzten Klick dann doch noch selbst auszuführen.“

Thierry Karsenti von Palo Alto Networks wiederum sieht sehr wohl eine Tendenz, dass IT-Security-Lösungen eigenständig und vollautomatisch auf Bedrohungen reagieren, dies allerdings nur bei Aktionen, „die keine Validierung durch Menschen erfordern“.

4. Teil: „Der Schutz von IoT-Systemen“

Der Schutz von IoT-Systemen

Letztlich ist damit zu rechnen, dass KI-Instanzen in immer stärkerem Maß autonom Schutzmaßnahmen ergreifen, wenn IT-Systeme und Netze unter Beschuss geraten. Zu dieser Entwicklung trägt bei, dass verstärkt eine neue Kategorie von Endgeräten vor Angriffen geschützt werden muss: IoT-Endpoints (Internet of Things) wie Sensoren an Werkzeugmaschinen und Steuerungen, digitale Stromzähler sowie Komponenten für die Automatisierung von Gebäuden und Wohnungen. „Systeme für das Internet der Dinge und die Betriebstechnik, also Operational Technology (OT), machen inzwischen 30 Prozent der Komponenten in Unternehmensnetzwerken aus“, weiß Thierry Karsenti. „Sie stellen ein erhebliches Sicherheitsrisiko dar, weil sie oft nicht verwaltet werden und in vielen Fällen mit Sicherheitslücken ausgeliefert werden.“

Hinzu kommen weitere Risikofaktoren. So sind IT- und OT-Sicherheitsfachleute oft nicht involviert, wenn solche Systeme angeschafft werden. Problematisch unter dem Aspekt Security sind außerdem die lange Lebenszeit und der unterschiedliche Aufbau von IoT-Lösungen. „Aus meiner Sicht besteht die einzige Möglichkeit, die Herausforderungen im Bereich IoT-Sicherheit zu bewältigen, darin, maschinelles Lernen einzusetzen“, so Karsenti.

Falsches Spiel mit Sensordaten

Zu einer ähnlichen Einschätzung kommt Daniel Carton, CEO von BotCraft. Das Unternehmen bietet Services in den Sparten IoT, Industrial IoT und Maschinenkonnektivität an. „Für mich ist KI im Zusammenhang mit IoT-Infrastrukturen zum einen ein Angriffsvektor“, betont Carton, „zum anderen lässt sich Künstliche Intelligenz auch dazu nutzen, um alle Ebenen des OSI-Layers zu überwachen.“ Solche Werkzeuge können selbst raffinierte Angriffe auf IoT-Infrastrukturen identifizieren. Als Beispiel führt Carton manipulierte Sensordaten an, die einem System einen falschen Zustand vorgaukeln, ohne dass es dies bemerkt. „Risiken durch solche simulierten Daten lassen sich durch die Implementierung von Überwachungssystemen an Schnittstellen minimieren. Diese Systeme können durch Simulationen getestet und trainiert werden, um entsprechende Angriffe zu erkennen.“ Das heißt, auch in vernetzten Fertigungsumgebungen können KI-basierte Sicherungsmechanismen eine wichtige Rolle spielen.

Fazit & Ausblick

Es ist absehbar, dass autonome IT-Sicherheitslösungen, die KI und maschinelles Lernen nutzen, in den kommenden Monaten an Boden gewinnen. Dazu tragen die Digitalisierungsentwicklungen und die sprunghaft wachsende Zahl vernetzter Dinge bei. Immer komplexere und größere IT-Umgebungen und Netzwerke lassen sich nicht mehr im Handbetrieb vor Cyberangriffen schützen. Die Frage ist, bis zu welchem Grad der Mensch die Kontrolle über solche Security-Lösungen abgeben will - oder ob er es sich leisten kann, auf automatisierte Sicherheitsprozesse zu verzichten. Dies erinnert an die Lage beim autonomen Fahren: Noch möchten die meisten Autofahrer dem KI-Autopiloten nicht komplett das Steuer überlassen. Doch in drei oder vier Jahren kann das durchaus anders sein.

5. Teil: „Im Gespräch mit Dennis Monner, CEO von Securcloud“

Im Gespräch mit Dennis Monner, CEO von Securcloud

Erst neuronale Netzwerke machen eine IT-Sicherheitslösung wirklich intelligent, sagt Dennis Monner, CEO des IT-Security-Spezialisten Secucloud.

com! professional: Herr Monner, wie bewerten Sie den Nutzen, aber auch die Risiken von Künstlicher Intelligenz im Bereich IT-Sicherheit? Denn mittlerweile setzen ja auch Cyberkriminelle diese Technologie ein.

Dennis Monner: Es ist richtig, dass auch Hacker KI zunehmend für ihre Zwecke einsetzen, etwa um Sicherheitslücken zu identifizieren und auszunutzen. Daraus entwickelt sich mehr und mehr ein regelrechter Wettstreit zwischen automatisiertem Hacking und KI-basierten Schutzmaßnahmen. Denn in dem Maß, in dem Cyberkriminelle Künstliche Intelligenz für ihre Zwecke nutzen, müssen auch wir mit entsprechenden Maßnahmen kontern, um in diesem Rennen möglichst immer einen Schritt voraus zu bleiben.

com! professional: Bei etlichen Security-Produkten kommt statt eines KI-Algorithmus maschinelles Lernen zum Einsatz. Wie sind Ihre Erfahrungen?

Monner: Gerade Systeme zur kontinuierlichen Analyse des Netzwerkverkehrs (netzwerkbasierte Intrusion-Detection-Systeme) sind weiterhin nur selten mit intelligenten Funktionen ausgestattet. Was sich vielmehr beobachten lässt, ist eine Verarbeitung großer Datenmengen auf Basis von maschinellem Lernen, um auf diese Weise Malware-Signaturen zu erstellen. Dieser Ansatz ist nicht zwingend auf die Nutzung Künstlicher Intelligenz angewiesen.

com! professional: Wie sieht denn eigentlich eine „richtige“ KI-gestützte Netzwerkanalyse aus?

Monner: Ein Beispiel für ein echtes KI-Szenario in der Security-Branche ist ein selbstlernendes System, das sich auf dieselbe Weise weiterentwickelt, wie wir es von einem künstlichen Gehirn erwarten würden.

Die Grundlage für ein solches System ist ein neuronales Netz, mit dem sich eine Art Gedächtnis erzeugen lässt: Werden bestimmte Verbindungen zwischen den einzelnen Knoten immer wieder aktiviert, werden diese stärker gewichtet. Auf diese Weise trainiert das neuronale Netz.

com! professional: Und wie lässt sich ein solches System in der Praxis einsetzen?

Monner: Ein Anwendungsszenario könnte beispielsweise ein netzwerkbasiertes Intrusion-Detection-System (N-IDS) sein, das Sicherheitsverletzungen nicht mehr rein auf Basis bereits bekannter Angriffsmuster erkennt. Stattdessen ist es in der Lage, mit Hilfe eines neuronalen Netzes zu „verstehen“, welche Merkmale unbedenklichen von schädlichem Netzwerkverkehr unterscheiden.

Mit einem solchen neuronalen Netz könnten sich Infrastrukturen schützen lassen, ohne dass eine kontinuierliche Aktualisierung einer Signaturdatenbank erforderlich wäre. Vielmehr würde das System durch die Verarbeitung des Netzwerkverkehrs lernen und sich so im Praxiseinsatz kontinuierlich weiterentwickeln.

com! professional: Wie aufwendig ist es, ein solches neuronales Netzwerk für Anwendungen im Bereich IT-Sicherheit zu trainieren?

Monner: Das Training ist in der Tat ein schwieriges Unterfangen, weil der Netzwerkverkehr heterogen ist und sich daher schwer analysieren lässt. Ein Lösungsansatz findet sich jedoch interessanterweise in einem völlig anderen Einsatzgebiet der KI: der Bilderkennung. Um beispielsweise eine Katze auf einem Foto zu identifizieren, greifen Suchmaschinen heute auf sogenannte Convolutional Neural Networks zurück. Diese sind darauf spezialisiert, Input visuell zu analysieren.

Tatsächlich lässt sich auch Netzwerkverkehr visuell darstellen - in Form eines Graustufenbilds, bei dem jedes Byte als ein Pixel dargestellt wird. Konfrontiert man das neuronale Netz nun mit den „Bildern“ von harmlosem und schädlichem Netzwerkverkehr, dann kann das KI-System darauf trainiert werden, die beiden Verkehrstypen voneinander zu unterscheiden.

com! professional: Das hört sich einfach an. Doch welche Hürden sind bei einem solchen Ansatz zu nehmen?

Monner: Zum einen muss der Netzwerkverkehr temporär entschlüsselt werden - etwa mit Hilfe von SSL-Interception. Außerdem ist es notwendig, die einzelnen Protokolle des Datenstroms, wie HTTP, HTTPS oder SMTP, voneinander zu trennen. Erst dann ist ein KI-gestütztes Security-System in der Lage, die einzelnen Schichten zu analysieren. Und drittens sollten die KI-Algorithmen idealerweise in der Cloud implementiert werden. Dies stellt sicher, dass die zur Analyse erforderliche Rechenleistung zur Verfügung steht.

Sind diese Voraussetzungen erfüllt, könnten auf Basis derselben Technologie, die zur Bilderkennung genutzt wird, spezielle KI-Klassifikatoren trainiert werden. Diese wiederum sind dann in der Lage, den Netzwerkverkehr visuell zu analysieren und als unbedenklich oder schädlich einzustufen. Das System würde dabei durch Erfahrung lernen und sich kontinuierlich selbst verbessern.

Galaxy AI

Samsung bringt KI auf weitere Smartphones und Tablets

Einige weitere, ältere Smartphone- und Tablet-Modelle von Samsung können mit einem Systemupdate jetzt die KI-Funktionen von Galaxy AI nutzen.

>>

Codeerzeugung per KI

Code ist sich viel ähnlicher als erwartet

Eine Studie zeigt, dass einzelne Codezeilen zu 98,3 Prozent redundant sind, was darauf hindeutet, dass Programmiersprachen eine einfache Grammatik haben. Die Machbarkeit von KI-erzeugtem Code war also zu erwarten.

>>

WebGPU

Sicherheitslücke in Browser-Schnittstelle erlaubt Rechnerzugriff via Grafikkarte

Forschende der TU Graz waren über die Browser-Schnittstelle WebGPU mit drei verschiedenen Seitenkanal-Angriffen auf Grafikkarten erfolgreich. Die Angriffe gingen schnell genug, um bei normalem Surfverhalten zu gelingen.

>>

Untersuchung

Amerikaner sehen KI als Risiko für Wahlen

Die Unterscheidung zwischen echten Infos und KI-Inhalten fällt vielen politisch interessierten US-Amerikanern schwer, wie eine Studie des Polarization Research Lab zeigt.

>>