23.04.2019

Data-Center

1. Teil: „Cloud oder On-Premise - die Qual der Wahl“

Cloud oder On-Premise - die Qual der Wahl

Autor: Andreas Dumont

vectorfusionart / shutterstock.com

Der Wettstreit zwischen Cloud und eigenem Rechenzentrum ist längst nicht entschieden. Zudem wird Edge-Computing bereits als potenzieller Nachfolger für die Wolke gehandelt.

IT-Trends wie Big Data, IoT oder Industrie 4.0 erhöhen kontinuierlich den Bedarf an der Bereitstellung von Daten und Rechenleistung. Grundsätzlich lässt sich das im Unternehmen selbst oder über einen externen Dienstleister, sprich in der Cloud, verwirklichen.

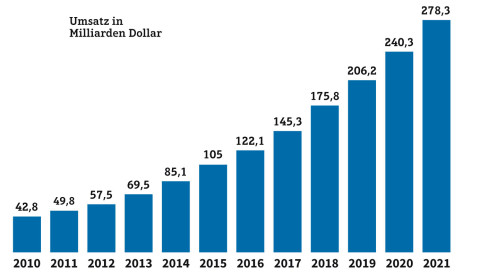

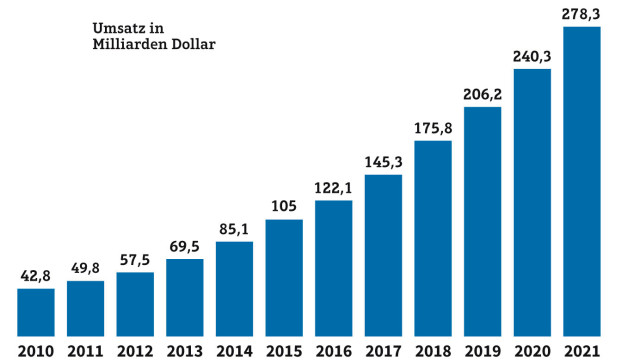

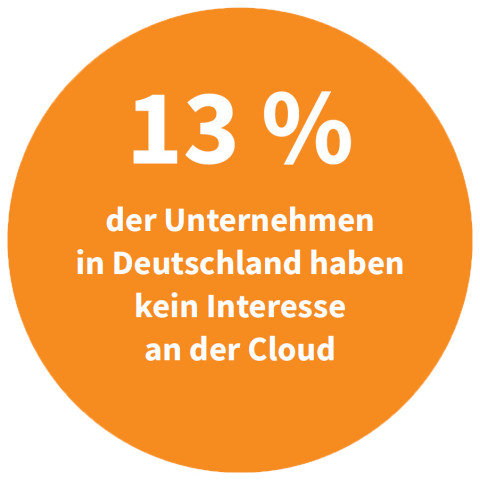

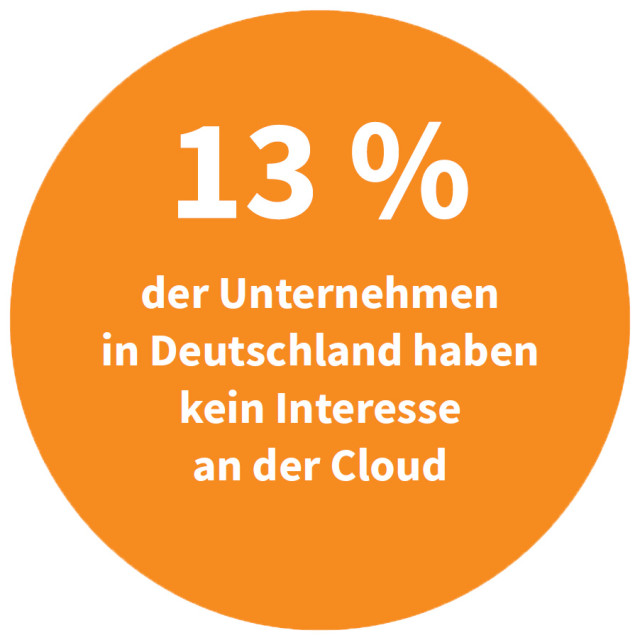

Der „Cloud-Monitor 2018“ der Unternehmensberatung KPMG zeigt selbst bei den lange skeptischen deutschen Firmen eine leicht steigende Cloud-Akzeptanz. Zwei von drei Unternehmen mit mindestens 20 Mitarbeitern nutzen demnach die Cloud bereits, 1 Prozent mehr als im Vorjahr. Die Datensicherheit in der Cloud bewerten sie zunehmend positiv, Verbesserungspotenzial besteht demnach vor allem beim IT-Administrationsaufwand und bei den Implementierungszeiten neuer Cloud-Anwendungen.

Doch trotz des scheinbaren Triumphs der Cloud haben auch On-Premise-Rechenzentren noch ihre Berechtigung. In mancher Hinsicht sind sie sogar immer noch die bessere Wahl. Das zeigt etwa ein Blick auf das Thema Hochverfügbarkeit: Insgesamt konnten 69 Prozent der Unternehmen in den vergangenen zwölf Monaten zumindest zeitweise nicht auf ihre Cloud-Anwendungen zugreifen.

Außerdem ist der Gang in die Cloud (fast) eine Reise ohne Wiederkehr. Der Weg zurück in die eigene Unternehmensumgebung ist wie das Befahren einer Einbahnstraße in verkehrter Richtung: zwar möglich, aber mit großen Risiken, Kosten und Mühen verbunden.

Allgegenwärtige Cloud

Eine klassische Public-Cloud-Lösung basiert auf dem Prinzip Software as a Service (SaaS). Dabei sind sämtliche Daten auf externen Servern von spezialisierten Anbietern gespeichert. Es sind folglich weder ein unternehmenseigenes Rechenzentrum noch ausgebildete IT-Spezialisten vonnöten. Deshalb gibt es auch kaum noch Branchen, die sich dem Lockruf der Cloud widersetzen. „Cloud-Dienste werden in allen Bereichen genutzt, wie zum Beispiel der Informationstechnologie und Telekommunikation, im Verkehrssektor oder im Bereich Einzelhandel“, sagt Christian Gehring, Director Solution Architects bei VMware. Dabei spielt die Größe des Unternehmens kaum eine Rolle. „Sowohl kleine Unternehmen aus dem deutschen Mittelstand als auch große, globale Unternehmen haben die Cloud für sich entdeckt.”

Natürlich gibt es gute Gründe, warum die Cloud auf IT-Entscheider eine gewisse Faszination ausübt. „Meist kommt die Cloud durch Zusatzprojekte oder zusätzlichen Ressourcenbedarf in die Unternehmen, weil sie im Vergleich zur klassischen IT-Beschaffung agiler und schneller zuschaltbar ist. Sie ergänzt dann die vorhandene On-Premise-Infrastruktur, erweitert sie oder bildet das Backup“, erklärt Henrik Hasenkamp, CEO des Kölner IaaS- und PaaS-Anbieters gridscale.

In den seltensten Fällen ersetzt die Cloud das eigene Rechenzentrum komplett. Auch dafür gibt es gute Gründe: „Zum einen sind die angeschafften Server mindestens bis zur vollständigen Abschreibung ein finanzieller Wert im Unternehmen, zum anderen machen bestimmte Regelungen hinsichtlich Datenhaltung und -sicherheit in manchen Branchen On-Premise-Lösungen unabdingbar.“

Cloud-Nachzügler sind laut Carlo Pacifico, VP DACH des Application-Performance-Management-Anbieters New Relic, vor allem alteingesessene Firmen: „Traditionsreiche Unternehmen wie etablierte Finanzdienstleister befinden sich aufgrund ihrer Unternehmenskultur und der komplexen Organisationsstruktur oft noch im hinteren Teil der Innovationswelle.“

2. Teil: „Vorteil Cloud“

Vorteil Cloud

Bei der Frage nach den Vorzügen der Cloud nennen IT-Entscheider vor allem eines: Flexibilität. „Besonders gut eignen sich Workloads für die Cloud, die schnell in mehreren Regionen der Welt, in denen das entsprechende Unternehmen tätig ist, ausgerollt werden müssen. Von großem Vorteil kann das Pay-per-use-Modell der Cloud-Anbieter sein, wenn noch unklar ist, wie viele Ressourcen benötigt werden, wenn es starke Schwankungen im Ressourcenbedarf und Lastspitzen gibt oder wenn Ressourcen nur temporär benötigt werden“, so Sven Klindworth, Head of IT & UCC Solutions for Germany and Austria beim britischen Telekommunikationsunternehmen BT. Der extrem hohe Automatisierungsgrad erlaube es, Infrastruktur sehr schnell und einfach zu provisionieren, fährt er fort. Weitere Vorteile seien laufende Updates („Evergreening“) und ein geringes kommerzielles Risiko. Klindworth nennt aber auch eine Einschränkung: „Bei einer cloudbasierten Lösung erwerbe ich die Nutzungsrechte und muss die Lösung so nehmen, wie sie ist.“ Dafür bekomme man immer die aktuellste Version und müsse sich keine Gedanken um den Betrieb machen.

Je nach Modell zahle man zudem nur, wenn man den Dienst auch verwendet, betont Manfred Völker, Sales Director für die DACH-Region bei Diabolocom, Telekommunikations-Provider und Anbieter von Cloud-Contact-Center-Lösungen.

Nicht zuletzt ist die Cloud ein Enabler. Sie erlaubt Anwendungen und Geschäftsmodelle, die sonst undenkbar wären. So sieht das etwa Thorsten Harth, Managing Consultant beim IT-Dienstleister NTT Data Deutschland: „Mit innovativen Technologien wie Microservices oder Serverless Computing fördert die Cloud die Anpassung bestehender Services und die Entwicklung neuer Geschäftsmodelle, beispielsweise im Marketing.“ Jens Puhle, Sales Director Germany beim Managed-Cloud-Provider Rackspace, stößt ins gleiche Horn: „Die Cloud ermöglicht viele neue Technologien, etwa in den Bereichen Internet der Dinge, Künstliche Intelligenz und maschinelles Lernen.“

3. Teil: „Vorteil On-Premise“

Vorteil On-Premise

Eigentlich müsste es nicht On-Premise, sondern „On-Premises“ heißen. Das englische „premise“ bedeutet nämlich Prämisse, also etwas ganz anderes als das gemeinte „in den eigenen Räumlichkeiten“. Aber durch die Macht der Gewohnheit und die Neigung vieler Hersteller, falsche Schreibweisen in ihre Produktnamen zu übernehmen, hat sich die Bezeichnung On-Premise weitgehend durchgesetzt. Fein raus sind alle, die einfach „On-Prem“ verwenden.

Ein schlichtes Argument für den Betrieb im eigenen Unternehmen, so BT-Mann Sven Klindworth, bestehe darin, dass ältere Software in der Cloud nicht ohne Weiteres lauffähig sei und oft nur mit enormem Aufwand angepasst werden könne. Auch funktionieren viele Cloud-Services nur mit einer ordentlichen Bandbreite. Das Schlagwort heißt Data Gravity. „Damit ist gemeint, dass Daten, die etwa bei einem Unternehmen im ländlichen Bereich in großer Menge vor Ort anfallen, wegen fehlender Bandbreite gar nicht zeitnah in die Cloud geschickt werden können und daher besser On-Premise in lokalen IT-Lösungen verarbeitet werden“, erläutert Klindworth. Müssen Daten direkt in der Produktion verarbeitet werden, bietet der On-Premise-Betrieb durch geringere Latenzen zudem Zeitvorteile. „Weitere Aspekte sind Sicherheitsbedenken, die Kronjuwelen eines Unternehmens wie Intellectual Property und Geschäftsgeheimnisse extern auf mit anderen Kunden geteilten Systemen zu betreiben“, so Klindworth weiter.

Schließlich kann auch die drohende Abhängigkeit von einem Cloud-Anbieter ein Argument für On-Premise sein - Stichwort Vendor-Lock-in. „Tatsächlich ist es wichtig, bei der Konzeption und der Umsetzung der eigenen Cloud- oder Hybrid-Lösung von Anfang an auf offene Schnittstellen und Portierbarkeit zu achten. Es stimmt, dass ein Anbieterwechsel schwieriger wird, je mehr Lösungen von IaaS über PaaS bis SaaS man aus einem Vendor-Universum nutzt“, gibt Henrik Hasenkamp von gridscale zu bedenken. NTT-Manager Thorsten Harth lässt einen Lock-in als Argument gegen die Cloud nicht gelten: „Wer eine ERP-Software kauft, legt sich auch auf eine bestimmte Lösung fest - mit allen Vor- und Nachteilen.“ Einen gewissen Grad an Vendor-Lock-in wird es also immer geben.

Doch die Frage für Unternehmen lautet: Was für Vor- und Nachteile entstehen dadurch?

In vielen Szenarien sei der geschäftliche Mehrwert höher als die Gefahren des Lock-in, meint denn auch Rackspace-Manager Jens Puhle. „Aber natürlich ist Vorsicht geboten vor den langfristigen Kosten einer Lieferantenbindung. Vermeiden lässt sich das etwa durch den Einsatz von Container-Technologie, Abstraktions-Tools oder offenen Cloud-APIs.“ Sehr gefragt sind Container- und Kubernetes-Anwendungen, die alle großen Anbieter unterstützen und eine problemlose Verschiebung von Workloads zwischen unterschiedlichen Cloud-Anbietern ermöglichen.

In vielen Szenarien sei der geschäftliche Mehrwert höher als die Gefahren des Lock-in, meint denn auch Rackspace-Manager Jens Puhle. „Aber natürlich ist Vorsicht geboten vor den langfristigen Kosten einer Lieferantenbindung. Vermeiden lässt sich das etwa durch den Einsatz von Container-Technologie, Abstraktions-Tools oder offenen Cloud-APIs.“ Sehr gefragt sind Container- und Kubernetes-Anwendungen, die alle großen Anbieter unterstützen und eine problemlose Verschiebung von Workloads zwischen unterschiedlichen Cloud-Anbietern ermöglichen.

Auch Datenschutz, Compliance und Sicherheitsbedenken können Unternehmen dazu bewegen oder gar zwingen, ihre Daten im eigenen Hoheitsgebiet zu verwalten. „Besonders sicherheitsbewusste Unternehmen ziehen sogar sichere MPLS-Verbindungen einer Kommunikation über das Internet vor“, weiß Sven Klindworth von BT. Multi-Protocol Label Switching dient der Vernetzung über eine geschlossene Infrastruktur.

4. Teil: „Kostenfalle oder Einsparungen“

Kostenfalle oder Einsparungen

Oft werden Kosteneinsparungen als Argument für die Cloud angeführt. Aber gerade das entspricht nicht unbedingt der Realität. Kostenvergleiche zwischen den beiden IT-Strategien kommen selten zu einem eindeutigen Ergebnis. Christian Gehring von VMware ist sicher: „Der Betrieb von Infrastruktur, Plattform und Anwendungen in der Cloud ist günstiger als On-Premise. Durch die hohe Automatisierung und den Einsatz von betriebsunterstützenden Tools für Management und Monitoring werden operative Kosten eingespart.“

Gridscale-Mann Henrik Hasenkamp urteilt differenzierter: „Ein Kostenvergleich ist in der Tat komplex.“ Das cloudtypische Pay-as-you-use-Modell biete zwar für Einstiegsprojekte große Vorteile. „Für eine Cloud-Strategie, die die IT mittel- und langfristig unterstützen soll, greift diese Art der Kostenbetrachtung aber zu kurz. In der Praxis spielen die Gesamtkosten und die Situation des Unternehmens eine Rolle. Längerfristig erscheint oft der Betrieb eines eigenen Rechenzentrums preisgünstiger, vor allem dann, wenn es weniger um die Abdeckung plötzlicher Lastspitzen geht, sondern mehr um dauerhaft datenintensive, hoch-performante Anwendungen.“

Für einen seriösen Vergleich müssen aber auch die Kosten für die Mitarbeiter, die eigenen Räumlichkeiten samt Sicherheitsmaßnahmen sowie für Software-Lizenzen und Support-Verträge einkalkuliert werden.

Laut einer Forrester-Studie sieht zwar die Hälfte der Fach- und IT-Entscheider Kostenreduktion als Haupttreiber für die Cloud-Einführung, 40 Prozent sagen aber auch, dass die Kosten höher ausfallen als erwartet. „Die größte Diskrepanz ergibt sich bei der Aktualisierung, Konsolidierung und Ablösung bestehender Geschäftsanwendungen und Systeme“, weiß Jens Puhle. Torben Mallwitz, Director Engineering beim Online-Preisvergleichsportal Guenstiger.de, weiß aus eigener Erfahrung: „Macht man ein Lift & Shift, ist man teurer als On-Premise. Wenn ich meine Applikation nehme, wie sie ist, und packe sie in die Cloud und erwarte, dass ich jetzt Geld spare und alles viel besser ist - nein, das funktioniert nicht. Günstiger wird es erst, wenn man Managed Services, Spot Instances und solche Geschichten anvisiert und nutzt.“

5. Teil: „Hybrid Cloud und Multi-Cloud“

Hybrid Cloud und Multi-Cloud

Cloud oder On-Premise? Immer häufiger lautet die Antwort: „sowohl als auch“. Die wenigsten Unternehmen lagern auf einen Schlag ihre komplette IT in die Cloud aus. Stattdessen stellen sie Schritt für Schritt um - und geben so nebenbei auch Systemhäusern die Möglichkeit, ihr Geschäftsmodell langsam zu verändern. Reines On-Premise ist ebenso selten anzutreffen wie reine Cloud-Lösungen.

Die Hybrid Cloud möchte die Vorteile beider Modelle bieten, und im Idealfall lassen sich Workloads und Services geschmeidig von einer Welt in die andere übertragen. Ein Unternehmen kann vertrauliche Daten in einem lokalen Rechenzentrum speichern und gleichzeitig von den robusten Ressourcen einer verwalteten Cloud profitieren. „Bei multinationalen Großkunden, wie sie BT als Kernzielgruppe bedient, werden noch für viele Jahre hybride Architekturen anzutreffen sein, die On-Premise, Managed Hosting und Cloud verbinden“, ist Sven Klindworth überzeugt.

Auch AWS hat inzwischen erkannt, dass die Hybrid Cloud den Anforderungen vieler Unternehmen entspricht, und kürzlich AWS Outpost angekündigt. Werner Vogels, CTO von Amazon, sagte auf dem „AWS Summit“ in Berlin Ende Februar, AWS sei sehr cloudlastig, was ein Problem für Unternehmen darstelle, die ihre Daten der Cloud nicht anvertrauen wollen oder dürfen. AWS Outpost ermögliche es, die gleichen Funktionalitäten in lokalen und Cloud-Anwendungen zu verwenden, also die Cloud-Dienste von AWS auch On-Premise zu betreiben. Die Infrastruktur werde dabei vollständig von AWS verwaltet und gewartet. Microsoft hat mit Azure Stack längst ein ähnliches Angebot. „Die Entwicklung der letzten Jahre zeigt klar, dass IT-Infrastrukturen heute deutlich flexibler sind - und dies auch sein müssen - und sich kaum noch auf Cloud oder On-Premise festlegen lassen. Inzwischen gibt es derart viele anpassbare und integrative Cloud-Lösungen, dass beinahe zwangsläufig hybride Infrastrukturen entstehen“, begründet Henrik Hasenkamp von gridscale den Erfolg der Hybrid Cloud.

Bei der Provider-Wahl sollten Entscheider darauf achten, dass sich Workloads einfach und unkompliziert von der On-Premise-Umgebung in die Cloud heben lassen und umgekehrt. Die Applikationen sollten in beiden Umgebungen den gleichen Service Level Agreements und identischen Update-Zyklen unterliegen, sodass sie stets auf dem gleichen Innovationsstand sind. Zudem sollte der Provider die Verantwortung für den IT-Support tragen. So können sich CIOs auf rein anwendungsbezogene und strategische Aufgaben konzentrieren. „Es gibt meines Erachtens kein Entweder-oder - die Lösung liegt in der Hybrid Cloud“, fasst VMware-Mann Gehring zusammen.

Die Hybrid Cloud wird von vielen Analysten nur als Zwischenstation angesehen auf dem Weg zur Multi-Cloud. Die soll das Problem lösen, dass es keinen für alle Einsatzszenarien optimal geeigneten Cloud-Dienst gibt. Bei der Multi-Cloud nutzen Unternehmen mehrere Anbieter, um Kosten, Sicherheit und Leistung bedarfsgerecht zu optimieren. Ähnlich wie die Automobilindustrie, die ihre Fahrzeugkomponenten von verschiedenen Zulieferern bezieht, werden Cloud-Services je nach Bedarf, gewünschter Leistung und Preis vom jeweils passendsten Anbieter bereitgestellt. Damit erhält der Anwender die für ihn jeweils beste Variante und senkt die Abhängigkeit von einem Cloud-Provider.

Ein weiterer Vorteil der parallelen Nutzung mehrerer Anbieter ist die Steigerung der Verfügbarkeit und der Ausfallsicherheit. Die Verwaltung erfolgt über eine zentrale Managementkonsole, denn um eine Multi-Cloud-Lösung effizient einzusetzen, braucht man eine ganzheitliche Sicht auf die Cloud-Services und die IT-Infrastruktur.

Fazit & Ausblick

Auch die Cloud ist nicht für immer und ewig die Krone der IT-Evolution. Als Nachfolger wird derzeit vor allem das Edge- Computing gehandelt - die dezentrale Datenverarbeitung am Rand des Netzwerks, dort wo die Daten generiert werden. Edge-Computing unterscheidet sich grundlegend von Cloud- Computing. Daten werden nicht aus der zentralen Cloud abgerufen, sondern an dezentralen Knotenpunkten gebündelt zur Verfügung gestellt. Ein autonomes Fahrzeug, das Standort- und Stauinfos von einem nahen Knotenpunkt erhält, muss keine Datenabfrage über ein Rechenzentrum ausführen, das vielleicht Hunderte Kilometer entfernt steht. Und wenn das IoT 2020 geschätzte 50 Milliarden Devices weltweit verbindet, dann fallen enorme Datenmengen an, die die Cloud möglicherweise überfordern. Die Turbine eines Verkehrsflugzeugs etwa generiert laut Cisco jede Stunde rund 20 Terabyte Daten. Venture Capitalist Peter Levine sieht deshalb bereits das Ende der Cloud am Horizont: Ein großer Teil der Rechenleistung, die heute in der Cloud stattfinde, werde zwangsläufig zum Edge wandern.

6. Teil: „Im Gespräch mit Guntram Alffen von Avi Networks“

Im Gespräch mit Guntram Alffen von Avi Networks

Avi Networks bietet eine Load-Balancing-Plattform an, die es Unternehmen ermöglicht, Applikationen schneller bereitzustellen. Guntram Alffen, Regional Director DACH, verrät, welche Fehler Unternehmen bei ihrer Cloud-Strategie machen.

com! professional: In welchen Bereichen steckt die „Cloudification“ noch in den Kinderschuhen?

Guntram Alffen: Letztendlich muss „Cloudification“ eine anwendungsorientierte Strategie sein, die Anwendungen mit den besten Services in der für sie besten Umgebung bereitstellt. Viele Unternehmen folgen tatsächlich immer noch einem infrastrukturzentrierten Ansatz. Diese Unternehmen schränken sich selbst ein, da dieser Ansatz sie immer an eine Art von Appliance - virtuell oder Hardware - ein Rechenzentrum oder eine Cloud bindet.

Unternehmen mit einem solchen Ansatz werden diesen früher oder später anpassen müssen, wenn sie erkennen, dass ihre Anwendungen die Cloud darstellen und nicht ihre Infrastruktur.

com! professional: Können Unternehmen mit der Cloud Kosten einsparen?

Alffen: Nein. Sehr selten ist die Public Cloud die kostengünstigste Lösung. Geschwindigkeit und Leistung sind die wichtigsten Faktoren, obwohl der Wechsel von Investitions- zu Betriebsausgaben für einige Unternehmen attraktiv sein kann.

com! professional: Welche neuen Technologien helfen, die Vorteile aller Arten von Cloud-Technologien zu nutzen?

Alffen: Die besten Technologien sind diejenigen, die eine Lösung bieten, die über Clouds und Rechenzentren hinweg konsistent ist. In der Vergangenheit konnten die Technologien im Rechenzentrum nicht in die Cloud und die Cloud-Lösungen nicht zurück in das Rechenzentrum migriert werden. Neue, Software-definierte Technologien können auf Bare Metal, VMs oder Containern im Rechenzentrum, in der Cloud oder sogar über mehrere Clouds eingesetzt werden. Dies vereinfacht den Betrieb und ermöglicht es Unternehmen, ihre Investitionen in Technologie vollauf zu nutzen. Unabhängig davon, ob sich diese im Rechenzentrum oder über mehrere Clouds hinweg befinden. Mit dem Aufkommen von Microservices werden wir auch den verstärkten Einsatz von Kubernetes sehen, das sich zu einer beliebten Plattform entwickelt hat, die die Bereitstellung und Verwaltung von containerisierten Anwendungen vereinfacht.

Der nächste Schritt wird die Verwendung eines Service Meshs sein, das diese Microservices mit allen Diensten verbindet, die sie über mehrere Infrastrukturen hinweg benötigen.

Pilot-Features

Google Maps-Funktionen für nachhaltigeres Reisen

Google schafft zusätzliche Möglichkeiten, um umweltfreundlichere Fortbewegungsmittel zu fördern. Künftig werden auf Google Maps verstärkt ÖV- und Fußwege vorgeschlagen, wenn diese zeitlich vergleichbar mit einer Autofahrt sind.

>>

The Boring Phone

Bierbrauer Heineken verschenkt ein Anti-Smartphone

Da viele Menschen durch Smartphones von echten sozialen Aktivitäten abgelenkt werden, legen Heineken und Bodega 5.000 Exemplare eines einfachen Klapp-Handys als "The Boring Phone" auf.

>>

Vier Smartphones

Huawei stellt die neue Pura-Serie vor

"Pura" statt "P": Huawei hat zunächst für den chinesischen Markt seine neue Flaggschiff-Serie mit den Modellen Pura 70, Pura 70 Pro, Pura 70 Pro+ und Pura 70 Ultra vorgestellt.

>>

Codeerzeugung per KI

Code ist sich viel ähnlicher als erwartet

Eine Studie zeigt, dass einzelne Codezeilen zu 98,3 Prozent redundant sind, was darauf hindeutet, dass Programmiersprachen eine einfache Grammatik haben. Die Machbarkeit von KI-erzeugtem Code war also zu erwarten.

>>