23.03.2020

Online-Handel und KI-Techniken

1. Teil: „Algorithmen müssen gezähmt werden“

Algorithmen müssen gezähmt werden

Autor: Christiane Fröhlich

whiteMocca / shutterstock.com

Algorithmen sollen stets das Optimum berechnen. Was, wenn sie Menschen diskriminieren?

Schlechte Presse für Apple: Vergangenen November geriet die Kreditkarte des IT-Konzerns in die Schlagzeilen. Bei der Festlegung des Kreditrahmens würden Frauen diskriminiert, so der unschöne Vorwurf - unter anderem erhoben von Apple-Mitgründer Steve Wozniak, dessen Frau genau dies erlebt hatte.

Auf seine Nachfragen bei dem IT-Konzern sowie bei der kartenherausgebenden Bank Goldman Sachs hieß es, die Entscheidung über den Kreditrahmen treffe ein Algorithmus. Das Problem dabei: Weder Apple noch die Bank konnten den Algorithmus einsehen, der zu der Entscheidung geführt hatte.

Von Menschen gemacht

Solche Berichte sind keine Einzelfälle. Immer wieder finden Forscher Hinweise darauf, dass Menschen aufgrund ihrer Herkunft, ihres Wohnorts, ihres Alters oder ihres Geschlechts von Algorithmen benachteiligt werden. Dies hat im Wesentlichen zwei Gründe: der eine ist die verfügbare Datenbasis, die den Berechnungen des Algorithmus zugrunde liegt, der andere sind die Logiken, anhand derer die Systeme vorgehen und weiterlernen. Sie sind von Menschen gemacht und daher ebenso anfällig für subjektive und diskriminierende Entscheidungen wie Menschen.

„Diskriminierung zu verhindern ist ein Dauerbrenner und keine Herausforderung, die sich der Gesellschaft erst jüngst in Zeiten von Künstlicher Intelligenz (KI) stellt. Bis heute sind viele Bereiche des Lebens nichts diskriminierungsfrei - auch in der KI nicht“, konstatiert Marion Weissenberger-Eibl. Sie beschäftigt sich als Leiterin des Fraunhofer-Instituts für System- und Innovationsforschung ISI mit Themen wie Machine Learning und KI sowie den dahinterliegenden Algorithmen.

Nun sind Algorithmen aus unserem Alltag schon lange nicht mehr wegzudenken. Und auch im E-Commerce sind sie längst zum festen Bestandteil geworden. Aus guten Grund: „Händler müssen immer komplexere Anforderungen erfüllen, die einerseits die Verbraucher und andererseits die internen Prozesse an sie stellen“, weiß Jens Scholz, CEO des auf KI-Lösungen spezialisierten Unternehmens Prudsys. So würden Online-Shopper erwarten, dass sie jederzeit auf jedem Kanal mit einem individuellen Einkaufserlebnis und herausragenden Services bedient werden. Gleichzeitig müssten die daraus resultierenden Omnichannel-Prozesse für den Händler sowohl beherrschbar als auch finanzierbar bleiben.

2. Teil: „Algorithmen auf Basis automatisierter Prozesse“

Algorithmen auf Basis automatisierter Prozesse

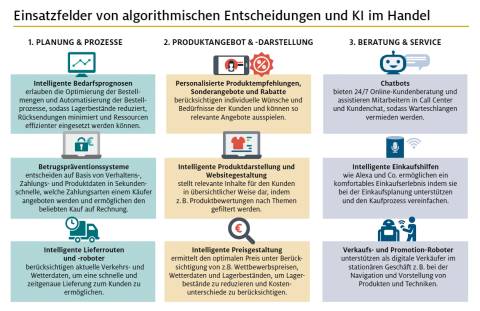

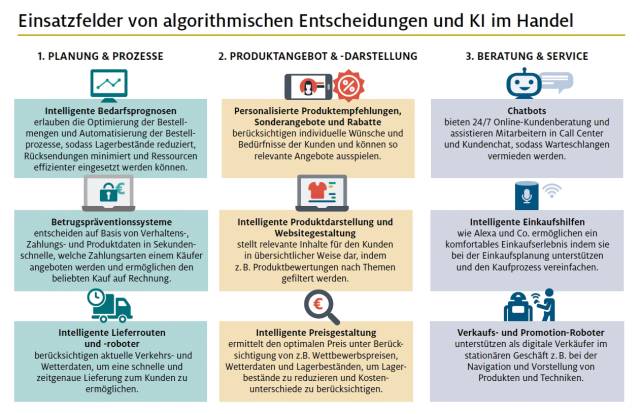

Deshalb sind automatisierte Prozesse auf Basis von Algorithmen ein elementarer Baustein, um die Wettbewerbsfähigkeit zu sichern. Sie stecken im Lagermanagement und der Lieferkettenoptimierung, in der Prognose von Kundenaufkommen und Nachfrage, in der dynamischen Preisanpassung, in vielen Formen von Personalisierung, in intelligenten Suchfunktionen und auch in der Zahlartensteuerung und der Bonitätsprüfung.

Damit wird das Spannungsfeld klar: Einerseits bieten selbstlernende Systeme ungeahnte Chancen, andererseits bergen sie durch ihre Omnipräsenz neue Risiken.

Dessen ist sich auch die Politik bewusst und hat daher im Sommer 2018 eine unabhängige Expertenkommission eingesetzt, die Empfehlungen zum Umgang mit Algorithmen erarbeiten sollte.

Im Oktober 2019 haben die 16 Kommissionsmitglieder ihre Empfehlungen vorgelegt. Sie schlagen ein ganzes Maßnahmenbündel vor, das für mehr Sicherheit und Vertrauen sorgen soll. So empfehlen sie, Algorithmen nach ihrem Schädigungspotenzial in fünf Risikoklassen einzuteilen. Je nachdem, welcher Risikoklasse ein System zugeordnet ist, müssen die Betreiber bestimmte Auflagen erfüllen, etwa die Benennung eines Algorithmus-Beauftragten, der zur Kommunikation und Zusammenarbeit mit Behörden verpflichtet ist.

Als Kontrollinstanz raten die Experten zu einem „Kompetenzzentrum Algorithmische Systeme“, das die Bundesregierung einrichten soll. Tatsächlich arbeitet die Regierung daran, ein solches Kontrollgremium, das sogenannte Deutsche KI-Observatorium, unter dem Dach des Bundesarbeitsministeriums zu installieren. Wie auf der Website des Ministeriums zu lesen ist, soll es im Lauf dieses Frühjahrs seine Arbeit aufnehmen.

Darüber hinaus empfehlen die Experten, ein freiwilliges oder auch verpflichtendes Gütesiegel als Schutzzeichen einzuführen. Zu guter Letzt regen sie eine Regulierung auf EU-Ebene an. In einer „Verordnung für Algorithmische Systeme“ sollten künftig die zentralen Grundprinzipien für den Umgang mit Algorithmen geregelt sein.

Die Reaktion auf die Vorschläge ist gespalten. Während der TÜV-Verband beispielsweise die Einteilung in Risikoklassen begrüßt, kritisiert der Digitalverband Bitkom die Empfehlungen scharf. Die Kommission stelle fast alle Algorithmen unter einen Generalverdacht, schreibt der Verband in einem Positionspapier. „Wir brauchen mehr Verständnis von Algorithmen, nicht mehr Verbote“, betont Bitkom-Präsident Achim Berg. Ziel könne nicht sein, den Weg in eine digitale Zukunft zu verstellen und Deutschland zu einem analogen Inselstaat zurückzubauen. Nach Ansicht des Verbands reichen die bestehenden Vorschriften und Gesetze aus. Zugleich setzt sich der Verband für mehr Transparenz im Umgang mit Algorithmen ein.

Schutz vor Manipulation

Auch der Handelsverband HDE mahnt, die Chancen zu ergreifen, die sich durch Künstliche Intelligenz bieten. „Wenn wir zu ängstlich auf KI schauen, werden wir verlieren“, schreibt der stellvertretende Hauptgeschäftsführer des HDE, Stefan Tromp, im HDE-Blog. Die Diskussion dürfe allerdings nicht naiv, sondern müsse offen geführt werden. „Da darf es kein Tabu sein, auch über Regulierung zu sprechen, die Vertrauen schafft, wo es bisher fehlt“, so Tromp. Er geht davon aus, dass KI nirgends so greifbar, so nah am Kunden ist wie im Handel. Deswegen komme dem Handel in der praktischen Umsetzung eine Schlüsselrolle zu. Er verweist dabei auf freiwillige Selbstverpflichtungen, mit denen der Handel sich als verantwortungsvoller Partner empfehlen könne.

Noch ist nicht deutlich erkennbar, wie und wann die Politik auf die komplexen Herausforderungen durch Künstliche Intelligenz reagieren wird. Klar ist aber, dass dringend Handlungsbedarf für differenzierte Regelungen besteht.

Ein Beispiel: Einerseits sollen Algorithmen transparent sein, um nachvollziehen zu können, wie es zu einer Entscheidung kommt. Andererseits sind die einem Algorithmus zugrunde liegenden Logiken gerade das, was den Wettbewerbsvorteil gegenüber anderen ausmacht. Darüber hinaus sind Manipulationen viel leichter möglich, wenn der Algorithmus bekannt ist. Und schließlich liegt es im Wesen von Künstlicher Intelligenz, dass die Systeme selbstständig hinzulernen. Es ist also nahezu unmöglich, am Ende eines langen Lernprozesses noch nachvollziehen zu können, wie die Künstliche Intelligenz zu einer bestimmten Lösung gekommen ist.

3. Teil: „Im Gespräch mit Marion A. Weissenberger-Eibl vom Fraunhofer ISI“

Im Gespräch mit Marion A. Weissenberger-Eibl vom Fraunhofer ISI

Bewusstsein für die Risiken, Transparenz und Nachvollziehbarkeit sind drei Faktoren, die Diskriminierung eindämmen können. com! professional spricht mit Marion A. Weissenberger-Eibl vom Fraunhofer-Institut für System- und Innovationsforschung ISI darüber, wie komplex das Thema ist.

com! professional: Ist es möglich, dass Algorithmen bestimmte Personengruppen aufgrund von Merkmalen wie Geschlecht, Alter, Wohnort oder Hautfarbe diskriminieren?

Marion A. Weissenberger-Eibl: Auch wenn wir viel Hoffnung in die Neutralität und Objektivität von Algorithmen legen, trifft Künstliche Intelligenz (KI) immer wieder diskriminierende Entscheidungen. So haben Algorithmen beispielsweise im amerikanischen Strafjustizsystem diskriminiert, indem Risikobewertungssysteme bestimmte Personengruppen systematisch benachteiligt haben.

Mittlerweile hat sich ein Bewusstsein für die ethischen und rechtlichen Herausforderungen im Umgang mit Algorithmen und KI entwickelt. Das ist ein sehr wichtiger Schritt, da Künstliche Intelligenz bereits Einzug in unser Leben gehalten hat.

com! professional: Sind diskriminierende Entscheidungen eine Frage der zugrunde liegenden Daten oder der Programmierung des Algorithmus?

Weissenberger-Eibl: Eine grundsätzliche Erwartung ist zunächst, dass es keine Diskriminierungsabsichten gibt. Das heißt, dass Menschen beispielsweise keine Algorithmen programmieren, die vorsätzlich bestimmte Personengruppen benachteiligen oder dass Programmierer und Programmiererinnen Algorithmen bewusst mit Trainingsdaten füttern, die Diskriminierung erzeugen oder fortschreiben.

Dennoch sollten wir uns immer wieder vor Augen führen, dass Algorithmen und KI nicht per se neutral oder objektiv sind. Sie unterliegen Bias, sprich Verzerrungen, die in ihren Code einprogrammiert wurden, beziehungsweise in den Daten, auf die sie zurückgreifen. Bei lernenden Systemen kann es dazu kommen, dass Daten generiert werden, die nachträglich Fehler oder Diskriminierung zur Folge haben.

com! professional: Wie lassen sich solche Diskriminierungen verhindern?

Weissenberger-Eibl: Ich würde mir wünschen, dass diese Frage einfacher zu beantworten wäre. Die Annahme, datenbasierte Entscheidungen seien neutral und objektiv, ist falsch und gefährlich. Sich dies bewusst zu machen, ist ein wichtiger Schritt, um Diskriminierung durch Künstliche Intelligenz zu verhindern. Wir brauchen also Awareness bei den Entscheidungsträgern in Politik, Wirtschaft und Gesellschaft.

Um Diskriminierung zu vermeiden, sind vor allem auch die Entwickler und Entwicklerinnen gefragt, die in der Praxis sensibel mit dem Thema umgehen müssen. Gleiches gilt für diejenigen, die KI anwenden.

Zudem müssen wir größtmögliche Transparenz und Nachvollziehbarkeit schaffen, die Neutralität der Daten gewährleisten, das Weiterlernen des Algorithmus kontrollieren und Verantwortlichkeiten regeln.

com! professional: Ist ein Algorithmen-TÜV oder ein Gütesiegel Ihrer Meinung nach sinnvoll?

Weissenberger-Eibl: Künstliche Intelligenz gehört wie gesagt längst zu unserem Leben und daher ist das „Wie“ und „Wie viel“ der Bereich, auf den wir uns fokussieren müssen. Die KI-Strategie der Bundesregierung sieht ein deutsches Observatorium für die Anwendungen von Künstlicher Intelligenz vor. Es soll die mit KI verbundenen Auswirkungen auf Gesellschaft und Arbeit analysieren sowie Handlungsempfehlungen und Maßnahmen zu deren Gestaltung entwickeln.

Daneben könnte ich mir durchaus ein Gütesiegel oder eine TÜV-Zertifizierung vorstellen, die offenlegt, wie der Algorithmus funktioniert. Beispielsweise sollte es damit möglich sein, nach bestimmten Vorgaben zu überprüfen, wie hoch das Diskriminierungspotenzial eines Algorithmus ist. Auf diese Weise könnte ein Standard für vertrauenswürdige Künstliche Intelligenz geschaffen werden.

Forschung

Beziehungstests auf TikTok taugen nichts

Forscherinnen der Flinders University bezweifeln die Aussagekraft von TikTok-Beziehungstests und sehen sogar negative Folgen für die Benutzer.

>>

Trendwende

Konsumenten sehen Silberstreif am Horizont

Erstmals seit Beginn der Lebenshaltungskostenkrise gibt es Anzeichen für einen Wendepunkt in der Mentalität der Verbraucher. Das zeigen Daten des Behavior Change Report der Consumer Panel Services GfK.

>>

Forschung

KI macht Gebärdensprache zugänglicher

Ein KI-Tool der Universität Leiden für "Wörterbücher" erkennt Positionen und Bewegungen der Hände bei der Darstellung unterschiedlicher Gebärdensprachen.

>>

Galaxy AI

Samsung bringt KI auf weitere Smartphones und Tablets

Einige weitere, ältere Smartphone- und Tablet-Modelle von Samsung können mit einem Systemupdate jetzt die KI-Funktionen von Galaxy AI nutzen.

>>