25.06.2015

Software-defined Data Center

1. Teil: „SDDC macht das Rechenzentrum programmierbar“

SDDC macht das Rechenzentrum programmierbar

Autor: Bernd Reder

Fotolia / Oleksiy Mark

Datacenter, die auf Software basieren, sind schnell, flexibel und sparsam. com! professional stellt das Konzept und die Vorteile der Software-defined Data Center, kurz SDDC, en détail vor.

Flexibel soll das moderne Rechenzentrum sein, sich schnell an neue Geschäftsanforderungen anpassen lassen, auf Knopfdruck weitere Services bereitstellen und zudem möglichst effizient und kostengünstig arbeiten. Ein herkömmliches Datacenter kann diese Vorgaben nicht erfüllen. Als Lösung favorisieren IT- und Netzwerkfirmen das Software-defined Data Center (SDDC). Es soll das Rechenzentrum „programmierbar“ machen. Doch die Migration zu einem SDDC ist nicht ohne Tücken.

Das klassische Rechenzentrum stößt an seine Grenzen: „Unternehmen müssen heute IT-Services immer schneller und flexibler bereitstellen“, sagt Ulrich, Hamm, Consulting System Engineer Data Center bei Cisco Deutschland. „Mit herkömmlichen Rechenzentrums-Infrastrukturen ist das nicht zu schaffen.“ Gefordert sind demzufolge Datacenter, die Server-, Storage- und Netzwerk-Ressourcen bezogen auf den jeweiligen Workload zur Verfügung stellen.

Statt des herkömmlichen Hardware-defined Data Centers (HDDC) forcieren deshalb IT-Unternehmen und Betreiber von Rechenzentren einen anderen Ansatz, den des softwarebasierten Rechenzentrums.

Zu den Anwendern, die derzeit auf SDDC setzen, zählen vor allem Unternehmen, die Cloud-Computing-Dienste anbieten, etwa Amazon Web Services, Google, Microsoft und Facebook. Der Grund: Sie bieten eine Vielzahl unterschiedlicher IT-Dienste an, von Office-Lösungen bis hin zu Server- und Storage-Kapazitäten, Disaster-Recovery-Lösungen und Datenbanken. Diese IT-Services und die dazugehörigen Ressourcen müssen auf Anforderung von Nutzern möglichst schnell bereitgestellt werden, am besten binnen weniger Minuten.

Doch auch kleinere Anbieter von Cloud-Diensten sowie firmeneigene Rechenzentren stehen vor der Herausforderung, Anwendern innerhalb kürzester Zeit neue IT-Dienste zur Verfügung zu stellen. Das schließt die dazugehörigen Server (Rechenleistung), Speicherressourcen (Storage) und Netzwerkkapazitäten (Network) mit ein. Hier spielt ein SDDC seine Stärken aus, so Peter Dümig, Senior Server Product Manager bei Dell: „Zu den Vorteilen eines softwarebasierten Rechenzentrums gehören Schnelligkeit, Flexibilität und Einfachheit. Daraus resultieren wiederum bessere Business-Services.“

Kein Wunder, dass die Prognosen der Marktforscher die Zukunft des SDDC rosig sehen. 2020 soll der weltweite Umsatz mit Produkten rund um das softwarebasierte Rechenzentrum 77 Milliarden Dollar erreichen, sagt Markets and Markets voraus – gegenüber rund 21,8 Milliarden Dollar 2015. Das jährliche Umsatzwachstum betrüge demnach 28,8 Prozent.

2. Teil: „Was ist ein Software-defined Data Center überhaupt?“

Was ist ein Software-defined Data Center überhaupt?

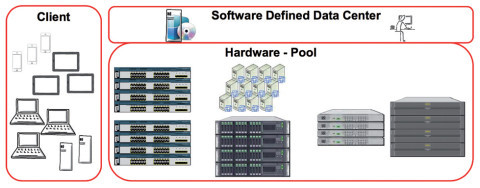

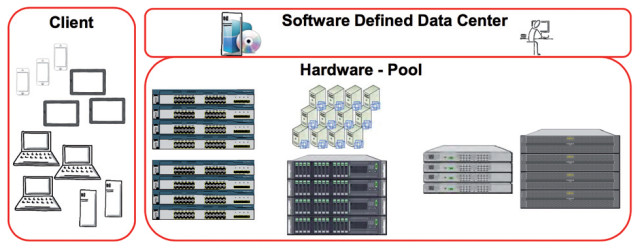

Noch ist allerdings unter IT-Fachleuten umstritten, was genau ein SDDC eigentlich ist. Die Distributed Management Task Force (DMTF), ein Normierungsgremium der IT-Industrie, moniert: „Nur wenige Definitionen bieten das erforderliche Maß an Informationen, das Interessenten benötigen.“ Die DMTF selbst beschreibt ein Software-defined Data Center als einen Pool aus Rechen-, Netzwerk-, Storage- und weiteren Ressourcen, der sich auf Basis von Workloads dynamisch bereitstellen und konfigurieren lässt. Weitere Eigenschaften sind:

- Funktionen, mit denen sich die speziellen Merkmale dieser Ressourcen ermitteln lassen

- die automatische Bereitstellung der Ressourcen, basierend auf den Anforderungen von Workloads

- eine zentrale Verwaltung der Server-, Storage- und Netzwerkkapazitäten, die diese Workloads benötigen

- eine Orchestrierung dieser Ressourcen auf Grundlage von Regelwerken (Policies). Diese stellt sicher, dass die Anforderungen der Workloads erfüllt werden.

Vereinfacht gesagt kann ein Systemverwalter in einem SDDC die zentralen IT-Ressourcen (Server, Storage Netzwerk) per Software steuern. Wenn er beispielsweise eine neue Virtual Machine aufsetzt, dann umfasst die Konfiguration auch die virtualisierten Netzwerk-Switches und Ports sowie die Speicherkapazitäten (Storage). Diese Bindung besteht auch dann weiter, wenn ein virtualisierter Server in ein anderes Rechenzentrum oder einen anderen Bereich eines SDDC verlagert wird. Die Basis für diese Steuerung per Software bildet eine Virtualisierungsschicht, die oberhalb der Hardware eingezogen wird.

3. Teil: „Die Vorteile eines Software-defined Data Center “

Die Vorteile eines Software-defined Data Center

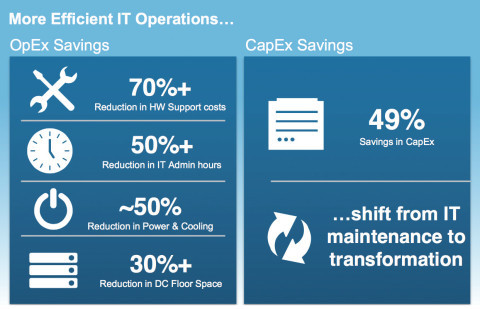

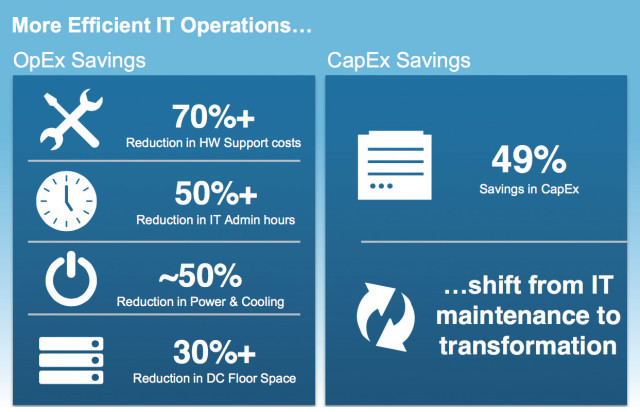

Welche Vorteile eine softwarebasierte Infrastruktur in der Praxis bringt, erfährt gerade der Halbleiterhersteller Intel. Er ist dabei, seine hauseigenen Datacenter auf SDDC umzustellen, besser gesagt auf eine Software-defined Infrastructure (SDI). Als positive Faktoren wertet Intel:

Niedrigere Investitionskosten: Ein SDDC ist weniger abhängig von proprietärer Hard- und Software wie speziellen Server-, Netzwerk- und Storage-Architekturen. Als Ersatz kommt Standard-Hardware in Verbindung mit offenen Protokollen wie OpenFlow (Software-defined Networking) oder OpenStack (für die Verwaltung der IT-Ressourcen) zum Zuge. Zudem lässt sich in einem SDDC mit Hilfe von Virtualisierung und Cloud-Computing die vorhandene IT-Infrastruktur besser ausnutzen. Ungenutzte Überkapazitäten entfallen.

Automatisches Bereitstellen von Ressourcen: Ein weiterer SDDC-Vorteil ist laut Intel, dass sich Ressourcen wie Rechen- und Storage-Kapazitäten automatisch bereitstellen lassen. Die zeitaufwendige und kostspielige „Handarbeit“ wird reduziert. Das schlägt sich in geringeren Systemkosten nieder. Außerdem können neue IT-Dienste schneller bereitgestellt werden. Laut VMware dauert es in einem HDDC bis zu mehreren Tage, um neue IT-Services einzurichten. In einer SDDC-Umgebung sind es im Schnitt nur etwa drei bis fünf Minuten.

Höhere Agilität: Die IT-Infrastruktur lässt sich schneller an geänderte Anforderungen von Abteilungen und Geschäftsbereichen anpassen. Benötigt etwa die Entwicklungsabteilung mehr Speicherplatz und höhere Rechenkapazitäten, weil ein neues Produkt in Arbeit ist, so ist das kein Problem.

Weniger Spezialwissen: Standardisierung sowie offene Protokolle und Technologien bedeuten zudem, dass weniger Spezialwissen und externe Support-Mitarbeiter von IT-Herstellern und Systemhäusern benötigt werden. Dadurch sinkt die Abhängigkeit von IT-Firmen und deren Fachpersonal. Außerdem fallen die Kosten niedriger aus. Man denke nur an die Vielzahl von Schulungen für die unterschiedlichen Systeme, die IT-Fachleute absolvieren müssen, weil in ihrem Datacenter Produkte mehrerer Hersteller eingesetzt werden.

4. Teil: „Netzwerk, Storage und Leistung eines SDDC“

Netzwerk, Storage und Leistung eines SDDC

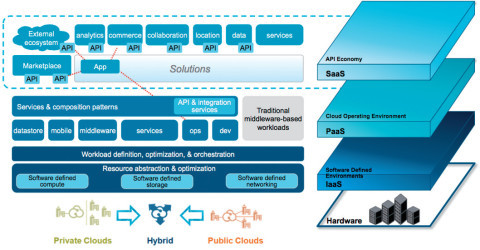

Zu den Kernelementen eines softwarebasierten Rechenzentrums zählt neben der Abstrahierung von Rechen-, Netzwerk- und Storage-Ressourcen vor allem die Virtualisierung von Netzwerkkomponenten und IT-Services. Virtualisierung findet in einem SDDC auf drei Ebenen statt: der Server-, der Storage- und der Netzwerkinfrastruktur-Ebene.

Die erste Virtualisierungsebene betrifft die Server: Rechenleistung, inklusive CPUs, Betriebssystem und Arbeitsspeicher, wird in Form von Virtual Machines (VMs) bereitgestellt. Für einen IT-Service und dessen Nutzer bleibt dabei intransparent, auf welchen physischen Server-Systemen „seine“ VM läuft. Diese virtuellen Maschinen lassen sich bei Bedarf hin und her bewegen – innerhalb eines firmeninternen Rechenzentrums oder zwischen diesem und dem Datacenter eines Cloud-Service-Providers.

Server-Virtualiserung ist mittlerweile in den meisten Rechenzentren anzutreffen. Marktexperten wie Gartner und IDC sowie IT-Hersteller taxieren den Virtualisierungsgrad in herkömmlichen Rechenzentren auf 75 bis 80 Prozent. Als Virtualisierungssoftware kommt vorzugsweise VMware vSphere zum Einsatz. Auf dem Vormarsch ist Microsoft Hyper-V. Dies auch deshalb, weil Microsoft Hyper-V in seine Server-Plattform Windows Server integriert hat und kostenlos zur Verfügung stellt. Allerdings sollte ein Software-defined Data Center außer vSphere und Hyper-V im Idealfall auch Citrix XenServer und Red Hat KVM unterstützen.

Die zweite Virtualisierungskomponente in einem SDDC ist die Speichersystem-Landschaft (Storage). Hier ist das Ziel, einen virtualisierten Storage-Pool einzurichten, der von einem zentralen Managementsystem aus verwaltet wird. In diesem Pool sind beispielsweise Hochleistungs-Storage-Arrays, iSCSI- und NAS-Systeme und Storage-Systeme auf Basis von Fibre-Channel-Netzen (FC) zusammengefasst. Zudem lassen sich Speichermedien für die Archivierung wie Bandlaufwerke oder Tape Libraries einbinden.

Solche Techniken für Software-defined Storage (SDS) gibt es bereits seit geraumer Zeit. Unternehmen wie EMC, NetApp, Fujitsu, Dell, HP und Brocade bieten entsprechende Produkte an, die in herkömmlichen Rechenzentren eingesetzt werden. Ebenso wie bei Software-defined Networking (SDN) wird bei SDS die Kontrollebene (Control Plane) der Speichersysteme von der Data Plane (Datentransport-Ebene) getrennt. Externe Controller übernehmen damit die Steuerung der Datenspeicher und ermöglichen es, per Software Anwendungen und IT-Diensten die passenden Storage-Ressourcen zur Verfügung zu stellen.

Da Storage-Virtualisierung bereits seit Jahren eingesetzt wird, sind entsprechend viele herstellerspezifische Ansätze auf dem Markt zu finden. Virtualisierte Speicher-Ressourcen in einem softwarebasierten Rechenzentrum sollten jedoch möglichst unabhängig von der Hard- und Software einzelner Anbieter arbeiten, damit sie sich zu einem Storage-Pool zusammenfassen lassen. Eine SDS-Umgebung in einem softwarebasierten Rechenzentrum muss daher über folgende Funktionen verfügen:

-

Automatisierung: eine möglichst einfach gehaltene Managementsoftware, mit der sich die Storage-Infrastruktur unkompliziert verwalten lässt.

- Standardschnittstellen: Application Programming Interfaces, über die sich die Speichersysteme und die entsprechenden Dienste unterschiedlicher Hersteller verwalten lassen.

- Virtualisierte Datenpfade: Dies sind Schnittstellen zu block-, datei- und objektorientierten Daten, die in einer typischen Storage-Umgebung eines Datacenters anfallen.

- Hohe Skalierbarkeit: Weiterer Speicher muss sich hinzufügen lassen, ohne dass es zu einer Unterbrechung des Rechenzentrumsbetriebs kommt.

Die dritte Virtualisierungs-Komponente eines SDDC ist die „programmierbare“ Netzwerkinfrastruktur, Stichwort Software-defined Networking (SDN). Die Grundlage dafür bilden laut Rainer Dresbach von Brocade sogenannte Ethernet Fabrics, eine erweiterte Form eines Ethernet-Netzwerks, die den Austausch gemeinsamer Konfigurationsparameter zwischen allen Switch-Ports der Fabric erlaubt. „Sie lassen sich in eine bestehende Umgebung integrieren und werden herkömmliche Netzwerke im Rechenzentrum ablösen“, so Dresbach. Das Ziel sei anschließend, möglichst viele Netzwerkkomponenten und deren Funktionen zu virtualisieren. „Dank Technologien wie Network Function Virtualization lassen sich diese Funktionen als virtuelle Instanz auf einem VMware-Server implementieren. Das bietet ein hohes Maß an Flexibilität und Skalierbarkeit“, stellt Dresbach heraus.

SDN ist im Gegensatz zur Storage-Virtualisierung eine neue Technologie. Das Ziel ist jedoch dasselbe: Statt herstellerspezifischer Router und Switches mit einer proprietären Systemsoftware sollen Standardsysteme zum Einsatz kommen. Die Kontrolle (Control Plane) wird an einen externen Controller übergeben. Er bestimmt, wohin die Daten transportiert werden und welche Quality-of-Service-Eigenschaften dabei zu berücksichtigen sind. Für den eigentlichen Transport der Daten sind – preisgünstige – Standard-Switches zuständig.

5. Teil: „Verschiedene Software-defined Networking Ansätze“

Verschiedene Software-defined Networking Ansätze

Eine besondere Herausforderung im Zusammenhang mit SDN besteht darin, dass es mehrere konkurrierende Ansätze gibt. Die Open Networking Foundation (ONF) hat beispielsweise einen SDN-Controller auf Grundlage des OpenFlow-Protokolls entwickelt. Mittlerweile sind diverse Controller und Netzwerk-Switches auf dem Markt verfügbar, die dieses Modell unterstützen.

Alternativ dazu gibt es das OpenDaylight Consortium. Mit maßgeblicher Unterstützung von Cisco hat es ein SDN-Framework entwickelt, das mehrere SDN-Protokolle und Netzwerksysteme unterstützt, etwa OpenFlow-Switches, Open-vSwitches sowie weitere virtualisierte und physische Switches und Router. Zudem lassen sich über eine Northbound-API Cloud-Management-Programme wie OpenStack anbinden. Dies ist auch für SDDC wichtig, speziell für Rechenzentren von Cloud-Service-Providern. Denn mit OpenStack lassen sich private, hybride oder öffentliche (public) Cloud-Infrastrukturen aufbauen und verwalten.

Damit nicht genug: Mit OpFlex hat Cisco ein eigenes Protokoll für SDN vorgestellt. Es kommt unter anderem in Ciscos hauseigener ACI-Plattform (Application Centric Infrastructure) zum Einsatz. Cisco positioniert ACI dabei als SDDC-Lösung: „Ansätze wie ACI verknüpfen physikalische und virtualisierte Server-Infrastrukturen unterschiedlicher Hersteller und sind durch die Nutzung von offenen Standards zu anderen Automatisierungs- und Orchestrierungslösungen kompatibel, also cloudfähig. Darüber hinaus erlaubt das eine einfache und schnelle Integration von Firewall und Load Balancer“, so Ulrich Hamm von Cisco.

Ressourcen-Verwaltung

In einer komplexen, hoch dynamischen IT-Umgebung wie einem SDDC spielt das Management der Server-, Storage- und Netzwerkressourcen eine zentrale Rolle. Eine Managementsoftware muss deshalb in der Lage sein, Workloads nach Bedarf bereitzustellen, inklusive Hardware-Ressourcen und IT-Sicherheitsfunktionen wie Firewalls. Dies darf jedoch nicht dazu führen, dass virtualisierte Netzwerk-Switches, Host-Bus-Adapter und Storage-Netzwerke überlastet werden.

Nach Angaben von Bernd Harzog, Chef der amerikanischen Marketing-Consulting-Firma APM Experts, muss eine Managementlösung für ein SDDC deshalb die Funktion Auto Discovery unterstützen. Das heißt, sie muss Veränderungen automatisch erfassen, da ständig neue Workloads aufgesetzt werden oder zwischen Hosts hin und her wandern. Und das ist nur möglich, wenn ein Monitoring der Rechenzentrumsumgebung erfolgt – in Echtzeit und auf eine feinkörnigere Weise als in einem herkömmlichen Datacenter.

Ein SDDC ist viel zu komplex, als dass Administratoren manuelle Workloads im Minutentakt konfigurieren könnten. Die Managementplattform muss also nicht nur Virtual Machines, sondern ganze Anwendungsumgebungen quasi auf Knopfdruck bereitstellen können.

6. Teil: „Open Source vs. proprietäre SDDC-Lösungen“

Open Source vs. proprietäre SDDC-Lösungen

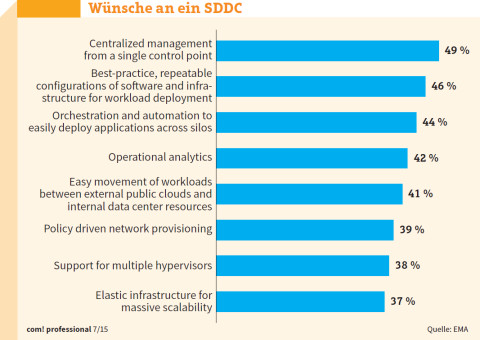

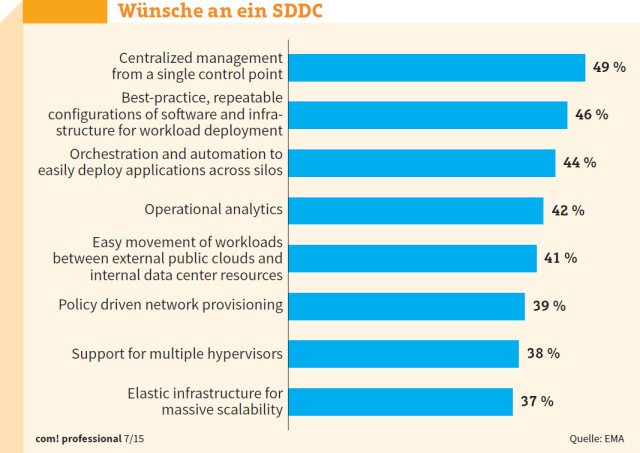

Allein aufgrund der hohen Komplexität eines softwarebasierten Rechenzentrums ist ein effizientes Management unverzichtbar. Das sehen auch die Anwender so. Laut einer Studie der Beratungsgesellschaft EMA ist für 49 Prozent der Unternehmen eine zentrale Managementkonsole ein Muss-Kriterium. Fast 44 Prozent betrachten Funktionen für die Orchestrierung und die automatische Bereitstellung von Anwendungen über die Grenzen von IT-Silos hinweg als wichtig.

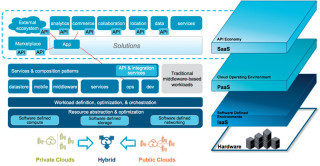

Bei Managementlösungen stehen mehrere Alternativen zur Auswahl. Eine ist das Open-Source-Framework OpenStack. Es wurde für die Verwaltung von Cloud-Computing-Umgebungen konzipiert und besteht aus mehreren Modulen. Swift ist etwa für die Bereitstellung von Software-defined Storage zuständig, Nova für die Verwaltung der Computing-Kapazitäten, speziell der Virtual Machines. Neutron wiederum ist die OpenStack-Komponente, mit der sich softwarebasierte Netzwerke (SDN) konfigurieren lassen.

Ein besonderer Pluspunkt von OpenStack ist, dass das Framework mit unterschiedlichen Hypervisors, Storage-Architekturen und Netzwerkkomponenten zurechtkommt. Das ist bei herstellerspezifischen Management-Tools naturgemäß nicht in demselben Maß gegeben.

Auf eigene Managementwerkzeuge setzt dagegen VMware, der Anbieter der immer noch marktführenden Virtualisierungsplattform für Unternehmens- und Cloud-Rechenzentren. Sie sind in der vRealize Suite zusammengefasst. Dazu zählt vRealize Operations für das Performance-, Konfigurations- und Kapazitätsmanagement von softwarebasierten Rechenzentren und Cloud-Umgebungen. vRealize Automation wiederum ermöglicht es Anwendern, aus einem Servicekatalog Infrastruktur-Services und Platform-as-a-Service-Angebote auszuwählen. Diese werden anschließend weitgehend automatisch bereitgestellt.

Nach Einschätzung von Bernd Harzog, Chef von APM-Experts, verfügt VMware gegenwärtig über die umfassendste Management- und Automatisierungslösung für SDDC. Allerdings haben auch andere Hersteller ihre Management-Tools für softwarebasierte und virtualisierte IT-Umgebungen aufgerüstet oder tun dies gerade. Ein Beispiel ist die Infrastrukturverwaltung HP OneView. Zusammen mit hauseigenen Storage-Systemen, Blade-Servern, Netzwerkprodukten und HP Virtual Connect bietet HP OneView als Komplettlösung für den Aufbau eines SDDC an. Virtual Connect ist dabei eine Technik für die Virtualisierung von Netzwerkadaptern für Server-Systeme.

Ein Beleg dafür, dass sich im Bereich SDDC-Lösungen noch keine „Produktsilos“ gebildet haben, ist die Kooperation von VMware und HP. Beide kündigten im Sommer 2014 an, dass HPs SDN-Controller Virtual Application Network (VAN) mit VMwares Netzwerkvirtualisierungs-Plattform NSX zusammenarbeiten wird. Zudem unterstützt HPs Helion OpenStack die NSX-Linie und Virtualisierungsplattform vSphere von VMware. Helion OpenStack ist die Open-Source-Version der Cloud-Plattform von HP. Vergleichbare Partnerschaften haben etliche Hersteller mit VMware geschlossen, etwa Brocade, Dell und Fujitsu. Brocade stellt beispielsweise mit VDX eine Ethernet-Fabric-Plattform für VMware NSX bereit.

Dell und Fujitsu wiederum zählen, neben Firmen wie Supermicro und EMC, zu den Herstellern der EVO:RAIL-Appliance von VMware. Dabei handelt es sich gewissermaßen um ein softwarebasiertes Rechenzentrum von der Stange. Die Appliances kombinieren Rechenleistung (Server) und Netzwerk- und Storage-Kapazitäten mit Virtualisierungs- und Managementsoftware. Die Software stammt von VMware, die anderen Komponenten liefern die genannten Anbieter. Das Ziel: Anwendern einen möglichst einfachen Umstieg auf ein SDDC zu ermöglichen.

7. Teil: „Eigenbau vs. Fertiglösung einer SDDC-Umgebung“

Eigenbau vs. Fertiglösung einer SDDC-Umgebung

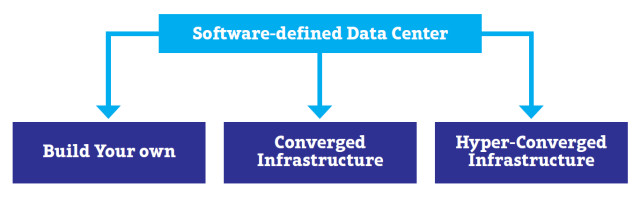

Unternehmen und Service-Provider, die ein Software-defined Data Center in Betracht ziehen, haben im Wesentlichen drei Optionen: den Aufbau einer SDDC-Umgebung in Eigenregie, den Kauf einer Fertiglösung oder die Orientierung an der Referenzarchitektur eines Anbieters.

Beim Do-it-yourself-Ansatz stellt der Anwender die IT-Komponenten selbst zusammen und integriert sie. Als Basiselemente kommen beispielsweise Open-Source-Lösungen wie OpenStack in Betracht, außerdem OpenFlow-basierte Controller für den Aufbau eines Software-defined Networks. Im Bereich Software-defined-Storage gibt es neben OpenStack Open-Source-Lösungen wie Ceph und GlusterFS.

Ein Vorteil eines selbst konzipierten Software-defined Data Centers ist, dass die IT-Abteilung frei wählen kann, welche IT-Komponenten sie im SDDC verwenden möchte, beispielsweise preisgünstige Standard-Server auf x86-Basis. Man begibt sich nicht in die Abhängigkeit von einem einzigen IT-Anbieter.

Der Haken bei diesem Ansatz: Er erfordert profundes Fachwissen in unterschiedlichen IT-Fachbereichen. Und das dürfte nicht in jedem Unternehmen vorhanden sein. Daher sind es derzeit häufig Betreiber von Mega-Rechenzentren wie Google, Amazon oder Facebook, die diesen Weg beschreiten.

Beim Kauf einer Fertiglösung kommen Appliances wie EVO:RAIL von VMware infrage. Auch die Converged Systems (siehe dazu den Abschnitt auf Seite 98) sind tendenziell eher Fertiglösungen, obwohl Firmen wie VMware oder Cisco mit Application Centric Infrastructure (ACI) ihre Produkte gern auch als SDDC-Blaupausen vermarkten.

Mittlerweile bieten außerdem eine Reihe von IT-Unternehmen Referenzarchitekturen an, auf deren Basis ein Unternehmen ein SDDC implementieren kann. HPs Lösung wurde bereits erwähnt. Ein weiteres Beispiel ist die Foundation Infrastructure Reference Architecture von EMC, VMware, Pivotal und RSA. Mit ihr können Anwender eine Hybrid-Cloud aufbauen, die Infrastrukturdienste (Infrastructure as a Service, IaaS) und darauf aufsetzende IT-Dienste bereitstellt. Die Grundlage bilden Storage- und Backup-Produkte von EMC, etwa die Storage-Virtualisierungslösung ViPR. Hinzu kommt VMwares Virtualisierungs- und Managementsoftware.

Den Markt der SDDC-Referenzmodelle dominieren derzeit Produkte auf Basis der Virtualisierungssoftware von VMware in Verbindung mit Storage-, Server- und Netzwerk-Hardware unterschiedlicher Hersteller. Beispiele sind die Dell-VMware Reference Architecture, Fujitsus vCloud-Lösung, das SDDC-Konzept von Brocade und VMware sowie die FlexPod-Architektur von Cisco, VMware und dem Storage-Spezialisten NetApp.

Konkurrenten von VMware im Virtualisierungsbereich wie Citrix haben Gegenentwürfe entwickelt oder tun dies gerade. Citrix, das mit XEN eine eigene Virtualisierungsplattform besitzt, schickt beispielsweise CloudPlatform ins Rennen. Mit der Übernahme der Firma Sanbolic im Januar 2015 hat Citrix Know-how im Bereich Storage-Virtualisierung erworben und eine Lücke in seiner SDDC-Strategie geschlossen.

Eine Referenzarchitektur bietet zwar weniger Gestaltungsräume als der Do-it-yourself-Ansatz. Dafür erhält der Nutzer eine Architektur, deren Komponenten bereits aufeinander abgestimmt sind. Das vereinfacht die Implementierung. Allerdings besteht das Risiko, dass sich ein Unternehmen dadurch an einen oder wenige Anbieter bindet, Stichwort Vendor Lock-in. Neben technischen Aspekten müssen auch diese Punkte im Vorfeld sorgfältig abgewogen werden.

Converged Systems

Eine Mischung aus Eigenbau und Fertiglösung sind Converged Systems. Sie zeichnen sich dadurch aus, dass sie Storage, Rechenleistung, Netzwerkkomponenten und Management in einer Box bieten. Bei Hyper-Converged-Infrastructure-Plattformen kommt noch Virtualisierungssoftware hinzu.

Ob es sich bei Hyper-Converged Systems wirklich um softwarebasierte Rechenzentren oder nur um Bausteine handelt, mit denen sich ein SDDC aufbauen lässt, ist umstritten. De facto stellen etliche dieser Systeme zentrale Funktionen eines SDDC bereit, allerdings oft um den Preis, sich auf die Lösung eines bestimmten Anbieters zu fixieren. Dies gilt insbesondere für das Management des Systems und der IT-Ressourcen.

Hersteller solcher Systeme sind unter anderem VCE mit Vblocks, Nutanix (Virtual Computing Plaform NX), HP (ConvergedSystem) und EMC (VSPEX). Gartner zählt zudem Cisco-NetApp (FlexPod), Oracle, IBM und Dell zu den führenden Anbietern.

Mit Hilfe solcher Systeme lässt sich in kurzer Zeit eine softwarebasierte IT-Infrastruktur aufbauen. Allerdings handelt es sich bei einem Gutteil dieser hoch integrierten Plattformen nicht um monolithische Blöcke. Vielmehr arbeiten sie mit Hard- und Softwarekomponenten unterschiedlicher Hersteller zusammen. Ein Beispiel dafür ist IBM PureFlex Systems.

Noch offener gibt sich die US-Firma Springpath, die Anfang 2015 an die Öffentlichkeit trat. Ihre Springpath Data Platform soll unterschiedliche Server- und Storage-Architekturen und Virtualisierungsplattformen unterstützen, etwa VMware, KVM und Microsoft Hyper-V.

8. Teil: „Herausforderungen softwarebasierter Rechenzentren“

Herausforderungen softwarebasierter Rechenzentren

Mal eben schnell ein softwarebasiertes Rechenzentrum aufzusetzen oder ein bestehendes Datacenter umzukrempeln, das funktioniert in der Praxis nicht. Udo Würtz, Chief Evangelist Global Server Business von Fujitsu, und Mornay Van Der Walt, Vice President der EVO:RAIL Emerging Solutions Group von VMware, sehen vor allem in drei Bereichen Herausforderungen: der Startphase, der Bereitstellung und beim Lifecycle-Management und Support.

Vor Beginn eines SDDC-Projekts gilt es, die strukturellen und organisatorischen Änderungen zu klären. Zudem muss eine Referenzarchitektur entwickelt werden. Dabei müssen gegebenenfalls externe Fachleute hinzugezogen werden. Hinzu kommen die Auswahl und der Test von Hardware- und Softwarekomponenten unterschiedlicher Hersteller. Ein klassischer Fehler sind in dieser Phase zu enge Zeitvorgaben.

Bei der Implementierung und Inbetriebnahme stellt sich nach Angaben von Fujitsu und VMware häufig heraus, dass es an Tools fehlt, mit denen sich Workloads und die dazugehörigen IT-Ressourcen wie Storage und Rechenleistung automatisiert bereitstellen lassen. Zudem haben viele IT-Abteilungen Probleme, die unterschiedlichen Infrastrukturknoten (Nodes) zu kombinieren, etwa Speicher- und Netzwerksysteme.

In der Praxis zeigt sich außerdem, dass gerade softwarebasierte Datacenter, die aus Komponenten unterschiedlicher Anbieter kombiniert wurden, alles andere als pflegeleicht sind. Das betrifft etwa den technischen Support und das Systemmanagement. Das Einspielen von Patches und Systemerweiterungen kann unter Umständen sogar zur Unterbrechung des Rechenzentrumsbetriebs führen.

Ein zentraler Kritikpunkt der Distributed Management Task Force (DMTF) bezieht sich auf fehlende Standards und Schnittstellen für den Übergang von einem konventionellen Rechenzentrum zu einem SDDC. So fehle es an Application Programming Interfaces (APIs) zwischen Anwendungen, SDDC-Komponenten und Cloud-Computing-Ressourcen. Die meisten Schnittstellen decken laut der Task Force nur das Bereitstellen von IT-Infrastrukturkomponenten wie Servern ab, nicht von Applikationen.

Eine Herausforderung ist auch die weitere Nutzung vorhandener Hardware: „Moderne Hardware unterstützt oft schon softwaredefinierte Ansätze und lässt sich weiterhin verwenden“, sagt Peter Dümig von Dell. „Ältere und proprietäre Komponenten müssen dagegen in aller Regel ersetzt werden.“

Die DMTF geht davon aus, dass die Betreiber von Rechenzentren vorhandene Hard- und Software so lange wie möglich verwenden werden – und rechnet daher mit Verzögerungen bei der Implementierung softwarebasierter Ansätze.

Zudem müssen beim Aufbau eines SDDC standardisierte Verfahren entwickelt werden, um die Trennung der Workloads und Daten unterschiedlicher Anwender sicherzustellen, die beispielsweise im SDDC eines Cloud-Service-Providers vorgehalten und gespeichert werden. Hier ist zu beachten, dass manche Daten nur in bestimmten Regionen oder Rechtsräumen vorgehalten und bearbeitet werden dürfen. Deutsche Unternehmen dürfen personenbezogene Informationen nur in Rechenzentren im EU-Raum speichern.

Vor einer Zersplitterung des SDDC-Markts in herstellerspezifische Inseln warnt Ashish Nadkarni, Research Director Storage Systems bei IDC. Er kritisiert, dass zwar mit OpenStack bereits ein Ansatz im Bereich SDDC existiert, der als übergreifende System- und Managementplattform dienen kann. Doch gibt es seiner Ansicht nach eine Tendenz in Richtung herstellerspezifischer SDDC-Stacks. Das liefe dem Konzept einen offenen, auf Standards basierenden Rechenzentrums zuwider und würde die Akzeptanz von softwarebasierten Rechenzentrums-Architekturen erschweren.

Fazit

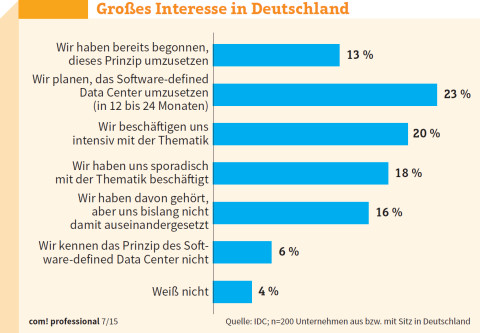

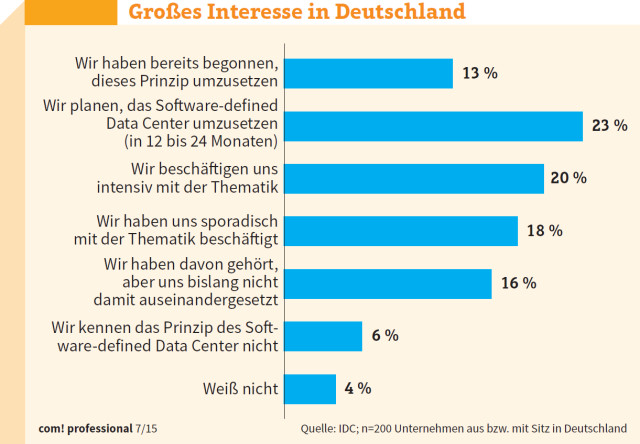

Dass softwarebasierte Rechenzentren auch in Deutschland an Boden gewinnen, steht nach Einschätzung von IDC außer Frage: „Zwar haben erst 13 Prozent der befragten Organisationen mit der Umsetzung eines SDDC begonnen“, so IDC-Analyst Matthias Kraus. „Allerdings gab ein Viertel an, SDDC in den kommenden 12 bis 24 Monaten zu implementieren. Weitere 20 Prozent beschäftigen sich intensiv mit der Technologie.“

Annähernd 11 Prozent der IT-Entscheider gehen nach Angaben von IDC davon aus, dass das SDDC-Konzept bereits in ein bis zwei Jahren ein bedeutender Faktor sein wird. Gut 35 Prozent erwarten, dass der SDDC-Ansatz eher mittelfristig, also in drei bis fünf Jahren, ein wesentlicher Ansatz zum Management gemischter IT-Landschaften sein wird.

Ein Grund für die eher abwartende Haltung deutscher IT-Verantwortlicher ist sicherlich, dass Software-defined Data Center ein relativ komplexes Thema ist. Zudem kommen Software-Tools und Technologien, mit denen sich ein softwarebasiertes Rechenzentrum aufbauen lassen, erst nach und nach auf den Markt. SDDC ist somit sicherlich eine Technologie, die ebenso wie softwarebasierte Netzwerk- und Storage-Infrastrukturen in Rechenzentren Einzug halten wird. Auf breiter Front dürfte dies jedoch erst in einigen Jahren der Fall sein.

Letzte Hürde genommen

USB-C kommt als einheitlicher Ladestandard

Nach dem Bundestag hat auch der Bundesrat einer EU-Richtlinie zugestimmt, die USB-C als einheitlichen Anschluss zum Laden von Elektrogeräten festlegt.

>>

Autohersteller

Erstes Smartphone von Polestar

Autohersteller Polestar hat in China sein erstes Smartphone vorgestellt, das vor allem gut mit den Fahrzeugen des Herstellers zusammenarbeiten soll.

>>

10 Stationen

1.500 Händler bei der AVM-Roadshow

Der Fokus der Solution Tour 2024 von AVM lag auf den Themen Glasfaser, Wi-Fi 7 und Smart Home, und mehr als 1.500 Handelspartner folgten der Einladung des Herstellers an die insgesamt 10 Standorte in Deutschland.

>>

Ohne Nokia

HMD zeigt erste Smartphones mit der eigenen Marke

Mit den drei neuen Pulse-Modellen bringt HMD seine ersten Smartphones auf den Markt, die nicht mehr unter der Lizenz von Nokia vermarktet werden.

>>