04.08.2014

Software-defined Storage

1. Teil: „(R)Evolution im Speichermarkt mit SDS“

(R)Evolution im Speichermarkt mit SDS

Autor: Hartmut Wiehr

Foto: iStockphoto / heizfrosch

Software-defined Storage (SDS) will die Speicherverwaltung revolutionieren, ist manchmal allerdings auch nur alter Wein in neuen Schläuchen.

IT-Produkte, egal welcher Kategorie, waren von Beginn an immer durch die Dualität von Hardware und Software charakterisiert. Eins ohne das andere geht nicht – Programme laufen auf einer Hardware-Basis und können individuell oder nach Unternehmensanforderungen angepasst und gesteuert werden. Nur in einigen Fällen wie Controllern oder Adaptern ist die Software direkt und unveränderlich ins Produkt eingebettet (embedded).

Seinen Ursprung hat der Trend Richtung „Software-defined Everything“ bei der Server-Virtualisierung, die von VMware vorangetrieben wurde und eigentlich nichts anderes ist als ein per Software definierter Server: Mit Hilfe sogenannter Hypervisoren lässt sich ein physikalischer Standard-Server in viele virtuelle Maschinen (VMs) aufteilen, in denen dann eigene Betriebssysteme und Anwendungen getrennt voneinander laufen.

VMs haben die Server-Landschaft revolutioniert, zumal diese Technik auf einfachen und günstigen x86-Standardrechnern läuft. Und sie haben auch deshalb zu einer deutlichen Kosteneinsparung geführt, weil man weniger physikalische Geräte braucht. Dieser Effekt wird allerdings durch erhöhte Management- und Sicherheitsanforderungen teilweise wieder aufgehoben.

VMware hat als erster Hersteller versucht, das Modell der Server-Virtualisierung auf andere Infrastrukturbereiche zu übertragen. Hierfür hat die EMC-Tochter den Begriff Software-defined Datacenter (SDDC) geprägt. Alle physikalischen Ressourcen in einem Rechenzentrum sollen nach diesem Konzept virtualisiert werden: CPU, Arbeitsspeicher, Speicher und Netzwerk. CPU und Arbeitsspeicher sind durch Hypervisoren bereits virtuell aufgeteilt, die anderen Bereiche sollen diesem Modell sukzessive folgen.

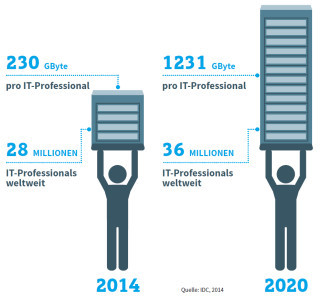

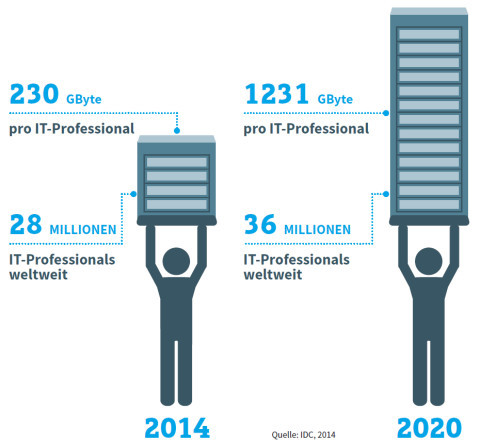

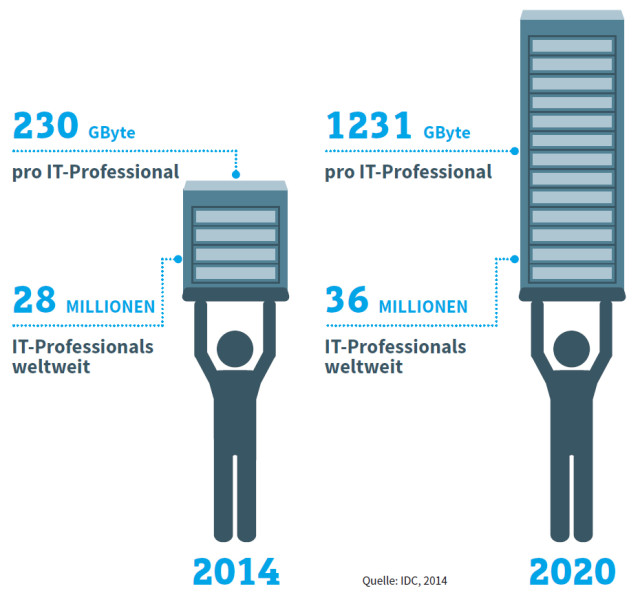

Cisco hat etwa zeitgleich mit EMC/VMware ein eigenes Software-defined-Konzept entwickelt: Die klassischen Switches erhalten eine Softwareschicht, sodass auf den physikalische Netzwerkverbindungen mehrere virtuelle Leitungen eingerichtet werden können. Software-defined Networking (SDN) soll ebenso wie Software-defined Storage (SDS) zu mehr Flexibilität und Skalierbarkeit führen. Nur so lässt sich, folgt man den Herstellern, das explodierende Datenwachstum bewältigen – bei letztlich sinkenden Hardware-Kosten.

2. Teil: „Das heißt Software-defined“

Das heißt Software-defined

Software-defined Storage geht noch einen Schritt weiter als bisherige Formen der Speicher-Virtualisierung. So verteilt zum Beispiel ein RAID-System (Redundant Array of Independent Disks) bisher schon die Speicherdaten redundant über verschiedene physikalische Festplatten hinweg, um sie vor einem Ausfall zu schützen.

Solche logischen Systeme oberhalb der Hardware-Basis finden sich auch beim LUN-Konzept oder bei der klassischen Speichervirtualisierung: LUNs (Logical Unit Numbers) bezeichnen eine logische oder virtuelle Speichereinheit, die auf einem oder mehreren Speichergeräten Daten zusammenfasst; Speichervirtualisierung kombiniert unterschiedliche Arrays von einem oder verschiedenen Herstellern zu einem virtuellen Pool. Alle diese Techniken sind schon länger „Software-driven“.

Das Konzept von Software-defined Storage dagegen will mehr: Es geht um nichts Geringeres, als die komplette traditionelle Hardware-orientierte Sichtweise von Speicher über den Haufen zu werfen. Die Kontrollebene, also die Zuteilung und laufende Verteilung von Speicher, soll zu 100 Prozent von der physikalischen Ebene abgetrennt werden – entsprechend dem Vorbild der Server-Virtualisierung. Das bedeutet de facto, dass die Storage-Infrastruktur trotzdem nach wie vor ihren Platz behält – nur soll dabei der Software-Anteil deutlich die Oberhand über den Hardware-Anteil gewinnen.

Der Ansatz von SDS besteht prinzipiell darin, dem exponentiellen Datenwachstum nicht mit immer neuen Speicherschränken zu begegnen, sondern mittels Virtualisierungstechnologie auf der Software-Ebene nach neuen Lösungen zu suchen. Dabei ist zu beachten, dass das Ziel zwar klar definiert ist, aber gegenwärtig noch konkurrierende Ansätze das Feld beherrschen.

Ein eindeutiger Marktführer wie VMware bei der Server-Virtualisierung ist noch nicht auszumachen. Für die Anwender bedeutet das, sorgfältig zwischen den Alternativen abzuwägen und den Investitionsaufwand gering zu halten. Man sollte auch überlegen, ob hinter bestimmten Software-defined-Angeboten nicht doch verklausulierte Hardware-Erweiterungen stecken.

IBM zum Beispiel hat die Broschüre „Software-defined Storage for Dummies“ herausgegeben, die sehr nahe an den eigenen, schon älteren Produkten entlanggeschrieben ist, aber auch neutrale Informationen enthält. So liefert IBM folgende Definition von SDS: „Grundsätzlich handelt es sich bei Software-defined Storage um Speicherlösungen für Unternehmen, die Standard-Hardware benutzen und alle wichtigen Speicher- und Management-Funktionen mittels intelligenter Software ausführen. SDS liefert automatisierte, regelbasierte und anwendungsorientierte Speicher-Services, indem die Speicherinfrastruktur von dem darüberliegenden Software-Layer orchestriert wird.“

Für IBM gehören zu SDS auch „automatisierte Management-Funktionen wie Information Life Cycle Management (ILM) und Provisioning, Storage-Virtualisierung und eine leistungsfähige Scale-out-Architektur“. Diese Eigenschaften stehen laut IBM in Kontrast zu traditionellen Speichersystemen, die wesentlich von proprietärer Hardware abhingen.

Spätestens hier zeigt sich ein Widerspruch in der IBM-Strategie: Der Konzern will ja – ebenso wie seine großen Konkurrenten auf dem Speichermarkt EMC, HDS oder HP – durchaus weiter seine eigenen proprietären Speichersysteme in die bestehende Kundenbasis hinein und darüber hinaus verkaufen. Mit konsequenter SDS-Technologie sägt man immer auch den Ast ab, auf dem man sitzt – so wie es zum Teil auch beim Propagieren von externen Cloud-Lösungen der Fall ist.

Ein schönes Beispiel für eine fast zwangsläufige Umetikettierung ist hier die im Mai 2014 angekündigte Einführung von Elastic Storage durch IBM. Diese „neue, bahnbrechende Technologie erlaubt es Unternehmen, mit dem explodierenden Datenwachstum Schritt zu halten, indem eine unbegrenzte Menge von Daten aus Geräten, Sensoren, Geschäftsprozessen und sozialen Netzwerken ausgewertet werden kann“, heißt es vom Hersteller.

Hinter Elastic Storage verbirgt sich allerdings lediglich das von IBM schon bisher verwendete Dateisystem GPFS (General Parallel File System), das zum Beispiel in geclusterten oder Shared-Umgebungen Anwendung findet. Elastic Storage ist für IBM nun ein Teil von SDS. Neu sind nur einige Erweiterungen in Richtung Cloud und Open Stack, entsprechend der allgemeinen Strategie von IBM, die Big-Data- und Cloud-Umgebungen anpeilt.

3. Teil: „Virtuelle Appliances“

Virtuelle Appliances

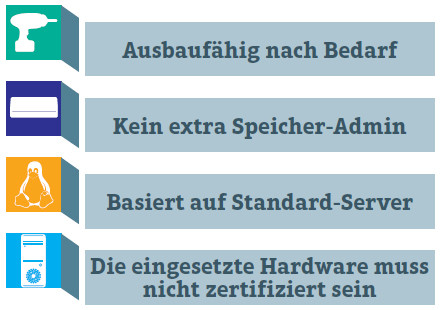

Bei Hewlett-Packard betont man, dass es keine offizielle Definition von SDS gebe. Laut Florian Bettges, Business Development Manager Online Storage bei HP Deutschland, orientiert sich HP bei der Definition einer SDS-Architektur stark an der übergeordneten Definition für ein Software-defined Datacenter (SDDC), da SDS ein Element des SDDC darstelle. Es gebe drei Komponenten, die eine SDS-Architektur ausmachten: eine standardisierte x86-Hardware-Plattform mit Linux-Betriebssystem, Storage-Services mit der Möglichkeit, viele Systeme im Scale-out- oder Grid-Verbund zusammenzuschalten, und Schnittstellen zu übergelagerten Managementsystemen.

HP entfernt sich mit dieser Festlegung nicht sehr weit von den bestehenden Angeboten einer Hardware-ausgerichteten Storage-Infrastruktur, die mit zusätzlichen SDS-Elementen und Software versehen wird. Dies verdeutlicht auch HPs StoreVirtual VSA, eine Appliance, also ein Stück Hardware mit vorinstallierter Software, die 2012 aus einer Umbenennung der Lefthand-Technologie hervorgegangen ist. Lefthand war 2008 von HP gekauft worden.

Die Analystengruppe Taneja sieht Virtual Storage Appliances (VSAs) als eine Art Vorläufer von Software-defined Storage: VSAs, die von diversen Herstellern angeboten werden – neben HP hauptsächlich von FalconStor, Nexenta und seit Kurzem von VMware –, seien „Software-driven“ und erlaubten es Administratoren, Storage-Controller innerhalb einer virtuellen Infrastruktur in einer VM zu installieren. Dies führe zu einer besseren Ausnutzung einer gegebenen verteilten Speicherlandschaft – innerhalb eines Unternehmens (On-Premise) oder in einer Cloud. Eine heterogene Speicherinfrastruktur, die von lokalen Platten in Servern und Arrays im Rechenzentrum bis hin zu mehreren verteilten Standorten reichen kann, ließe sich so homogen und gemeinsam verwalten.

Die Taneja Group sieht den Erfolg von VSAs gerade auch bei kleineren Unternehmen als Grund dafür, dass VMware 2013 in dieses Marktsegment eingestiegen ist und nun ebenfalls eine Softwarelösung für Storage anbietet, die in einer VM als virtuelle Instanz läuft.

Taneja beschreibt diese VM-Varianten so: „Im Unterschied zu einer normalen VM brauchen sie kein eigenes Betriebssystem und sind mit sofort einsetzbarer Storage-Software vollgepackt. Diese entspricht weitgehend dem Code, der auf physikalischen Speichersystemen läuft. Die Software läuft in einer virtuellen Appliance ähnlich wie in einem normalen Storage-Array und teilt zum Beispiel lokale Kapazität einem SAN (Storage Area Network) oder NAS (Network Attached Storage) zu. Dabei arbeitet die Appliance mit dem Hypervisor, der die VSA hostet, oder mit anderen Hypervisoren zusammen.“

Storage Arrays werden auf diese Weise zu virtuellen Maschinen, die sich laut Taneja einfacher managen lassen als in ihrer physikalischen Form. Daten können nun ebenfalls einfacher bewegt oder migriert werden – wie bei einer normalen VM.

VSAs integrieren lokalen Speicher in den Servern und CPU-Performance in die Verwaltung der virtualisierten Arrays, was Taneja zufolge zugleich die Speicherausgaben senkt, und das nicht nur bei den Anschaffungskosten: „Die Kosten für Midrange-Speichersysteme betragen heute drei bis fünf Dollar pro Gigabyte, sind aber nur alle paar Jahre fällig.

Im Gegensatz dazu betragen die operationalen Ausgaben einschließlich Verwaltung, Energie, Kühlung und Platz im Rechenzentrum fünf bis acht Dollar pro Gigabyte und Jahr. Die Unternehmen zahlen in der Regel das Drei- bis Vierfache der Hardware-Kosten allein für das laufende Management der Speicherinfrastruktur. Der Einsatz von mehr Software hierfür würde diese Ausgaben deutlich senken.“

4. Teil: „„Speicher-Mafia““

„Speicher-Mafia“

Tarkan Maner, früherer Eigentümer von Wyse (an Dell verkauft) und CEO des Speicher-Start-ups Nexenta, spricht von einer „Mafia der Hardware-Hersteller“: Deren Ziel sei es immer nur gewesen, möglichst viele und völlig überteuerte Speichersysteme an die Kunden zu verkaufen. Doch nähere sich deren absolute Herrschaft ihrem Ende, wenn man sich für SDS-Lösungen entscheide.

Nexenta hat sich zunächst in Virtual-Desktop-Umgebungen (VDI) profiliert, strebt aber ein breiteres Spektrum an. CEO Maner betont im Gespräch mit com! professional, dass der Software-Ansatz des Start-ups ein Hardware-Lock-in vermeide. Die Software laufe auf einem breiten Spektrum von zertifizierten Storage-Systemen und eigne sich besonders für Standard-Hardware, was zu größeren Kosteneinsparungen für die Kunden führe. Zudem sei sie voll integrierbar für die Virtualisierungs- und Cloud-Umgebungen von Citrix, VMware und Microsoft sowie für Open-Source-Ansätze von Open Stack und Cloud Stack.

Das Betriebssystem NexentaStor 4.0 soll zukünftig durch Nexenta Edge ergänzt werden, das dann für sämtliche unstrukturierten Daten Integrationsmöglichkeiten anbieten soll. Ein gemeinsamer Management-Layer soll zudem Block-, File- und Object-Speicherdaten zusammenführen.

Für IDC gehört Nexenta zu den „Hot Vendors“, weil dieser Hersteller mit SDS auf Basis der Open-Source-Technologie ZFS ein klares Profil entwickelt habe. Das Z File System (ZFS) war ursprünglich von Sun entwickelt worden. Laut IDC eignet sich diese Technologie auch besonders für Cloud- und Big-Data-Umgebungen.

CEO Maner räumt gegenüber com! professional ein, dass die großen Storage-Konkurrenten inzwischen aufgewacht sind und ihrerseits SDS-Lösungen entwickeln. So sei EMC mit seinem Produkt ViPR zwar bereits auf dem richtigen Weg, aber immer noch durch die proprietäre Hardware aus dem eigenen Hause gefesselt. ViPR (Virtualization Platform Reinvented) wurde 2013 auf der EMC World in Las Vegas präsentiert. Amitabh Srivastava, Chef der EMC-Sparte Advanced Storage, stellte dort die EMC-Version von Software-defined Storage vor.

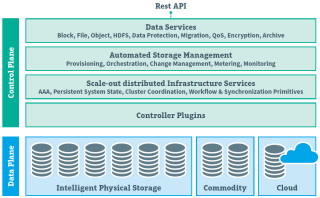

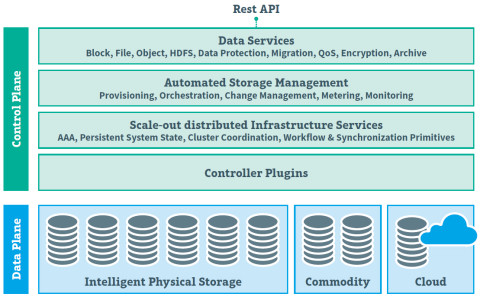

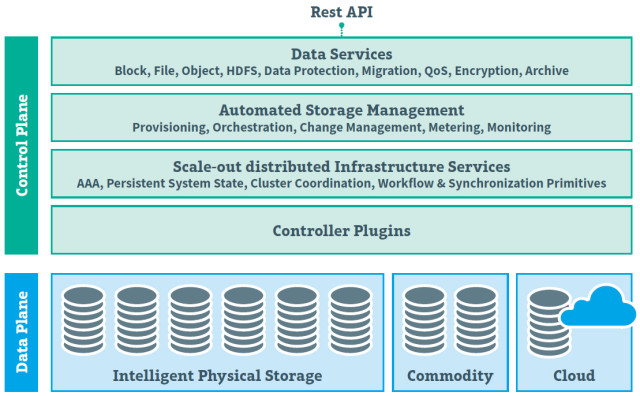

ViPR soll die Integration heterogener Speicher-Hardware im Zeitalter von Cloud- und Big-Data-Umgebungen bringen, was bisher nicht gerade im Interesse von EMC, dem Marktführer für externe Speichersysteme, war. So soll ViPR Schnittstellen (APIs) und Adapter zur Verfügung stellen, mit denen unterschiedlichste Geräte und Programme zusammenarbeiten können. Technisch will EMC das ermöglichen durch eine Trennung von Control Plane und Data Plane auf Speicherebene (siehe Grafik unten).

Der Ansatz lässt sich allerdings nur realisieren, wenn die großen Hardware-Konkurrenten wie Net App, HDS oder IBM ihre Produkte für die EMC-Software öffnen und die Schnittstellen verfügbar machen.

David Floyer, CTO und Mitbegründer der Analystengruppe Wikibon, verweist darauf, dass EMC mit seiner Tochter VMware sehr nahe an der Software-Entwicklung dran ist und damit einen entscheidenden Konkurrenzvorteil hat. Sehr viele EMC-Kunden hätten zudem VMware-Lösungen implementiert und sind somit zumindest „Software-driven“. Das könne die ViPR-Einführung erleichtern.

5. Teil: „Radikale SDS-Ansätze“

Radikale SDS-Ansätze

Über SDS wird viel gesprochen und manche Hersteller – gerade aus der alten Hardware-Storage-Welt – scheinen nur die Labels ihrer Produkte und Strategien ausgetauscht zu haben. So hat DataCore seinen ursprünglichen Virtualisierungsansatz für die Pool-Bildung von Speicher-Arrays unterschiedlicher Hersteller einfach in „Software-defined“ umgetauft, ohne an dem Produkt etwas zu ändern. Daher ist es umso interessanter, auch einige Start-ups näher in Augenschein zu nehmen, die bislang in Europa und Deutschland noch nicht im Mittelpunkt des Interesses stehen.

Da ist zum Beispiel Tegile, eine Firma, die heute in jenem großen Gebäudekomplex im Silicon Valley untergebracht ist, in dem noch vor ein paar Jahren Sun zu Hause war. Tegile setzt an dem Punkt an, dass viele Anwender auf den SSD-Zug aufgesprungen sind und ihre Speicher-Arrays und/oder Server mit Flash-Speicher vollpacken, um die Performance ihrer Storage-Infrastruktur und ihrer Anwendungen angesichts des permanenten Datenwachstums hoch zu halten.

Tegile hat einen Software-Layer entwickelt, der für Hybrid- oder All-Storage-Systeme geeignet ist. Ein eigenes Betriebssystem, IntelliFlash Operating Environment genannt, steuert zwei Bereiche: Performance und Kapazität. Eine neue Hardware-Komponente ist nicht erforderlich, stattdessen arbeitet man eng mit Flash-Herstellern wie SanDisk oder HGST zusammen. Das 2012 an den Markt gegangene Unternehmen hat bereits über 500 Kunden gewonnen, die die Tegile-Software in ihre SSD-Infrastruktur integriert haben, darunter eine Branchengröße wie AT&T. Schrittweise sollen immer mehr Medien in die Lösung integriert werden, auch dicht gepackte oder preisgünstige Flash-Speicher.

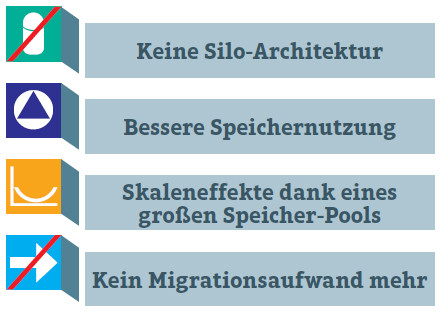

Das Start-up Scality wiederum bezeichnet seinen Ansatz als Software-defined Storage at Petabyte Scale: Seine Software soll großen Firmen und Service-Providern helfen, eine skalierfähige Cloud-Storage-Infrastruktur auf x86-Standard-Servern zu entwickeln. Mit dem Produkt Scality RING kann eine Struktur für ein Software-defined Datacenter eingeführt werden, die mandantenfähig ist sowie viele Workloads und unterschiedliche Anwendungen unterstützt.

Es wird ein einziger großer Speicher-Pool gebildet, in den weitere Commodity-Hardware beziehungsweise -Server auf Linuxbasis und ohne Zertifizierung eingefügt werden können. Über einen Scale Out Access Layer und Unified Storage Interfaces wird der Zugang zu Block-, File- und Object-Storage geregelt. Ferner ist eine Hadoop-Integration vorgesehen. Eine zentrale Stelle in der Softwarelösung nimmt ein vom Massachusetts Institute of Technology (MIT) entwickelter Peer-to-Peer-Algorithmus (CHORD genannt) ein, der eine ausfallsichere und belastbare Ringstruktur garantieren soll.

Drittes Beispiel: 2012 hat PernixData mit der Software PernixData FVP eine Lösung vorgestellt, die ebenfalls ohne neue Speicher-Hardware auskommt. Bisher, so die Überlegung von CEO und Mitbegründer des Unternehmens Poojan Kumar, hat man in der Regel die Performance der Storage-Infrastruktur durch das Hinzufügen neuer Arrays oder Festplatten sowie durch All-Flash- oder Hybrid-Arrays erhöht.

Mit dieser Koppelung von Performance und Kapazität will das Start-up Schluss machen, indem alle bestehenden Performance-Ressourcen auf den einzelnen Servern im Netzwerk aggregiert und für die Speicherseite genutzt werden. Das geht von SSDs und Controller-Karten bis zum RAM. Die Aggregation leistet ein Software-Layer, der direkt an einen VMware-Hypervisor angeschlossen ist. In künftigen Versionen soll das auch mit Virtualisierungs-Software von Citrix und Microsoft möglich sein. CEO Kumar spricht von einer neuen Storage-Intelligenz auf der Server-Seite, die der Performance auf der Speicherseite zugutekommt und keine neuen Hardware-Kosten verursacht.

6. Teil: „Ohne Infrastruktur geht es nicht“

Ohne Infrastruktur geht es nicht

Was man angesichts der vielen neuen Möglichkeiten, die Speicherleistungen per Software-defined-Technologien zu verbessern, nicht vergessen sollte: Ganz ohne eine Infrastruktur aus klassischer Speicher-Hardware geht gar nichts. Noch immer sind diverse Datenbehälter notwendig, die die digitalen Informationen auf Festplatten, SSDs oder sogar auf Magnetbändern aufnehmen – und zwar egal, ob sie wie bisher aus strukturierten Business-Programmen à la SAP oder aus unstrukturierten Daten von Sensoren, dem Internet und Social Media stammen.

Oder anders gesagt: Die Zukunft von Speicherriesen wie EMC, IBM oder NetApp sieht gar nicht so schlecht aus, zumal sie ja ebenfalls damit begonnen haben, sich mit Software-defined-Alternativen zu befassen. Und sie sind nach wie vor finanzkräftig genug, um sich die eine oder andere SDS-Variante hinzuzukaufen.

Test-Framework

Testautomatisierung mit C# und Atata

Atata ist ein umfassendes C#-Framework für die Web-Testautomatisierung, das auf Selenium WebDriver basiert. Es verwendet das Fluent Page Object Pattern und verfügt über ein einzigartiges Protokollierungssystem sowie Trigger-Funktionalitäten.

>>

Programmiersprache

Primärkonstruktoren in C# erleichtern den Code-Refactoring-Prozess

Zusammenfassen, was zusammen gehört: Dabei helfen die in C# 12 neu eingeführten Primärkonstruktoren, indem sie Code kürzer und klarer machen.

>>

Huawei Roadshow 2024

Technologie auf Rädern - der Show-Truck von Huawei ist unterwegs

Die Huawei Europe Enterprise Roadshow läuft dieses Jahr unter dem Thema "Digital & Green: Accelerate Industrial Intelligence". Im Show-Truck zeigt das Unternehmen neueste Produkte und Lösungen. Ziel ist es, Kunden und Partner zusammenzubringen.

>>

Nach der Unify-Übernahme

Mitels kombinierte Portfoliostrategie

Der UCC-Spezialist Mitel bereinigt nach der Unify-Übernahme sein Portfolio – und möchte sich auf die Bereiche Hybrid Cloud-Anwendungen, Integrationsmöglichkeiten in vertikalen Branchen sowie auf den DECT-Bereich konzentrieren.

>>