27.04.2015

Hyperkonvergente Systeme

1. Teil: „Datenzentren im Rack-Format machen flexibel“

Datenzentren im Rack-Format machen flexibel

Autor: Harald Töpfer

shutterstock / Aqwees / Ovchinnkov Vladimir

Einfache Installation und unkomplizierter Rechenzentrumsbetrieb dank Vollintegration. Hyperkonvergente Systeme versprechen die perfekte Skalierbarkeit für alle Standardaufgaben.

Herkömmliche Rechenzentrumsstrukturen werden den zukünftigen Anforderungen an die Schnelligkeit und Flexibilität der Business-IT nicht mehr gerecht. Zu komplex und unflexibel ist deren Aufbau in Inseln und spezialisierten Einheiten.

Eine Weile wurde versucht, durch Tuning-Maßnahmen mit dem Datenwachstum und den Anforderungen an Bandbreite und Schnelligkeit mitzuhalten. Flash-Arrays beispielsweise beschleunigen den Zugriff auf Speicherinhalte enorm, WAN-Optimizer (Wide Area Networks) und Load-Balancer gewährleisten eine rasche Auslieferung über öffentliche Netze, und die Server-Virtualisierung hat für eine wesentlich bessere Auslastung und flexiblere Zuordnung von Rechenkapazität gesorgt.

All diese Maßnahmen ändern aber nichts an dem grundlegenden Dilemma: Anwender erwarten einen perfekten Service, und sie erwarten ihn in Tagen oder Wochen, nicht in Monaten oder gar Jahren. Schließlich sind sie das im privaten Umfeld längst so gewohnt. Die dafür nötige Flexibilität kann ein Rechenzentrum aber nur erbringen, wenn es weitgehend virtualisiert ist, sich also auf dem Weg zum Software-defined Data Center (SDDC) befindet.

Rechenzentrum im Kleinformat

Komplette SDDCs in großem Maßstab sind noch ein Wunschtraum, im Kleinformat kann man sie jedoch schon kaufen: sogenannte Hyper-converged Infrastructure Appliances (HCIAs) vereinen alle Leistungsmerkmale eines Rechenzentrums auf nur zwei Höheneinheiten – von virtuellen Servern über Speicher und Netzwerk bis hin zu Backup und Disaster Recovery. Vorangetrieben wurde die Entwicklung im Wesentlichen von zwei Neulingen am Markt: Nutanix und Simplivity.

Wie wichtig die etablierten Hersteller diese Kampfansage nehmen, zeigte sich schnell: Auf der VMworld 2014 stellte VMware seine eigene hyperkonvergente Infrastruktur unter dem Namen Evo:Rail vor. Das Unternehmen zeigte außerdem die Konzeptstudie Evo:Rack, mit der sich eine hyperkonvergente Infrastruktur über Dutzende von Racks aufbauen lässt – ein großer Schritt hin zum hochskalierbaren Software-defined Data Center.

Auch Hewlett-Packard nutzte die VMworld 2014, um seinen Einstieg in den Hyperkonvergenz-Markt anzukündigen. Unter dem sperrigen Namen HP ConvergedSystem 200-HC StoreVirtual System stellte das Unternehmen eine hyperkonvergente Appliance vor, die hauptsächlich auf HP-Hard- und -Software sowie VMwares vCenter als Managementplattform beruht.

2. Teil: „Hyperkonvergent oder nur konvergent?“

Hyperkonvergent oder nur konvergent?

Schon seit mehreren Jahren bieten Hersteller sogenannte konvergente Infrastrukturen an, die ebenfalls die Evolution eines Rechenzentrums hin zum SDDC ermöglichen sollen. Das Spektrum reicht von VCE vBlock über FlexPod von NetApp und Cisco bis hin zu IBM Flex System, HP Converged System, Dell Active System oder Oracle Virtual Compute.

Der größte Unterschied zwischen einer hyperkonvergenten und einer „bloß“ konvergenten Infrastruktur liegt in der für den Nutzer sichtbaren Komplexität, die sich bereits im Aufbau zeigt: „In einem konvergenten System werden alle Hardware-Komponenten einzeln verbaut, also für das Netzwerk ein Switch, für Storage ein Storage-System und für die Compute-Power ein oder mehrere Server-Systeme“, sagt Erwin Breneis, Cloud Management Solutions, Manager Systems Engineering bei VMware.

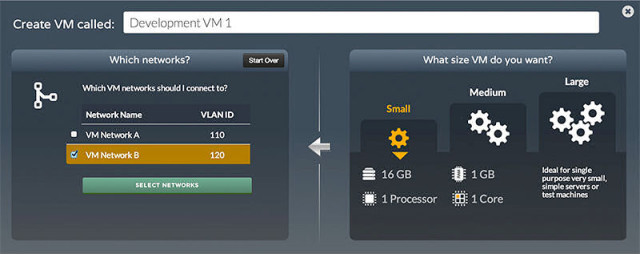

Eine hyperkonvergente Infrastruktur ist dagegen eine Blackbox, sämtliche Komponenten werden in eine Appliance integriert. Wie die Hardware aufgebaut ist, braucht den Anwender nicht zu interessieren. Er schließt das System an und richtet seine virtuellen Maschinen ein – fertig.

Konvergente Infrastrukturen bestehen dagegen aus Komponenten, die zwar aufeinander abgestimmt sind, aber dennoch erheblichen Installations- und Konfigurationsaufwand erfordern. Auch das Management bleibt deutlich komplexer, denn jede Infrastrukturkomponente bringt eigene Steuerungssoftware mit. „Das bedeutet auch unterschiedliche Vorgehensweisen bei den Update-Prozessen“, ergänzt Breneis.

„Hyper-converged Systems bringen das Konzept von Converged Infrastructure auf die nächste Stufe“, sagt Martin Drissner, Virtualization & Cloud Architect beim Systemhaus Fritz & Macziol. Ähnlich wie Mitbewerber Bechtle (siehe Interview mit Roland König) hat das Unternehmen die Zeichen der Zeit erkannt und bietet seinen Kunden seit letztem Jahr hyperkonvergente Systeme an.

Neben den vorgefertigten Appliances von Simplivity setzt Fritz & Macziol aber auch auf ein Baukastenprinzip, bei dem die Hyper-converged Infrastructure Appliance (HCIA) aus Standardkomponenten zusammengestellt wird. Software-Layer wie Virtual SAN von VMware oder Scale IO von EMC sorgen für eine Virtualisierung des Speichers (Software-defined Storage) und ermöglichen so im Zusammenspiel mit einem Hypervisor den Betrieb als hyperkonvergente Appliance.

3. Teil: „Die wesentlichen Vorteile der Hyperkonvergenz“

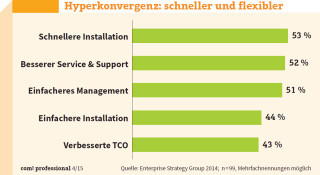

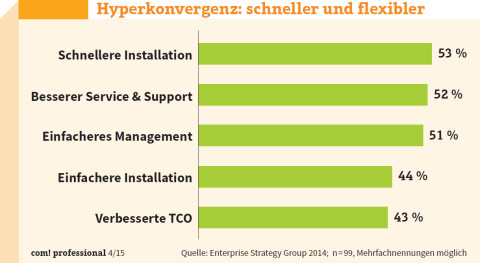

Die wesentlichen Vorteile der Hyperkonvergenz

Die Abgrenzung hyperkonvergent versus konvergent hat die Vorteile der Hyper-converged Infrastructure Appliances bereits angedeutet: Hochintegriert und kompakt benötigen sie nicht nur sehr wenig Platz – meist genügen zwei bis vier Höheneinheiten in einem 19-Zoll-Rack – sie sind auch ausgesprochen leicht zu installieren und zu administrieren. 15 Minuten bis maximal ein paar Stunden genügen, um das System einsatzbereit zu bekommen.

„Für die Inbetriebnahme des Systems sind nur wenige Konfigurationsschritte erforderlich und der Kunde muss nicht mehr selbst für die Kompatibilität der einzelnen Komponenten sorgen“, kommentiert VMware-Manager Breneis. Bei der Planung und Installation herkömmlicher Rechenzentren gehen dagegen meist Monate, wenn nicht sogar Jahre ins Land, beim Aufbau einer konvergenten Infrastruktur immerhin noch Wochen.

Alle Komponenten einer HCIA sind aufeinander abgestimmt und integriert, es wird kein zusätzliches Speichernetzwerk (Storage Area Network, SAN) benötigt, das nur mit Spezialkenntnissen aufgebaut und betrieben werden kann – und das vor allem beim Zugriff vieler virtueller Maschinen auf dieselben Speichereinheiten (Logical Unit Number, LUN) schnell zum Performance-Flaschenhals werden kann.

Die Integration hat laut Breneis aber nicht nur bei Installation und Management große Vorzüge, sondern auch bei der Aktualisierung: „Ein weiteres Merkmal ist das One-Klick-Update, das einen sehr großen Vorteil gegenüber herkömmlichen Infrastrukturen bietet. Der Hersteller der HCIA stellt für ein Update von Treibern und Software einen integrierten Update-Prozess bereit, in den er alle betroffenen Komponenten einbezieht.“

Skalierung: ja, aber …

Auch die Skalierung von HCIAs ist denkbar einfach: Benötigt man mehr Rechenleistung, zusätzlichen Speicher oder weitere Knoten, ergänzt man die Infrastruktur einfach durch eine neue Appliance. Diese Einfachheit hat allerdings einen Haken, wie Martin Drissner von Fritz & Macziol einräumt: „Eine Erweiterung ist häufig nur pro Building Block möglich – also durch eine Einheit mit CPU, Memory und Storage.“ Wer mehr Speicher oder Rechenleistung will, muss folglich eine weitere HCIA kaufen. Festplatten nachzurüsten, zusätzlichen Arbeitsspeicher zu integrieren oder schnellere CPUs zu installieren, das ist im hyperkonvergenten Konzept eigentlich nicht vorgesehen.

Gerade was den Speicher angeht, sind HCIAs deshalb vergleichsweise teuer. Rein auf die Storage-Kapazität bezogen liegt der Preis pro Gigabyte im zweistelligen Dollarbereich und damit sogar über den Kosten für Hochleistungs-Flash-Arrays. Der Vergleich hinkt allerdings erheblich, denn HCIAs bieten nicht nur sehr viel mehr als eine reine Speicherlösung, sie sind auch wahre Optimierungskünstler, wenn es um die Speichernutzung geht. Während in herkömmlichen Rechenzentren ein großer Teil der Storage-Kapazität ungenutzt bleibt, gewährleisten die HCIAs durch Deduplizierung und Komprimierung maximale Speicherauslastung.

Da die HCIAs auf Standard-x86-Komponenten beruhen, stoßen sie bei sehr anspruchsvollen Aufgaben oder speziellen Anforderungen an ihre Grenzen. Im High-Performance-Computing-Bereich oder bei der Echtzeitanalyse großer Datenmengen sind sie deshalb nicht einsetzbar. Zumindest noch nicht, denn HCIAs stehen ganz am Anfang: „Die Einsatzgebiete werden sich mit zunehmender Erfahrung aus der Praxis erweitern“, sagt Martin Drissner von Fritz & Macziol, und vergleicht die Entwicklung mit der Server-Virtualisierung im x86-Bereich. Kunden hätten den Hypervisor VMware ESXi 1.5 erstmals 2002 produktiv eingesetzt: „Seitdem ist viel passiert.“

4. Teil: „Einsatzgebiete, Kosten & Hersteller der HCIAs“

Einsatzgebiete, Kosten & Hersteller der HCIAs

Die leichte und schnelle Installation und die geringe Wartungsintensität prädestinieren HCIAs für den Einsatz in Filialen und Niederlassungen, in denen kein IT-Personal vorhanden ist. Diese „Branch Office“-Appliances sind auch die preisgünstigsten. „Der Einstieg für die Infrastruktur startet bei circa 20.000 Euro, zum Beispiel für die IT-Infrastruktur einer Außenstelle“, sagt Drissner. Darüber hinaus sind HCIAs natürlich für alle Aufgaben besonders geeignet, in denen virtuelle Systeme ihre Flexibilität ausspielen können. Zu nennen wären etwa virtuelle Desktop-Infrastrukturen (VDI) oder Hochverfügbarkeitslösungen mit mehreren räumlich verteilten Knoten. Aber auch für Backup und Recovery gibt es geeignete Systeme.

Selbst anspruchsvolle Aufgaben wie Big Data lassen sich abdecken – zumindest wenn man den Angaben der Hersteller glauben darf. Je nach Anforderungsprofil können hier natürlich schnell sechsstellige Investitionsbeträge zusammenkommen. Ein voll redundantes Rechenzentrum mit zwei HCIAs an verschiedenen Standorten lässt sich aber schon für 60.000 bis 70.000 Euro realisieren.

Die Hersteller

Die HCIAs stehen am Beginn ihrer Karriere. Hersteller wie Nutanix, Simplivity, Scale Computing oder Pivot 3 sind erst seit Kurzem aktiv, ihre hyperkonvergenten Systeme kamen erst vor ein, zwei Jahren auf den Markt. In Deutschland fangen sie ohnehin gerade erst an, Fuß zu fassen. Wer sich auf ein hyperkonvergentes System einlässt, muss also auch ein gewisses Maß an Mut mitbringen: „Für die noch recht junge Technologie sind weniger Erfahrungswerte vorhanden als für klassische Infrastrukturlösungen“, so Drissner.

Tabelle:

Noch ist der Markt für Hyper-converged Infrastructure Appliances (HCIAs) übersichtlich. Mit VMware und dessen OEM-Partnern steigen nun auch die großen Anbieter ein.

Einer der am ehesten etablierten Vertreter ist Nutanix. Das Unternehmen entstand 2009 aus dem Ingenieursteam, das für Google, Facebook und Amazon ein hochskalierbares Dateisystem entwickelte.

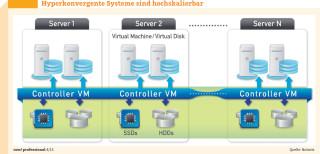

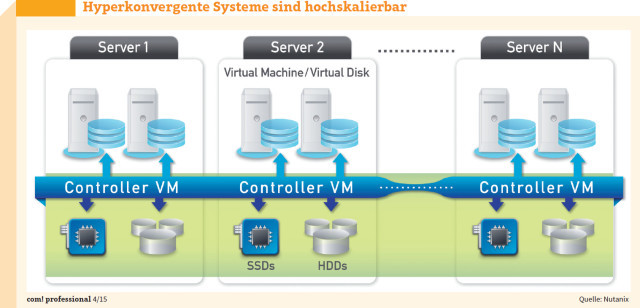

Seit 2011 bietet der Hersteller mit der Virtual Computing Platform eine HCIA, die aus Standard-x86-Hardware, einem Hypervisor (ESXi, Hyper-V oder KVM) und dem Nutanix Operating System (NOS) besteht. Auf dem Hypervisor wird der Nutanix Controller VM (CVM) als virtuelle Maschine installiert. Der CVM ist für die Kommunikation mit dem Hypervisor und den darauf laufenden virtuellen Maschinen zuständig. Mehrere Knoten bilden zusammen ein verteiltes System, das Nutanix Distributed File System (NDFS). Je nach Hypervisor präsentiert der CVM dieses als NFS, iSCSI oder Server Message Block. Für den Hypervisor sieht das NDFS wie ein zentralisiertes Storage- Array aus, tatsächlich werden aber alle Datenströme lokal gehalten.

Die HCIAs sind in verschiedenen Serien und Ausbaustufen erhältlich, beginnend bei der vier Rechenknoten fassenden NX-1000-Serie mit sechs CPU-Kernen, 200 GByte Flash und 2 TByte Festplattenspeicher pro Knoten.

In Deutschland sind sie über die Distributoren ADN und Also erhältlich. Erster Systempartner ist das IT-Systemhaus Targosoft, das seit Beginn dieses Jahres zu Kramer & Crew gehört. Die Nutanix-Software kommt außerdem in den XC Web-scale Converged Appliances von Dell zum Einsatz.

5. Teil: „HCIA-Lösungen von Simplivity, VMware und HP“

HCIA-Lösungen von Simplivity, VMware und HP

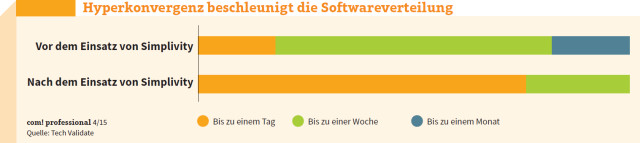

Während Nutanix mehrere Hypervisoren anbietet, hat sich Simplivity auf die VMware-Lösung vSphere konzentriert. Weitere Hypervisoren sollen aber demnächst ebenfalls verwendet werden können. Simplivity wurde 2009 gegründet und brachte sein Produkt Omnicube 2012 auf den Markt. Herzstück der Appliance ist die Omnistack Data Virtualization Platform, die alle Daten in 4 bis 8 KByte große Blöcke aufbricht, dedupliziert, komprimiert und optimiert. Eine eigene PCIe-Einsteckkarte, der Omnicube Accelerator, sorgt dafür, dass dies im laufenden Betrieb ohne Leistungseinbußen möglich ist.

Die HCIA ist derzeit in drei Varianten erhältlich. Neben dem Einstiegsmodell CN-2200 mit 8 bis 24 CPU-Kernen und 5 bis 10 TByte effektiver Speicherkapazität gibt es eine Version (CN-3000), die bis zu 40 TByte effektiven Storage anbietet, sowie eine Hochleistungsvariante (CN-5000), die mit mehr SSD-Speicher und schnelleren Festplatten ausgerüstet und für Großunternehmen oder Cloud-Provider gedacht ist.

Mit Omnicube Cloud gibt es aber auch eine preisgünstige Erweiterung auf Basis der Amazon Web Services (AWS), die sich zum Beispiel für entfernte Backups oder die Archivierung eignet. Im August 2014 hat der Hersteller außerdem eine Zusammenarbeit mit Cisco angekündigt. Die Lösung besteht aus Unified Computing Servern (UCS) von Cisco, auf denen Omnistack vorinstalliert ist. Vertrieben werden die Simplivity-Produkte in Deutschland über ein wachsendes Netzwerk von Systemhäusern und Integratoren, darunter Arrow ECS, Bechtle und Fritz & Macziol.

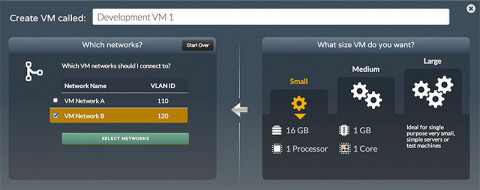

Einen ähnlichen Ansatz wie Simplivity mit Omnistack auf Cisco-Maschinen verfolgt VMware mit Evo:Rail. Das Unternehmen liefert den Software-Stack, der aus den Hardware-Komponenten der Partner eine hyperkonvergente Infrastruktur macht. Der Anbieter stellt das Softwarepaket und die Anweisungen zum Erstellen der Appliance bereit. Die Evo:Rail-Partner sind für das Beziehen der Hardware, das Erstellen der Appliance, den Verkauf an Kunden und den Support für Hardware und Software zuständig. „Mit Evo:Rail sprechen wir vor allem diejenigen Kunden an, die nach einfachen und schnellen Lösungen suchen und nicht über die Zeit und/oder das Personal verfügen, um selbstständig ihre Infrastruktur von Grund auf aufzubauen“, so VMware-Manager Breneis.

Die Appliance bietet durch ihre Architektur mit vier Nodes eine integrierte Hochverfügbarkeit. Für die Speicherverwaltung kommt vSAN zum Einsatz. Evo:Rail soll laut Breneis im ersten Halbjahr dieses Jahres auf den Markt kommen. Preise legen die Vertriebspartner (Qualified Evo:Rail Partner, QEP) fest. Zu den QEPs gehören Dell, EMC, Fujitsu, Hitachi Data Systems, HP und NetApp.

Neben dem auf Evo:Rail basierenden Modell HP Converged System 200-HC Evo:Rail bietet Hewlett-Packard eine hyperkonvergente Alternative an, die HPs eigene Software-defined-Storage-Lösung StoreVirtual verwendet – das bereits erwähnte HP ConvergedSystem 200-HC StoreVirtual System. Die zwei Höheneinheiten messende Appliance ist derzeit in zwei Varianten erhältlich: Das Modell HP CS 240-HC StoreVirtual System bietet 64 CPU-Kerne mit je 2 GHz Taktrate, 512 GByte RAM sowie 24 1,2-TByte-SAS-Festplatten (Serial Attached SCSI) im 2,5-Zoll-Format (Small Form Factor, SFF).

Die leistungsfähigere Variante HP CS 242-HC StoreVirtual System bietet 80 CPU-Kerne mit je 2,8 GHz Taktrate, 1 TByte RAM sowie 16 1,2-TByte-SAS-SFF-Drives und acht 400 GByte große SSDs. Beide Maschinen verfügen über je vier Rechenknoten sowie je acht 10-Gigabit-Ethernet- und 1-Gigabit-Ethernet-Ports. Als Hypervisor kommt VMware vSphere zum Einsatz.

Die Verwaltung erfolgt über HP OneView for VMware vCenter. Die CS-200-HC-Systeme sind für Multi-Site Desaster Recovery von VMware zertifiziert. Setzt man mehrere Appliances an unterschiedlichen Standorten ein, werden auch VMware-Features wie zum Beispiel High Availability (Hochverfügbarkeit) und Fault Tolerance (Fehlertoleranz) unterstützt.

6. Teil: „Skepsis und Existenzängste bei den IT-Spezialisten“

Skepsis und Existenzängste bei den IT-Spezialisten

Ein weiterer Anbieter hochintegrierter Appliances ist Scale Computing. Das 2007 gegründete Unternehmen begann mit Speicherlösungen und stellte 2012 mit HC3 eine HCIA vor. Die Appliance nutzt KVM als Hypervisor. Jede VM ist automatisch hochverfügbar. Beim Ausfall eines Knotens entscheidet HC3 automatisch, wo Ressourcen verfügbar sind, und startet dort die VM neu. Der gesamte Speicher wird automatisch in einem virtuellen RAID 10 bereitgestellt.

Ähnlich wie Simplivity mit Omnicube gibt es auch die HC3-Appliance in drei Varianten (HC1000, HC2000, HC4000). Die Bandbreite reicht von vier bis zwölf CPU-Kernen, 32 bis 128 GByte RAM und 2 bis 9,6 TByte physikalischer Speicherkapazität pro eine Höheneinheit messendem Knoten. Ein Starterset besteht immer aus jeweils drei Knoten. Die Preise liegen bei 25.500 Dollar (HC1000 Starterset), 37.500 Dollar (HC2000) und 67.500 Dollar (HC3000). Zusätzliche Knoten sind für 8500, 12.500 und 22.500 Dollar zu haben.

Zu nennen ist schließlich noch Pivot 3. Bereits 2003 gegründet, ist das Unternehmen der Veteran in der HCIA-Branche. Seine Lösung nennt sich vSTAC (Virtual Storage and Compute) und läuft ebenfalls auf Standard-x86-Hardware. Pivot 3 hat sich auf Lösungen für Videoüberwachung und virtuelle Desktop-Infrastrukturen spezialisiert. In Deutschland bietet beispielsweise Avnet die Appliance P Cubed an, die für VDI-Umgebungen mit bis zu 100 Desktops gedacht ist.

Fazit

Noch ist das Interesse an hyperkonvergenten Appliances in Deutschland verhalten. Zu neu sind die Anbieter und die Konzepte, die vor allem bei IT-Spezialisten auf Skepsis stoßen und womöglich sogar Existenzängste auslösen. Schließlich macht ein voll virtualisiertes, hyperkonvergentes Rechenzentrum im Appliance-Format Experten für Speicher, Netzwerk oder Server weitgehend überflüssig. Ein Administrator mit Standardkenntnissen in vCenter, Hyper-V oder KVM reicht in der Regel aus, um die Geräte zu installieren und zu bedienen.

Das allein ist Grund genug, dass die Nachfrage zunehmen wird. Immerhin spricht vieles für den Einsatz der Maschinen. Sie bieten eine Komplettlösung für alle Standardaufgaben und sind in ein paar Stunden oder sogar Minuten einsatzbereit.

Das Allheilmittel, als das sie vom Marketing der Hersteller angepriesen werden, sind sie jedoch sicher nicht. Immer dort, wo spezielle Anforderungen herrschen – seien es große relationale Datenbanken, In-Memory-Big-Data-Anwendungen oder extrem hohe Durchsatzraten – , sind die Boxen noch nicht die erste Wahl. Auch wer einfach nur seinen wachsenden Speicherbedarf befriedigen muss, sollte besser bei dedizierten Storage-Systemen bleiben. Die Kosten pro Gigabyte sind bei einer hyperkonvergenten Appliance noch zu hoch, um sie als Speicherbüchse zu missbrauchen.

7. Teil: „„Klassische IT-Abteilungen werden Service-Anbieter““

„Klassische IT-Abteilungen werden Service-Anbieter“

Unser Interviewpartner ist Roland König, Leiter des Geschäftsfelds Virtualisierung der Bechtle AG und Geschäftsführer des Bechtle IT-Systemhauses München/Regensburg

com! professional: Herr König, was ist der größte Unterschied zwischen einer konvergenten und einer hyperkonvergenten Infrastruktur?

Roland König: Die konvergenten Infrastrukturen sind zwar für die Virtualisierung optimiert, bestehen aber immer noch aus Einzelkomponenten. Planung und Aufbau sind aufwendig, dauern lange und sind nur mit Expertenwissen zu bewerkstelligen.

Hyperkonvergente Infrastrukturen sind darauf ausgelegt, schnell und einfach bestimmte Aufgaben zu erledigen. Die Implementierungszeit beträgt gerade mal zwischen 15 Minuten und zwei Stunden, und die Systeme können von jedem bedient werden, der sich mit der Verwaltung virtueller Umgebungen auskennt.

com! professional: Für welche Aufgaben sind sie geeignet und für welche nicht?

König: Im Prinzip lassen sich alle Standardaufgaben im Rechenzentrum damit abdecken. Wir haben Tests gefahren mit Oracle- und Microsoft-SQL-Datenbanken. Wenn das Design dahinter passt, habe ich im Vergleich zu traditionellen Systemen keine Leistungseinbußen. Natürlich gibt es Einsatzfelder, für die hyperkonvergente Systeme nicht oder noch nicht geeignet sind. Nehmen Sie beispielsweise das Thema Big Data oder auch große SAP-Umgebungen. Die würde ich prinzipiell nicht auf eine hyperkonvergente Infrastruktur verlegen.

com! professional: Hyperkonvergente Systeme basieren auf x86-Standard-Hardware und können in der Leistung sicher nicht mit spezialisierten Lösungen, etwa Flash-Arrays, mithalten, oder?

König: Das sehe ich anders, wir haben Vergleiche gefahren, die diese Vermutung nicht bestätigen. Die Frage ist natürlich, welche Systeme aus der Hyperkonvergenzfamilie Sie verwenden. Die werden sich weiterentwickeln und schneller werden. Es kommt ja bereits die zweite Generation auf den Markt.

com! professional: Was wird diese Generation auszeichnen?

König: Sie wird schneller sein, mehr Knoten unterstützen, mehr Funktionen bieten und natürlich auch weiter in Rechenzentren vorstoßen. Schon heute lösen wir traditionelle Infrastrukturen in mittleren Rechenzentren durch hyperkonvergente Systeme ab. Wir haben Kunden, die überlegen, 30, 40 oder 50 solcher Blöcke zu kaufen. Das sind dann keine kleinen Umgebungen mehr. Wir sind auch dabei, mit einigen Kunden die Auslandsniederlassungen auszurüsten. Das müssen Sie sich mal vorstellen: Sie schicken eine zwei Höheneinheiten große Box in Ihr Auslandsbüro, schließen sie an, verbinden sie mit dem Netzwerk, replizieren die Daten und haben damit Ihre Auslandsniederlassung voll redundant abgesichert, ohne dort einen Administrator beschäftigen zu müssen.

com! professional: Steigt nicht mit 30 oder 40 Blöcken der Managementaufwand stark an?

König: Nein, überhaupt nicht. Sie haben das Management in einem Tool, und wenn es weltweit hundert Appliances sind, dann sehen Sie eben hundert. Sie überblicken den Betrieb in jedem Bereich, das ist wirklich simpel.

com! professional: Kritiker sagen, hyperkonvergente Systeme seien extrem teuer, wenn man sich den Preis pro GByte Speicher ansieht. Stimmt das?

König: Wenn Sie die vorhandene physische Speicherkapazität betrachten, dann mag das stimmen. Wenn Sie aber bedenken, dass hyperkonvergente Systeme durch Komprimierung und Deduplizierung ein Vielfaches dieser Kapazität bereitstellen können, sieht die Rechnung schon ganz anders aus. Ich kenne Systeme, die auf acht Höheneinheiten Petabytes an Daten verwalten, das lässt sich mit traditionellem Storage nicht mehr vergleichen.

com! professional: IT-Abteilungen dürften von dem Trend nicht allzu begeistert sein. Schließlich sind die Arbeitsplätze vieler Spezialisten gefährdet. Wie überzeuge ich den IT-Verantwortlichen davon, in hyperkonvergente Systeme zu investieren?

König: In der Regel werden solche Systeme im Management positioniert, weil es darum geht, die operativen Kosten zu senken. Alle IT-Abteilungen, egal ob klein oder groß, befinden sich gerade in einer Transformation. Sie verändern sich von klassischer IT, die einen Server oder Speicherplatz zur Verfügung stellt, hin zum Service-Anbieter. Die Automatisierung in den hyperkonvergenten Systemen und das simple Management machen die Arbeit der IT-Abteilung schneller und einfacher.

Die Verantwortlichen können sich dann um die eigentlich entscheidenden Probleme kümmern: Wie schnell bringe ich Services auf den Markt? Wo kann ich Services günstig einkaufen und integrieren? Wie kann ich eine verteilte Umgebung für mehr Datensicherheit und Disaster Recovery aufbauen? Da entwickeln sich neue Szenarien, die dem Kunden helfen, die operativen Kosten im Griff zu behalten, obwohl die Anforderungen steigen.

Letzte Hürde genommen

USB-C kommt als einheitlicher Ladestandard

Nach dem Bundestag hat auch der Bundesrat einer EU-Richtlinie zugestimmt, die USB-C als einheitlichen Anschluss zum Laden von Elektrogeräten festlegt.

>>

Autohersteller

Erstes Smartphone von Polestar

Autohersteller Polestar hat in China sein erstes Smartphone vorgestellt, das vor allem gut mit den Fahrzeugen des Herstellers zusammenarbeiten soll.

>>

10 Stationen

1.500 Händler bei der AVM-Roadshow

Der Fokus der Solution Tour 2024 von AVM lag auf den Themen Glasfaser, Wi-Fi 7 und Smart Home, und mehr als 1.500 Handelspartner folgten der Einladung des Herstellers an die insgesamt 10 Standorte in Deutschland.

>>

Ohne Nokia

HMD zeigt erste Smartphones mit der eigenen Marke

Mit den drei neuen Pulse-Modellen bringt HMD seine ersten Smartphones auf den Markt, die nicht mehr unter der Lizenz von Nokia vermarktet werden.

>>