21.09.2023

Data Mesh

1. Teil: „Der Schlüssel zum Datenschatz“

Der Schlüssel zum Datenschatz

Autor: Bernd Reder

Stutterstock

Mit Data Meshs das Potenzial von Daten ausschöpfen.

Zugegeben, Schlagworte wie „Unternehmen sitzen auf einem Datenschatz“ wurden in den vergangenen Jahren überstrapaziert. Doch in der Tat nehmen die Datenbestände in Firmen und öffentlichen Einrichtungen rapide zu. Das zeigt die Studie „Worldwide Global Datasphere Data Forecast 2021-2026“ des Marktforschungsunternehmens IDC. Sie prognostiziert, dass allein das Volumen der unstrukturierten Daten, die weltweit vorhanden sind, zwischen 2023 und 2026 von 115 auf über 200 Zettabyte anwächst. Die Menge der strukturierten Daten soll sich in dieser Zeitspanne fast verdreifachen, von 7,6 auf 21 Zettabyte.

Ein Großteil der Unternehmen hat erkannt, welches geschäftliche Potenzial in diesen Informationsbeständen steckt. So nutzen beispielsweise in Deutschland rund 80 Prozent Daten für die Wertschöpfung. Fast alle (90 Prozent) stufen sich als „datenorientiert“ ein. Das ergab die Analyse „Data-Driven Enterprise 2023“ von IDG Research Services.

Doch die Realität sieht häufig anders aus. Daten zu erfassen, zu konsolidieren und in verwertbare Erkenntnisse umzusetzen (Insights), oder sie gar für neue Geschäftsmodelle zu nutzen, stellt Unternehmen vor große Herausforderungen. So bewertet die Hälfte der Unternehmen, die IDG befragte, das Management und die Qualität der vorhandenen Daten als unzureichend. Und das Beratungshaus Bearingpoint hat auf Basis der Erkenntnisse aus Tausenden von Projekten ermittelt, dass mehrere Faktoren nötig sind, damit Unternehmen ihren „Datenschatz“ heben können. Dazu zählen Kenntnisse der eigenen Datenwelt und die Vorbereitung der Mitarbeiter auf datenorientierte Prozesse, und dies in Verbindung mit dem Einsatz von neuen Technologien.

„Ein Verständnis über die zielgerichtete Datennutzung ist unabdingbar, um neue Datenprodukte anbieten zu können. Dies setzt allerdings eine klare Datenstrategie und umfangreiche Data Governance voraus“, unterstreicht Tomas Chroust, der als Partner bei Bearingpoint für die Schweiz zuständig ist.

Neuer Ansatz: Data Mesh

Um Daten zu „mobilisieren“ und nutzbar zu machen, etabliert sich neben Datenplattformen, Datenmanagementlösungen, Data Fabrices und DataOps ein weiterer Ansatz: Data Mesh. Die Grundidee hat die IT-Spezialistin Zhamak Dehghani vor einigen Jahren beim Technologieberatungshaus Thoughtworks entwickelt. Heute ist sie CEO von Nextdata, das mit Nextdata OS ein Toolset entwickelt hat, mit dem Anwender ein Data Mesh einrichten können.

Doch was verbirgt sich hinter diesem Begriff? Jedenfalls keine Lösung von der Stange, so Benjamin Bohne, Group Vice President Sales CEMEA bei Cloudera: „Data Mesh ist ein Ansatz für den dezentralen Umgang mit Daten und Analysen, um Agilität und Flexibilität für Unternehmen als Ganzes zu erreichen.“

Ein domänenorientiertes Design überträgt den Datenbesitz von einer zentralen Instanz im Unternehmen auf einzelne Teams oder Geschäftsbereiche. „Diese sind nicht nur für ihre Daten verantwortlich, sondern auch dafür, wie diese Daten im Unternehmen genutzt werden können“, ergänzt Genevieve Broadhead, Principal for Retail EMEA im Industry Solutions Team bei MongoDB.

Vier Grundelemente

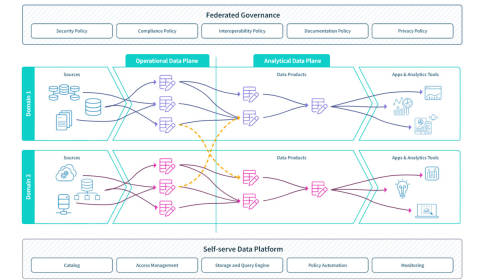

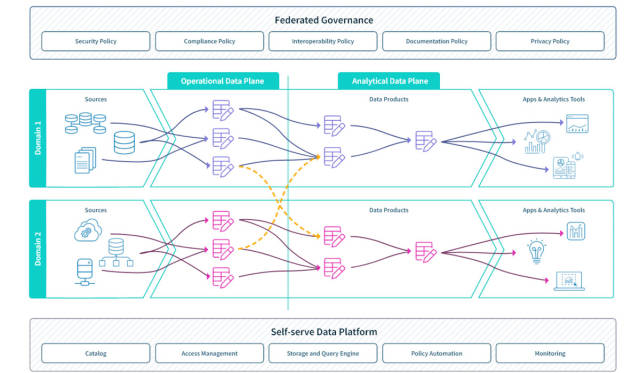

Ein Data Mesh setzt gemäß der Definition von Zhamak Dehghani auf vier Säulen auf. Die erste ist die domänenbasierte Data Ownership. Das heißt, die Kontrolle über die Daten wird von zentralen Datenteams auf Domänen verlagert, die mit bestimmten Daten am besten vertraut sind, etwa Fachbereiche wie Vertrieb, Produktentwicklung oder Finanzwesen.

„Die Fachbereiche wissen schließlich am besten, wie diese Informationen verwaltet und bereitgestellt werden sollen und welche Zugriffsparameter sinnvoll sind“, betont Marc Kleff, Director Solutions Engineering bei NetApp Deutschland. „Das ist das Mesh-Prinzip: Wer die Daten erzeugt, trägt Mitverantwortung.“

Diese Verantwortung umfasst auch die IT-Ressourcen der Domäne. Deshalb bestehen Domain-Teams aus Mitarbeitern der Fachabteilungen und IT-Fachleuten.

Das zweite Element sind Datenprodukte, Stichwort „Data as a Product“. Das heißt, Daten werden über die Grenzen von Domänen hinweg anderen Nutzern („Kunden“) zur Verfügung gestellt, etwa Fachleuten in anderen Abteilungen oder Data Scientists. Diese Datenprodukte müssen mehrere Anforderungen erfüllen, etwa in Bezug auf die Vertrauenswürdigkeit, Interoperabilität, Sicherheit und Ausstattung mit Schnittstellen. Wichtig, ist zudem, dass Kunden solche Datenprodukte auf einfache Weise finden können. Dies lässt sich mithilfe von Metadaten erreichen.

Self-Service und Federated Governance

Damit Teams über die Grenzen von Abteilungen und Domänen hinweg Datenprodukte bereitstellen, pflegen und nutzen können, ist außerdem eine Datenplattform erforderlich, die nach dem Selbstbedienungsmodell funktioniert. Diese Plattform stellt Services und APIs (Application Programming Interfaces) zur Verfügung. Die vierte Säule ist eine „Federated Computational Governance“. Das bedeutet, die Domänen-Teams entwickeln gemeinsam ein übergreifendes Data-Governance-Modell für die Datenprodukte. Dieses berücksichtigt beispielsweise Datenschutzregelungen und lässt sich an geänderte Vorgaben anpassen. Zusätzlich definieren die Data Owner Richtlinien für ihre Datenprodukte.

2. Teil: „Vorteile von Data Meshs“

Vorteile von Data Meshs

Bereits diese Basiselemente machen deutlich, dass die Implementierung eines Data-Mesh-Ansatzes mit einem nicht zu unterschätzenden Aufwand verbunden ist. So müssen Organisationsstrukturen umgebaut und Aufgaben neu verteilt werden. Daher gilt es abzuwägen, ob sich der Aufwand lohnt. Für Genevieve Broadhead steht das außer Frage: „Data Mesh hat zwei Vorteile. Erstens ist dasjenige Geschäftsteam Dateneigentümer, das die Daten am besten versteht und somit die Möglichkeit hat, sie zu ändern und zu erneuern. Zweitens sind die Daten im gesamten Unternehmen zuverlässig verfügbar, so dass sie für viele andere betriebliche und analytische Anwendungsfälle genutzt werden können“, etwa um Innovationen und die Digitalisierung voranzutreiben.

Ein weiterer Pluspunkt ist, dass das dezentrale Konzept Flaschenhälse beseitigt: „Es entstehen keine Engpässe durch die Zentralisierung von Betrieb, Eigentum und Verwaltung von Daten und Analysen“, unterstreicht Benjamin Bohne von Cloudera. Hinzu kommt, dass Fachleute die Aufgabe übernehmen, Daten und Erkenntnisse zu erstellen und als Produkte bereitzustellen. „Daher werden sie nicht als Daten wahrgenommen, sondern als Projekt. Das führt zu eine verbesserten Langlebigkeit und Qualität sowie einem höheren Wert.“

Mit einem Data Mesh soll zudem ein Nachteil herkömmlicher Dateninfrastrukturen überwunden werden: dass Daten in separaten Silos abgelegt werden. Dies führt sonst oft zu einem höheren Bedarf an Storage-Ressourcen und verhindert eine übergreifende Sicht auf Informationen. Dadurch wiederum ist es schwieriger, Daten aus unterschiedlichen Silos zu kombinieren und zu analysieren. Dies kann zu Lasten der Reaktionsfähigkeit und Time-to-Market-Zeiten von Unternehmen und deren Entwicklungsabteilungen gehen.

Allerdings weisen Kritiker darauf hin, dass auch das Domänen-Modell eines Data Mesh dazu führen kann, dass abgeschottete Bereiche entstehen. Hinzu kommt, dass es möglicherweise zu einem Wildwuchs in Bereichen wie der Datenspeicherung und dem Data Management kommt. Dies ist dann der Fall, wenn viele Data Stores und APIs zum Einsatz kommen. Dann steigt der Aufwand für die Verwaltung und damit die Belastung der zuständigen IT- und Datenspezialisten. Und dies ist angesichts des Mangels an solchen Fachleuten etwa in Deutschland und der Schweiz problematisch.

„Um Data Mesh im Unternehmen einzusetzen, muss das bisher zentral vorhandene technische Spezialwissen auf die Business Units verteilt werden. Diese Anpassung stellt für kleinere Unternehmen, die hier teilweise unterbesetzt sind, eine große Herausforderung dar“, bestätigt Till Sander, Chief Technology Officer beim Business-Intelligence-Beratungshaus Areto Consulting in Köln.

Dezentralisierte Datenbestände stellen zudem nach seinen Erfahrungen erhöhte Anforderungen an die Auffindbarkeit und Dokumentation von Informationen. „In diesem Zusammenhang ist der Einsatz eines Data Catalog unerlässlich.“

Die Rolle von Data Fabrics

Im Zusammenhang mit der Debatte über Data Meshs drängst sich vielen Unternehmen unweigerlich eine weitere Frage: Was soll eine Firma tun, die bereits viel Geld und Ressourcen in Lösungen wie Data Fabrics und Data Lakes investiert hat? Die gute Nachrichtig lautet: Storage- und Datenspezialisten sind sich darin einig, dass sich diese Technologien mit einem Data Mesh verbinden lassen.

„Technisch gesehen verfolgt Data Mesh einen dezentralen Ansatz, bei dem die Umsetzung einzelnen Teams überlassen bleibt. Data Fabric orientiert sich an der Idee des klassischen zentralen Data Warehouse, ergänzt diese aber durch ‚moderne‘ Building Blocks, etwa Data Pipelines und Data Lakes“, erläutert Till Sander. Daher könne ein Data Mesh durchaus als „Governed Mesh“ auf Basis einer zentralen Plattform entwickelt werden, bei der die Teams auf einer Data Fabric mit dem gleichen Technologieportfolio arbeiten.

Technische Basis und Storage

Auch Cloudera plädiert für ein „Sowohl als auch“ von Mesh und Fabric. Bei beiden Ansätzen sei das Datenmanagement das Herzstück. Es gibt jedoch nach Einschätzung von Benjamin Bohne auch Unterschiede: „Eine Data Fabric erschließt Daten in großem Umfang, stellt sie in einen geschäftlichen Kontext und macht sie auf sichere und konforme Weise als Self-Service verfügbar. Data Mesh baut dagegen auf dem Wissen auf, das aus allen Datenquellen gesammelt wurde, um die Daten entlang der Domänen bereitzustellen und jeden Datensatz auffindbar zu machen“. Data Mesh sei ohne ein tiefes Datenverständnis und angemessene Data Governance, also eine Data Fabric, nicht möglich.

Zum selben Ergebnis kommt NetApp-Fachmann Marc Kleff, insbesondere vor dem Hintergrund, dass Daten sowohl im Unternehmens-Datacenter als auch in Cloud-Umgebungen gespeichert werden. „Eine Data Fabric ist ein Architekturkonzept für die hybride Multi-Cloud-Welt. Das heißt, sie optimiert Anwendungsfälle wie Data Protection, Daten-Tiering, Produktivdatenbereitstellung, Security und Compliance sowie die Multi-Cloud-Nutzung. Damit bildet die Data Fabric das Fundament für Data-Mesh-Ansätze.“

Apropos Fundament: Wer Data Fabrics oder Meshs einsetzen möchte, sollte bei der Planung prüfen, ob die Storage-Ressourcen für solche Konzepte ausgelegt sind. „Entscheidend ist, dass Daten genau dort abgerufen, analysiert und verarbeitet werden können, wo sie benötigt werden. Dies erfordert Datenmobilität, etwa die Fähigkeit, Anwendungen mit ihren Daten von einem Cloud-Anbieter zu einem anderen zu verschieben“, sagt Remko Deenik, Technical Director Europe beim Storage-Anbieter Pure Storage.

Zudem muss es möglich sein, auf alle Daten zuzugreifen, gleich, ob diese in einer Cloud, Unternehmensrechenzentren oder am Edge vorliegen. Das erfordert laut Deenik Speichersysteme und eine Systemsoftware, dies es ermöglicht, die Datenverwaltung zu vereinfachen und Silos aufzubrechen.

3. Teil: „„Data Meshs erfordern einen organisatorischen Wandel““

„Data Meshs erfordern einen organisatorischen Wandel“

Ein Data Mesh einzurichten, ist nicht nur eine technische Aufgabe. Vielmehr müssen auch die Organisationsstrukturen im IT-Bereich und den Fachabteilungen angepasst werden, unterstreicht Adam Mayer, Director Technical Product Marketing beim Daten- und KI-Spezialisten Qlik.

com! professional: Herr Mayer, zunächst generell zu Data Meshs. Was sind denn die Besonderheiten dieses Ansatzes?

Adam Mayer: Data Mesh ist keine Technologie, sondern vielmehr eine neue Lösungsarchitektur für die Verwaltung von Unternehmensdaten. Die Intention ist der Wechsel zu einer domain-gesteuerten, dezentralen Datenarchitektur, in der die Data Lakes und Data Warehouses als Knotenpunkte des Meshs gesehen werden, nicht als zentraler Punkt der Gesamtarchitektur.

com! professional: Welche Änderungen sind damit in der Praxis verbunden?

Mayer: Das Ziel eines Data Mesh ist das Verständnis von Daten als Produkt mit dezentralem, domain-gesteuerten Dateneigentum. Dieses Modell führt die Rolle des Datenproduktmanagers beziehungsweise Eigentümers ein. Er stammt in der Regel aus einer Geschäftssparte und ist Teil eines funktionsübergreifenden Teams von Dateningenieuren, die den Bereich, die Selbstverwaltung und die Governance auf dezentrale Weise verwalten.

com! professional: In den vergangenen Jahren haben sich Ansätze wie Data Fabrics und Data Lakes etabliert. Wodurch unterscheiden sich Data Meshs von ihnen?

Mayer: Data Mesh und Data Lake sind Architekturen, während Data Fabric eine Reihe von Designprinzipien darstellt, die dabei helfen, eine Vielzahl von Architekturimplementierungen zu unterstützen. Beides sind Ansätze zur Datenverwaltung, die sich gegenseitig ergänzen können. Data Mesh ist das Ziel, Data Fabric ist hingegen das Mittel, um dies zu erreichen.

com! professional: Welche Vorteile bringt ein Data Mesh?

Mayer: Ein Data Mesh fördert die Selbstverwaltung und die Demokratisierung von Daten und Analysen in den Geschäftsbereichen. Dies ermöglicht es diesen, eigene Analyseprojekte zu realisieren. Einige Vorteile und Anwendungsfälle sind beispielsweise die Wiederverwendung von Daten zur Erstellung bereichsübergreifender Datenprodukte und die geringeren Verzögerungen bei datenbasierten Entwicklungsprojekten. Hinzu kommt die höhere Datenagilität.

com! professional: Können Sie ein Beispiel aus der Praxis nennen?

Mayer: Nehmen Sie eine Marketingabteilung. Sie veröffentlicht ein Datenprodukt, das die meistverkauften Produkte beschreibt. Die Abteilung Operations, welche die Nachfragemodelle entwirft, möchte möglicherweise die Informationen über die meistverkauften Produkte aus dem Marketing als Input für ihre Nachfragemodelle verwenden. Mit einem Data Mesh müssen die Fachleute aus dem Operations-Bereich die Daten nicht in ihre Domain duplizieren und eine abgekoppelte Kopie erstellen. Sie können einfach das Marketing-Datenprodukt abonnieren und in ihrer Analyse verwenden.

Der Energieversorger Uniper nutzt beispielsweise Lösungen von Talend als Basis für seine Datenanalyseplattform. Diese ermöglicht ein besseres Verständnis für die Entwicklung des Marktes und die Optimierung des Energiehandels. Gleichzeitig erlaubt sie es Juniper, gesetzliche Vorschriften einzuhalten.

com! professional: Wo sehen Sie die größten Herausforderungen bei der Einführung und dem Betrieb von Data Meshs?

Mayer: Data Mesh erfordert die richtige Architektur und die richtigen technischen Fähigkeiten, es ist jedoch auch eine Frage der Teamorganisation und der Übertragung von Zuständigkeiten, wenn Datenprodukte erstellt werden sollen. Data Mesh ist eine Umstellung auf eine neue Arbeitsweise. Organisationen müssen bereit sein, sich anzupassen. Durch die Dezentralisierung der Verantwortlichkeiten wird versucht, siloartige Data-Engineering-Teams in bereichsübergreifende Teams umzuwandeln. Die Idee einer verteilten Governance kann allerdings Herausforderungen mit sich bringen und sogar neue Silos schaffen.

com! professional: Wie ist die Resonanz deutscher Firmen auf Data Mesh?

Mayer: Data Mesh ist eine Architektur, die sich noch im Anfangsstadium befindet. Daher ist es für uns schwer, die Reaktion auf Data Mesh auf lokaler Ebene zu bestimmen. Aber man kann sagen, dass bisher nur ein kleiner Anteil der Unternehmen über die Fähigkeit und das Vertrauen verfügt, Data Meshs aufzubauen.

com! professional: Und worauf sollten Unternehmen neben der Anpassung von Prozessen achten, wenn sie ein Data Mesh implementieren?

Mayer: Die Schlüsselfunktionen für eine erfolgreiche Implementierung von Datenarchitekturen sind überall auf der Welt dieselben. Es ist wichtig, dass die Elemente einer robusten Datenintegrationslösung vorhanden sind. Dazu gehören Mechanismen zur Erfassung, Verwaltung, Speicherung und zum Zugriff auf Daten. Darüber hinaus ist es wichtig, dass ein angemessenes Data-Governance-Framework zur Verfügung steht. Dieses sollte über ein Metadatenmanagement, Datenlinien und Best Practices für die Datenintegrität verfügen.

4. Teil: „Anwendungsbeispiel: Roche Diagnostics“

Anwendungsbeispiel: Roche Diagnostics

Da es sich bei Data Mesh um ein neues Konzept handelt, hält sich die Zahl der Unternehmen in Grenzen, die bereits entsprechende Konzepte umgesetzt haben. Ein Anwender ist der schweizerische Pharmakonzern Roche. Dessen Sparte Roche Diagnostics startete 2020 ein auf zwei Jahre ausgelegtes Migrationsprojekt, um die bestehende IT-Umgebung in Richtung Cloud-Services und eines modernen Data Stack weiterzuentwickeln. Ein Grund war, dass die Entwicklung von daten- und analysebasierten Produkten für Kunden und Patienten zu langsam ablief. Neue Releases wurden nur alle drei Monate zur Verfügung gestellt.

Ein Kernelement der neuen Strategie war die Einführung eines Data Mesh. Parallel dazu implementierte Roche Diagnostics ein agiles Warehouse auf Basis der Modellierungstechnik Data Vault 2.0. Das Data Mesh besteht aus drei Ebenen. Die erste ist eine Plattform, die das Erstellen von Datenprodukten durch Domänen unterstützt. Das entsprechende Team prüft beispielsweise, mit welchen Methoden sich Datenprodukte auffinden lassen und welche Data Products benötigt werden, um bestimmte Geschäftsanforderungen zu erfüllen.

Die zweite Ebene beschäftigt sich mit der „Mesh Experience“. Es wird beispielsweise erfasst, welche Domains vorhanden sind, welche Datenprodukte sie erzeugen und für welche Use Case sie tauglich sind. Dies erfolgt mithilfe von Lösungen von Anbietern wie Monte Carlo, Collibra und Immuta.

Die erforderliche Infrastruktur stellt eine dritte Ebene bereit. Sie umfasst (Cloud-)Storage- und Compute-Ressourcen von AWS, Google und Microsoft Azure, zudem eine Data-Cloud-Plattform von Snowflake und ein API-Management. Hinzu kommen Lösungen für die Data Ingestion, also das Importieren von großen Datenmengen aus unterschiedlichen Quellen in ein zentrales Speichermedium.

Ein Effekt des Data Mesh ist, dass sich bei Roche Diagnostics die Entwicklungszeiten verkürzt haben, bis ein MVP (Minimum Viable Product) bereitsteht – von etwa sechs Monaten auf sechs bis acht Wochen. Die Zahl der Releases von Anwendungen stieg zudem auf mehr als 120 pro Monat. Außerdem gelang es Roche Diagnostics, sein Datenökosystem auszubauen, etwa durch Einbindung von externen Partnern.

Voraussetzungen und Anforderungen

Basierend auf den eigenen Erfahrungen haben Fachleute von Roche und der Lösungslieferanten einige Punkte zusammengestellt, die für den Erfolg von Data-Mesh-Projekten wichtig sind. Ein zentraler Faktor ist demnach: Ein Unternehmen muss willens sein, Änderungen auf der organisatorischen Ebene vorzunehmen. Das Konzept von Domänen, Datenprodukten und Product Owners verlangt sowohl von IT- und Datenspezialisten als auch den Fachabteilungen ein Umdenken und eine Anpassung bestehender Abläufe – keine einfache Aufgabe.

Ebenso wie bei anderen Technologien, etwa KI und Machine Learning, sollten außerdem stimmige Use Case erarbeitet werden. Mal eben schnell Data Meshs und Data Fabrics einzuführen, funktioniert nicht. Es muss klar definiert sein, auf welche Weise ein Mesh dazu beitragen kann, Geschäftsanforderungen zu erfüllen. Hilfreich ist zudem, wenn der Anwender bereits Erfahrungen mit einem dezentralen Business-Intelligence- und Analytics-Ansatz hat.

Hinzu kommt, dass es keine schlüsselfertigen Data-Mesh-Lösungen gibt. Ein Anwender muss daher mit Anbietern aus unterschiedlichen Sparten zusammenarbeiten. Dazu zählen Spezialisten für das Einspeisen (Ingestion), Modellieren und Virtualisieren von Daten. Hinzu kommen Unternehmen, die Lösungen für Data Discovery und Observability, für das Bereitstellen von Datenprodukten sowie für Storage- und Rechenkapazitäten. Dies stellt hohe Anforderungen an die Projektkoordination, in fachlicher und personeller Beziehung.

Zwei weitere Faktoren dürften sich für viele Unternehmen als besonders hohe Hürden erweisen: Es sind gut qualifizierte Data Engineers erforderlich. Außerdem sollte das Unternehmen bereits einen Gutteil des Weges zu einem Data-Driven Enterprise absolviert haben, also die technischen, organisatorischen und betriebskulturellen Grundlagen geschaffen haben.

Die erste Anforderung zu erfüllen, dürfte wegen des notorischen Mangels an Datenspezialisten schwerfallen. „Letztlich funktioniert ein Data Mesh nur, wenn die Product Owner die entsprechenden Kenntnisse mitbringen. Hier liegen die größten Herausforderungen“, betont Marc Kleff von NetApp. Es gehe allerdings nicht darum, sämtliche Kompetenzen auf niedrigerer Ebene zu duplizieren, sondern Dezentralisierung intelligent aufzusetzen. „Die Teams verwenden ihre Daten als Produkt, aber sie kümmern sich nicht um sämtliche datenrelevante Belange. Sonst wird Data Mesh zum Komplexitätstreiber und Ressourcenfresser.“

Doch auch der zweite Punkt, also die Voraussetzungen für eine datenbasierte Strategie und Wertschöpfung zu schaffen, stellt eine Herausforderung dar. Denn laut der Studie „Data-Driven Enterprise 2023“ von IDG haben nur 36 Prozent der Unternehmen in Deutschland eine Datenstrategie entwickelt. Und ganze 29 Prozent verfügen über ein Datenmanagement. In der Schweiz dürften die Lage ähnlich sein. Somit müssen zunächst solche Defizite beseitigt werden.

5. Teil: „Fazit, Anbieter & Ausblick“

Fazit, Anbieter & Ausblick

Dass ein Data Mesh einen geschäftlichen Nutzen bringen kann, zeigen etliche Projekte, etwa beim Pharmakonzern Roche, dem Online-Bekleidungshändler Zalando, dem Sportartikelunternehmen Adidas und der Streaming-Plattform Netflix. Allerdings handelt es dabei um Firmen, in denen das Erfassen und Analysieren von Daten aus unterschiedlichen Quellen generell eine zentrale Rolle spielt, seien es Informationen über das Nutzungs- und Kaufverhalten, Forschungsdaten, das Feedback von Kunden und Rückmeldungen aus den Lieferketten.

Dagegen muss ein Großteil der Unternehmen zunächst einmal die technischen und organisatorischen Grundlagen legen, um ihren „Datenschatz“ heben zu können. Ganz zu schweigen davon, dass auch den Mitarbeitern vermittelt werden sollte, welche Bedeutung datenbasierte Prozesse und Services haben und welche Rolle sie selbst in einem Data-Driven Enterprise spielen. Daher dürfte ein beträchtlicher Teil der Unternehmen ein Data Mesh derzeit eher als „Nice to Have“ einstufen, nicht als Notwendigkeit.

„Data Mesh ist als Konzept in allen Unternehmen angekommen, die sich mit modernen Daten-Konzepten auseinandersetzen“, betont dagegen Till Sander von Areto Consulting. „Die Umsetzung stellt jedoch Unternehmen unabhängig von der Größe vor Herausforderungen, da hier primär ein organisatorischer Wandel vollzogen werden muss“, räumt der Fachmann ein. Außerdem seien in den Business Units weder das technische Know-how noch die Projektstrukturen vorhanden, um ein solches Vorhaben erfolgreich umzusetzen. Daher empfiehlt er, auch vor dem Hintergrund der Schwierigkeiten, Datenspezialisten zu finden, gegebenenfalls auf das Fachwissen von externen Fachleuten zurückzugreifen.

Huawei Roadshow 2024

Technologie auf Rädern - der Show-Truck von Huawei ist unterwegs

Die Huawei Europe Enterprise Roadshow läuft dieses Jahr unter dem Thema "Digital & Green: Accelerate Industrial Intelligence". Im Show-Truck zeigt das Unternehmen neueste Produkte und Lösungen. Ziel ist es, Kunden und Partner zusammenzubringen.

>>

Nach der Unify-Übernahme

Mitels kombinierte Portfoliostrategie

Der UCC-Spezialist Mitel bereinigt nach der Unify-Übernahme sein Portfolio – und möchte sich auf die Bereiche Hybrid Cloud-Anwendungen, Integrationsmöglichkeiten in vertikalen Branchen sowie auf den DECT-Bereich konzentrieren.

>>

Umweltschutz

Netcloud erhält ISO 14001 Zertifizierung für Umweltmanagement

Das Schweizer ICT-Unternehmen Netcloud hat sich erstmalig im Rahmen eines Audits nach ISO 14001 zertifizieren lassen. Die ISO-Zertifizierung erkennt an wenn Unternehmen sich nachhaltigen Geschäftspraktiken verpflichten.

>>

Cyberbedrohungen überall

IT-Sicherheit unter der Lupe

Cybersecurity ist essentiell in der IT-Planung, doch Prioritätenkonflikte und die Vielfalt der Aufgaben limitieren oft die Umsetzung. Das größte Sicherheitsrisiko bleibt der Mensch.

>>