05.02.2016

Big Data

1. Teil: „Predictive Analytics schlagen das Bauchgefühl“

Predictive Analytics schlagen das Bauchgefühl

Autor: Thomas Hafen

Shutterstock / phipatbig

Mit modernen Vorhersagemethoden gelingen Unternehmen treffendere Prognosen. Predictive-Analytics-Lösungen führen dabei zu fundierten Entscheidungen.

Egal ob im Einkauf, im Vertrieb, im Marketing oder in der Chefetage: In jedem Unternehmen werden ständig Entscheidungen getroffen, die auf Annahmen über die Zukunft basieren. „Um Entscheidungs- und Handlungsalternativen entwickeln zu können, brauchen wir den Blick nach vorn“, sagt Hans Wieser, Business Lead Data Platform bei Microsoft Deutschland.

Neben einfachen statistischen Verfahren wie Extrapolation oder Regression und dem viel zitierten „Bauchgefühl“ werden dabei mit Hilfe der IT zunehmend fortgeschrittene Analysen einsetzt, die dank sogenannter Predictive-Analytics-Software (PA) auch bei großen Datenmengen und komplexen Zusammenhängen zuverlässige Vorhersagen ermöglichen. Dieser Ansatz stoße auf großes Interesse, so Wieser: „Das ist in fast jeder Branche derzeit ein Fokusthema.“

Die Marktforscher sind derselben Meinung und prognostizieren für Predictive Analytics ein starkes Wachstum. Laut Technavio steigen die Umsätze bis 2019 weltweit um durchschnittlich 25 Prozent pro Jahr, Research and Markets und Micromarket Monitor halten sogar Wachstumsraten von über 30 Prozent für möglich. Die Angaben und Prognosen über das Gesamtvolumen des PA-Markts liegen zwischen 2,3 Milliarden Dollar im Jahr 2019 bei Micromarket Monitor und 5,24 Milliarden Dollar im Jahr 2018 bei Research and Markets.

2. Teil: „Die großen Softwarehersteller rüsten auf“

Die großen Softwarehersteller rüsten auf

Die Markterwartungen wecken auch Begehrlichkeiten bei den Konzernen, die selbst nicht oder nicht genügend eigene Expertise im Bereich fortgeschrittener Analysen haben. Bereits 2007 kaufte TIBCO Software den Business-Intelligence-Spezialisten Spotfire, 2009 verleibte sich IBM die Statistikfirma SPSS ein, 2014 übernahm Dell StatSoft und Anfang 2015 schluckte OpenText den BI-Anbieter Actuate.

Auch Microsoft ist auf Einkaufstour und hat im vergangenen Frühjahr die Übernahme von Revolution Analytics abgeschlossen, einem Unternehmen, das mit Revolution R eine Distribution des für fortgeschrittene Analysen häufig verwendeten Programmpakets R anbietet (siehe dazu auch die unten stehende Tabelle).

Das steigende Interesse hat gute Gründe, findet Heleen Snelting, Data Science Manager EMEA bei TIBCO Software: „Predictive Analytics bietet Unternehmen einen signifikanten Wettbewerbsvorteil, weil sie schnellere und fundierte Entscheidungen treffen können. Unternehmen sind dadurch in der Lage, Chancen besser zu nutzen und Risiken vorzeitig zu erkennen und zu umgehen.“

3. Teil: „Vier neue Aspekte der Predictive Analytics“

Vier neue Aspekte der Predictive Analytics

Die angewandten Predictive-Analytics-Verfahren wie multivariate Statistik, neuronale Netze oder maschinelles Lernen sind nicht neu. Sie werden schon seit vielen Jahren in der Forschung, aber auch in der Wirtschaft eingesetzt. Neu in Predictive Analytics sind vor allem vier Aspekte:

- Demokratisierung der Verfahren:

Wie im Bereich Business Intelligence werden auch die Prognosemodelle von Predictive Analytics immer leichter zugänglich. Grafische Bedienoberflächen ersetzen kommandozeilenbasierte Programmierschnittstellen und erlauben es, Analysen per Drag and Drop zusammenzustellen. Cloud-Angebote erleichtern außerdem den Zugang zu fortgeschrittenen Analysemethoden, ohne vorab investieren und komplexe Systeme installieren zu müssen. „Insbesondere im Bereich Labor sehe ich aufgrund der Pay-as-you-go-Angebote, der häufigen Aktualisierungen und der Möglichkeiten zur Skalierung Cloud-Werkzeuge auf dem Vormarsch“, sagt Artus Krohn-Grimberghe, Chief Data Scientist bei der pmOne Analytics GmbH, einer 2015 gegründeten Tochter der pmOne AG, die neben Beratungsleistungen auch eigene Algorithmen für fortgeschrittene Analysen entwickeln und anbieten will.

- Auswertung großer Datenmengen: Durch Big-Data-Analyseverfahren lassen sich Vorhersagen auf Basis großer Mengen unstrukturierter Daten treffen. „Durch die aktuelle Popularität des Begriffs Big Data ist das Interesse in allen Branchen stark gewachsen, Daten zu nutzen, um wertschöpfende Informationen zu generieren“, sagt Nicole Tschauder, Business Expert Analytics bei SAS Deutschland.

- Vernetzung verschiedenster Informationen: „Wo man früher eine Datenbank eingesetzt hat, nutzt man heute viele verschiedene Datenquellen“, erläutert Jakob Rehermann, Geschäftsführer des Berliner Software-Unternehmens Datapine, das seit vier Jahren eine einfach zu bedienende Software-as-a-Service-basierte Business-Intelligence-Lösung für kleine und mittlere Unternehmen entwickelt und ab April auch ein Modul zur Erstellung von Vorhersagen anbieten will.

- Interne und externe Quellen: Während klassische Prognoseverfahren hauptsächlich auf intern erhobenen Daten wie Absatzzahlen oder Einkaufspreisen beruhen, setzen heute viele Anwendungsfälle auf eine Kombination interner Informationen mit externen Angeboten wie Wettervorhersagen, demografischen Entwicklungen, Verkehrsströmen oder auch So-cial-Media-Daten. „Je mehr Informationsquellen ich habe, um so runder wird mein Bild vom Kunden“, sagt Dominik Claßen, Sales Engineering Director EMEA & APAC bei Pentaho. Durch die Vernetzung von Maschinen und internetfähigen Alltagsgegenständen entstehen ständig neue Datenströme, die für Prognosen herangezogen werden können.

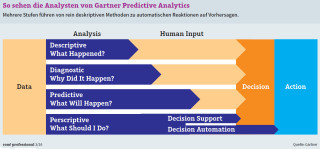

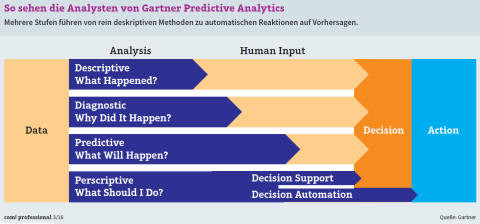

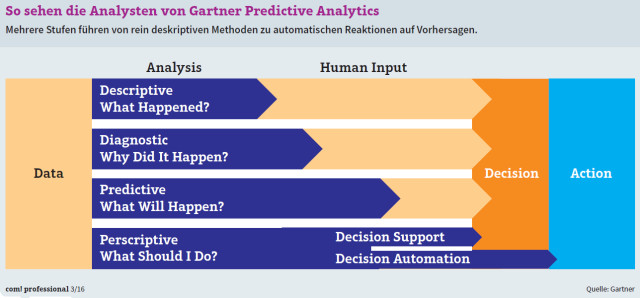

- Neue Steuerungsmöglichkeiten: „Nur zu wissen, was passieren wird, bringt ein Unternehmen nicht weiter. Entscheidend ist, was mit dem vorhergesagten Szenario getan werden muss“, so SAS-Expertin Tschauder. „Erst die Kombination von Echtzeitanalysen und automatisierten Geschäftsprozessen bringt Anwendern den Effizienzgewinn, den sie im harten internationalen Wettbewerb benötigen“, erklärt Dunja Riehemann von Blue Yonder, einem Anbieter von Predictiv-Analytics-Lösungen auf Software-as-a-Service-Basis.

4. Teil: „Die Methoden der Predictive Analytics“

Die Methoden der Predictive Analytics

Klassische statistische Verfahren kommen auch bei Predictive Analytics zum Einsatz. Dabei muss man zwischen linearen und nicht linearen Analysen beziehungsweise Vorhersagemodellen sowie parametrischen und nicht parametrischen Verfahren unterscheiden. Parametrische Verfahren gehen von einer Normalverteilung der Daten aus, der klassischen Gaußschen Glockenkurve. Parameterfreie Ansätze wie der Mann-Whitney-U-Test kommen dagegen ohne Annahmen über die Verteilung der Daten aus.

Zu den linearen Verfahren gehören die multiple lineare Regression (MLR), Partial Least Squares (PLS), Ridge Regression oder LDA (Linear Discriminant Analysis). Zu den nicht linearen zählen LOWESS (Locally Weighted Scatterplot Smoothing), GAM (Generalized Additive Model), MARS (Multiple Adaptive Regression Splines) oder FDA (Flexible Discriminant Analysis).

Hinzu kommen analytische Prognosemodelle, die häufig auf maschinelles Lernen mit Hilfe neuronaler Netze setzen. Das System entdeckt eigenständig oder angeleitet Gesetz-mäßigkeiten auf Basis von Trainingsdaten. Der daraus abgeleitete Algorithmus wird an Testdaten überprüft und optimiert. Nach einigen Durchgängen kann das Verfahren dann auf Daten angewandt werden, deren Klassifikation unbekannt ist. Zu den eingesetzten Verfahren gehören SVM (Support Vector Machine) und RVM (Relevance Vector Machine), Entscheidungsbäume (Decision Trees), Bootstrap Aggregation (Bagging) und Random Forests.

Keine Vorhersage ohne Daten

Die Prognosegüte steht und fällt mit der Datenbasis, weshalb dem Data Mining eine große Bedeutung zukommt. Alle internen verfügbaren Datenquellen zu entdecken, auszuwerten und zusammenzuführen sind vorbereitende Schritte in diesem Prozess. „Data Mining ist die Voraussetzung, um überhaupt Muster erkennen zu können“, sagt Datapine-Geschäftsführer Jakob Rehermann. „Je mehr Daten vorliegen, desto besser können die Algorithmen aus Ereignissen lernen und umso exakter sind die Vorhersagen und Handlungsempfehlungen“, ergänzt Dunja Riehemann von Blue Yonder.

Menge allein genügt nicht, auch die Datenqualität muss stimmen. „Der typische Data Scientist verbringt 80 Prozent seiner Zeit damit, saubere Daten zu bekommen“, sagt Pentaho-Manager Claßen. Ein Data Warehouse ist zur Datenhaltung nicht zwingend notwendig. Es kann sogar kontraproduktiv sein, wenn die Daten zu sehr aggregiert und vorverarbeitet sind. „Viele fortschrittliche Analysen werden mit Roh- oder Detaildaten durchgeführt, weil man so mehr Daten für die Modellbildung hat“, sagt Carsten Bange, Geschäftsführer des Analystenhauses BARC (siehe auch Interview auf der letzten Seite).

5. Teil: „Einsatzszenarien der Predictive Analytics“

Einsatzszenarien der Predictive Analytics

Bessere Prognosen kann jeder gebrauchen. Deshalb sind die Einsatzszenarien vielfältig. Microsoft-Manager Hans Wieser nennt IT-Sicherheitssysteme wie Intrusion Detection and Prevention sowie die Betrugsprävention bei Finanzdienstleistern und Telekommunikationsunternehmen als typische Beispiele.

Heleen Snelting von TIBCO zählt die Betrugserkennung in Echtzeit, prädiktive Instandhaltung (Predictive Maintenance), die Routenoptimierung, das Supply-Chain- und Risikomanagement, das Kundenmarketing und das Mobile Asset Management zu den Haupteinsatzgebieten.

Eine Branche, die sehr stark von den neuen Vorhersagemethoden profitiert, ist der Handel. Amazon etwa generiert einen Großteil seines Umsatzes über die Produktempfehlungen, die jedem Kunden eingeblendet werden, der sich auf der Webseite des Online-Händlers eingeloggt hat. Sie beruhen auf fortgeschrittenen Analysen und beziehen eine Vielzahl von Faktoren wie das individuelle Kaufverhalten, den aktuellen Warenkorb, die lang- und kurzfristigen Abverkaufszahlen eines Produkts, die Preisentwicklung und sogar Erwähnungen in Tweets und Likes mit ein.

Im öffentlichen Raum sind es vor allem die Bereiche Verkehrssteuerung, Energie und Verbrechensprävention, auf denen die größten Hoffnungen liegen. „Wenn ich Verkehrsflüsse besser verstehen und Staus vermeiden will, wenn ich Grids (Stromnetze) besser managen will, um Black-outs zu vermeiden, wenn ich alternative Energiequellen intelligenter integrieren will, brauche ich prädiktive Modelle“, beschreibt Christian Dornacher, Director, Storage and Analytics Solutions bei Hitachi Data Systems, die Entwicklung der Städte zu „Smart Cities“. Datapine-Geschäftsführer Rehermann führt als Beispiel ein Präventionsprogramm für ehemalige Häftlinge in Baltimore und Philadelphia an: „Mit Predictive Analytics konnte die Rückfallquote um 30 Prozent gesenkt werden.“

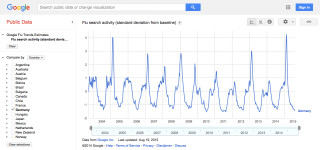

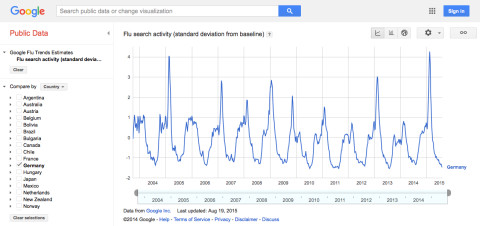

Zu erwähnen ist noch das Gesundheitswesen, das Predictive Analytics bei der Prognose von Krankheiten, aber auch in der Vorsorge und bei der Berechnung von Epidemieverläufen einsetzt. So hat beispielsweise Google mit Flu Trends eine Möglichkeit gefunden, Grippewellen vorherzusagen. Eine Analyse von Milliarden Datensätzen aus den vergangenen zehn Jahren ergab 144 Suchbegriffe, die für ein tagesgenaues Vorhersagemodell relevant sind. „Entscheidend war, dass Google komplett ergebnisoffen an die Analyse ging und nicht von vorneherein Suchbegriffe definiert hat“, sagt Pentaho-Manager Claßen.

Mit Predictive Analytics sind nicht nur erstaunlich genaue Vorhersage-, sondern auch völlig neue Geschäftsmodelle möglich. So setzt die in Deutschland umstrittene Taxi-Alternative Uber auf fortgeschrittene Analysemethoden. Der Erfolg des Unternehmens hängt unter anderem davon ab, dass es sehr genau vorhersagen kann, wo der größte Bedarf an Mitfahrgelegenheiten entstehen wird, ja sogar, wohin die Fahrgäste gebracht werden wollen.

Ein weiteres Beispiel sind die Finanztechnologie-Unternehmen (FinTech), deren Geschäftsmodell auf der Auswertung von Social-Media-Daten beruht. Mit deren Hilfe konnten sie Scoring-Modelle entwickeln, die es erlauben, die Kreditwürdigkeit von Menschen einzustufen, die nicht über eine Kredithistorie verfügen.

6. Teil: „So gelingt der Predictive-Analytics-Einstieg“

So gelingt der Predictive-Analytics-Einstieg

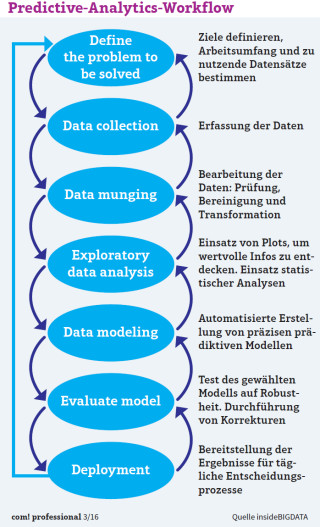

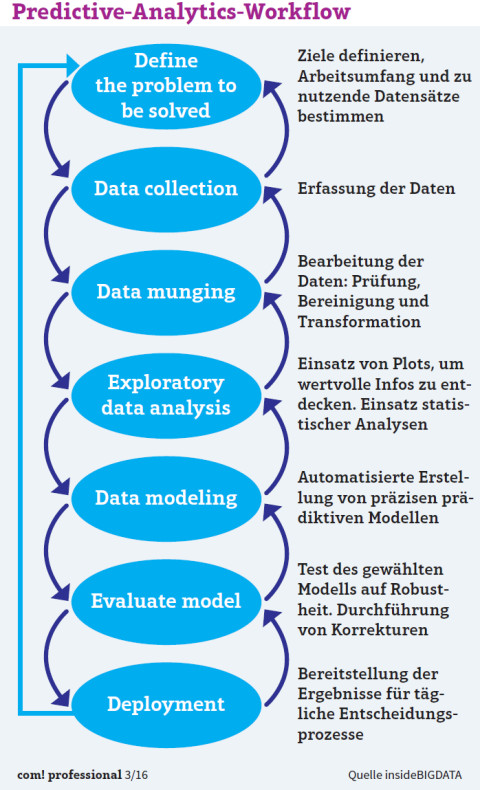

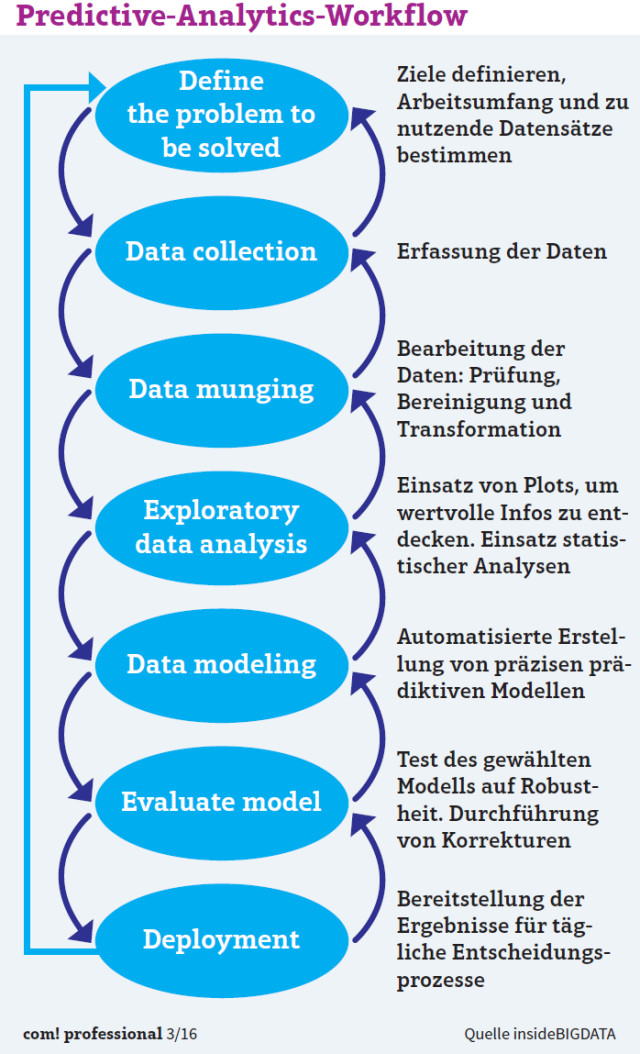

Datensammlung und Aufbereitung, die Wahl des richtigen Modells, Implementierung, Anpassung und schließlich die Interpretation der Ergebnisse stellen vor allem kleine und mittelständische Unternehmen vor erhebliche technische Herausforderungen. „Eine gute Zusammenarbeit zwischen den Fachabteilungen und der IT ist für die Erfassung der relevanten Daten und die Verwendung der richtigen Technologien notwendig“, sagt TIBCO-Managerin Snelting.

Krohn-Grimberghe von pmOne Analytics warnt allerdings vor einer rein technischen Betrachtung. Auch organisatorische und unternehmenskulturelle Aspekte spielten eine große Rolle: „Dazu zählt auch eine Führungspersönlichkeit mit dem Willen, das Unternehmen weiterzuentwickeln und analytische Themen voranzutreiben. Sonst verlaufen solche Initiativen oft im Sande.“ Rado Kotorov, Chief Innovation Officer und Vice President Market Strategy bei Information Builders, einem Anbieter von BI- und Integrationslösungen, sieht dies ähnlich: „Die Herausforderung ist mehr kultureller als technischer Natur.“ Analysen lohnten sich nur, wenn sie auch operationalisiert, das heißt in Anwendungen integriert würden, so Kotorov weiter. „Solange die Ergebnisse auf Papier oder in PowerPoint-Präsentationen bleiben und nicht in betriebsfähige Systeme aufgenommen werden, lässt sich kein Return on Investment erzielen.“

Auch Christian Dornacher von Hitachi Data Systems sieht die Herausforderungen weniger auf der technischen als auf der konzeptionellen Seite: „Man muss sich genau anschauen: Was will ich mit den Daten erreichen?“ Dornacher empfiehlt, mit einem Workshop in das Thema einzusteigen, um diese Frage zu klären. Basierend auf den Resultaten dieses Workshops sollte das Unternehmen einen Lösungsansatz definieren und eine Roadmap erstellen, wie es die Ergebnisse erreichen will. Über Evaluierungs- und Pilotphasen ließe sich dann die richtige Lösung finden. „Das ist klassisches Business-Consulting“, sagt Dornacher.

Krohn-Grimberghe von pmOne empfiehlt, in ein Analytics-Labor zu investieren: „Bereits mit günstigen Open-Source-Technologien lässt sich verproben, ob Use Cases zutreffen und weiterverfolgt werden sollten.“ Erst wenn ein Szenario im Labor Erfolg verspreche, sollte man mit der klassischen Projektarbeit beginnen, so Krohn-Grimberghe weiter.

7. Teil: „Auswahl der Predictive-Analytics-Werkzeuge“

Auswahl der Predictive-Analytics-Werkzeuge

Ist geklärt, wie Predictive Analytics im Unternehmen eingesetzt und welchen Nutzen es bringen soll, geht es an die Wahl der richtigen Werkzeuge. Heleen Snelting von TIBCO nennt einige Voraussetzungen dafür:

- Benutzerfreundlichkeit: In praktisch allen Branchen besteht ein Mangel an Fachkräften mit guten Analysekenntnissen. Daher ist es wichtig, für Predictive Analytics eine Plattform auszuwählen, die in der Handhabung für die Nutzer einfach ist – unabhängig von deren Analyse-Know-how.

- Flexibler Datenzugriff und flexible Datentransformation: Die Lösung sollte es Anwendern ermöglichen, Daten aus verschiedenen Quellen zu kombinieren, ohne SQL-Anweisungen schreiben zu müssen. Folgende Datenquellen sollten dabei einbezogen werden können: Excel, Cloud-Datenquellen (Amazon Redshift), Webservices (OData), Big Data Stores (Cloudera, Hortonworks, PivotalHQ, Teradata Aster), relationale Datenbanken (Oracle, SQL Server, MySQL, IBM DB2, PostgreSQL), Analytic Databases (HP Vertica, Teradata, SAP Hana) und OLAP-Systeme (SAP Netweaver Business Warehouse, Microsoft SQL Server Analysis Services, Oracle Essbase).

- Erweiterte Funktionen: Tools zum Erstellen von Datenbeziehungen, Prognosen und prädiktiven Modellen für Regressionen und Klassifikationen sowie Clustering sind ebenfalls wünschenswert. So lassen sich bei komplexen Daten schnell fortschrittliche Analysen durchführen.

- Skalierbarkeit und Sicherheit: Eine Predictive-Analytics-Lösung sollte skalierbar sein, da die Anzahl an Anwendern in Unternehmen zunimmt. Je mehr Nutzer und Datenquellen vernetzt beziehungsweise angebunden werden, desto wichtiger wird die sichere Verwaltung einer solchen Plattform. Die Lösung sollte darüber hinaus alle Funktionen bereithalten, die ein Unternehmen jetzt und in absehbarer Zeit benötigt.

Bei einem datengetriebenen Ansatz entwickeln sich die Anforderungen meistens mit der Zeit weiter. Das bedeutet, dass Unternehmen heute nicht alle notwendigen Anforderungen verstehen und voraussehen können. Sie sollten sich daher beraten lassen und verschiedene Anbieter und Lösungsangebote vergleichen.

Fazit

Moderne Vorhersagemethoden sind für alle Unternehmen von Vorteil, besonders dann, wenn sie direkt mit automatisierten Aktionen verknüpft werden können, wie dies in Bereichen wie Marketing Automation oder Predictive Maintenance bereits der Fall ist. Das Schürfen, Klassifizieren und Auswerten vorhandener Daten kann – oft in Kombination mit externen Quellen – sogar ganz neue Geschäftsmodelle entstehen lassen.

Die automatisierte Klassifikation von Kunden, Versicherten, Mitarbeitern oder Straftätern und die darauf beruhende Prognose ihres zukünftigen Verhaltens bringen jedoch auch Probleme mit sich. Ob wir wirklich wollen, dass unsere Kreditwürdigkeit durch unsere Facebook-Likes, unsere Kfz-Versicherungsprämie durch unser Fahrverhalten und die Krankenkassenbeiträge durch die Zahl unserer täglichen Schritte bestimmt wird, lässt sich letztlich nur gesellschaftlich entscheiden. Technisch möglich sind solche Szenarien schon heute.

8. Teil: „„Unternehmen profitieren von Predictive Analytics““

„Unternehmen profitieren von Predictive Analytics“

Test-Framework

Testautomatisierung mit C# und Atata

Atata ist ein umfassendes C#-Framework für die Web-Testautomatisierung, das auf Selenium WebDriver basiert. Es verwendet das Fluent Page Object Pattern und verfügt über ein einzigartiges Protokollierungssystem sowie Trigger-Funktionalitäten.

>>

Programmiersprache

Primärkonstruktoren in C# erleichtern den Code-Refactoring-Prozess

Zusammenfassen, was zusammen gehört: Dabei helfen die in C# 12 neu eingeführten Primärkonstruktoren, indem sie Code kürzer und klarer machen.

>>

Huawei Roadshow 2024

Technologie auf Rädern - der Show-Truck von Huawei ist unterwegs

Die Huawei Europe Enterprise Roadshow läuft dieses Jahr unter dem Thema "Digital & Green: Accelerate Industrial Intelligence". Im Show-Truck zeigt das Unternehmen neueste Produkte und Lösungen. Ziel ist es, Kunden und Partner zusammenzubringen.

>>

Tools

GitLab Duo Chat mit KI-Chat-Unterstützung

Der DevSecOps-Plattform-Anbieter GitLab führt den GitLab Duo Chat ein. Dieses Tool integriert Künstliche Intelligenz in die DevSecOps-Workflows.

>>