11.07.2017

Standards für die Cloud

1. Teil: „Der Cloud fehlt es an Transparenz“

Der Cloud fehlt es an Transparenz

Autor: Konstantin Pfliegl

Shutterstock / toozdesign

Echte Cloud-Standards gibt es nicht, vielmehr dominieren De-facto-Standards den Markt. Diese fehlende Transparenz sorgt für Unsicherheit bei Unternehmen.

An der Cloud führt kein Weg vorbei, sie ist ein essenzieller Treiber der digitalen Transformation. Das spiegelt sich einmal mehr im aktuellen „Cloud-Monitor 2017“ von KPMG wider, wonach bereits zwei von drei Unternehmen in Deutschland Cloud-Dienste im Einsatz haben.

Viele Unternehmen haben einen großen Teil ihrer IT-Infrastruktur in die Cloud gehievt und freuen sich, dass ihre Kosten meist sinken und ihre Infrastruktur je nach Anforderung skalierbar ist.

Was aber, wenn ein Unternehmen, aus welchen Gründen auch immer, seine Daten und Anwendungen ins eigene Rechenzentrum zurückholen möchte? Oder wenn man den Cloud-Anbieter wechseln will, weil ein anderer günstiger ist? Ein weiteres Szenario: Das Unternehmen plant die gleichzeitige Nutzung mehrerer Dienste – beim Anbieter A sollen Daten verarbeitet und dann in der Cloud des Anbieters B weiterverarbeitet werden.

Das Fehlen von Standards ist die Achillesferse der Cloud. Jeder Cloud-Anbieter kocht sein eigenes Süppchen und verwendet eigene Technologien. Aus Sicht eines Cloud-Anbieters sind proprietäre Dienste selbstverständlich alles andere als ein Nachteil: Sie sorgen, Stichwort Vendor-Lock-in, immerhin für eine gewisse Treue seitens der Kunden. Je proprietärer ein Dienst ist, desto schwerer tut sich der Kunde mit einem Wechsel, und er bleibt dann letztendlich vielleicht doch länger als beabsichtigt – sei es aus Bequemlichkeit oder technischer Notwendigkeit.

Cloud ohne Standards

Echte Standards für die Cloud sucht man vergeblich. Vielmehr sind es die großen Cloud-Anbieter und Open-Source-Plattformen, die versuchen, De-facto-Standards zu schaffen, die sich im Lauf der Zeit zu anerkannten Standards entwickeln sollen.

Zur Frage, warum es keine echten Standards für die Cloud gibt, erklärt Rudolf Hotter, Vorstand des IT-Dienstleisters Cancom: „Das liegt daran, dass die Cloud-Anbieter sehr wettbewerbsorientiert agieren und versuchen, ihre eigenen Werkzeuge und Dienste zum Standard zu machen beziehungsweise sich mit Nichtkonformität bewusst vom Wettbewerb abzugrenzen.“ Eine Standardisierung werde so oftmals verhindert. Kunden wollen seiner Erfahrung nach meist eine Kombination von Diensten unterschiedlicher Anbieter und stellen dann fest, dass eine bestimmte Programmierschnittstelle (API) oder ein bestimmter Dienst eines Anbieters am besten funktioniert, und fordern das dann bei den anderen Anbietern auch ein. „Es gibt keine offiziellen Standards, es gibt Hersteller und deren Produkte, die sich selbst zum Standard erklärt oder das versucht haben“, fasst Rudolf Hotter die aktuelle Situation zusammen.

Nach Meinung von Olaf Reimann, Sprecher des ICT-Service-Providers Operational Services, einem Joint-Venture zwischen dem Frankfurter Flughafenbetreiber Fraport und T-Systems, wäre die Einführung von Standards auch gar nicht so einfach: „Die Vielfalt der Cloud-Anbieter und die dadurch bedingte Dynamik im Markt schließt eine durchgängige Standardisierung fast aus, da jeder seine eigenen Lösungen vorantreibt und sie als ,Quasi-Standard‘ etablieren möchte.“ Es stelle sich die Frage, ob es überhaupt einen Standard geben müsse, „denn dieser raubt dem Thema möglicherweise die Dynamik und die Agilität, die die digitale Transformation eigentlich vorantreiben.“

Zudem ist das Fehlen von Standards kein cloudspezifisches Problem – „Unternehmen standen schon immer in einer gewissen Abhängigkeit zu Plattformen oder Herstellern, was sich auch in der Cloud nicht vollständig ändern wird“, so die Einschätzung von Roland König, Geschäftsführer beim Bechtle IT-Systemhaus München sowie Leiter des Geschäftsfelds Virtualisierung. „Einerseits entwickelt sich der Cloud-Markt erst jetzt so richtig in die Breite, andererseits spielt hier die Absicherung von Marktanteilen eine Rolle. In vielen Bereichen etablieren sich langsam Standards, aber das wird mit Sicherheit noch etwas dauern.“

Roland König sieht in Quasi-Standards auch Vorteile: „Natürlich setzen die großen Anbieter eigene Standards und über die Marktdurchdringung werden diese eben zu De-facto-Standards. Innerhalb der einzelnen Technologien und Plattformen können die Kunden aber wählen, von wem sie welchen Service beziehen.“ Als Beispiel nennt er die Partnernetzwerke von VMware oder Microsoft: Hier bauen Hoster und Partner Dienste auf der jeweiligen Architektur, die dann für diesen Bereich zum De-facto-Standard wird.

Olaf Reimann fasst die derzeitige Lage so zusammen: „Auch wenn einige große Anbieter den Cloud-Markt dominieren, gibt es keinen echten Standard.“

Vor allem zwei Technologien haben sich im weltweiten Cloud-Markt durchgesetzt: Branchenriese Amazon mit seinen Amazon Web Services sowie das Open-Source-Projekt OpenStack. Laut der Studie „The State of Cloud Platform Standard, Q4 2016“ der Marktanalysten von Forrester Research sind sowohl Amazon als auch OpenStack „safe bets“ – also eine sichere Sache, bei der Unternehmen wenig falsch machen können.

2. Teil: „De-facto-Standard AWS“

De-facto-Standard AWS

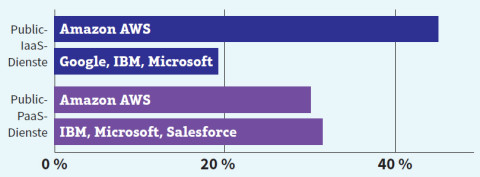

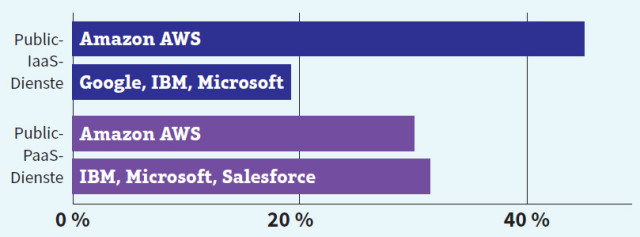

Wenn man einen Blick auf den aktuellen Cloud-Markt wirft, dann fällt auf, dass der Online-Shopping-Riese Amazon mit seiner Tochter Amazon Web Services (AWS) mittlerweile „der“ Big Player im Cloud-Markt ist. Laut einer Marktanalyse der Synergy Research Group vom Oktober letzten Jahres sahnte Amazon im dritten Quartal 2016 im weltweiten Public-Infrastructure-as-a-Service-Markt satte 45 Prozent der weltweiten Umsätze ab. Das ist mehr als doppelt so viel wie die drei Nächstgrößten – Google, IBM und Microsoft – zusammen.

Kaum ausgewogener war das Marktverhältnis bei den Public-Platform-as-a-Service-Diensten. Hier entfielen zwar nur rund 30 Prozent der Umsätze auf Amazon – die nächstgrößeren Mitbewerber IBM, Microsoft und Salesforce kamen jedoch ebenfalls zusammen nur auf gut 30 Prozent.

Für Software-Entwickler im Cloud-Umfeld gehört daher die Unterstützung für Amazons-AWS-APIs mittlerweile wohl zu den Kernanforderungen, um die man nicht mehr herumkommt.

Amazon Web Services ist nicht nur die Nummer eins bei den Marktanteilen, sondern auch spitze, was den Umfang des Cloud-Angebots angeht. Mehr als 70 AWS-Dienste vom Speicher über Datenbanken bis hin zu Analytic-Tools decken fast alle denkbaren Anwendungsfälle ab.

Vor allem der Speicher-Dienst Amazon Simple Storage Service, kurz Amazon S3, hat sich als Standard für Object-Storage etabliert, an dem sich inzwischen viele andere Anbieter von Cloud-Diensten orientieren. „Durch die weite Verbreitung von Amazon S3 als ,De-facto-Standard‘ für Object-Storage haben natürlich auch andere Cloud-Anbieter und Storage-Hersteller nachgezogen und bieten schon länger ebenfalls Object-Storage als neue Speicheroption. Dies gilt auch für APIs, hier hat Amazon sicherlich Quasi-Standards gesetzt, an denen andere sich orientieren“, so Rudolf Hotter von Cancom.

Zur Erklärung: Amazon S3 ist ein Speicher-Dienst, in dem man theoretisch beliebig große Datenmengen ablegen kann. Er verwendet einen objektbasierten Ansatz, daher die Bezeichnung Object-Storage. Die sogenannten Objekte beinhalten wie herkömmliche Dateien Daten. Im Gegensatz zu Dateien sind Objekte allerdings nicht in einer Hierarchie organisiert. Jedes Objekt befindet sich auf derselben Hierarchie-Ebene. S3 eignet sich als primärer Speicher für cloudnative Anwendungen oder als sogenannter Data Lake.

3. Teil: „IaaS: Open-Source-Alternativen“

IaaS: Open-Source-Alternativen

Weil immer mehr Unternehmen die Nachteile der Abhängigkeit von einzelnen Anbietern und Technologien erkennen, setzen sie – vor allem bei Infrastructure as a Service – auf Open-Source-Software. Vier quelloffene Projekte spielen hier eine Rolle: Eucalyptus, Nimbus, OpenNebula sowie OpenStack. Nach Ansicht von Branchenkennern dürfte jedoch nur OpenStack als ernsthafter Konkurrent aus dem Open-Source-Umfeld übrig bleiben.

„OpenStack erfährt derzeit eine sehr große Nachfrage und wird sich durchsetzen“, so die Einschätzung von Olaf Reimann. Das liege schon an der recht großen Verbreitung. „Da haben es andere Anbieter schwer, denn OpenStack verfügt bereits über eine sehr große gewachsene Community – da sich so viele Spezialisten und Unternehmen daran beteiligen, entwickelt sich die Lösung rasant immer weiter.“ Bei diesem Tempo könnten andere Lösungen kaum aufholen. OpenStack ist nach Einschätzung von Olaf Reimann eine gute Möglichkeit, sich vor einem Vendor-Lock-in zu schützen.

Ähnlich sieht es Cancom-Vorstand Hotter: „OpenStack hat sich sicherlich als Automatisierungswerkzeug durchgesetzt.“ Seiner Ansicht nach haben aber noch weitere Werkzeuge eine gewisse Bedeutung: „Wenn man zum Beispiel Container veröffentlichen, managen und automatisieren will, gibt es noch viele zusätzliche Open-Source-Werkzeuge und Bereitstellungsmechanismen, die sicherlich noch lange auf dem Markt sein werden und auch ihre Berechtigung haben.“ Als Beispiel nennt Hotter etwa das Cloud-Management-Tool Puppet und bei der Virtualisierung KVM. „Wie sehr diese Werkzeuge in Zukunft eine Rolle spielen, wird der Markt zeigen.“

Doch was genau ist OpenStack? Für das Open-Source-Projekt, das ursprünglich aus einer Kooperation der US-Raumfahrtbehörde NASA und dem Webhoster Rackspace entstanden ist, gibt es viele und teilweise sehr komplexe Begriffsdefinitionen. Laut Andreas Nemeth, Head of Technology & Operations der Group Innovation Business Applications & Cloud Services bei der Deutschen Telekom, lässt sich OpenStack am einfachsten mit einem Betriebssystem vergleichen. Das, was Windows für den Computer ist, das ist OpenStack für die Cloud: Während Windows die Ressourcen eines einzelnen Rechners verwaltet, übernimmt OpenStack diese Aufgabe für die Ressourcen vieler Rechner und bildet so die Plattform für eine Cloud-Umgebung.

OpenStack bietet die bekannten Vorteile von Open-Source-Lösungen: Unternehmen können sich in der Entwickler-Community einbringen und Lösungen aktiv mitentwickeln. Zu den namhaftesten Unterstützern von OpenStack zählen unter anderem Cisco und IBM.

Der größte Vorteil von OpenStack: Man muss als Unternehmen keinen Vendor-Lock-in fürchten. Wenn beide Cloud-Anbieter – der aktuelle sowie der neue Dienstleister – OpenStack unterstützen, dann ist ein Anbieterwechsel meist jederzeit möglich.

4. Teil: „Konkurrenten holen auf“

Konkurrenten holen auf

Trotz der zu beobachtenden Marktkonsolidierung raten die Analysten von Forrester Research dazu, mögliche weitere De-facto-Standards im Auge zu behalten.

Dazu gehört etwa das Open-Source-Projekt Cloud Foundry. Der Platform-as-a-Service-Dienst ermöglicht das Betreiben und Verteilen von Applikationen sowohl in der Public Cloud als auch in der Private Cloud. Zum Erfolg von Cloud Foundry dürfte vor allem auch beitragen, dass zahlreiche renommierte IT-Unternehmen das Projekt unterstützen. Darunter finden sich diverse Branchengrößen wie Cisco, IBM und SAP.

Wer Container einsetzen möchte, sollte sich laut Forrester Research das Open-Source-System Kubernetes näher ansehen. Das Tool zur Orchestrierung von Containern wurde ursprünglich von Google entwickelt und später der Open-Source-Community übergeben.

Auch Microsoft Azure ist auf Aufholjagd und ebenfalls dabei, sich langsam zu einem Quasi-Standard zu entwickeln. Der Konzern platziert sich derzeit als Nummer zwei auf dem Public-Cloud-Markt und baut sein Angebot an Cloud-Diensten kontinuierlich aus.

Cloud-Strategie

Wie nun sollte man als Unternehmen agieren angesichts fehlender offizieller und diverser Quasi-Standards? Und wie stellt man sicher, dass es bei einem späteren Wechsel nicht zu einem bösen Erwachen kommt? Laut Roland König von Bechtle ist es wichtig, eine Cloud-Strategie zu haben, die sich auf die Geschäftsprozesse und das Unternehmen sowie auf die mittel- und langfristigen Ziele konzentriert. „Ein entscheidender Punkt ist, wie die eigene Private Cloud aussieht: Ist sie bereits auf neue Anforderungen ausgerichtet? Bin ich in der Lage, hybride Modelle zu integrieren? Ist ein Managementsystem vorhanden, mit dem die Anforderungen überwacht werden können? Hier spielt die Plattform eine entscheidende Rolle, die Unternehmen die Flexibilität einräumen muss, die sie im digitalen Zeitalter benötigen.“

Rudolf Hotter von Cancom hält es für wichtig, dass man als Unternehmen überlegt, was man mit der Cloud eigentlich anfangen möchte. Man muss sich fragen, was man seinen Mitarbeitern mit welcher Verfügbarkeit und welcher Skalierung anbieten will. Weitere Fragen seien, ob viele Änderungen zu erwarten sind oder ob der Service eher statisch ist. „Diese und noch viele weitere Faktoren beeinflussen die Wahl der Cloud-Werkzeuge und der Cloud-Plattform.“

Olaf Reimann ist der Ansicht, dass Kunden sich keine Gedanken um Cloud-Standards zu machen brauchen: „Eigentlich sollte sich ein Unternehmen gar nicht mit der Technologieauswahl beschäftigen müssen, sondern sich auf seine eigenen Geschäftsprozesse konzentrieren.“

Vor allem für mittelständische Unternehmen sei es wichtig, für komplexe IT-Themen einen Service-Partner an der Seite zu haben, der die passenden Technologien und Cloud-Plattformen auswählt, diese managt, orchestriert und Prozesse automatisiert. „Da der Markt dynamisch ist und sich in kürzester Zeit viel ändert, ist es komplex, jede Entwicklung selbst nachzuvollziehen und immer die internen Ressourcen dafür bereitzustellen oder aufzubauen.“

Unternehmen würden es nur mit großem Aufwand schaffen, auf eigene Faust Technologieangebote zu analysieren und zu entscheiden, ob und wann ein Wechsel notwendig sei.

Bad News

Game macht Fake News spielerisch erkennbar

Wissenschaftler der Universität Uppsala haben ihr Online-Spiel "Bad News" erfolgreich an 516 Schülern getestet. Es soll helfen, manipulative Techniken in Social-Media-Posts zu erkennen.

>>

Huawei Roadshow 2024

Technologie auf Rädern - der Show-Truck von Huawei ist unterwegs

Die Huawei Europe Enterprise Roadshow läuft dieses Jahr unter dem Thema "Digital & Green: Accelerate Industrial Intelligence". Im Show-Truck zeigt das Unternehmen neueste Produkte und Lösungen. Ziel ist es, Kunden und Partner zusammenzubringen.

>>

Nach der Unify-Übernahme

Mitels kombinierte Portfoliostrategie

Der UCC-Spezialist Mitel bereinigt nach der Unify-Übernahme sein Portfolio – und möchte sich auf die Bereiche Hybrid Cloud-Anwendungen, Integrationsmöglichkeiten in vertikalen Branchen sowie auf den DECT-Bereich konzentrieren.

>>

Tools

GitLab Duo Chat mit KI-Chat-Unterstützung

Der DevSecOps-Plattform-Anbieter GitLab führt den GitLab Duo Chat ein. Dieses Tool integriert Künstliche Intelligenz in die DevSecOps-Workflows.

>>